¿Puede la regulación efectiva reducir el impacto del contenido divisivo en las redes sociales?

Publicado: 2022-04-08En medio de una nueva tormenta de controversia provocada por The Facebook Files, una exposición de varios proyectos de investigación internos que, de alguna manera, sugieren que Facebook no está haciendo lo suficiente para proteger a los usuarios de daños, la pregunta central que debe abordarse a menudo es ser distorsionado por el sesgo inherente y la orientación específica de Facebook, la empresa, a diferencia de las redes sociales, y la amplificación algorítmica de contenido como concepto.

Es decir, ¿qué hacemos para solucionarlo? ¿Qué se puede hacer, de manera realista, que realmente marque la diferencia? ¿Qué cambios en la regulación o la política podrían implementarse de manera factible para reducir la amplificación de publicaciones dañinas y divisivas que están alimentando más angustia dentro de la sociedad como resultado de la creciente influencia de las aplicaciones de redes sociales?

Es importante considerar las redes sociales de manera más amplia aquí, porque cada plataforma social utiliza algoritmos para definir la distribución y el alcance del contenido. Facebook es, con mucho, el más grande y tiene más influencia en los elementos clave, como el contenido de noticias y, por supuesto, los conocimientos de investigación en sí mismos, en este caso, provinieron de Facebook.

El enfoque en Facebook, específicamente, tiene sentido, pero Twitter también amplifica el contenido que genera más compromiso, LinkedIn clasifica su feed en función de lo que determina que será más atractivo. El algoritmo de TikTok está muy en sintonía con tus intereses.

El problema, como lo destacó la denunciante de Facebook, Frances Haugen, es la distribución algorítmica, no el propio Facebook. Entonces, ¿qué ideas tenemos que puedan mejorar ese elemento de manera realista?

Y la pregunta adicional entonces es, ¿las plataformas sociales estarán dispuestas a hacer tales cambios, especialmente si presentan un riesgo para sus niveles de participación y actividad de los usuarios?

Haugen, quien es un experto en coincidencia de contenido algorítmico, ha propuesto que las redes sociales deberían verse obligadas a dejar de usar algoritmos basados en participación por completo, a través de reformas a las leyes de la Sección 230, que actualmente protegen a las empresas de redes sociales de la responsabilidad legal por lo que los usuarios comparten en sus aplicaciones. .

Como explica Haugen:

“Si tuviéramos la supervisión adecuada, o si reformamos la [Sección] 230 para que Facebook sea responsable de las consecuencias de sus decisiones de clasificación intencionales, creo que se desharían de la clasificación basada en el compromiso”.

El concepto aquí es que Facebook, y por extensión, todas las plataformas sociales, serían responsables de las formas en que amplifican cierto contenido. Entonces, si más personas terminan viendo, digamos, información errónea sobre COVID debido a la intervención algorítmica, Facebook podría ser legalmente responsable de cualquier impacto.

Eso agregaría un riesgo significativo a cualquier toma de decisiones en torno a la construcción de dichos algoritmos y, como señala Haugen, eso puede hacer que las plataformas se vean obligadas a dar un paso atrás en las medidas que aumentan el alcance de las publicaciones en función de cómo los usuarios interactúan con dicho contenido. .

Esencialmente, eso probablemente obligaría a las plataformas sociales a volver a los días previos al algoritmo, cuando Facebook y otras aplicaciones simplemente le mostrarían una lista del contenido de las páginas y las personas que sigue en orden cronológico, según el tiempo de publicación. Eso, a su vez, reduciría la motivación para que las personas y las marcas compartan contenido más controvertido y que provoque el compromiso para jugar con los caprichos del algoritmo.

La idea tiene algo de mérito: como han demostrado varios estudios, generar una respuesta emocional con sus publicaciones en redes sociales es clave para maximizar el compromiso y, por lo tanto, el alcance basado en la amplificación de algoritmos, y las emociones más efectivas, en este sentido, son el humor y la ira. Los chistes y los videos divertidos todavía funcionan bien en todas las plataformas, impulsados por el alcance del algoritmo, pero también lo hacen las tomas calientes que provocan ira, con las que se han topado los medios de comunicación y las personalidades partidistas, que bien podrían ser una fuente clave de la división y la angustia que ahora. ver en línea

Para ser claros, Facebook no puede ser el único responsable de ello. Los editores partidistas y las figuras controvertidas han desempeñado durante mucho tiempo un papel en el discurso más amplio, y sus opiniones de centroizquierda estaban despertando la atención y el compromiso mucho antes de que llegara Facebook. La diferencia ahora es que las redes sociales facilitan un alcance tan amplio, mientras que también, a través de Me gusta y otras formas de participación, brindan un incentivo directo para ello, ya que los usuarios individuales obtienen un golpe de dopamina al desencadenar una respuesta y los editores generan más tráfico de referencia y obtienen más exposición a través de la provocación.

Realmente, una cuestión clave al considerar el resultado anterior es que ahora todos tienen voz, y cuando todos tienen una plataforma para compartir sus pensamientos y opiniones, todos estamos mucho más expuestos a eso y mucho más conscientes. En el pasado, probablemente no tenías idea de las tendencias políticas de tu tío, pero ahora lo sabes, porque las redes sociales te lo recuerdan todos los días, y ese tipo de intercambio entre pares también juega un papel en una división más amplia.

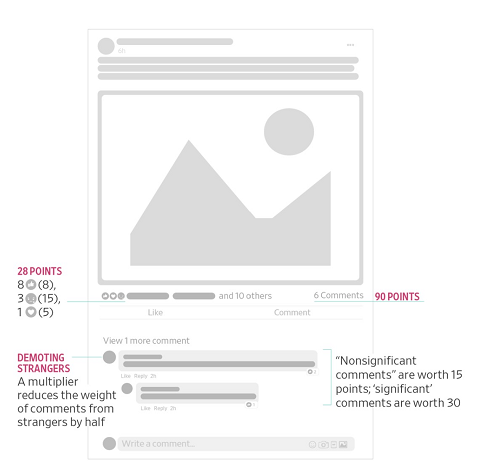

Sin embargo, el argumento de Haugen es que Facebook incentiva esto; por ejemplo, uno de los informes que Haugen filtró al Wall Street Journal describe cómo Facebook actualizó su algoritmo News Feed en 2018 para poner más énfasis en la participación entre los usuarios y reducir la discusión política, lo que se había convertido en un elemento cada vez más divisivo en la aplicación. Facebook hizo esto al cambiar su ponderación para diferentes tipos de interacción con las publicaciones.

La idea era que esto incentivaría una mayor discusión, al ponderar más las respuestas, pero como puede imaginar, al otorgar más valor a los comentarios, para generar un mayor alcance, eso también llevó a más editores y páginas a compartir cada vez más divisivo, emocionalmente. publicaciones cargadas, para incitar más reacciones y, como resultado, obtener puntajes de participación más altos. Con esta actualización, los Me gusta ya no eran el factor clave de alcance, como lo habían sido, y Facebook hizo que los comentarios y las Reacciones (incluido 'Enojado') fueran cada vez más importantes. Como tal, la discusión sobre las tendencias políticas en realidad se volvió más prominente y expuso a más usuarios a dicho contenido en sus feeds.

Entonces, la sugerencia, basada en estos datos internos, es que Facebook sabía esto, sabía que este cambio había aumentado el contenido divisivo. Pero optaron por no volver atrás o implementar otra actualización, porque el compromiso, una medida clave para el éxito de su negocio, había aumentado como resultado.

En este sentido, tendría sentido eliminar la motivación del algoritmo, o tal vez podría buscar eliminar los incentivos del algoritmo para ciertos tipos de publicaciones, como la discusión política, y al mismo tiempo maximizar el alcance de publicaciones más atractivas de amigos, atendiendo tanto a los objetivos de participación como a los divisivos. preocupaciones.

Eso es lo que Dave Gillis de Facebook, que trabaja en el equipo de seguridad de productos de la plataforma, ha señalado en un hilo de tweet, en respuesta a las revelaciones.

Según Gillis:

“ Al final del artículo del WSJ sobre la clasificación algorítmica de feeds, se menciona, casi de pasada, que nos alejamos de la clasificación basada en el compromiso para el contenido cívico y de salud en News Feed. Pero espera, eso es un gran problema, ¿no? Probablemente sea razonable clasificar, por ejemplo, videos de gatos y fotos de bebés por Me gusta, etc., pero maneje otros tipos de contenido con más cuidado. Y eso es, de hecho, lo que nuestros equipos abogaron por hacer: usar diferentes señales de clasificación para el contenido cívico y de salud, priorizando la calidad + confiabilidad sobre el compromiso. Trabajamos arduamente para comprender el impacto, incorporar el liderazgo (sí, Mark también) y es un cambio importante. ”

Esta podría ser una forma de avanzar, utilizando diferentes señales de clasificación para diferentes tipos de contenido, lo que puede funcionar para permitir una amplificación óptima del contenido, impulsando la participación beneficiosa del usuario, al mismo tiempo que disminuye la motivación para que ciertos actores publiquen material divisivo con el fin de alimentar algoritmos. alcanzar.

Funcionaría eso? Nuevamente, es difícil de decir, porque las personas aún podrían compartir publicaciones, aún podrían comentar y redistribuir material en línea, todavía hay muchas formas en que la amplificación puede ocurrir fuera del algoritmo mismo.

En esencia, ambas sugerencias tienen méritos, que las plataformas sociales podrían tratar diferentes tipos de contenido de manera diferente, o que los algoritmos podrían eliminarse para reducir la amplificación de dicho material.

Y, como señala Haugen, es importante centrarse en los sistemas en sí, porque las soluciones basadas en contenido abren varias complejidades cuando el material se publica en otros idiomas y regiones.

“En el caso de Etiopía, hay 100 millones de personas y seis idiomas. Facebook solo admite dos de esos idiomas para los sistemas de integridad. Esta estrategia de centrarse en sistemas específicos del idioma y del contenido para que la IA nos salve está condenada al fracaso”.

Tal vez, entonces, eliminar los algoritmos, o al menos cambiar las regulaciones sobre cómo funcionan los algoritmos, sería una solución óptima, que podría ayudar a reducir los impactos del contenido negativo que genera ira en la esfera de las redes sociales.

Pero luego volvemos al problema original que el algoritmo de Facebook fue diseñado para resolver: en 2015, Facebook explicó que necesitaba el algoritmo de News Feed no solo para maximizar la participación del usuario, sino también para ayudar a garantizar que las personas vieran todas las actualizaciones de la mayoría. relevancia para ellos.

Como explicó, el usuario promedio de Facebook, en ese momento, tenía alrededor de 1500 publicaciones elegibles para aparecer en su News Feed en un día determinado, según las páginas que les gustaban y sus conexiones personales, mientras que para algunos usuarios más activos , ese número era más como 15,000. Simplemente no es posible que las personas lean todas y cada una de estas actualizaciones todos los días, por lo que el enfoque clave de Facebook con el algoritmo inicial fue crear un sistema que descubriera el contenido mejor y más relevante para cada individuo, a fin de brindarles a los usuarios la mayor cantidad de experiencia atractiva y, posteriormente, hacer que regresen.

Como explicó el director de producto de Facebook, Chris Cox, a la revista Time:

"Si pudiera calificar todo lo que sucedió en la Tierra hoy que fue publicado en cualquier lugar por cualquiera de sus amigos, cualquiera de su familia, cualquier fuente de noticias, y luego elegir los 10 que fueron los más significativos para saber hoy, eso sería realmente genial servicio para que construyamos. Eso es realmente en lo que aspiramos que se convierta News Feed ".

El enfoque de News Feed ha evolucionado mucho desde entonces, pero el desafío fundamental que fue diseñado para resolver permanece. Las personas tienen demasiadas conexiones, siguen demasiadas páginas, son miembros de demasiados grupos para recibir todas sus actualizaciones todos los días. Sin el algoritmo de alimentación, se perderán publicaciones relevantes, actualizaciones relevantes como anuncios familiares y cumpleaños, y simplemente no estarán tan involucrados en la experiencia de Facebook.

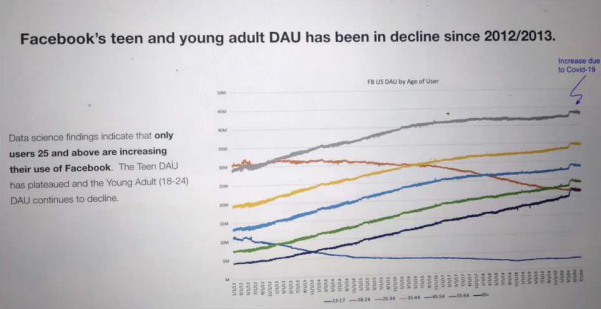

Sin el algoritmo, Facebook perderá, al no optimizarse para los deseos de la audiencia, y como se destaca en otro de los informes compartidos como parte de los archivos de Facebook, en realidad ya está viendo disminuciones en la participación en algunos subconjuntos demográficos.

Puede imaginar que si Facebook eliminara el algoritmo, o se viera obligado a cambiar su dirección en esto, este gráfico solo empeorará con el tiempo.

Por lo tanto, no es probable que Zuck and Co. esté interesado en esa solución, por lo que un compromiso, como el propuesto por Gillis, puede ser lo mejor que se puede esperar. Pero eso viene con sus propios defectos y riesgos.

De cualquier manera, vale la pena señalar que el enfoque del debate debe cambiar a los algoritmos de manera más amplia, no solo en Facebook, y si realmente existe una forma viable y viable de cambiar los incentivos en torno a los sistemas basados en algoritmos para limitar la distribución. de elementos más divisivos.

Porque ese es un problema, no importa cómo Facebook o cualquier otra persona intente darle la vuelta, razón por la cual la postura de Haugen es importante, ya que bien puede ser la chispa que nos lleve a un debate nuevo y más matizado en torno a este elemento clave.