Una regolamentazione efficace può ridurre l'impatto dei contenuti divisivi sui social network?

Pubblicato: 2022-04-08In mezzo a una nuova tempesta di polemiche scatenata da The Facebook Files, un'esposizione di vari progetti di ricerca interni che, in qualche modo, suggeriscono che Facebook non sta facendo abbastanza per proteggere gli utenti dai danni, la questione centrale che deve essere affrontata è spesso distorto da pregiudizi intrinseci e targeting specifico di Facebook, l'azienda, in contrasto con i social media e l'amplificazione algoritmica del contenuto come concetto.

Cioè, cosa facciamo per risolverlo? Cosa si può fare, realisticamente, che farà davvero la differenza; quali modifiche alla regolamentazione o alla politica potrebbero essere attuate in modo fattibile per ridurre l'amplificazione di post dannosi e divisivi che alimentano più angoscia all'interno della società a causa della crescente influenza delle app di social media?

È importante considerare i social media in modo più ampio qui, perché ogni piattaforma social utilizza algoritmi per definire la distribuzione e la portata dei contenuti. Facebook è di gran lunga il più grande e ha maggiore influenza su elementi chiave, come i contenuti delle notizie e, naturalmente, gli stessi approfondimenti della ricerca, in questo caso, provengono da Facebook.

L'attenzione su Facebook, in particolare, ha senso, ma Twitter amplifica anche i contenuti che stimolano un maggiore coinvolgimento, LinkedIn ordina il suo feed in base a ciò che determina sarà più coinvolgente. L'algoritmo di TikTok è molto in sintonia con i tuoi interessi.

Il problema, come evidenziato dall'informatrice di Facebook Frances Haugen, è la distribuzione algoritmica, non Facebook stesso, quindi quali idee abbiamo per migliorare realisticamente quell'elemento?

E l'ulteriore domanda è: le piattaforme social saranno disposte ad apportare tali cambiamenti, soprattutto se presentano un rischio per il loro coinvolgimento e i livelli di attività degli utenti?

Haugen, che è un esperto in corrispondenza di contenuti algoritmici, ha proposto che i social network dovrebbero essere costretti a smettere del tutto di utilizzare algoritmi basati sul coinvolgimento, attraverso la riforma delle leggi della Sezione 230, che attualmente proteggono le società di social media dalla responsabilità legale per ciò che gli utenti condividono nelle loro app .

Come spiegato da Haugen:

"Se avessimo un'adeguata supervisione, o se avessimo riformato la [Sezione] 230 per rendere Facebook responsabile delle conseguenze delle loro decisioni intenzionali sulla classifica, penso che si libererebbero della classifica basata sul coinvolgimento".

Il concetto qui è che Facebook – e, per estensione, tutte le piattaforme social – sarebbero ritenuti responsabili dei modi in cui amplificano determinati contenuti. Quindi, se più persone finiscono per vedere, ad esempio, disinformazione COVID a causa dell'intervento algoritmico, Facebook potrebbe essere ritenuto legalmente responsabile per qualsiasi impatto.

Ciò aggiungerebbe un rischio significativo a qualsiasi processo decisionale relativo alla costruzione di tali algoritmi e, come osserva Haugen, ciò potrebbe quindi vedere le piattaforme costrette a fare un passo indietro rispetto alle misure che aumentano la portata dei post in base al modo in cui gli utenti interagiscono con tali contenuti .

In sostanza, ciò vedrebbe probabilmente le piattaforme social costrette a tornare ai giorni pre-algoritmo, quando Facebook e altre app ti mostrerebbero semplicemente un elenco dei contenuti delle pagine e delle persone che segui in ordine cronologico, in base al tempo di pubblicazione. Ciò, a sua volta, ridurrebbe la motivazione per le persone e i marchi a condividere contenuti più controversi e stimolanti per il coinvolgimento al fine di giocare secondo i capricci dell'algoritmo.

L'idea ha qualche merito: come hanno dimostrato vari studi, suscitare una risposta emotiva con i tuoi post sui social è la chiave per massimizzare il coinvolgimento e, quindi, la copertura basata sull'amplificazione dell'algoritmo, e le emozioni più efficaci, a questo proposito, sono l'umorismo e la rabbia. Le battute e i video divertenti continuano a funzionare bene su tutte le piattaforme, alimentati dalla portata dell'algoritmo, ma anche le riprese hot che provocano rabbia, con cui hanno corso notiziari e personalità di parte, che potrebbero essere una fonte chiave della divisione e dell'angoscia che ora noi vedi in linea.

Per essere chiari, Facebook non può essere ritenuto l'unico responsabile di ciò. Gli editori partigiani e le figure controverse hanno da tempo svolto un ruolo nel discorso più ampio e stavano suscitando attenzione e coinvolgimento con le loro opinioni di centrosinistra molto prima dell'arrivo di Facebook. La differenza ora è che i social network facilitano una portata così ampia, mentre anche, attraverso i Mi piace e altre forme di coinvolgimento, forniscono un incentivo diretto per tali, con i singoli utenti che ottengono un colpo di dopamina attivando la risposta e gli editori che guidano più traffico di referral e guadagnano maggiore esposizione attraverso la provocazione.

In realtà, una questione chiave quando si considera il risultato precedente è che tutti ora hanno una voce e quando tutti hanno una piattaforma per condividere i propri pensieri e opinioni, siamo tutti molto più esposti a questo e molto più consapevoli. In passato, probabilmente non avevi idea delle persuasioni politiche di tuo zio, ma ora lo sai, perché i social media te lo ricordano ogni giorno e anche quel tipo di condivisione tra pari sta giocando un ruolo in una divisione più ampia.

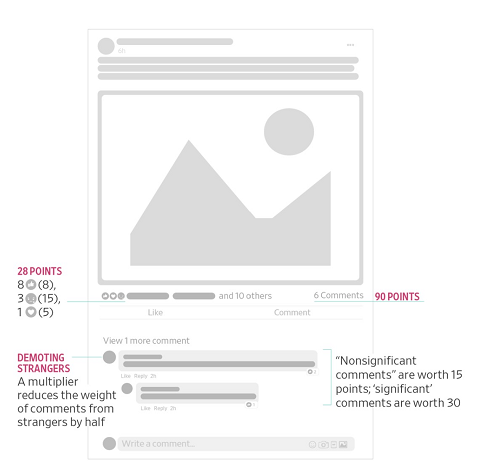

L'argomento di Haugen, tuttavia, è che Facebook incentiva questo: ad esempio, uno dei rapporti che Haugen ha fatto trapelare al Wall Street Journal sottolinea come Facebook abbia aggiornato il suo algoritmo del feed di notizie nel 2018 per porre maggiormente l'accento sul coinvolgimento tra gli utenti e ridurre la discussione politica, il che era diventato un elemento sempre più divisivo nell'app. Facebook lo ha fatto modificando la sua ponderazione per i diversi tipi di coinvolgimento con i post.

L'idea era che questo avrebbe incentivato più discussioni, ponderando le risposte in modo più pesante - ma come puoi immaginare, dando più valore ai commenti, al fine di aumentare la copertura, ciò ha anche spinto più editori e Pagine a condividere sempre più divisioni, emotivamente- post caricati, al fine di incitare più reazioni e ottenere di conseguenza punteggi di condivisione più elevati. Con questo aggiornamento, i Mi piace non erano più il fattore chiave della copertura, come lo erano stati, con Facebook che rendeva sempre più importanti commenti e reazioni (incluso "Arrabbiato"). In quanto tale, la discussione sulle tendenze politiche è diventata effettivamente più importante e ha esposto più utenti a tali contenuti nei loro feed.

Il suggerimento quindi, sulla base di questi dati interni, è che Facebook lo sapesse, sapeva che questo cambiamento aveva intensificato i contenuti divisivi. Ma hanno deciso di non tornare indietro o implementare un altro aggiornamento, perché il coinvolgimento, una misura chiave per il suo successo aziendale, era effettivamente aumentato di conseguenza.

In questo senso, avrebbe senso rimuovere la motivazione dell'algoritmo, o forse potresti cercare di rimuovere gli incentivi dell'algoritmo per alcuni tipi di post, come la discussione politica, massimizzando comunque la portata di post più coinvolgenti degli amici, soddisfacendo sia gli obiettivi di coinvolgimento che quelli divisivi preoccupazioni.

Questo è ciò che Dave Gillis di Facebook, che lavora nel team di sicurezza dei prodotti della piattaforma, ha indicato in un thread di tweet, in risposta alle rivelazioni.

Secondo Gillis:

“ Alla fine del pezzo del WSJ sulla classifica dei feed algoritmici, viene menzionato - quasi di sfuggita - che siamo passati dalla classifica basata sul coinvolgimento per i contenuti civici e sanitari nel feed delle notizie. Ma aspetta, è un grosso problema, no? Probabilmente è ragionevole classificare, ad esempio, video di gatti e foto di bambini in base a Mi piace, ecc. Ma gestire altri tipi di contenuti con maggiore attenzione. Ed è, in effetti, ciò che i nostri team hanno raccomandato di fare: utilizzare segnali di ranking diversi per salute e contenuto civico, dando priorità alla qualità + affidabilità rispetto al coinvolgimento. Abbiamo lavorato duramente per capire l'impatto, ottenere la leadership a bordo - sì, anche Mark - ed è un cambiamento importante. "

Questa potrebbe essere una via da seguire, utilizzando diversi segnali di classificazione per diversi tipi di contenuto, che potrebbero funzionare per consentire un'amplificazione ottimale dei contenuti, aumentando il coinvolgimento positivo degli utenti, riducendo anche la motivazione di alcuni attori a pubblicare materiale divisivo al fine di alimentare gli algoritmi portata.

Funzionerebbe? Ancora una volta, è difficile dirlo, perché le persone sarebbero ancora in grado di condividere post, sarebbero comunque in grado di commentare e ridistribuire materiale online, ci sono ancora molti modi in cui l'amplificazione può avvenire al di fuori dell'algoritmo stesso.

In sostanza, ci sono dei meriti in entrambi i suggerimenti, che le piattaforme social potrebbero trattare diversi tipi di contenuto in modo diverso, o che potrebbero essere eliminati algoritmi per ridurre l'amplificazione di tale materiale.

E come osserva Haugen, concentrarsi sui sistemi stessi è importante, perché le soluzioni basate sui contenuti aprono varie complessità quando il materiale viene pubblicato in altre lingue e regioni.

“Nel caso dell'Etiopia ci sono 100 milioni di persone e sei lingue. Facebook supporta solo due di queste lingue per i sistemi di integrità. Questa strategia di concentrarsi su sistemi specifici per lingua e contenuti per l'IA per salvarci è destinata a fallire".

Forse, quindi, rimuovere gli algoritmi, o almeno modificare i regolamenti su come funzionano gli algoritmi, sarebbe una soluzione ottimale, che potrebbe aiutare a ridurre l'impatto dei contenuti negativi e irritanti nella sfera dei social media.

Ma poi torniamo al problema originale che l'algoritmo di Facebook è stato progettato per risolvere: nel 2015 Facebook ha spiegato che aveva bisogno dell'algoritmo del feed di notizie non solo per massimizzare il coinvolgimento degli utenti, ma anche per garantire che le persone vedessero tutti gli aggiornamenti della maggior parte rilevanza per loro.

Come spiegato, l'utente medio di Facebook, a quel tempo, aveva circa 1.500 post idonei per apparire nel proprio feed di notizie in un dato giorno, in base alle pagine che gli erano piaciute e alle loro connessioni personali, mentre per alcuni utenti più attivi , quel numero era più simile a 15.000. Semplicemente non è possibile per le persone leggere ogni singolo aggiornamento di questi aggiornamenti ogni giorno, quindi l'obiettivo principale di Facebook con l'algoritmo iniziale era creare un sistema che scoprisse i contenuti migliori e più rilevanti per ogni individuo, al fine di fornire agli utenti il massimo esperienza coinvolgente e, successivamente, farli tornare.

Come ha spiegato a Time Magazine il chief product officer di Facebook, Chris Cox:

"Se potessi valutare tutto ciò che è accaduto oggi sulla Terra che è stato pubblicato ovunque da qualsiasi tuo amico, qualsiasi membro della tua famiglia, qualsiasi fonte di notizie, e poi scegliere i 10 che erano i più significativi da sapere oggi, sarebbe davvero fantastico servizio per noi da costruire. Questo è davvero ciò che aspiriamo a far diventare News Feed ".

L'approccio del feed di notizie si è evoluto molto da allora, ma la sfida fondamentale che è stato progettato per risolvere rimane. Le persone hanno troppe connessioni, seguono troppe Pagine, sono membri di troppi gruppi per ricevere tutti i loro aggiornamenti, ogni giorno. Senza l'algoritmo del feed, mancheranno i post rilevanti, gli aggiornamenti rilevanti come annunci di famiglia e compleanni e semplicemente non saranno così coinvolti nell'esperienza di Facebook.

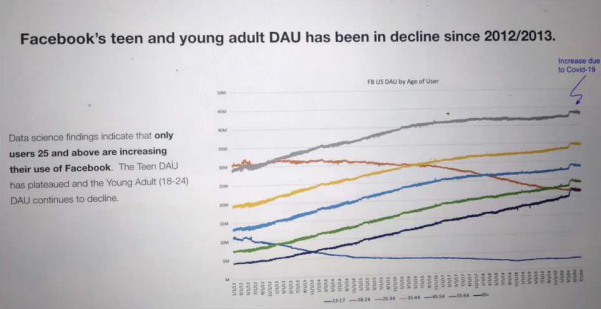

Senza l'algoritmo, Facebook perderà terreno, non riuscendo a ottimizzare per i desideri del pubblico e, come evidenziato in un altro dei rapporti condivisi come parte dei file di Facebook, in realtà sta già assistendo a un calo del coinvolgimento in alcuni sottoinsiemi demografici.

Puoi immaginare che se Facebook dovesse eliminare l'algoritmo, o essere costretto a cambiare direzione su questo, questo grafico peggiorerà solo nel tempo.

È quindi improbabile che Zuck e Co. apprezzino questa soluzione, quindi un compromesso, come quello proposto da Gillis, potrebbe essere il migliore che ci si possa aspettare. Ma questo ha i suoi difetti e rischi.

Ad ogni modo, vale la pena notare che il fulcro del dibattito deve spostarsi sugli algoritmi in modo più ampio, non solo su Facebook, e se esiste effettivamente un modo praticabile e praticabile per cambiare gli incentivi attorno ai sistemi basati su algoritmi per limitare la distribuzione di elementi più divisivi.

Perché questo è un problema, non importa come Facebook o chiunque altro tenti di farlo girare, motivo per cui la posizione di Haugen è importante, poiché potrebbe benissimo essere la scintilla che ci porterà a un nuovo dibattito più sfumato attorno a questo elemento chiave.