Facebookの内部調査によると、再共有は誤った情報を大幅に増幅する可能性があります

公開: 2022-04-08Facebookがアプリ内の誤った情報の拡散を制限する手段として、投稿共有を完全に削除した場合はどうなりますか? Facebookのエンゲージメントとインタラクションにどのような影響がありますか?

この質問は、より広範な「Facebookファイル」リークの一部としてリリースされたFacebookの内部調査からの新しい洞察のリリースに続いて発生します。これは、Facebook自身のレポートが、投稿共有が誤った情報を増幅し、Facebookに害を広める上で重要な役割を果たすことを示しています。コミュニティ。

AlexKantrowitzがニュースレターBigTechnologyで報告したように、次のようになります。

「レポートによると、Facebookの一般的な写真やリンクと比較して、共有の共有を介して投稿に遭遇した場合、人々は誤った情報を目にする可能性が4倍高くなります。 チェーンにさらに数株を追加すると、人々は誤った情報を見る可能性が5倍から10倍高くなります。 特定の国では悪化します。 インドでは、研究者が言うように、「深い再共有」に遭遇した人々は、誤った情報を見る可能性が20倍高くなっています。」

したがって、それ自体は直接の共有ではなく、再増幅された共有であり、アプリでウイルスの牽引力を獲得する、物議を醸す、分裂する、衝撃的な、または驚くべき種類のレポートである可能性が高くなります。 感情的な反応を生み出すコンテンツは、この点でより多くの共有活動を見るので、主張が過激であるほど、特にユーザーがサードパーティのレポート。

そしてもっとあります:

「調査によると、誤った情報を含むリンク投稿のすべての[ビュー]の38%は、2回の再共有後に発生しています。 写真の場合、その数は増加します。写真の誤報の表示の65%は、2回の再共有後に発生します。 一方、Facebookページは、配布のために深い再共有に依存しないでください。 ページコンテンツの約20%は、2以上の再共有深度で表示されます。 」

繰り返しになりますが、データは、ユーザーがFacebookのネットワーク全体でこれらの投稿を増幅および再増幅するため、多くの場合、そのようなものについての独自の考えや意見を追加することなく、これらのよりスパイシーで物議を醸す主張や投稿が継続的な共有を通じて大きなウイルスの牽引力を発揮することを示しています。

では、Facebookが共有を完全に排除し、コンテンツを共有するために独自の投稿を作成するか、元の投稿にコメントするように強制した場合、ボタンをタップするだけでそのような急速な増幅が遅くなるとしたらどうでしょうか。

興味深いことに、Facebookはこの面で変更を加えており、この調査に関連している可能性があります。 昨年、Facebookが所有する(現在はメタが所有する)WhatsAppは、メッセージチェーンを介した誤った情報の拡散を防ぐために、メッセージ転送に新しい制限を実装しました。共有はメッセージごとに5倍に制限されています。

WhatsAppによると、これは効果的です。

「新しい制限が導入されて以来、世界中で、WhatsAppで送信される高度に転送されるメッセージの数が70%減少しました。 この変更は、WhatsAppを個人的およびプライベートな会話の場に保つのに役立ちます。」

これは前向きな結果であり、そのような限界に価値がある可能性が高いことを示しています。 しかし、新たに明らかになった調査ではFacebookを具体的に取り上げており、これまでのところ、Facebookは、このレポートの中心的な関心事であるメインアプリ内の共有プロセスを変更するために何もしていません。

この面での同社の行動の欠如は、Facebookの内部告発者であるフランセスハウゲンの会社に対する法的推進の一部を形成しており、ハウゲンの弁護士は、再共有の制限を実施できない場合、FacebookをAppStoreから削除するよう求めています。

Facebookはまだこれらの新しい主張に対応していませんが、他のFacebookの実験との関連でこの調査に注目するのは興味深いことです。これは、主張の中心的な焦点を支持し、矛盾しているようです。

2018年8月、Facebookは実際に投稿から[共有]ボタンを削除し、代わりに[メッセージ]プロンプトに置き換えて実験を行いました。

これは、Facebookアプリではなく、メッセージングストリーム内のコンテンツに関する議論の増加に触発されたようですが、実験のタイミングを考えると、調査に関連して、Facebookは削除にどのような影響があるかを調べているようです。共有の割合は、アプリ内エンゲージメントに影響を与える可能性があります。

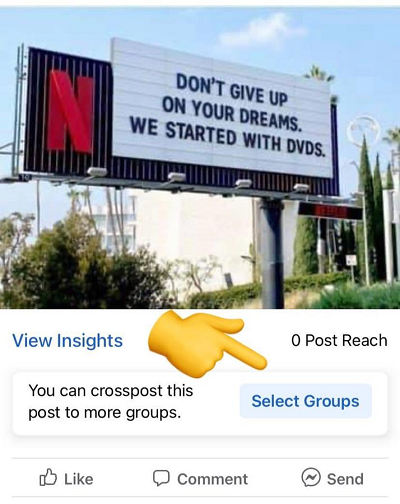

ただし、別の面では、Facebookが実際にテストした拡張共有では、ユーザーが一度に複数のFacebookグループに投稿を共有できるようにする新しいオプションがテストで発見されました。

これは、2019年の調査の焦点であった再共有とは対照的に、直接投稿共有に焦点を当てているようです。 しかし、そうであっても、コンテンツを増幅するためのより多くの方法、潜在的に危険または有害な投稿をより簡単に提供することは、レポートで概説されている調査結果に反するようです。

繰り返しになりますが、Facebookはレポートにコメントしていないため、完全な監視はできませんが、有害なものの急速な再循環を制限する手段として、オプションとして投稿共有を完全に削除することには利点があるようです。請求。

しかし、繰り返しになりますが、それはFacebookのエンゲージメントを大きく損なうだけかもしれません。おそらく、これらのさまざまな実験を通じて、Facebookは人々のエンゲージメントが少なく、アプリに費やす時間が少ないことを発見したため、アイデアを放棄しました。

これは、Haugenがプラットフォームに対する批判の中で提起する中心的な質問であり、Facebookは、少なくとも知覚的には、ビジネス上の利益を損なう可能性がある場合、害を及ぼす可能性のある要素に対して行動を起こすことをためらっています。

Facebookの規模と影響力において、これは重要な考慮事項であり、より透明性が必要なものです。

Facebookは、CEOのMark Zuckerbergが次のように説明しているように、システムを改善するという明確な目的でそのような調査を行っていると主張しています。

「研究を無視したいのなら、そもそもこれらの重要な問題を理解するために業界をリードする研究プログラムを作成するのはなぜでしょうか。 有害なコンテンツとの戦いを気にしないのなら、なぜ私たちのスペースで他のどの会社よりも多くの人々をこれに専念させるのでしょうか? 結果を隠したいのなら、なぜ私たちは透明性と私たちがしていることについて報告するための業界をリードする基準を確立したのでしょうか?」

これは理にかなっていますが、その検査によって潜在的な危害のレベルが検出されたときに、結果としてビジネス上の考慮事項がその後の決定に影響を与えるかどうかは説明されません。

それが問題の核心です。 Facebookの影響は明らかであり、接続および情報配信チャネルとしてのFacebookの重要性は明らかです。 しかし、そのような懸念を評価する際に、何に対して行動を起こし、何を残すかに関して、その決定に何が影響するのでしょうか。

この場合に示されているように、Facebook自体のデータが問題を浮き彫りにしている場合でも、Facebookがそのようなことを強く押し付けすぎないようにしたことを示唆する証拠があります。 Facebookには返信する権利があり、Haugenの告発に対応するための法廷での日が必要ですが、特に同社が将来に向けてさらに没入型で包括的な接続ツールを作成することを目指しているため、これは私たちが本当に答える必要があるものです。 。