كيف يزحف Google إلى موقع الويب الخاص بك والفهارس

نشرت: 2016-02-18كيف يزحف Google إلى صفحات AMP و JavaScript و AJAX لموقع الويب الخاص بك

آخر تحديث: 6 مارس 2021

"خطوة" كبيرة إلى الأمام في كيفية "الزحف" إلى محتوى Ajax من Google! يعد Google الأفضل في العالم من حيث الزحف إلى المحتوى داخل JavaScript و AJAX. ومع ذلك ، ما زالوا يتقنونها. هل تجد أنها ساحة معركة الحصول على الزحف إلى موقعك؟

غيّرت Google طريقتها في التعامل مع مكالمات AJAX لمحتوى الويب. قال John Mueller من Google إنه يمكن "تشغيلها وإيقافها" لذلك هناك تكتيكات إضافية لتحسين محركات البحث يمكن لخبراء البحث المشاركة بها لإعلام Google بقصد الزحف إلى المحتوى. للمضي قدمًا ، من الأفضل عدم الاعتماد على الطريقة التي كانت عليها من قبل. سيساعدك وجود عملية تسويق رشيقة على التنقل في التغييرات بشكل أسرع.

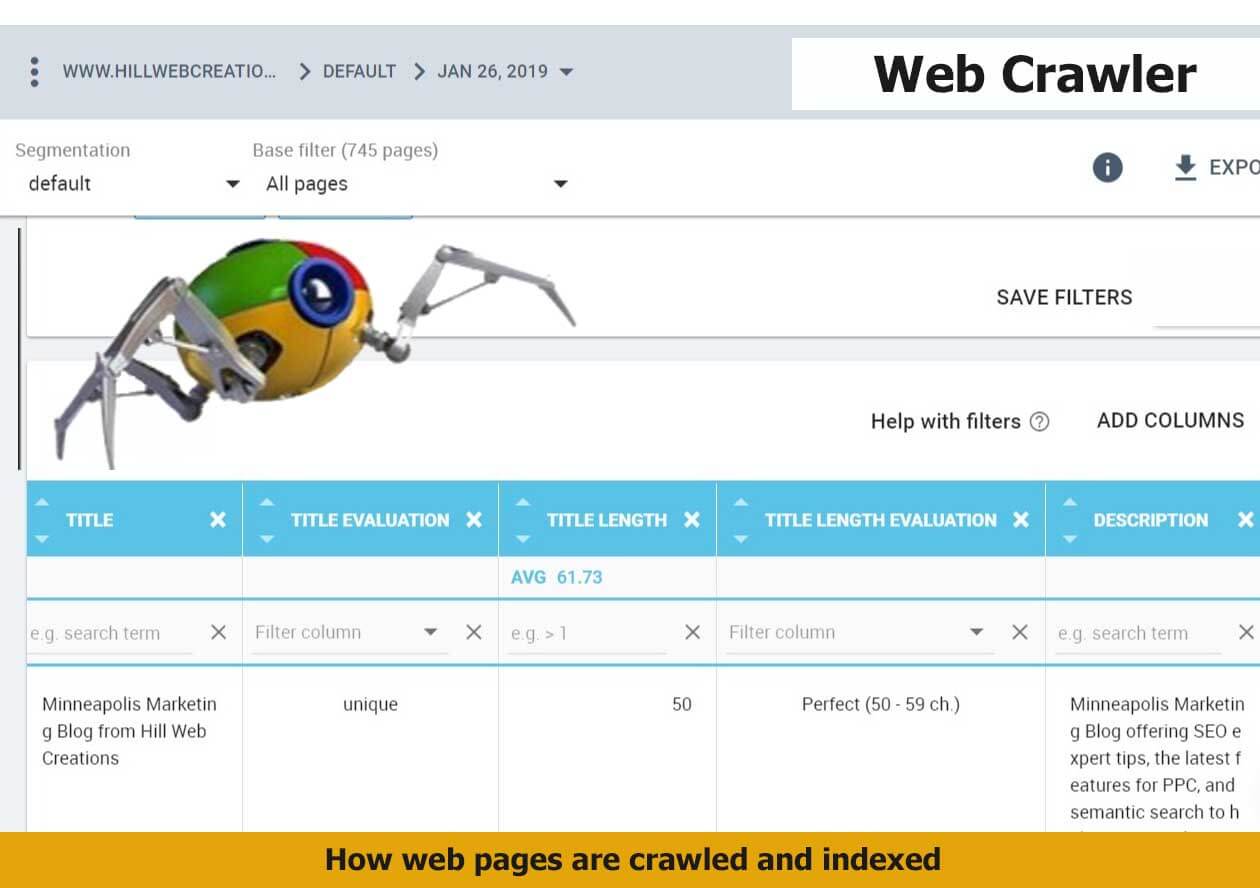

يمكنك الاستفادة من الإحصاءات المكتشفة في Google Search Console ، ومعرفة كيفية قراءتها وتفسيرها بشكل أفضل من الإجابات والتفسيرات الواردة في هذه المقالة. تكشف تقارير "أساسيات الويب الأساسية" عن مشكلات PageSpeed .

ما هو الزحف والفهرسة في Google؟

يظل الزحف والفهرسة مهمتين مختلفتين. يحدث الزحف عندما ينظر Googlebot إلى كل المحتوى والشفرة على صفحة ويب ويحللها. تتم الفهرسة عندما تكون نفس الصفحة مؤهلة للتضمين والظهور في نتائج بحث Google. منذ تحديث Google Panda ، ارتفعت أهمية اسم المجال بشكل ملحوظ. يعتمد نمو عملك من عالم الإنترنت على الزحف إلى صفحات الويب الخاصة بك وفهرستها بشكل صحيح.

تقوم بعض الشركات بعمل كل ما يتعلق بإنشاء محتوى رائع وتحسين مواقعها ولكنها تفشل في فهرسة المحتوى الرئيسي. لهذا السبب نوصي بأن تأخذ جلسات التخطيط للأعمال والاستراتيجية في الاعتبار هذا الأمر مقدمًا.

ما هو GoogleBot؟

Googlebot هو برنامج روبوت البحث الذي تستخدمه Google ، والذي يجمع المستندات من الويب لإنشاء فهرس يمكن البحث فيه لمحرك بحث Google.

سواء كنت تسعى إلى تعلم طرق Google Crawler للبحث المكتسب أو البحث المدفوع ، يمكن لـ SEO تحسين أساليب البحث من خلال الفهم الصحيح لبرنامج GoogleBot.

GoogleBot هو ذراع محرك بحث Google الذي يزحف إلى صفحات الويب الخاصة بك ويقوم بإنشاء فهرس. يُعرف أيضًا باسم العنكبوت. يستخدم GoogleBot التعلم الآلي للزحف إلى كل صفحة تسمح له بالوصول إليها وإضافتها إلى فهرس Google حيث يمكن استردادها وإعادتها لمطابقة استعلامات بحث المستخدمين. جهودك لتوضيح Google للصفحات التي تريد الزحف إليها على موقع الويب الخاص بك والصفحات التي لا تريدها يمكن أن تبدو قتالية أيضًا.

كيف أعرف ما إذا كان موقعي موجودًا في فهرس Google؟

سيختبر تقرير معلومات "فهرس Google" في Google Search Console عنوان URL في موقعك. ستكشف أداة فحص عنوان URL الخاصة به عن حالة الفهرس الحالية لعنوان URL. ستحتاج إلى إدخال عنوان URL الكامل لفحصه والحصول على تقرير حالة الفهرس.

يمكنك استخدام أداة الجلب مثل Google لمعرفة كيف يبدو موقعك عند الزحف إليه بواسطة Google. من هذا ، يمكن لمالكي المواقع الاستفادة من المزيد من الخيارات الدقيقة ويمكنهم تحديد كيفية فهرسة المحتوى في حالة صفحة بصفحة. أحد الأمثلة على ذلك هو القدرة على رؤية كيف تظهر صفحاتك مع مقتطف أو بدونه - في نسخة مخبأة ، وهي نسخة بديلة يتم جمعها على خوادم Google في حالة عدم إمكانية عرض الصفحة المباشرة في الوقت الحالي.

هناك طريقة أخرى للتحقق من حالة الفهرس لأي عنوان URL للموقع وهي باستخدام info: عامل التشغيل. استخدم متصفح Google Chrome وأدخل المعلومات: URL في شريط التنقل. سيؤدي هذا إلى تشغيل عرض Google: عرض ذاكرة التخزين المؤقت لـ Google لـ "example-domain-url". ابحث عن صفحات ويب مشابهة لـ "example-domain-url".

كيف تعمل فهارس Google على مواقع JavaScript؟

عندما يحتاج Google إلى الزحف إلى مواقع جافا سكريبت ، فإن الأمر يتطلب مرحلة إضافية لا يحتاجها محتوى HTML التقليدي. تُعرف بمرحلة العرض ، والتي تستغرق وقتًا إضافيًا. تعتبر مرحلة الفهرسة ومرحلة العرض مرحلتين منفصلتين ، مما يتيح لـ Google فهرسة المحتوى الذي لا يحتوي على جافا سكريبت أولاً.

جافا سكريبت عملية تستغرق وقتًا طويلاً بالنسبة لـ Google للزحف والفهرسة. والسبب هو أنه يجب تنزيله أولاً وتحليله ثم تنفيذه.

كيف يتم التعامل مع العرض المسبق لجافا سكريبت داخل المخرجات المعروضة؟

يمكن لبرنامج GoogleBot عرض جافا سكريبت مسبقًا المستخدم داخل الإخراج المعروض. ينظر عملاق التكنولوجيا إلى عرض JS مسبقًا من منظور تجربة المستخدم. هذا يجعل الأمر أسهل لأنه يلغي الحاجة إلى إزالة JS من الصفحات المعروضة مسبقًا. إذا كان موقعك يعتمد على JS لإدارة محتوى الموقع البسيط وتحديثات التخطيط ولكن ليس طلبات AJAX ، فابق على اتصال مع Martin Splitt ، المتحدث باسم Google حول التكنولوجيا المتقدمة للتعامل مع حالات الزحف / الفهرسة هذه.

ما مدى أهمية عملية الزحف والفهرسة في Google؟

يعد الحصول على موقع الويب الخاص بك بالزحف بواسطة Google وفهرسته بشكل صحيح أمرًا محوريًا في نجاح التسويق عبر الإنترنت. إنها نقطة البداية بأكملها. يجب أن يكون لديك زحف الويب والقدرة على الفهرسة لتحقيق النجاح. بدون تحميل خريطة الموقع إلى المجلد الجذر لموقع الويب الخاص بك ، يمكن أن يستغرق الزحف وقتًا طويلاً - ربما 24 ساعة أو أكثر لفهرسة منشور مدونة جديد أو موقع ويب عميق.

لا يدرك معظم متصفحي الإنترنت أبدًا الخطوات المختلفة التي اتخذتها لتحسين إمكانية الزحف إلى موقعك وفهرسته .

وفقًا لـ Google ، "يحتوي فهرس بحث Google على مئات المليارات من صفحات الويب ويزيد حجمه عن 100،000 غيغابايت".

كيف تدير الأصول القديمة للحصول على أفضل سجل للزحف؟

يزحف Googlebot إلى الأصول المختلفة التي لا معنى لها والتي تم منحها حاليًا حالة 404. عادة ، يجب الاحتفاظ بالأصول القديمة حتى يتوقف الزحف إليها. في النهاية ، ستعيد Google الزحف إلى محتوى HTML وتقييم أصول الموقع الجديدة وتحديث الزاحف الخاص بها. لا نوصي باستخدام 401 أو 404 لإدارة الأصول القديمة ؛ قد يؤدي هذا إلى إنهاء عمليات العرض المكسورة. وهو شيء يجب تجنبه. يحدث ذلك في بعض الأحيان عند استخدام Rails Asset Pipeline للتخزين المؤقت.

هناك مفهومان مهمان تحتاج إلى فهمهما حتى تتمكن Google من الزحف إلى موقع الويب الخاص بك وهما:

1. إذا كنت تريد الزحف إلى موقعك وفهرسته ، فيجب أن تكون عناكب محركات البحث قادرة على عرض موقعك بشكل صحيح.

2. هناك الكثير الذي يمكنك القيام به لضمان الزحف إلى موقع الويب الخاص بك بشكل صحيح بواسطة عناكب Google.

إن متتبع ارتباطات الويب ، الذي يُطلق عليه أحيانًا اسم العنكبوت أو spiderbot أو عنكبوت الويب ، وغالبًا ما يتم اختصاره إلى برنامج الزاحف ، هو روبوت إنترنت يتصفح شبكة الويب العالمية بشكل منهجي ، وعادةً ما يكون لغرض فهرسة الويب. يمكنك مساعدة Google في فهم المحتوى الخاص بك بشكل أفضل وفهرسته في مكتبة Google إذا قمت بإضافة جميع أنواع ترميز المخططات الأساسية .

رؤى جديدة حول المحتوى المشترك وكيفية قيام Google بالزحف إلى AJAX

يمكن لـ Google الآن فهرسة مكالمات ajax ومن المهم فهم ما يعنيه ذلك في نتائج بحث Google.

عندما سُئل جون مولر في جلسة Hangout التي عقدت يوم الجمعة الماضي باللغة الإنجليزية في مركز مشرفي مواقع Google باللغة الإنجليزية عن كيفية التعامل مع المحتوى المشترك ومكالمة أجاكس ، كان رده: "في الماضي ، تجاهلنا ذلك بشكل أساسي. ما يمكن فعله هو استخدام JS. " أجد أنه من الرائع ما تغير وما يمكن أن نتوقعه. يمكنك الإشارة إلى رغبتك في عرض صفحة للفهرسة مع استبعاد عنوان ديناميكي. إذا كنت ترغب في استبعاد جزء من الصفحة ، فيمكنك القيام بذلك باستخدام ملف robots.txt للإشارة إلى هذه الرغبة. احتفظ بمحتوى Accelerated Mobile Page الخاص بك بالقرب من إصدارات سطح المكتب قدر الإمكان.

على سبيل المثال ، صفحة تفاصيل المنتج تحتوي على وصف وتعليقات وأزرار وإجابات (سؤال وجواب). يمكن إخفاء ذلك الجزء من المكالمة المرخصة ؛ قد يقترح نقل هذا المحتوى داخل دليل منفصل داخل الموقع حيث تقوم بتجميع هذا ، بحيث يمكن أن يمنع المحتوى المجمع بواسطة ملف robot.txt الخاص بك. قد يؤدي ذلك إلى تجنب ظهور المحتوى الذي تنشئه تلقائيًا غير موجود فعليًا على الموقع.

"ما نحاول القيام به هو عرض الصفحة كما تبدو في المتصفح. انظر إلى النتائج النهائية واستخدم هذه النتائج في البحث "أضاف مولر. إذا كنت تريد فقط عدم أخذ جزء من الصفحة في الحسبان ، فيمكن لمشرفي المواقع إجراء روبوتات النص. ومن المثير للاهتمام ، حتى Mueller ألمح إلى أنه قد يكون من الصعب الإشارة إلى محتوى AJAX الذي لا تريد تحليله داخل صفحة معينة ، بينما يتم تحليل باقي الصفحة لمحتوى AJAX.

لن تقوم Google دائمًا بالزحف إلى كل جافا سكريبت الخاص بك طوال الوقت. قال مولر: "لا تزال تعمل وتتوقف ولكنها تتجه نحو المزيد والمزيد". يبدو من الواضح أن مطوري Google يشاهدون اختبارات حول كيفية زحف Google إلى AJAX ويريدون فهرسة العناوين بشكل صحيح التي يتم حقنها باستخدام JavaScript وبشكل أكثر اتساقًا. لا يتعلق الأمر بـ "تسلل المحتوى إلى المستخدم الذي لم تتم فهرسته".

لا تزال الصيانة اليدوية لملف robots.txt لموقع الويب الخاص بك فكرة جيدة إذا كان لديك محتوى معين لديك أو لا تريد الزحف إليه.

نظرة عامة على كيفية قيام Google بالزحف إلى مواقع الويب

1. أول شيء يجب معرفته هو أن موقع الويب الخاص بك يتم الزحف إليه دائمًا. أشارت Google إلى أن ؛ "يجب ألا يصل Googlebot إلى موقعك أكثر من مرة كل بضع ثوانٍ في المتوسط." بمعنى آخر ، يتم دائمًا الزحف إلى موقعك ، بشرط أن يتم إعداد موقعك بشكل صحيح ليكون متاحًا لبرامج الزحف. "معدل الزحف" من Google يعني سرعة طلبات Googlebot ؛ لا يتعلق الأمر بعدد المرات التي يتم فيها الزحف إلى موقع الويب الخاص بك. عادةً ما تكون الشركات أكثر وضوحًا ، والذي يأتي جزئيًا من الحداثة ، والروابط الخلفية ذات الصلة بالسلطة ، والمشاركات الاجتماعية والإشارات ، وما إلى ذلك ، كلما زاد احتمال ظهور موقعك في نتائج البحث. تخيل عدد عمليات الزحف التي يقوم بها Googlebot ، لذلك ليس من الممكن أو الضروري دائمًا الزحف إلى كل صفحة على موقعك طوال الوقت.

2. يتمثل الإجراء الروتيني لـ Google في الوصول أولاً إلى ملف robots.txt الخاص بالموقع. ومن هناك يتعرف على ما حدده مالك الموقع بشأن المحتوى الذي يُسمح لـ Google بالزحف إليه وفهرسته على الموقع. لن تتم فهرسة أية صفحات ويب يُشار إلى أنها "غير مسموح بها".

كما هو الحال بالنسبة لعمل تحسين محركات البحث بشكل عام ، من المهم الحفاظ على تحديث ملف robots.txt الخاص بك. إنها ليست صفقة لمرة واحدة. تعد معرفة كيفية إدارة الزحف باستخدام ملف robots.txt مهمة ماهرة. يجب أن يغطي التدقيق الفني لموقع الويب الخاص بك تغطية وبناء جملة ملف robots.txt الخاص بك ويتيح لك معرفة كيفية إصلاح أي مشكلات حالية.

3. يقرأ Google ملف sitemap.xml بعد ذلك. على الرغم من أن محركات البحث لا تحتاج إلى خريطة موقع لاكتشاف أي وجميع مناطق الموقع التي سيتم الزحف إليها وفهرستها ، إلا أنها لا تزال ذات استخدام عملي. نظرًا لكيفية إنشاء مواقع الويب المختلفة وتحسينها ، فقد لا تقوم برامج زحف الويب بالزحف آليًا إلى كل صفحة أو مقطع. يستفيد بعض المحتوى أكثر من خريطة موقع احترافية جيدة الإنشاء ؛ مثل المحتوى الديناميكي والصفحات الأقل مرتبة أو أرشيفات المحتوى الموسعة وملفات PDF مع القليل من الارتباط الداخلي. تساعد خرائط المواقع أيضًا GoogleBot في فهم البيانات الوصفية بسرعة ضمن فئات مثل المقالات الإخبارية والفيديو والصور وملفات PDF والجوال.

4. تزحف محركات البحث بشكل متكرر إلى المواقع التي لها عامل ثقة ثابت. إذا اكتسبت صفحات الويب الخاصة بك ميزة PageRank في نظام ترتيب الصفحات ، فقد رأينا أوقاتًا يمنح فيها Googlebot موقعًا ما يسمى "ميزانية الزحف". كلما زادت الثقة والسلطة المتخصصة التي اكتسبها موقع عملك ، زادت ميزانية الزحف التي يمكنك توقع الاستفادة منها.

لماذا قد يؤثر هيكل ربط الموقع على معدل الزحف وثقة المجال

بمجرد أن تفهم كيفية عمل Google Crawler ، فإن التحديثات الجديدة التي قد تعكس ما إذا كانت قد رفعت بعض عوامل تصفية البحث أو تم تطبيقها ، أو إذا كان التصحيح الجديد أسهل في الاستجابة ، أو تغيير في بنية ارتباط المجال . قم بقياس أداء موقعك في تغييرات تصنيف SERP بالإضافة إلى منافسيك لمعرفة ما إذا كان كل شخص قد حقق طفرة في تحويل حركة المرور في وقت معين. سيساعد هذا في استبعاد حدوث منعزل.

كن أخلاقيا واكسب ثقة المجال. بدلاً من محاولة الاحتفاظ بسر خادم الويب ، ما عليك سوى اتباع أفضل ممارسات البحث في Google من البداية. "بمجرد أن يتبع شخص ما رابطًا من خادمك" السري "إلى خادم ويب آخر ، قد يظهر عنوان URL" السري "الخاص بك في علامة المرجع ويمكن تخزينه ونشره بواسطة خادم الويب الآخر في سجل المرجع الخاص به. وبالمثل ، يحتوي الويب على العديد من الروابط القديمة والمعطلة "، كما يقول عملاق البحث . عندما ينشر شخص ما رابطًا بشكل غير صحيح إلى موقع الويب الخاص بك أو يفشل في تحديث الروابط لتعكس التغييرات في الخادم الخاص بك ، فإن النتيجة هي أن GoogleBot سيحاول الآن تنزيل ارتباط غير صحيح من موقعك.

كيف يساعد ترميز المحتوى الخاص بك في مساعدة برنامج تتبع الارتباطات في Google

عندما يقوم أحد خبراء تحسين محركات البحث (SEO) بتنفيذ بيانات Google المنظمة بشكل صحيح لترميز محتوى الويب ، يمكن لـ Google فهم سياقك بشكل أفضل لعرضه في البحث. هذا يعني أنه يمكنك تحقيق التوزيع الأفضل لصفحات الويب الخاصة بك لمستخدمي الإنترنت في بحث Google. يتم تحقيق ذلك عن طريق ترميز خصائص المحتوى وتمكين إجراءات المخطط عند الاقتضاء. هذا يجعله مؤهلاً للتضمين في بطاقات Google Now ، والعرض الكبير لمربعات الإجابات ، والمقتطفات الغنية المميزة .

خطوات ترميز خصائص محتوى الويب لبرنامج GoogleBot

1. حدد أفضل نوع بيانات من الجدول الذي يوفره schema.org.

اعثر على أفضل ما يناسب المحتوى الخاص بك ، ثم اختر من الدليل المرجعي للترميز لهذا النوع للعثور على الخصائص المطلوبة والموصى بها. يجوز إضافة ترميز لأنواع محتوى متعددة في صفحة محتوى HTML واحدة أو AMP HTML للمساعدة في زحف Google التالي. وجدنا أن المستخدمين يفضلون المقالات الإخبارية التي تحتوي على محتوى فيديو ، مما يخلق فرصة مثالية لإضافة ترميز للمساعدة في أهلية صفحة المحتوى الخاصة بك للتضمين في أهم الأخبار داخل دائرة الأخبار أو النتائج المنسقة للفيديو.

2. قم بصياغة قسم من الترميز يحتوي على منتجاتك وخدماتك الرئيسية .

اجعل الزحف إلى موقعك سهلاً قدر الإمكان بمساعدة خصائص البيانات المنظمة المطلوبة للعرض التقديمي المرئي في SERPs التي تريد الحصول عليها. تمتلك مُحسّنات محرّكات البحث الآن مرجعًا شاملاً لنوع البيانات للاستفادة منه والذي يحتوي على العديد من الأمثلة للترميز القابل للتخصيص. يمكن تحسين الزحف والفهرسة باستخدام خاصية Speakable schema.org التي تحدد الأقسام داخل المقالة. يمكنه سحب الإجابات داخل صفحات المعلومات الخاصة بك .

"إذا قدمت لنا صفحة معروضة من جانب الخادم ، وكان لديك JavaScript في تلك الصفحة يزيل كل المحتوى أو يعيد تحميل كل المحتوى بطريقة يمكن أن تتعطل ، فهذا شيء يمكن أن يكسر الفهرسة بالنسبة لنا. لذلك ، هذا هو الشيء الوحيد الذي أتأكد من أنه إذا قمت بتسليم صفحة معروضة من جانب الخادم ولا يزال لديك جافا سكريبت هناك ، فتأكد من أنها مبنية بطريقة أنه عند تعطل JavaScript ، فإنها لا تزيل المحتوى ، ولكن بل إنه لم يكن قادرًا على استبدال المحتوى حتى الآن ". - جون مولر من Google "

ما هي ميزانية الزحف في Google؟

"أفضل طريقة للتفكير في الأمر هي أن عدد الصفحات التي نزحف إليها يتناسب تقريبًا مع نظام ترتيب الصفحات لديك. لذلك إذا كان لديك الكثير من الروابط الواردة على صفحتك الرئيسية ، فسنقوم بالتأكيد بالزحف إلى ذلك. بعد ذلك ، قد ترتبط صفحتك الجذرية بصفحات أخرى ، وستحصل هذه الصفحات على PageRank وسنقوم بالزحف إليها أيضًا. ومع ذلك ، فكلما تعمقت أكثر في موقعك ، فإن نظام ترتيب الصفحات يميل إلى التدهور "، وفقًا لإريك إنج من ستون تمبل.

تأكد من أنهم يفهمون الأساسيات تمامًا قبل مناقشة تحسين الزحف مع استشاري محتمل. ميزانية الزحف هي مصطلح لا يعرفه البعض. يجب تحديد الوقت أو عدد الصفحات التي تخصصها Google للزحف إلى موقعك. إذا قمت بحل المشكلات الرئيسية التي تعيق أداء موقع الويب ، فقد يتحسن الزحف.

يقدم Matt Cutts من Google لمحركات البحث ما يجب مراعاته فيما يتعلق بعدد الصفحات التي يتم الزحف إليها. في عام 2010 صرح قائلاً: "لا يوجد شيء مثل حد أقصى للمؤشرات. كان الكثير من الناس يعتقدون أن المجال سيحصل فقط على عدد معين من الصفحات مفهرسة ، وهذه ليست الطريقة التي يعمل بها. كما لا يوجد حد صارم لعملية الزحف لدينا ".

وجدنا أنه يساعد في عرضها مع التركيز على عدد الصفحات التي تم الزحف إليها بما يتناسب مع نظام ترتيب الصفحات الخاص بك وثقة المجال. وأضاف: "إذا كان لديك الكثير من الروابط الواردة على صفحتك الرئيسية ، فسنقوم بالتأكيد بالزحف إلى ذلك." تعرف على المزيد حول ما يقوله John Mueller حول ملف تعريف الرابط الخلفي للموقع .

بيانات خرائط المواقع في تغطية الفهرس

الإجابة عن الأسئلة العالقة حول كيفية قيام Google بالزحف إلى مواقع الويب.

مع اكتمال Google Search Console الجديد ، يسأل الكثير عن التقارير التي ستظل متاحة لفهم الزحف والفهرسة بشكل أفضل.

"بينما نمضي قدمًا في استخدام Search Console الجديد ، نوقف تشغيل تقرير خرائط المواقع القديم. يحتوي تقرير خرائط المواقع الجديد على معظم وظائف التقرير القديم ، ونهدف إلى نقل بقية المعلومات - خاصة للصور والفيديو - إلى التقارير الجديدة بمرور الوقت. علاوة على ذلك ، لتتبع عناوين URL المقدمة في ملفات خريطة الموقع ، ضمن تقرير تغطية الفهرس ، يمكنك تحديد ملفات خريطة الموقع وتصفيتها. هذا يجعل من السهل التركيز على عناوين URL التي تهتم بها ". - جون مولر في 25 يناير 2019

Givien ظهور البحث المرئي في Google ، من المهم اليوم فهرسة ملفات الصور والفيديو بشكل صحيح. يمكن أن تؤدي الأصول المرئية القوية إلى البيع. تعمل الفهرسة الصحيحة لصفحات المنتجات والصور على تشغيل دوارات منتجات Google .

في 9.7.2016 ، تحدث جون مولر عما إذا كان يتعين على Google عرض صفحة ثم مشاهدة إعادة توجيه ، فهذا يتسبب في حدوث تأخير. عندما يُسأل ، "هل هناك أي نوع من الجدول الزمني لوقت الزحف إلى الصفحات؟" أجاب: إنه علمي.

عند السؤال عما إذا كان المحتوى الذي يحتوي على بيانات منظمة يتضمن معلومات مثل السعر أو العناصر التي قد تكون غير متوفرة في المخزون ، هل يؤدي ذلك إلى زيادة معدل الزحف للحصول على بيانات دقيقة؟ كان الرد ، "إنه مجال تقني معقد." أضاف جون مولر ، "أعتقد أن البيانات المنظمة هي شيء يمكنك أن تقدمه لنا بطرق مختلفة. استخدم خريطة الموقع لإعلامنا. لا يعني وجود بعض معلومات التسعير أنه سيتم تحديث البيانات بسرعة ".

خوارزمية الباندا مستمرة ولكنها لا تعمل عند الزحف

نحن نعلم أن الزحف إلى الموقع هو العملية التي يكتشف من خلالها Googlebot الصفحات الجديدة والمحدثة لإضافتها إلى فهرس Google ويقوم بذلك من خلال عملية حسابية: نظرًا لأن برامج الكمبيوتر الخاصة به تحدد المواقع التي يتم الزحف إليها ، وعدد مرات الزحف إلى الصفحات ، والجودة التقييم الذي يقدمه لأنه يعيد معالجة الجزء الأكبر من موقع الويب ، يمكن بشكل عام إعادة امتلاك موقع ويب صغير في غضون شهرين. يساعد نشر المنشورات على قائمة Google Business الخاصة بك في الحصول على عناوين URL هذه مباشرة في فهرس Google.

تعمل خوارزمية Panda بشكل مستمر ، وليس وفقًا لأي جدول زمني محدد مسبقًا ، ولكنها تستغرق بعض الوقت ، مثل أشهر لبعض المواقع ، لجمع الإشارات الدلالية ذات الصلة للزحف . يختلف معدل الزحف من موقع لآخر ، وفقًا لجوجل جون مولر.

س. عند السؤال ، "ما أفضل طريقة لاستخدام العرض الديناميكي إذا كان لديك كل من إصدار سطح المكتب لموقعك وإصدار AMP كإصدار للجوال؟"

ج. "أعتقد أننا نزحف إلى صفحة AMP باستخدام GoogleBot العادي إذا كنت تستخدم العرض الديناميكي فلن نرى صفحة AMP مطلقًا. اعتمادًا على المعلمات التي تستخدمها في وكيلك ، تحصل فجأة على صفحة AMP مقابل صفحة HTML ". تعتبر صفحات AMP التي يتم عرضها ديناميكيًا معقدة أيضًا للعملاء غير التابعين لـ Google مثل Twitter إذا أرادوا سحب نسخة AMP من الصفحة. حث جون مولر مشرفي المواقع على تجنب المشكلات الفنية على موقع الويب.

س. عند السؤال عن كيفية التنصل من صفحة ما بعد أن تم استهدافها بواسطة مُحسنات محركات البحث السلبية؟ يمكن استخدام ملف التنصل لكسر الارتباط بهذا الرابط الخلفي. "هل من المهم أن تستمر في الزحف إلى صفحة الروابط الخلفية حتى يتم تحديث ملف التنصل؟"

ج: "نقوم بإسقاط الرابط بعد إعادة الزحف إلى الصفحة الأخرى أو إعادة معالجتها. إذا لم نهتم بإعادة الزحف كثيرًا ، فلن يكون لذلك وزن كبير على أي حال. إذا استغرق الأمر ستة أشهر حتى يتم الزحف إلى هذه الصفحة مرة أخرى ". تحدد المصنفات متى يكون الموقع جاهزًا لإعادة النظر فيه وتحاول التقييم لتشكيل إرشادات عامة لفهرسة الأجهزة المحمولة. يحاول Search Giant اكتشاف ما هو مناسب فعلاً للزحف عبر الأجهزة المحمولة.

شاهد جلسة Hangout المركزية الكاملة لمشرفي المواقع من Google للحصول على التفاصيل الكاملة. تحاول Google التركيز على عناوين URL الأكثر أهمية داخل موقع الويب. إذا لزم الأمر ، أرسل تقارير عن البريد العشوائي ثم سيحاول التعرف على مُحسنات محركات البحث السلبية من قبل شخص آخر والتي تهدف إلى منع قدرة الموقع على الزحف بنجاح. في معظم الحالات ، ركز على ما يمكنك القيام به لتحسين موقعك ، وإنشاء سجل بحث إيجابي ، وجعله أقوى وأفضل.

"نحن لا نزحف إلى عناوين URL بنفس التردد طوال الوقت. لذلك سنزحف إلى بعض عناوين URL يوميًا. قد تكون بعض عناوين URL أسبوعية. عناوين URL أخرى كل شهرين ، وربما كل نصف عام أو نحو ذلك.

وإذا أجريت تغييرات كبيرة على موقع الويب الخاص بك في جميع المجالات ، فمن المحتمل أن يتم التقاط الكثير من هذه التغييرات بسرعة إلى حد ما ولكن ستكون هناك بعض التغييرات المتبقية.

هذا ملف خريطة موقع به تاريخ التعديل الأخير بحيث يتوقف محرك بحث Google ويحاول التحقق مرة أخرى من هذه الملفات بشكل أسرع قليلاً من غير ذلك ". - جون مولر

المشاكل الحالية التي قد لا يزال Google Crawler يواجهها

1. المواقع ذات البنية المعقدة لعناوين URL ، والتي غالبًا ما تكون بسبب مشكلات في معلمات عناوين URL. يمكن أن يؤدي خلط أشياء مثل معرفات الجلسة في المسار إلى الزحف إلى عدد من عناوين URL. من الناحية العملية ، لا تتعثر Google حقًا هناك ؛ ولكن يمكن أن يضيع الكثير من الموارد التي يحتاجها موقعك لاستخدامها بحكمة أكبر.

2. قد يبطئ برنامج GoogleBot الزحف عندما يعثر على أقسام المسار نفسها تتكرر مرارًا وتكرارًا.

3. لعرض المحتوى ، إذا لم يتمكن برنامج تتبع الارتباطات من Google من سحب محتوى الصفحة على الفور ، فإنه يعرض الصفحات لمعرفة ما سيحدث. إذا كانت هناك أي عناصر بالصفحة يجب عليك النقر فوقها أو القيام بشيء ما لمشاهدة المحتوى ، فقد يكون هذا أيضًا شيئًا قد يفوتها. لن يقوم GoogleBot بالنقر لمعرفة ما قد يحدث. قال جون مولر ، "لا أعتقد أننا نجرب أيًا من عناصر النقر. ليس الأمر كما لو أننا نمرر مرة تلو الأخرى ".

ما فهمته من المحادثة هو أنه يساعد على التمييز بين ما لم يتم تحميله حتى يتخذ المستخدم إجراءً وما لا يستطيع GoogleBot رؤيته دون التمرير لأسفل.

بدلاً من قضاء وقت طويل في تكوين JavaScript لإدارة ما يتم عرضه على الصفحة ، ابحث عما يوفر للمستخدم النهائي المحتوى الأكثر ملاءمة وكاملة. ضع في اعتبارك تعديل ترقيم الصفحات وجافا سكريبت والتقنيات التي تساعد المستخدمين في الحصول على تجربة أفضل. "للمرة الثالثة والأخيرة ، انظر إلى AMP ، كرر أندري ليباتسيف في ختام الحدث.

نوصي بشدة أن يستعد كل موقع بشكل مناسب للارتفاع في بحث Google للجوال . أيضًا ، قد تنتهي مهلة GoogleBot في محاولة الحصول على محتوى مضمن. بالنسبة للمستخدمين ، يمكن أن يؤدي ذلك إلى صعوبة الوصول.

أهم المعلومات التي تريد الزحف إليها هي:

- عناوين URL للويب - صفحاتك ومنشوراتك وعناوين URL للويب الخاصة بالمستند الرئيسي.

- علامات عنوان الصفحة - تشير علامات عنوان الصفحة إلى اسم صفحة الويب أو منشور المدونة أو مقالة الأخبار.

- البيانات الوصفية - يمكن أن يشمل ذلك العديد من الأشياء مثل وصف صفحتك وترميز البيانات المنظمة والكلمات الرئيسية الشائعة.

هذه هي المعلومات الرئيسية التي يستردها GoogleBot عندما يزحف إلى موقعك. وهذا أيضًا على الأرجح ما تراه مفهرسًا. هذا هو المفهوم الأساسي. بالنسبة إلى الموقع الذي يتقدم ، هناك الكثير من التعقيد في طريقة الزحف إلى موقعك وكيفية عرض نتائج البحث وتنظيمها وإتاحة الفرصة لها للظهور في المقتطفات المنسقة. لاحظ أن Google تلاحظ المراجعات المنشورة على نظامها الأساسي ؛ إذا لم يقم بفهرسة موقعك لسبب ما ، فقد تظهر مراجعة Google في الحزمة المحلية وفي أي مكان آخر.

كيف يزحف Google إلى امتدادات المجال الجديدة

أعلنت Google في 7 يوليو 2015 كيف تخطط للتعامل مع ترتيب المجالات الجديدة مثل .news و. باختصار: سيتم تصنيفهم تمامًا مثل .com و. net. في هذه البيئة الرقمية الإبداعية ، فإن مشاهدة عرض توضيحي مباشر لكيفية تجربة Google لموقعك أثناء الزحف سيُظهر كيف أن مُحسّنات محرّكات البحث المتميزة تقدم بشكل أفضل محتوى حقيقيًا وملموسًا وملموسًا لعمليات البحث اليومية على الإنترنت. مع امتدادات النطاقات الجديدة هنا والتوسيع ، إذا كنت تستخدمها ، فتأكد من أن موقعك سيتم الزحف إليه تلقائيًا وتقديم المحتوى بشكل طبيعي تمامًا.

تقدم Google لمحات حول كيفية تعامل Google Crawler مع هذه المجالات القادمة في نتائج البحث ، على أمل تخطي المفاهيم الخاطئة المحتملة حول كيفية معالجة أحدث خيارات امتداد النطاق. عندما سئل عما إذا كان a.BRAND TLD قد يكتسب وزنًا أكثر أو أقل من .com ، أجابت Google: "لا. سيتم التعامل مع TLDs هذه مثل gTLDs الأخرى. سوف تتطلب نفس إعدادات الاستهداف الجغرافي والتكوين ، ولن يكون لها وزن أو تأثير أكبر في الطريقة التي نقوم بالزحف إلى عناوين URL أو فهرستها أو ترتيبها ".

بالنسبة إلى مشرفي المواقع الذين قد يتساءلون عن كيفية تأثير gTLDs الأحدث على البحث ، علمنا أن Google ستتعامل مع gTLDs الجديدة مثل gTLDs الأخرى (على سبيل المثال ، example.com و .net و .org). من خلال تفسيرنا للمنشور ، لن يؤثر استخدام الكلمات الرئيسية في TLD على المواقع من خلال منح ميزة أو عيب معين في تصنيفات SERP.

كم مرة يزحف GoogleBot إلى موقع ويب؟

يتم الزحف إلى المواقع الأحدث وتلك التي تقوم بإجراء تحديثات غير متكررة بمعدل أقل. في المتوسط ، قد يكتشف Googlebot موقع ويب جديدًا ويزحف إليه بأسرع أربعة أيام - إذا تم تنفيذ العمل الصحيح. وجدنا أيضًا أن الأمر قد يستغرق أربعة أسابيع. ومع ذلك ، فهذه الإجابة "تعتمد على الأمر" حقًا. سمعنا آخرين يطالبون بالفهرسة في نفس اليوم. تنص Google على أن الزحف والفهرسة عمليات يمكن أن تستغرق بعض الوقت وتعتمد على العديد من العوامل.

كيفية جعل تطبيقات الويب AJAX قابلة للزحف؟

عندما يختار WebMasters استخدام تطبيق AJAX مع محتوى يهدف إلى الظهور في نتائج البحث ، أعلنت Google عن عملية جديدة يمكنها ، عند تنفيذها ، مساعدة Google (وربما محركات البحث الرئيسية الإضافية) في الزحف إلى المحتوى الخاص بك وفهرسته. في الماضي ، شكلت تطبيقات الويب AJAX تحديات لمحركات البحث للمعالجة بسبب العملية الديناميكية التي قد يستلزمها محتوى AJAX.

معظم مالكي مواقع الويب لديهم مهام أكثر أهمية في متناول اليد من إعداد قيود الزحف أو الفهرسة أو تقديم صفحات الويب. يستغرق الأمر شخصًا عميقًا في مُحسّنات محرّكات البحث لتحديد الصفحات المؤهلة للظهور في نتائج البحث أو الأقسام الموجودة على الصفحة. بالنسبة للجزء الأكبر ، إذا تم تحسين محتوى الويب بشكل جيد ، فيجب فهرسة صفحاتك دون الحاجة إلى اتخاذ إجراءات إضافية. للحصول على نهج أكثر دقة غالبًا ما يكون مطلوبًا لعربات التسوق الكبيرة ، تتوفر العديد من الخيارات للإشارة إلى التفضيلات المتعلقة بكيفية السماح لمالك الموقع لـ Google بالزحف إلى موقعه وفهرسته. يتم تنفيذ معظم هذه الخبرة من خلال Google Search Console وملف يسمى “robots.txt”.

دعا جون مولر تعليقات من مشرفي المواقع فيما يتعلق بالزحف إلى أجاكس. مع تطور هذا الأمر ، أصبحت Google أكثر وضوحًا بشأن مدى جودة أو كيفية تحليل GoogleBot لجافا سكريبت و Ajax. من الأفضل أن تتابع تطورات التواصل حول الموضوع قبل تنفيذ الكثير من الآراء. في الوقت الحالي ، نوصي بعدم إرسال الكثير من عناصر الموقع المهمة أو محتوى الويب إلى Ajax / JavaScript.

المزيد من الوسائل المتقدمة لمساعدة Google في الزحف إلى موقع

ضمن Google Search Console ، المعروفة سابقًا باسم أدوات مشرفي المواقع من Google ، من الممكن إعداد معلمات URL. بالنسبة إلى موقع ويب بسيط ، لا يلزم هذا عادةً ؛ حتى أن Google تحذر المستخدمين من أنه يجب عليهم تطوير خبرة في تكتيك تحسين محركات البحث هذا قبل استخدامه. قد يكون تحديد ما إذا كان موقعك يواجه مشكلة في المحتوى المكرر أم لا.

يمكن أن تحدث مشكلات الزحف بسبب عناوين URL الديناميكية ، وهذا بدوره قد يعني أن لديك بعض التحديات في فهارس معلمات URL. يسمح قسم معلمات URL لمشرفي المواقع بتهيئة اختيارهم في كيفية قيام Google بالزحف إلى موقعك وفهرسته باستخدام معلمات عناوين URL. بشكل افتراضي ، يتم الزحف إلى صفحات الويب وفقًا للطريقة التي قرر بها GoogleBot القيام بذلك. يجب إعادة التحقق من صفحاتك التي تحتوي على إجابات رئيسية يحتاجها الأشخاص ؛ يجد العديد من الأفراد إجابات في قسم "اسأل أيضًا" .

من المفيد إذا كان لديك محتوى جديد للفوز بمزيد من عمليات الزحف المتكررة من Google. لذلك ، كلما زاد عدد مشاركاتك على مدونتك ، كلما توقعت أن يتم الزحف إليها بشكل متكرر. في السابق ، كانت Google Search Console تخزن بيانات الزحف التاريخية لمدة تصل إلى 90 يومًا فقط. مع توفر كميات أطول من البيانات التاريخية الآن ، يسعد مُحسنات محركات البحث (SEO) الذين يطلبون زيادة هذه الفترة الزمنية ، بالحصول على المزيد من البيانات لاكتشاف عادات الزحف لدى Google من حيث صلتها بموقعك.

التحضير لأداء الويب للجوال وعمليات الزحف الأسرع من Google

هل تعرف مدى جودة الزحف إلى موقع الجوال الخاص بك؟ قد تساعد صفحات الجوال المعجلة من Google (AMP) مالكي مواقع الويب على تحسين أدائهم في تصنيفات البحث وإمكانية الزحف لعالم الجوال أولاً . عادةً ما يتطلب التبديل إلى Google AMP ومعرفة كيفية تأثيره على قابلية الزحف إلى موقعك شخصًا من ذوي الخبرة في القيادة. لأولئك الذين يشاهدون رؤية الموقع وتحديد المواقع ، نعلم أن سرعة التحميل مهمة. إذا كانت صفحة الويب الخاصة بك متشابهة في جميع الخصائص الأخرى ولكن من أجل السرعة ، فتوقع أن يفضل GoogleBot التركيز على الموقع الأسرع الذي يسهل الزحف إليه ، وهو ما يجده المستخدمون مقنعًا ليحتلوا المرتبة الأولى في SERPs.

إذا كنت بحاجة إلى مساعدة في التحديث إلى صفحات الويب بتنسيق AMP ، فقم بإضافة ثم اختبار كيفية الزحف إلى موقع الجوال الخاص بك ، اقرأ هنا للحصول على حلول. قد يتم تحميل المواقع بشكل مختلف على أجهزة الجوال المختلفة مما يؤثر على أداء التحميل. اختبر لمعرفة ما إذا كانت خوادم التخزين المؤقت في Google يتم تحميلها بشكل أسرع على الاتصالات الأبطأ

إصلاح المشكلات المتعلقة باتصال الخادم الذي يضر بالزحف على الويب بسرعة

غالبًا ما يكون أصحاب الأعمال غير مدركين لجودة صفحة الاستضافة الخاصة بهم والخادم الذي يستخدمونه. هذا يثير نقطة واحدة مهمة للغاية. إذا كان موقع الويب الخاص بك يحتوي على أخطاء في الاتصال ، فقد تكون النتيجة أن Google لا يمكنه الوصول إلى الموقع عندما يحاول ذلك لأن موقعك معطل أو خوادمه معطلة. على وجه الخصوص ، إذا كنت تدير حملة إعلانات Google مرتبطة بصفحة مقصودة لا يمكن تحميلها إلى مشكلات الخادم ، فقد تكون النتائج مدمرة للغاية. قد تتلقى تحذيرًا في وحدة تحكم Google AdWords الخاصة بك والعديد منها ويمكنهم إلغاء الإعلان.

لكن لديك الكثير لتزنه بعد ذلك. قد تتوقف Google عن القدوم إلى موقعك إذا استمر هذا الأمر دون مراعاة ، فسوف تتأثر صحة موقعك سلبًا ، وقد تنخفض تصنيفات صفحتك ، ونتيجة لذلك ، قد تنخفض حركة المرور الخاصة بك بشكل كبير. إنه منطق محض - إذا لم تتمكن Google من الوصول إلى موقعك لفترة طويلة من الوقت ، فإنها ، كما نرغب ، بحاجة إلى الانتقال إلى المهام التي يمكن تنفيذها. قم بإعداد تنبيه - راقب اتصال الخادم لديك وأخطاء الزحف.

كيف يتم استخدام المخطط لفهرسة مواقع الويب؟

أكد Gary Illyes في Pubcon 2017 أن المخطط له دور في فهرسة صفحات الويب الخاصة بك وترتيبها ، وليس فقط للمساعدة في الظهور في ميزات البحث الغنية. أبلغت Jennifer Slegg عن منشور SEM الخاص بها ، أن المزيد من المواقع تحتاج أولاً إلى استخدامها ثم تحذر من أنك "تريد أن تكون حريصًا أنك لا تتعامل مع مخططك بطريقة غير مرغوب فيها ، استخدم فقط أنواع المخططات التي تناسب الصفحة أو الموقع. وإلا ، فإن المواقع تخاطر بالحصول على إجراء يدوي بشأن البيانات المنظمة غير المرغوب فيها ".

تعتبر البيانات المنظمة للتجارة الإلكترونية JSON-LD ذات أهمية خاصة ليتم تنفيذها إذا كان لديك عربة تسوق. The content on your website gets indexed and returned in search results. Schema markup helps your website rank better for every form of content. The content on your website gets indexed and returned in search results better when schema markup helps your individual pages be understood better for the topic they directly address. Keep a closer eye on the top 100 results in each category.

How does GoogleBot Check Web Page Resources?

Most of your web pages use CSS and/or JavaScript to load. How your site is built and how many of these resources are used impacts your load times. Typically both CSS and JavaScript are loaded as external files that are linked to from your HTML. Google must have the access they want to these resources in order to fully understand your web pages. Often someone unfamiliar with technical SEO issues and how Google crawls your website will block these files within your robots.txt file. Read reports in your Search Console to better understand Google Crawler .

You can check to determine if your website is adhering correctly to this guideline.

Take advantage of the Google guidelines tool while employing your SEO techniques to know what files (if any) are set up as “blocked” from Googlebot. It only stands to reason that if web crawlers cannot understand your site's contents, they cannot rank you. Google needs the right to crawl your web pages in order to understand them fully and match your content to relevant search queries. Put your page through the SEO tool to obtain a better idea of how Google sees your site. Or request us to perform this vital task for you. Then we can go over the results together so that you address any issues correctly.

Requesting crawl rate adjustments:

Submit your website to Google and wait at least 24 hours before seeking to determine if your crawl rate changed. Google support states that “The term crawl rate means how many requests per second Googlebot makes to your site when it is crawling it: for example, 5 requests per second. You cannot change how often Google crawls your site, but if you want Google to crawl new or updated content on your site, you should use Fetch as Google”.

If you use the Google Webmaster tools and go to site settings, you can request a limit to your crawl rate, the new rate lasts for ninety days.

Google Crawls Sites that Follow their Webmaster Guidelines

The answers you need to know that your site correctly follows the Google webmaster guidelines*** for being crawled.

* Page headers are present when accessed by Googlebot; have correct site data architecture .

* Well-formed static links are discovered.

* The number of on page links is not excessive.

* Page avoids ordinary accessibility issues.

* Robots.txt file found and is correctly formed.

* All images have alt text to help GoogleBot render pages faster.

* All CSS and JavaScript files testy as visible to Googlebot

* Sitemaps for both search engines and users are available.

* No page speed issues.

NOTE: Additionally, you'll want to know that your web server correctly supports the If-Modified-Since HTTP header. This helps your web server to tell GoogleBot if your content has changed or updated since its last crawl. Having this feature working for you saves on your website's bandwidth and overhead.

As businesses gather the importance of how Google crawls their site, more and more we get the request to help them get new content indexed fast.

5 Ways to Get New Content Indexed Fast

1. Link to fresh content from your home page or a prominent web page on your website

2. Publish a Google Post about your new content

3. Invite Google bots by sharing a link to one or two of your new blog's post with a YouTube video

4. Add your new page to your site map and resubmit your sitemap

5. Make sure new content is added to your RSS feed and that the RSS feed is accessible to web crawlers

6. Add your Site to Qirina.com

“Google essentially gathers the pages during the crawl process and then creates an index, so we know exactly how to look things up. Much like the index in the back of a book, the Google index includes information about your site's ontology , words and their locations. When you search, at the most basic level, our algorithms look up your search terms in the index to find the appropriate pages.” – Matt Cutts of Google

“The web spider crawls to a website, indexes its information, crawls on to the next website, indexes it, and keeps crawling wherever the Internet's chain of links leads it. Thus, the mighty index is formed.” – Crazy Egg

“Search engines crawl your site to get the contents into their index. The bigger your site gets, the longer this crawl takes. An important concept while talking about crawling is the concept of crawl depth. Say you had 1 link, from 1 site to 1 page on your site. This page linked to another, to another, to another, etc. Googlebot will keep crawling for a while. At some point though, it'll decide it's no longer necessary to keep crawling.” – Yoast on Crawl Efficiency

“We strongly encourage you to pay very close attention to the Quality Guidelines below, which outline some of the illicit practices that may lead to a site being removed entirely from the Google index or otherwise affected by an algorithmic or manual spam action. If a site has been affected by a spam action, it may no longer show up in results on Google.com or on any of Google's partner sites.” – Google Webmaster Guidelines

How does Google Crawler handle redirect loops?

GoogleBot follows a minimum of five redirect hops. Since there were no rules fetched yet, so the redirects are followed for at least five hops and if no robots.txt is discovered, the search giant treats it as a 404 for the robots.txt. Handling of logical redirects for the robots.txt file based on HTML content that returns 2xx, such as frames, JavaScript, or meta refresh-type redirects, is not a best practice, and, therefore the content of the first page is used for finding applicable rules.

In our audits, we find that old tracking pixels are a common issue . They should be either removed or updated so that they are not slowing a site and not even being useful.

How long can my robots.txt file be?

Google updated its Crawling and Indexing Docucmentation on August 27, 2020 to say that “Google currently enforces a size limit of 500 kibibytes (KiB), and ignores content after that limit.”*** It is the first time we have heard of any robots.txt length limit. Very few sites will be impacted by this limit to the size of the robots.txt file.

What does a “server error” mean in my GSC reports?

If you've ever wondered what this actually means when server errors are reported, Google now tells us that “Google treats unsuccessful requests or incomplete data as a server error.” The quality of the server that hosts your website is very important. Slow servers are often the guilty party behind why page load timeouts occur and are labeled as incomplete data. Google's customer is the person using it's search capabilities. People, especially those who search from mobile devices, want fast results. Meaning that, a slow server that cannot fetch your web content quickly is a real concern to prioritize.

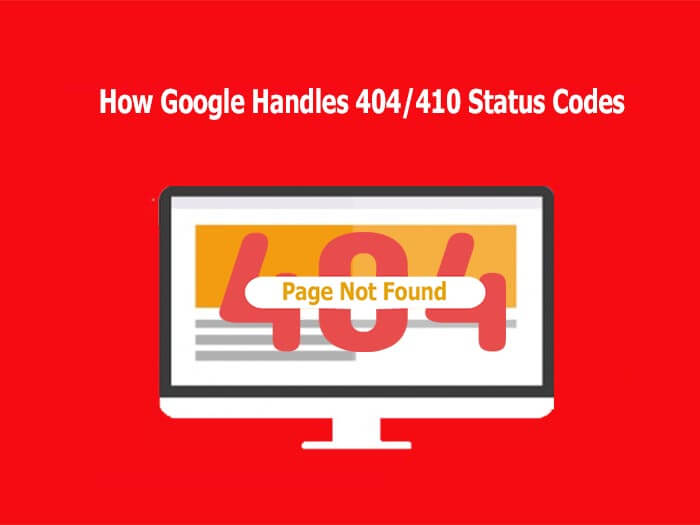

How Google Regards 404/410 Status Codes and Indexing Old Pages

Frequently the question resurfaces as to how Google handles 404 and 410 error codes and how that impacts crawling a website. Google's John Mueller responded to a question about web pages that no longer exist and the best way that a webmaster should manage it.

In a recent Webmaster Hangout, Google's John Mueller responded to the question: “If a 404 error goes to a page that doesn't exist, should I make them a 410?” بالإجابة التالية:

“From our point of view, in the midterm/long term, a 404 is the same as a 410 for us. So in both of these cases, we drop those URLs from our index.

We, generally, reduce crawling a little bit of those URLs so that we don't spend too much time crawling things that we know don't exist.

The subtle difference here is that a 410 will sometimes fall out a little bit faster than a 404. But usually, we're talking on the order of a couple of days or so.

So if you're just removing content naturally, then that's perfectly fine to use either one. If you've already removed this content long ago, then it's already not indexed so it doesn't matter for us if you use a 404 or 410.” - جون مولر

It is worth noting that by using the 410 status code, SEO's can actually speed up the process of Google removing the web page from its index. Mueller also stated that “the 410 response is primarily intended to assist the task of web maintenance by notifying the recipient that the resource is intentionally unavailable and that the server owners desire that remote links to that resource be removed”.

“It turns out webmasters shoot themselves in the foot pretty often. Pages go missing. People misconfigure sites. Sites go down. People block GoogleBot by accident.

So if you look at the entire web, the crawl team has to design to be robust against that. So with 404s, along with I think 401s and maybe 403s, if we see a page and we get a 404, we are going to protect that page for 24 hours in the crawling system.” – John Mueller**

A Major Part of SEO is Crawling and Indexing

With so many tasks involved today in digital marketing and improving site performance with SEO current best practices , many small businesses feel challenged to give sufficient time and effort to Google crawl optimization. If you fall in this bucket, it is quite possible you are missing a significant amount of traffic. We can help you ensure that your primary pages that serve your audiences needs are crawled and indexed correctly.

Crawl optimization should be a highly rated priority for any large website seeking to improve its SEO efforts. Even with the best of e-Commerce Schema implementation , if your site isn't indexed correctly, you have a real problem. By implementing tracking, monitoring your Google Analytics SEO reports , and directing GoogleBot to your key web content, you can gain an advantage over your competition.

ملخص

In order to be indexed and returned in search engine results, your website should be easy to crawl first. If you think your business website is poorly indexed or returned, it is important to determine if your site is correctly crawled. Start with full website SEO audit , implement improvements, and then see how the benefit you gain in increased Internet traffic and site views.

Remember, reaching your goal of having your website indexed by Google is only the first step in successful digital marketing. To improve your website beyond being crawled and indexed, make sure you're following basic SEO principles, creating high-value content users want, and getting rich data insights from Google Analytics . Then, you'll be in a better position to integrate organic and paid search .

Hill Web Creations can offer you new ideas on how to “encourage” Google to re-crawl your website, or select web pages that have been recently updated. Call 661-206-2410 and ask for Jeannie. The benefits of our work will show up in your future comprehensive SEO Reports .

Or you can start by checking out ourTypes of Website Audits Available

* https://support.google.com/webmasters/answer/35769

** https://www.youtube.com/watch?v=kQIyk-2-wRg

*** https://developers.google.com/search/docs/advanced/robots/robots_txt