Googleがあなたのウェブサイトとインデックスをクロールする方法

公開: 2016-02-18GoogleがウェブサイトのAMPページ、JavaScript、AJAXをクロールする方法

最終更新日:2021年3月6日

GoogleがAjaxコンテンツを「クロール」する方法の大きな「一歩」! Googleは、JavaScriptとAJAX内でコンテンツをクロールするのに世界一です。 しかし、彼らはまだそれを完成させています。 あなたはそれがあなたのサイトを這う戦場だと思いますか?

Googleは、WebコンテンツへのAJAX呼び出しの処理方法を変更しました。 グーグルのジョン・ミューラーは、彼らは「オンとオフ」であることができると言ったので、検索の専門家がグーグルにあなたのコンテンツのクロール意図を知らせるために従事することができる追加のSEO戦術があります。 今後は、以前のやり方に頼らないのが最善です。 アジャイルマーケティングプロセスを導入すると、変更をより迅速にナビゲートするのに役立ちます。

Google検索コンソールで発見された洞察を活用し、この記事の回答と説明からそれらを読んで解釈する方法をよりよく知ることができます。 Core Web Vitalsレポートは、PageSpeedの問題を明らかにしています。

Googleのクロールとインデックス作成とは何ですか?

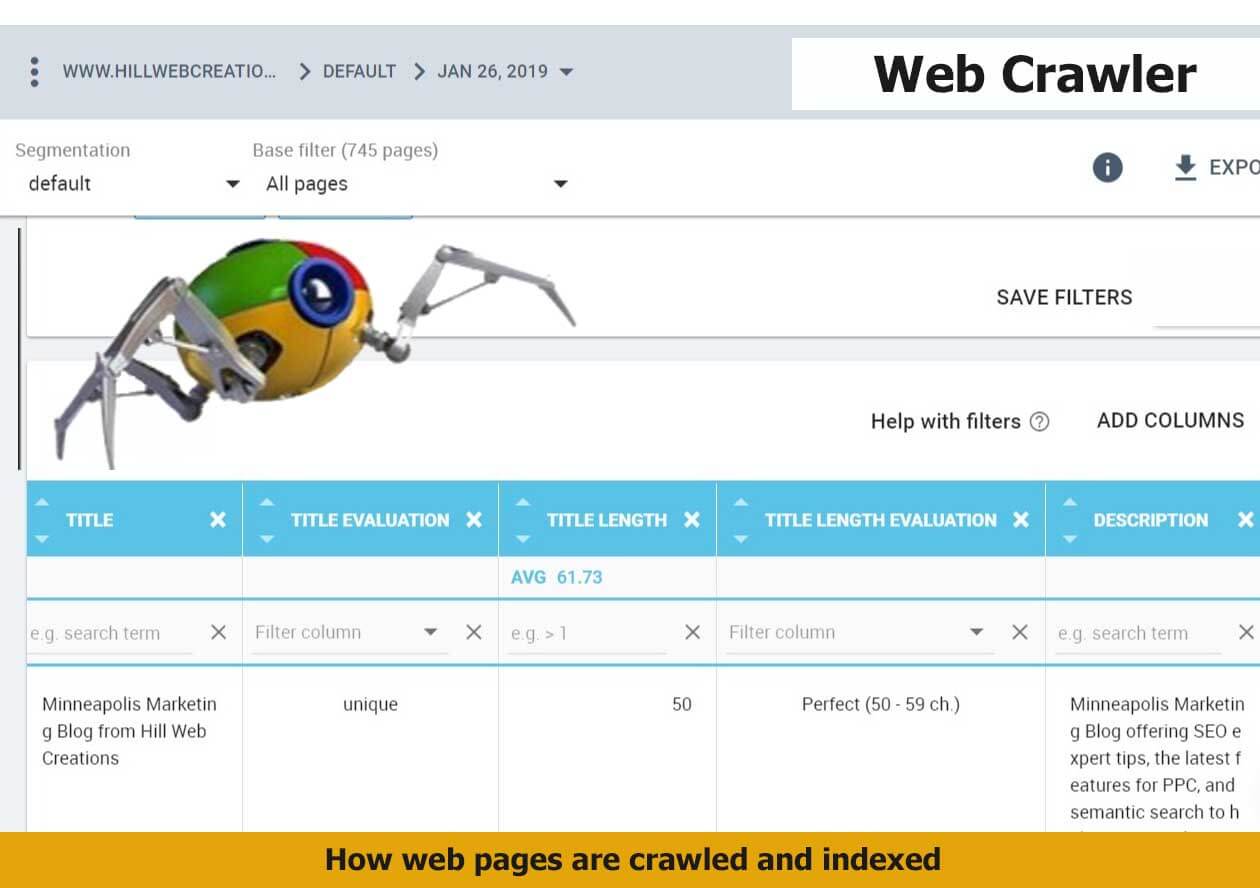

クロールとインデックス作成は、依然として別個のタスクです。 クロールとは、Googlebotがウェブページ上のすべてのコンテンツとコードを調べて分析することです。 インデックス作成とは、同じページがGoogleの検索結果に含まれ、表示される資格がある場合です。 Google Pandaの更新以降、ドメイン名の重要性が大幅に高まっています。 オンラインの世界からのビジネスの成長は、 Webページが正しくクロールおよびインデックス化されているかどうかにかかっています。

一部の企業は、優れたコンテンツの作成とサイトの最適化のすべての作業を行っていますが、主要なコンテンツのインデックスを作成できていません。 そのため、ビジネスプランニングセッションと戦略ではこれを事前に検討することをお勧めします。

GoogleBotとは何ですか?

Googlebotは、Googleが使用する検索ボットソフトウェアであり、ウェブからドキュメントを収集して、Google検索エンジンの検索可能なインデックスを作成します。

獲得検索または有料検索のためのGoogleCrawlerの方法を学習しようとしているかどうかにかかわらず、SEOはGoogleBotを正しく理解することで検索戦術を改善できます。

GoogleBotは、ウェブページをクロールしてインデックスを作成するGoogleの検索エンジンのアームです。 蜘蛛としても知られています。 GoogleBotは機械学習を使用して、アクセスを許可したすべてのページをクロールし、Googleのインデックスに追加して、ユーザーの検索クエリに一致するように取得して返すことができます。 ウェブサイトのどのページをクロールしたいのか、どのページをクロールしたくないのかをGoogleに明確に示すための努力も、戦闘のように見える可能性があります。

自分のサイトがGoogleのインデックスに含まれているかどうかはどうすればわかりますか?

Google検索コンソールのGoogleインデックス情報レポートは、プロパティのURLをテストします。 そのURL検査ツールは、URLの現在のインデックスステータスを明らかにします。 完全なURLを入力して検査し、インデックスステータスレポートを取得する必要があります。

Fetch as Google Toolを使用して、Googleがクロールしたときにサイトがどのように表示されるかを確認できます。 これにより、サイト所有者はより詳細なオプションを利用して、ページごとのステータスでコンテンツをインデックスに登録する方法を選択できます。 1つの例は、スニペットの有無にかかわらず、ページがどのように表示されるかを確認する機能です。キャッシュバージョンは、現在ライブページが表示されない場合に備えて、Googleのサーバーで収集される代替バージョンです。

サイトのURLのインデックスステータスを確認するもう1つの方法は、info:operatorを使用することです。 Google Chromeブラウザを使用して、ナビゲーションバーにinfo:URLを入力します。 これにより、Googleの表示がトリガーされます。「example-domain-url」のGoogleのキャッシュを表示します。 「example-domain-url」に類似したWebページを検索します。

GoogleインデックスはJavaScriptサイトでどのように機能しますか?

GoogleがJavaScriptサイトをクロールする必要がある場合、従来のHTMLコンテンツを必要としない追加のステージが必要です。 これはレンダリングステージと呼ばれ、追加の時間がかかります。 インデックス作成段階とレンダリング段階は別々のフェーズであるため、GoogleはJavaScript以外のコンテンツを最初にインデックスに登録できます。

JavaScriptは、Googleがクロールしてインデックスを作成するためのより時間のかかるプロセスです。 その理由は、最初にダウンロードして解析し、次に実行する必要があるためです。

JavaScriptの事前レンダリングはレンダリングされた出力内でどのように処理されますか?

GoogleBotは、レンダリングされた出力内で使用されるJavaScriptを事前にレンダリングできます。 テクノロジーの巨人は、ユーザーエクスペリエンスの観点からJSの事前レンダリングを検討しています。 これにより、事前にレンダリングされたページからJSを削除する必要がなくなるため、簡単になります。 サイトがマイナーなサイトコンテンツとレイアウトの更新を管理するためにJSに依存しているが、AJAXリクエストを管理していない場合は、そのようなクロール/インデックス作成のケースを処理するための高度なテクノロジーに関するGoogleのスポークスマンであるMartinSplittに注目してください。

Googleのクロールとインデックス作成プロセスはどのくらい重要ですか?

あなたのウェブサイトをグーグルによってクロールして正しく索引付けすることは、インターネットマーケティングの成功において極めて重要な問題です。 それが全体の出発点です。 成功するには、Webクロールとインデックス作成機能が必要です。 Webサイトのルートフォルダにサイトマップをアップロードしないと、クロールに長い時間がかかる可能性があります。新しいブログ投稿や詳細なWebサイトのインデックスを作成するには24時間以上かかる場合があります。

ほとんどのインターネットサーファーは、サイトのクロール性とインデックス作成を改善するために行ったさまざまな手順に気付くことはありません。

「Google検索インデックスには数千億のウェブページが含まれており、サイズは1億ギガバイトをはるかに超えています」とGoogleは述べています。

最高のクロール履歴のために古い資産を管理する方法は?

Googlebotは、現在404ステータスが付与されているさまざまな古いアセットをクロールします。 通常、古いアセットは、クロールが停止するまで維持する必要があります。 最終的に、GoogleはHTMLコンテンツを再クロールし、新しいサイトアセットを評価し、クローラーを更新します。 古い資産の管理に401または404を使用することはお勧めしません。 これにより、レンダリングが壊れてしまう可能性があります。 これは避けるべきものです。 これは、キャッシングにRails AssetPipelineを使用している場合に発生します。

Googleがウェブサイトをクロールするために理解する必要がある2つの重要な概念は次のとおりです。

1.サイトをクロールしてインデックスを作成する場合は、検索エンジンスパイダーがサイトを正しく表示できる必要があります。

2.ウェブサイトがGoogleのスパイダーによって正しくクロールされるようにするためにできることはたくさんあります。

Webクローラーは、スパイダー、スパイダーボット、またはWebスパイダーと呼ばれることもあり、クローラーと短縮されることもあります。これは、通常はWebインデックス作成を目的として、ワールドワイドウェブを体系的に閲覧するインターネットボットです。 重要なスキーママークアップタイプをすべて追加すると、Googleがコンテンツをよりよく理解し、Googleのライブラリでインデックスに登録できるようになります。

シンジケートコンテンツとGoogleがAJAXをクロールする方法に関する新しい洞察

Googleはajax呼び出しのインデックスを作成できるようになりました。これは、Google検索結果での意味を理解することが重要です。

先週の金曜日の英語のGoogleウェブマスターセントラルの営業時間のたまり場でジョンミューラーがシンジケートコンテンツとajaxコールの処理方法を尋ねられたとき、彼の回答は次のとおりでした。 できることはJSを使用することです。」 何が変わったのか、そして何が期待できるのか、それは魅力的だと思います。 動的タイトルを省略したまま、インデックス作成用のページをレンダリングすることを指定できます。 ページの一部を除外する場合は、robots.txtファイルを使用して除外し、その希望を示すことができます。 Accelerated MobilePageのコンテンツをデスクトップバージョンにできるだけ近づけてください。

たとえば、説明、レビュー、ボタン、および回答(Q&A)を含む製品詳細ページ。 シンジケートされた呼び出しのその部分は非表示にすることができます。 彼は、これを集約しているサイト内の別のディレクトリ内にそのコンテンツを移動することを提案します。これにより、robot.txtファイルによって集約されたコンテンツがブロックされる可能性があります。 これにより、サイトに実際には存在しないコンテンツを自動生成しているように見えるのを防ぐことができます。

「私たちがやろうとしているのは、ブラウザで表示されるようにページをレンダリングすることです。 最終結果を見て、それらの結果を検索に使用してください」とミューラーは付け加えました。 ページの一部だけを考慮に入れたくない場合は、Webマスターがテキストのロボット化を行うことができます。 興味深いことに、Muellerでさえ、特定のページ内で解析したくないAJAXコンテンツを指定するのは難しいかもしれないが、ページの残りの部分はAJAXコンテンツのために解析されるとほのめかしました。

Googleは、JavaScriptのすべてを常にクロールするわけではありません。 「それはまだオンとオフですが、ますます多くの方向に向かっています」とミューラーは言いました。 Googleの開発者がGoogleがAJAXをクロールする方法のテストを監視しており、JavaScriptが注入されているタイトルをより一貫して適切にインデックス付けしたいと考えていることは明らかです。 「インデックスに登録されていないユーザーにコンテンツを忍び込ませる」ことではありません。

クロールする特定のコンテンツがある場合、またはクロールしたくない場合は、Webサイトのrobots.txtファイルを手動でメンテナンスすることをお勧めします。

Googleがウェブサイトをクロールする方法の概要

1.最初に知っておくべきことは、Webサイトが常にクロールされているということです。 グーグルはそれを示しました; 「Googlebotは、平均して数秒に1回以上サイトにアクセスするべきではありません。」 つまり、クローラーが使用できるようにサイトが正しく設定されていれば、サイトは常にクロールされます。 Googleの「クロール速度」とは、Googlebotのリクエストの速度を意味します。 それはあなたのウェブサイトがクロールされる頻度についてではありません。 通常、企業は、より多くの可視性、権限を持つ関連するバックリンク、ソーシャルシェア、メンションなどから部分的にもたらされ、サイトが検索結果に表示される可能性が高くなります。 Googlebotが実行するクロールの数を想像してみてください。そのため、サイトのすべてのページを常にクロールすることが常に実行可能または必要であるとは限りません。

2. Googleのルーチンは、最初にサイトのrobots.txtファイルにアクセスすることです。 そこから、Googleがサイト上でクロールしてインデックスを作成することを許可されているコンテンツに関してサイト所有者が指定した内容を学習します。 「不許可」と表示されているWebページはインデックスに登録されません。

一般的なSEO作業に当てはまるように、robots.txtファイルを最新の状態に保つことが重要です。 これは1回限りの取引ではありません。 robots.txtファイルを使用してクロールする方法を知ることは熟練した作業です。 技術的なウェブサイトの監査では、robots.txtの適用範囲と構文をカバーし、既存の問題を修正する方法を通知する必要があります。

3.次にGoogleがsitemap.xmlを読み取ります。 検索エンジンは、クロールしてインデックスを作成するサイトのすべての領域を検出するためにサイトマップを必要としませんが、それでも実用的です。 さまざまなWebサイトがどのように構築および最適化されているかにより、Webクローラーはすべてのページまたはセグメントをロボットでクロールするわけではありません。 一部のコンテンツは、専門的で適切に構築されたサイトマップからより多くの利益を得ます。 動的コンテンツ、ランクの低いページ、拡張コンテンツアーカイブ、内部リンクがほとんどないPDFファイルなど。 サイトマップは、GoogleBotがニュース記事、動画、画像、PDF、モバイルなどのカテゴリ内のメタデータをすばやく理解するのにも役立ちます。

4.検索エンジンは、信頼係数が確立されているサイトをより頻繁にクロールします。 あなたのウェブページがかなりのPageRankを獲得した場合、Googlebotがいわゆる「クロール予算」をサイトに与えることがあります。 あなたのビジネスサイトが獲得した信頼とニッチな権威が大きければ大きいほど、あなたはより多くのクロール予算から利益を得ることが期待できます。

サイトリンク構造がクロール速度とドメインの信頼に影響を与える理由

Googleクローラーがどのように機能するか、一部の検索フィルターを解除または適用したかどうかを反映する可能性のある新しい更新、新しいパッチへの対応が容易、またはドメインリンク構造の変更を理解したら。 SERPランキングの変更と競合他社でサイトのパフォーマンスをベンチマークして、特定の時間にトラフィックのコンバージョンが急増するかどうかを確認します。 これは、孤立した発生を除外するのに役立ちます。

倫理的に行動し、ドメインの信頼を獲得します。 ウェブサーバーの秘密を維持しようとするのではなく、最初からGoogleの検索のベストプラクティスに従ってください。 「誰かがあなたの「シークレット」サーバーから別のウェブサーバーへのリンクをたどるとすぐに、あなたの「シークレット」URLがリファラータグに表示され、他のウェブサーバーがそのリファラーログに保存して公開できるようになります。 同様に、ウェブには多くの古くて壊れたリンクがあります」と検索の巨人は述べています。 個人がウェブサイトへのリンクを誤って公開したり、サーバーの変更を反映するようにリンクを更新しなかったりすると、GoogleBotはサイトから誤ったリンクをダウンロードしようとします。

コンテンツのマークアップがGoogleクローラーにどのように役立つか

SEOの専門家がウェブコンテンツをマークアップするためにGoogleの構造化データを正しく実装すると、Googleは検索に表示するためのコンテキストをよりよく理解できます。 これは、Google検索のインターネットユーザーへのWebページの優れた配布を実現できることを意味します。 これは、コンテンツプロパティをマークアップし、必要に応じてスキーマアクションを有効にすることで実現されます。 これにより、Google Nowカード、アンサーボックスの大型ディスプレイ、注目のリッチスニペットに含めることができます。

GoogleBotのWebコンテンツプロパティをマークアップする手順

1.schema.orgが提供するテーブルから最適なデータ型を特定します。

コンテンツに最適なものを見つけてから、そのタイプのマークアップリファレンスガイドから選択して、必須および推奨のプロパティを見つけます。 次のGoogleクロールを支援するために、複数のコンテンツタイプのマークアップを単一のHTMLまたはAMPHTMLコンテンツページに追加することは許可されています。 ユーザーは動画コンテンツを含むニュース記事を好むことがわかりました。これにより、マークアップを追加して、ニュースカルーセル内のトップストーリーや動画の豊富な結果にコンテンツページを含める資格を得る絶好の機会が生まれます。

2.主要な製品とサービスを含むマークアップのセクションを作成します。

取得したいSERPで視覚的に表示するために必要な構造化データのプロパティを使用して、サイトをできるだけ簡単にクロールできるようにします。 SEOには、カスタマイズ可能なマークアップの多くの例を含む、そこから引き出すための広範なデータ型参照があります。 記事内のセクションを識別するspeakableschema.orgプロパティを使用することで、クロールとインデックス作成を改善できます。 それはあなたの情報ページ内の答えを引き出すことができます。

「サーバー側でレンダリングされたページをGoogleに配信し、そのページにJavaScriptがあり、すべてのコンテンツを削除したり、中断する可能性のある方法ですべてのコンテンツを再読み込みしたりすると、インデックス作成が中断する可能性があります。 したがって、サーバー側でレンダリングされたページを配信し、そこにJavaScriptが残っている場合は、JavaScriptが壊れてもコンテンツが削除されないように構築されていることを確認しますが、これは1つのことです。むしろ、まだコンテンツを置き換えることができていないだけです。」 –GoogleのJohnMueller」

Googleクロール予算とは何ですか?

「それについて考える最良の方法は、クロールするページ数がPageRankにほぼ比例することです。 したがって、ルートページに多数の受信リンクがある場合は、間違いなくそれをクロールします。 次に、ルートページが他のページにリンクする可能性があり、それらはPageRankを取得し、それらもクロールします。 ただし、サイトがどんどん深くなるにつれて、PageRankは低下する傾向があります」とStoneTempleのEricEnge氏は述べています。

将来のコンサルタントとクロールの最適化について話し合う前に、彼らが本質を完全に理解していることを確認してください。 クロール予算は、一部の人にはなじみのない用語です。 Googleがサイトをクロールするために割り当てる時間またはページ数を決定する必要があります。 Webサイトのパフォーマンスを妨げる重要な問題を解決すると、クロールが改善される可能性があります。

GoogleのMattCuttsは、クロールされたページ数に関して何を念頭に置いておくべきかをSEOに提供します。 2010年に、彼は次のように述べています。 多くの人は、ドメインは特定の数のページのみがインデックスに登録されると考えていましたが、それは実際には機能しません。 また、クロールに厳しい制限はありません。」

PageRankとドメインの信頼に比例してクロールされたページ数に焦点を当てて表示すると便利です。 「したがって、ルートページに多くの受信リンクがある場合は、間違いなくそれをクロールします」と彼は付け加えました。 ジョンミューラーがサイトの被リンクプロファイルについて何と言っているかについてもっと学びましょう。

インデックスカバレッジのサイトマップデータ

Googleがウェブサイトをクロールする方法についての長引く質問に答えます。

新しいGoogle検索コンソールが完成すると、クロールとインデックス作成をよりよく理解するために、どのレポートを引き続き利用できるかについて多くの人が質問します。

「新しい検索コンソールを進めるにつれ、古いサイトマップレポートをオフにします。 新しいサイトマップレポートには、古いレポートのほとんどの機能が含まれており、残りの情報(特に画像と動画)を新しいレポートに反映することを目指しています。 さらに、サイトマップファイルで送信されたURLを追跡するために、インデックスカバレッジレポート内で、サイトマップファイルを使用して選択およびフィルタリングできます。 これにより、気になるURLに集中しやすくなります。」 – 2019年1月25日のジョンミューラー

グーグルビジュアル検索の台頭をギビアン、今日あなたの画像とビデオファイルを適切に索引付けすることがより重要です。 強力な視覚的資産は販売につながる可能性があります。 商品ページと画像の適切なインデックス作成により、 Googleの商品カルーセルが強化されます。

2016年9月7日、John Muellerは、Googleがページをレンダリングする必要があるかどうかについて話しました。その後、リダイレクトが表示され、遅延が発生します。 「ページがクロールされるまでのスケジュールはありますか?」と尋ねられたとき。 彼は「それは科学的です」と答えました。

価格などの情報を含む構造化データを含むコンテンツ、または在庫切れの可能性があるアイテムがあるかどうかを尋ねられた場合、正確なデータのクロール速度が向上しますか? 回答は「複雑な技術分野です」でした。 John Mueller氏は、次のように述べています。「構造化データは、さまざまな方法で提供できるものだと思います。 サイトマップを使用してお知らせください。 価格情報があるからといって、データがすぐに更新されるわけではありません。」

パンダアルゴリズムは継続的ですが、クロールでは実行されません

サイトのクロールは、GooglebotがGoogleインデックスに追加する新しいページと更新されたページを検出し、アルゴリズムプロセスを使用して行うプロセスであることがわかっています。コンピュータプログラムがクロールするサイト、クロールされる頻度、品質を決定するためです。それがウェブサイトの大部分を再処理するときにそれが与える評価、小さなウェブサイトは一般的に数ヶ月で取り戻すことができます。 Googleビジネスリスティングに投稿を公開すると、それらのURLをGoogleのインデックスに直接取得できます。

Pandaアルゴリズムは継続的に実行され、事前に決定されたタイムテーブルでは実行されませんが、クロールに関連するセマンティックシグナルを収集するのに、一部のサイトでは数か月のように少し時間がかかります。 GoogleのJohnMuellerによると、クロールの頻度はサイトごとに異なります。

Q.「サイトのデスクトップバージョンとモバイルバージョンとしてAMPバージョンの両方がある場合、ダイナミックサービングを使用するための最良の方法は何ですか?」と尋ねられたとき。

A.「ダイナミックサービングを使用している場合、AMPページは通常のGoogleBotでクロールすると思います。AMPページは表示されません。 エージェントで使用するパラメータによっては、突然AMPページとHTMLページが表示されます。」 動的に配信されるAMPページは、TwitterなどのGoogle以外のクライアントが、ページのAMPバージョンを引き出したい場合にも複雑になります。 John Mullerは、ウェブサイトの技術的な問題を回避するようウェブマスターに促しました。

Q.ネガティブSEOのターゲットにされた後、GoogleBotがどのようにページを否認するかについて尋ねられたとき? 否認ファイルは、そのような被リンクとの関連付けを解除するために使用できます。 「否認ファイルを更新するには、バックリンクページをクロールすることが重要ですか?」

A.「他のページを再クロールまたは再処理した後、リンクを削除します。 あまりリクロールしなければ、とにかく大きな重みはありません。 そのページをもう一度クロールするのに6か月かかる場合。」 分類子は、サイトを再スパイダリングする準備ができているかどうかを判断し、モバイルインデックス作成の一般的なガイダンスを形成するために評価を試みます。 Search Giantは、モバイルクロールに実際に関連するものを見つけようとしています。

詳細については、完全なGoogleウェブマスターセントラルハングアウトをご覧ください。 Googleは、Webサイト内のより重要なURLに焦点を合わせようとします。 必要に応じて、スパムレポートを送信すると、サイトが正常にクロールされるのを妨げることを目的とした、他の誰かによる否定的なSEOを認識しようとします。 ほとんどの場合、あなたのサイトを改善し、ポジティブな検索履歴を確立し、そしてそれをさらに強くそしてより良くするためにあなたができることに焦点を合わせてください。

「常に同じ頻度でURLをクロールするわけではありません。 したがって、いくつかのURLは毎日クロールします。 一部のURLは毎週の場合があります。 他のURLは、2、3か月ごと、場合によっては半年に1回程度です。

そして、あなたが全面的にあなたのウェブサイトに重要な変更を加えたなら、おそらくそれらの変更の多くはかなり迅速に拾い上げられますが、いくつかの残りのものがあるでしょう。

これが最終変更日のサイトマップファイルです。これにより、Googleは停止し、他の方法よりも少し早くこれらを再確認しようとします。」 –ジョンミューラー

Googleクローラーがまだ直面する可能性のある既存の問題

1.複雑なURL構造を持つサイト。これは、ほとんどの場合、URLパラメータの問題が原因です。 セッションIDなどをパスに混在させると、多数のURLがクロールされる可能性があります。 実際には、Googleは実際にはそこで立ち往生していません。 しかし、それはあなたのサイトがより賢く使う必要がある多くの資源を浪費する可能性があります。

2. GoogleBotは、同じパスセクションが何度も繰り返されていることを検出すると、クロールの速度を低下させる可能性があります。

3.コンテンツをレンダリングするために、Google Crawlerがページコンテンツをすぐに引き出すことができない場合、ページをレンダリングして何が表示されるかを確認します。 ページ上に何かをクリックするか、コンテンツを表示するために何かをしなければならない要素がある場合、それも見逃す可能性があります。 GoogleBotは、何が表示されるかを確認するためにクリックすることはありません。 ジョン・ミューラーは、次のように述べています。 スクロールし続けるようなものではありません。」

会話から私が理解したことは、ユーザーがアクションを実行するまでロードされないものと、下にスクロールしないとGoogleBotが表示できないものを区別するのに役立ちます。

ページに表示される内容を管理するためにJavaScriptの構成に多大な時間を費やすのではなく、エンドユーザーに最も適切で完全なコンテンツを提供するものを探してください。 Webサイトのページ付け、JavaScript、およびユーザーがより良いエクスペリエンスを得るのに役立つテクニックを微調整することを検討してください。 「3回目で最後に、AMPを見て、イベントの終わりにAndreyLipattsevを繰り返しました。

すべてのサイトがGoogleモバイル検索の台頭に十分に備えることを強くお勧めします。 また、GoogleBotは埋め込みコンテンツを取得しようとしてタイムアウトする場合があります。 ユーザーにとって、これはアクセシビリティを難しくする可能性があります。

クロールする最も重要な情報は次のとおりです。

- Web URL —ページ、投稿、および主要なドキュメントのWebURLアドレス。

- ページタイトルタグ—ページタイトルタグは、Webページ、ブログ投稿、またはニュース記事の名前を示します。

- メタデータ—これには、ページの説明、構造化データのマークアップ、一般的なキーワードなど、さまざまなものが含まれます。

これは、GoogleBotがサイトをクロールするときに取得する主な情報です。 そして、これはおそらくあなたが索引付けされているものです。 それが基本的な考え方です。 進行中のサイトの場合、サイトをクロールする方法や、検索結果が返され、整理され、リッチスニペットに表示される方法がはるかに複雑になります。 Googleはそのプラットフォームに投稿されたレビューに気付くことに注意してください; 何らかの理由でサイトのインデックスが作成されない場合は、ローカルパックなどにGoogleのレビューが表示されることがあります。

Googleが新しいドメイン拡張機能をクロールする方法

Googleは、2015年7月7日に、.news、.social、.ninja、.doctor、.insurance、.shopping、.videoなどの新しいドメインのランキングをどのように処理するかを発表しました。 要約すると、それらは.comおよび.netとまったく同じようにランク付けされます。 このクリエイティブなデジタル環境で、クロール中にGoogleがサイトをどのように体験するかをライブで実演することで、プレミアムSEOがインターネットでの毎日の検索に本物の明白で具体的なコンテンツをどのように提供するかがわかります。 ここに新しいドメイン拡張機能があり、それらを使用する場合は、サイトが自動的にクロールされ、コンテンツが非常に自然に配信されることを確認してください。

Googleは、Google Crawlerが検索結果でこれらの今後のドメインをどのように処理するかを垣間見ることができ、最新のドメイン拡張オプションをどのように処理するかについて考えられる誤解を回避することを望んでいます。 a.BRAND TLDが.comよりも多かれ少なかれ重みを増す可能性があるかどうかを尋ねられたとき、Googleは次のように答えました。 これらのTLDは、他のgTLDと同じように扱われます。 同じジオターゲティング設定と構成が必要になり、URLのクロール、インデックス作成、ランク付けの方法に重みや影響を与えることはありません。」

新しいgTLDが検索にどのように影響するか疑問に思っているウェブマスターの場合、Googleが新しいgTLDを他のgTLD(example.com、.net、.orgなど)と同じようにクロール処理することを学びました。 投稿の解釈から、TLDでのキーワードの使用は、SERPランキングで特定の長所または短所を付与することにより、サイトに影響を与えません。

GoogleBotはどのくらいの頻度でウェブサイトをクロールしますか?

新しいサイトや更新頻度の低いサイトは、クロールの頻度が低くなります。 適切な作業が行われていれば、平均してGooglebotは4日以内に新しいウェブサイトを見つけてクロールする可能性があります。 また、4週間かかる場合があることもわかりました。 ただし、これは実際には「状況によって異なります」という答えです。 他の人が同じ日にインデックスを作成すると主張しているのを聞いたことがあります。 Googleによると、クロールとインデックス作成は時間がかかる可能性があり、多くの要因に依存するプロセスです。

AJAX Webアプリケーションをクロール可能にする方法は?

ウェブマスターが検索結果に表示することを目的としたコンテンツでAJAXアプリケーションを使用することを選択した場合、Googleは、実装すると、Google(および場合によっては追加の主要な検索エンジン)がコンテンツをクロールしてインデックスに登録するのに役立つ新しいプロセスを発表しました。 これまで、AJAX Webアプリケーションは、AJAXコンテンツが伴う可能性のある動的なプロセスのために、検索エンジンが処理するための課題を提起していました。

ほとんどのWebサイト所有者は、Webページのクロール、インデックス作成、または提供の制限を設定するよりも、手元にあるより重要なタスクを持っています。 どのページが検索結果に表示されるのに適格であるか、またはページのどのセクションに表示されるのかを指定するには、SEOに深く関わっている人が必要です。 ほとんどの場合、Webコンテンツが適切に最適化されている場合は、余分な対策を講じることなく、ページのインデックスを作成する必要があります。 大型のショッピングカートでよく必要となるよりきめ細かいアプローチについては、サイト所有者がGoogleにサイトのクロールとインデックス作成を許可する方法に関する設定を示すための多くのオプションを利用できます。 この専門知識のほとんどは、Google検索コンソールと「robots.txt」というファイルを介して実行されます。

John Muellerは、AJAXのクロールに関してWebマスターからのコメントを募集しました。 これがさらに発展するにつれ、Googleは、GoogleBotがJavaScriptとAjaxをどれだけうまく、またはどのように解析するかについて、より前向きになります。 あまりにも多くの意見を実装する前に、このトピックに関するコミュニケーションの開発の足がかりに注目し続けることが最善です。 当面は、重要なサイト要素やWebコンテンツの多くをAjax / JavaScriptに委託しないことをお勧めします。

Googleがサイトをクロールするのを支援するより高度な手段

以前はGoogleウェブマスターツールと呼ばれていたGoogle検索コンソール内で、URLパラメータを設定できます。 単純なWebサイトの場合、これは通常必要ありません。 グーグルでさえ、ユーザーに、このSEO戦術を使用する前に専門知識を身につけておくべきだと警告しています。 サイトが重複コンテンツの問題に直面しているかどうかは、1つの判断かもしれません。

クロールの問題は動的URLによって引き起こされる可能性があります。これは、URLパラメータインデックスにいくつかの課題があることを意味する可能性があります。 [URLパラメータ]セクションを使用すると、ウェブマスターは、GoogleがURLパラメータを使用してサイトをクロールしてインデックスを作成する方法を選択できます。 デフォルトでは、ウェブページはGoogleBotが決定した方法に応じてクロールされます。 人々が必要とする重要な答えがあるページは再確認する必要があります。 多くの人が「PeopleAlsoAsk」セクションで答えを見つけます。

あなたがより頻繁なグーグルクロールに勝つために新鮮なコンテンツを持っているならば、それは役に立ちます。 したがって、ブログに投稿する人が多いほど、クロールされることが予想される頻度が高くなります。 以前は、Google検索コンソールには最大90日間のクロール履歴データしか保存されていませんでした。 より多くの履歴データが利用できるようになったため、その期間を要求するSEOは、サイトに関連するGoogleのクロール習慣を発見するためのデータを増やして喜んでいます。

モバイルWebパフォーマンスとより高速なGoogleクロールの準備

あなたのモバイルサイトがどれだけうまくクロールされているか知っていますか? GoogleのAcceleratedMobile Pages(AMP)は、ウェブサイトの所有者がモバイルファーストの世界での検索ランキングとクロール性のパフォーマンスを向上させるのに役立つ可能性があります。 Google AMPに切り替えて、それがサイトのクロール可能性にどのように影響するかを学ぶには、通常、実権を握っている経験者が必要です。 サイトの可視性とポジショニングを見ている人にとって、速度の負荷が重要であることを私たちは知っています。 ウェブページの特徴が他のすべての特徴と似ているが速度が高い場合は、GoogleBotがクロールしやすい高速サイトに重点を置き、ユーザーがSERPでトップにランク付けすることを強いられると期待します。

AMP Webページへの更新についてサポートが必要な場合は、モバイルサイトがどのようにクロールされるかを追加してテストします。ここを読んで、解決策を入手してください。 サイトはさまざまなモバイルデバイスで異なる方法でロードされる可能性があり、ロードパフォーマンスに影響を与えます。 遅い接続でGoogleのキャッシュサーバーの読み込みが速くなるかどうかをテストします

Webクロールに悪影響を与えるサーバー接続の問題をすばやく修正する

多くの場合、ビジネスオーナーは、ホスティングページとサーバーの品質に気づいていません。 それは1つの非常に重要なポイントをもたらします。 ウェブサイトに接続エラーがある場合、サイトがダウンしているかサーバーがダウンしているため、Googleがサイトにアクセスしようとしたときにアクセスできない可能性があります。 特に、サーバーの問題に読み込めないランディングページにリンクするGoogle広告キャンペーンを実行している場合、結果は非常に破壊的なものになる可能性があります。 Google AdWordsコンソールに警告が表示され、その数が多すぎると、広告がキャンセルされる可能性があります。

しかし、それを超えて検討することがたくさんあります。 これが無視され続けると、Googleはあなたのサイトにアクセスしなくなる可能性があり、サイトの健康に悪影響を及ぼし、ページのランキングが急落し、その結果、トラフィックが大幅に減少する可能性があります。 これは純粋な論理です。Googleが長期間サイトにアクセスできない場合は、私たちと同じように、実行可能なタスクに進む必要があります。 アラートを設定する–サーバーの接続とクロールエラーに注意してください。

Webサイトのインデックス作成にスキーマはどのように使用されますか?

Gary Illyesは、2017 Pubconで、スキーマが、豊富な検索機能に表示されるのを助けるだけでなく、Webページのインデックス作成とランク付けに役割を果たすことを確認しました。 JenniferSleggは彼女のSEMPostについて報告し、最初にさらに多くのサイトがそれを使用する必要があり、次に「スキーマにスパムが発生しないように注意したいので、ページまたはサイトに適合するスキーマタイプのみを使用してください。 そうしないと、サイトはスパムのような構造化データの手動アクションを取得するリスクを冒します。」

EコマースのJSON-LD構造化データは、ショッピングカートがある場合に実装することが特に重要です。 The content on your website gets indexed and returned in search results. Schema markup helps your website rank better for every form of content. The content on your website gets indexed and returned in search results better when schema markup helps your individual pages be understood better for the topic they directly address. Keep a closer eye on the top 100 results in each category.

How does GoogleBot Check Web Page Resources?

Most of your web pages use CSS and/or JavaScript to load. How your site is built and how many of these resources are used impacts your load times. Typically both CSS and JavaScript are loaded as external files that are linked to from your HTML. Google must have the access they want to these resources in order to fully understand your web pages. Often someone unfamiliar with technical SEO issues and how Google crawls your website will block these files within your robots.txt file. Read reports in your Search Console to better understand Google Crawler .

You can check to determine if your website is adhering correctly to this guideline.

Take advantage of the Google guidelines tool while employing your SEO techniques to know what files (if any) are set up as “blocked” from Googlebot. It only stands to reason that if web crawlers cannot understand your site's contents, they cannot rank you. Google needs the right to crawl your web pages in order to understand them fully and match your content to relevant search queries. Put your page through the SEO tool to obtain a better idea of how Google sees your site. Or request us to perform this vital task for you. Then we can go over the results together so that you address any issues correctly.

Requesting crawl rate adjustments:

Submit your website to Google and wait at least 24 hours before seeking to determine if your crawl rate changed. Google support states that “The term crawl rate means how many requests per second Googlebot makes to your site when it is crawling it: for example, 5 requests per second. You cannot change how often Google crawls your site, but if you want Google to crawl new or updated content on your site, you should use Fetch as Google”.

If you use the Google Webmaster tools and go to site settings, you can request a limit to your crawl rate, the new rate lasts for ninety days.

Google Crawls Sites that Follow their Webmaster Guidelines

The answers you need to know that your site correctly follows the Google webmaster guidelines*** for being crawled.

* Page headers are present when accessed by Googlebot; have correct site data architecture .

* Well-formed static links are discovered.

* The number of on page links is not excessive.

* Page avoids ordinary accessibility issues.

* Robots.txt file found and is correctly formed.

* All images have alt text to help GoogleBot render pages faster.

* All CSS and JavaScript files testy as visible to Googlebot

* Sitemaps for both search engines and users are available.

* No page speed issues.

NOTE: Additionally, you'll want to know that your web server correctly supports the If-Modified-Since HTTP header. This helps your web server to tell GoogleBot if your content has changed or updated since its last crawl. Having this feature working for you saves on your website's bandwidth and overhead.

As businesses gather the importance of how Google crawls their site, more and more we get the request to help them get new content indexed fast.

5 Ways to Get New Content Indexed Fast

1. Link to fresh content from your home page or a prominent web page on your website

2. Publish a Google Post about your new content

3. Invite Google bots by sharing a link to one or two of your new blog's post with a YouTube video

4. Add your new page to your site map and resubmit your sitemap

5. Make sure new content is added to your RSS feed and that the RSS feed is accessible to web crawlers

6. Add your Site to Qirina.com

“Google essentially gathers the pages during the crawl process and then creates an index, so we know exactly how to look things up. Much like the index in the back of a book, the Google index includes information about your site's ontology , words and their locations. When you search, at the most basic level, our algorithms look up your search terms in the index to find the appropriate pages.” – Matt Cutts of Google

“The web spider crawls to a website, indexes its information, crawls on to the next website, indexes it, and keeps crawling wherever the Internet's chain of links leads it. Thus, the mighty index is formed.” – Crazy Egg

“Search engines crawl your site to get the contents into their index. The bigger your site gets, the longer this crawl takes. An important concept while talking about crawling is the concept of crawl depth. Say you had 1 link, from 1 site to 1 page on your site. This page linked to another, to another, to another, etc. Googlebot will keep crawling for a while. At some point though, it'll decide it's no longer necessary to keep crawling.” – Yoast on Crawl Efficiency

“We strongly encourage you to pay very close attention to the Quality Guidelines below, which outline some of the illicit practices that may lead to a site being removed entirely from the Google index or otherwise affected by an algorithmic or manual spam action. If a site has been affected by a spam action, it may no longer show up in results on Google.com or on any of Google's partner sites.” – Google Webmaster Guidelines

How does Google Crawler handle redirect loops?

GoogleBot follows a minimum of five redirect hops. Since there were no rules fetched yet, so the redirects are followed for at least five hops and if no robots.txt is discovered, the search giant treats it as a 404 for the robots.txt. Handling of logical redirects for the robots.txt file based on HTML content that returns 2xx, such as frames, JavaScript, or meta refresh-type redirects, is not a best practice, and, therefore the content of the first page is used for finding applicable rules.

In our audits, we find that old tracking pixels are a common issue . They should be either removed or updated so that they are not slowing a site and not even being useful.

How long can my robots.txt file be?

Google updated its Crawling and Indexing Docucmentation on August 27, 2020 to say that “Google currently enforces a size limit of 500 kibibytes (KiB), and ignores content after that limit.”*** It is the first time we have heard of any robots.txt length limit. Very few sites will be impacted by this limit to the size of the robots.txt file.

What does a “server error” mean in my GSC reports?

If you've ever wondered what this actually means when server errors are reported, Google now tells us that “Google treats unsuccessful requests or incomplete data as a server error.” The quality of the server that hosts your website is very important. Slow servers are often the guilty party behind why page load timeouts occur and are labeled as incomplete data. Google's customer is the person using it's search capabilities. People, especially those who search from mobile devices, want fast results. Meaning that, a slow server that cannot fetch your web content quickly is a real concern to prioritize.

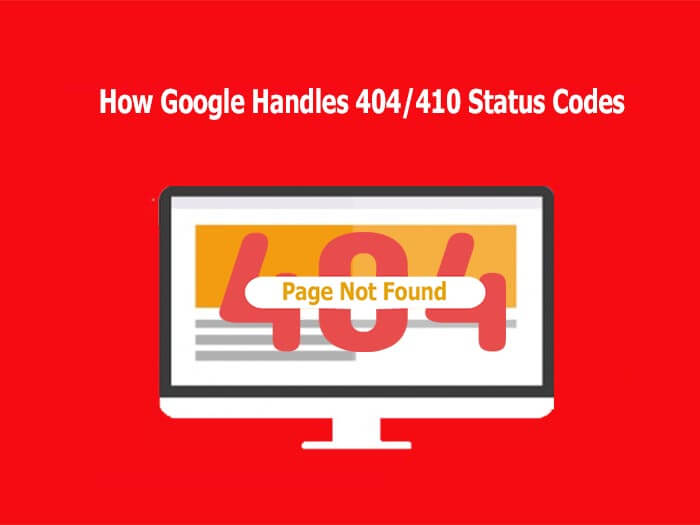

How Google Regards 404/410 Status Codes and Indexing Old Pages

Frequently the question resurfaces as to how Google handles 404 and 410 error codes and how that impacts crawling a website. Google's John Mueller responded to a question about web pages that no longer exist and the best way that a webmaster should manage it.

In a recent Webmaster Hangout, Google's John Mueller responded to the question: “If a 404 error goes to a page that doesn't exist, should I make them a 410?” with the following answer:

“From our point of view, in the midterm/long term, a 404 is the same as a 410 for us. So in both of these cases, we drop those URLs from our index.

We, generally, reduce crawling a little bit of those URLs so that we don't spend too much time crawling things that we know don't exist.

The subtle difference here is that a 410 will sometimes fall out a little bit faster than a 404. But usually, we're talking on the order of a couple of days or so.

So if you're just removing content naturally, then that's perfectly fine to use either one. If you've already removed this content long ago, then it's already not indexed so it doesn't matter for us if you use a 404 or 410.” –ジョンミューラー

It is worth noting that by using the 410 status code, SEO's can actually speed up the process of Google removing the web page from its index. Mueller also stated that “the 410 response is primarily intended to assist the task of web maintenance by notifying the recipient that the resource is intentionally unavailable and that the server owners desire that remote links to that resource be removed”.

“It turns out webmasters shoot themselves in the foot pretty often. Pages go missing. People misconfigure sites. Sites go down. People block GoogleBot by accident.

So if you look at the entire web, the crawl team has to design to be robust against that. So with 404s, along with I think 401s and maybe 403s, if we see a page and we get a 404, we are going to protect that page for 24 hours in the crawling system.” – John Mueller**

A Major Part of SEO is Crawling and Indexing

With so many tasks involved today in digital marketing and improving site performance with SEO current best practices , many small businesses feel challenged to give sufficient time and effort to Google crawl optimization. If you fall in this bucket, it is quite possible you are missing a significant amount of traffic. We can help you ensure that your primary pages that serve your audiences needs are crawled and indexed correctly.

Crawl optimization should be a highly rated priority for any large website seeking to improve its SEO efforts. Even with the best of e-Commerce Schema implementation , if your site isn't indexed correctly, you have a real problem. By implementing tracking, monitoring your Google Analytics SEO reports , and directing GoogleBot to your key web content, you can gain an advantage over your competition.

Summary

In order to be indexed and returned in search engine results, your website should be easy to crawl first. If you think your business website is poorly indexed or returned, it is important to determine if your site is correctly crawled. Start with full website SEO audit , implement improvements, and then see how the benefit you gain in increased Internet traffic and site views.

Remember, reaching your goal of having your website indexed by Google is only the first step in successful digital marketing. To improve your website beyond being crawled and indexed, make sure you're following basic SEO principles, creating high-value content users want, and getting rich data insights from Google Analytics . Then, you'll be in a better position to integrate organic and paid search .

Hill Web Creations can offer you new ideas on how to “encourage” Google to re-crawl your website, or select web pages that have been recently updated. Call 661-206-2410 and ask for Jeannie. The benefits of our work will show up in your future comprehensive SEO Reports .

Or you can start by checking out ourTypes of Website Audits Available

* https://support.google.com/webmasters/answer/35769

** https://www.youtube.com/watch?v=kQIyk-2-wRg

*** https://developers.google.com/search/docs/advanced/robots/robots_txt