Лучшие бесплатные инструменты для создания robots.txt

Опубликовано: 2022-04-28Когда дело доходит до вашего веб-сайта, очень важно сделать все возможное (цифровое). Это может означать скрытие некоторых страниц от робота Googlebot при сканировании вашего сайта. Файлы robots.txt, к счастью, позволяют вам это сделать. Мы рассмотрим актуальность файлов robots.txt и способы их создания с помощью бесплатных инструментов генератора txt для роботов в следующих разделах.

Что такое файл robots.txt и зачем он мне нужен?

Давайте поговорим о том, что такое файл robots.txt и почему он необходим, прежде чем мы перейдем к невероятно полезным (и бесплатным!) инструментам генератора robots.txt, которые вы должны проверить.

На вашем веб-сайте могут быть страницы, которые вы не хотите сканировать или нуждаетесь в роботе Googlebot. Файл robots.txt сообщает Google, какие страницы и файлы на вашем веб-сайте следует сканировать, а какие игнорировать. Считайте это практическим руководством для робота Googlebot, которое поможет вам сэкономить время.

вот как это работает

Робот хочет просканировать URL-адрес веб-сайта, например http://www.coolwebsite.com/welcome.html. Сначала он сканирует http://www.coolwebsite.com/robots.txt и находит:

Раздел запрета информирует поисковых роботов о том, что некоторые веб-страницы или элементы веб-сайта не должны сканироваться.

Каково значение файла Robots.txt?

Файл robots.txt полезен для различных целей SEO. Во-первых, это позволяет Google быстро и четко определить, какие страницы вашего сайта более значимы, чем другие.

Файлы robots.txt можно использовать для предотвращения отображения таких аспектов веб-сайта, как аудиофайлы, в результатах поиска. Обратите внимание, что хотя файл robots.txt не следует использовать для сокрытия страниц от Google, его можно использовать для контроля трафика поисковых роботов.

В соответствии с рекомендациями Google по бюджету на сканирование, вы не хотите, чтобы сканер Google перегружал ваш сервер или растрачивал деньги на сканирование неважных или похожих страниц на вашем сайте.

Что такое файл robots.txt и как его создать?

Для Google файлы robots.txt должны быть отформатированы определенным образом. На каждом веб-сайте разрешен один файл robots.txt. Первое, что нужно помнить, это то, что файл robots.txt вашего домена должен находиться в корневом каталоге.

Подробные инструкции по созданию файлов robots.txt вручную см. в Центре поиска Google. Мы составили список из 10 лучших инструментов для создания robots.txt, которые вы можете использовать бесплатно!

10 бесплатных инструментов для создания robots.txt :

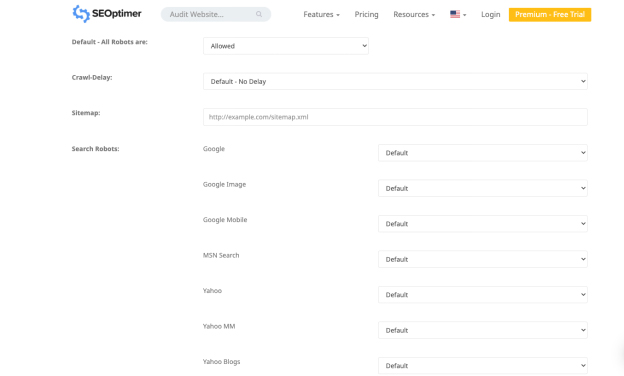

1. SEO-оптимизатор

Приложение от Seo Optimer позволяет бесплатно собрать файл robots.txt. Инструмент предлагает надежный интерфейс для бесплатного создания файла robots.txt. Вы можете выбрать период задержки сканирования и каким ботам разрешено или запрещено сканировать ваш сайт.

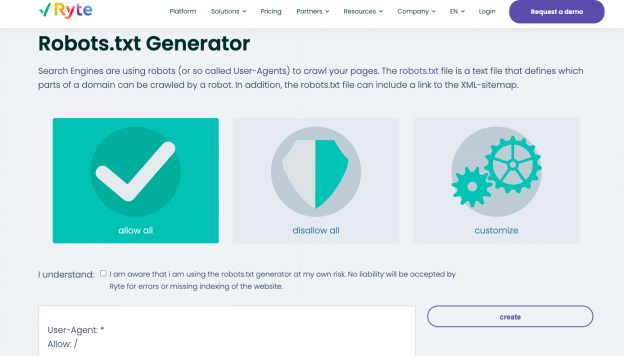

2. Райт

Разрешить все, запретить все и настроить — вот три варианта создания файла robots.txt в бесплатном генераторе Ryte. Вы можете выбрать, на каких ботов вы хотите повлиять, с помощью параметра настройки, содержащего пошаговые инструкции.

Ryte поможет вам провести SEO-аудит, чтобы выявить содержание вашего сайта, технические и структурные ошибки. Начните анализ одним щелчком мыши или запланируйте частые сканирования для автоматизации потоков данных. Вы можете настроить сканирование с более чем 15 конфигурациями или использовать надежный API для интеграции данных непосредственно в ваш обычный рабочий процесс. С помощью этого инструмента вы получите всю необходимую информацию для повышения UX вашего сайта.

Вы можете легко создавать интригующий контент с рекомендациями ключевых слов Ryte, которые помогут вашему веб-сайту отображаться в верхней части поисковой выдачи. Как только вы поймете рекомендации по ключевым словам, вы сможете изменить свой веб-контент с помощью структурированных данных и тегов schema.org. Вы можете экспортировать готовый текст в HTML, а затем скопировать и вставить в свою CMS.

3. Лучше Robots.txt (WordPress)

Плагин Better Robots.txt для WordPress улучшает SEO и скорость загрузки вашего сайта. Он может защитить ваши данные и контент от вредоносных ботов и доступен на семи языках. Плагин Better Robots.txt работает с плагином Yoast SEO и другими генераторами карт сайта. Плагин может определить, используете ли вы в настоящее время Yoast SEO или доступны ли какие-либо другие карты сайта на вашем веб-сайте. Чтобы добавить карту сайта, вам нужно всего лишь скопировать и вставить URL-адрес карты сайта. Затем Better Robots.txt добавит его в ваш файл Robots.txt.

Плагин Better Robots.txt поможет вам заблокировать сканирование вредоносных ботов и их влияние на ваши данные. Плагин защищает ваш сайт WordPress от парсеров и пауков. Он также предоставляет обновления и время с более полным списком плохих ботов, заблокированных инструментом.

4. Виртуальные роботы.txt (WordPress)

Плагин WordPress Virtual Robots.txt — это простое и автоматизированное решение для создания и управления файлом robots.txt для вашего веб-сайта. Вам нужно только загрузить и активировать плагин, прежде чем использовать его по максимуму.

Плагин Virtual Robots.txt по умолчанию предоставляет доступ к элементам WordPress, к которым должны иметь доступ хорошие бутсы, такие как Google. В то время как другие части WordPress остаются заблокированными. Когда плагин обнаруживает предыдущий XML-файл карты сайта, ссылка на него автоматически добавляется в файл robots.txt.

5. Небольшие SEO-инструменты

Еще одним простым инструментом для создания файла robot.txt является бесплатный генератор Small SEO Tools. Он использует раскрывающиеся меню для настроек каждого бота. Для каждого бота вы можете выбрать, разрешен он или нет.

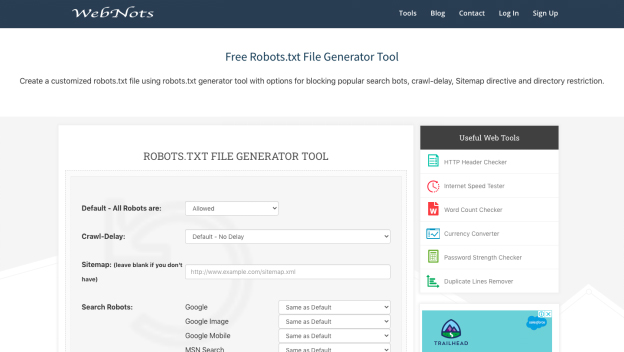

6. Веб-ноты

Из-за своего минималистского внешнего вида инструмент генерации robots.txt Web Nots похож на генератор Small SEO Tools. Он также включает раскрывающиеся меню и раздел для ограниченных каталогов. Когда вы закончите, вы можете скачать файл robots.txt.

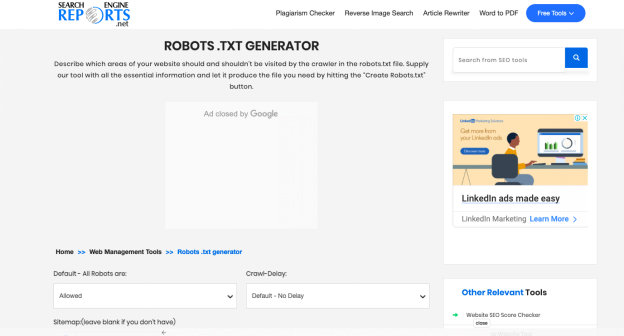

7. Отчеты поисковых систем

Генератор в отчетах поисковой системы предоставляет части для карты вашего сайта и любых каталогов с ограниченным доступом. Это бесплатное приложение — прекрасный способ быстро создать файл robots.txt.

С отчетами поисковых систем вы проверяете фрагмент контента, содержащий 2000 слов за раз. Вы можете вставить содержимое в поле и нажать кнопку отправки. Интеграция с Dropbox позволяет напрямую загружать контент с этой платформы.

Вы также можете загрузить файлы, хранящиеся в вашей системе, нажав на опцию «Загрузить файл» в отчетах поисковой системы. Вы можете добавить URL-адрес в поле с онлайн-проверкой на плагиат, и программное обеспечение выполнит подробные операции.

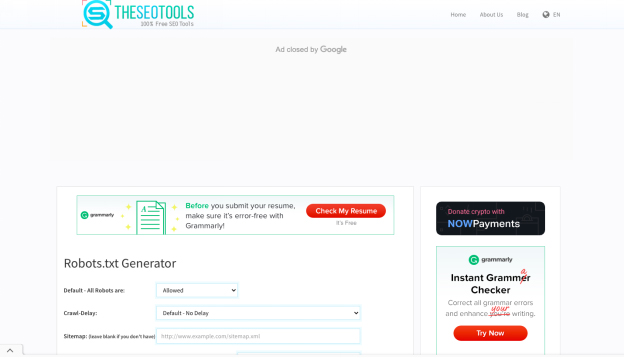

8. SEO-инструменты

Бесплатный генератор robots.txt от SEO Tools — это простой и быстрый способ создать файл robots.txt для вашего веб-сайта. Если хотите, вы можете определить задержку сканирования и ввести карту сайта. Когда вы завершите выбор нужных параметров, нажмите «Создать и сохранить как Robots.txt».

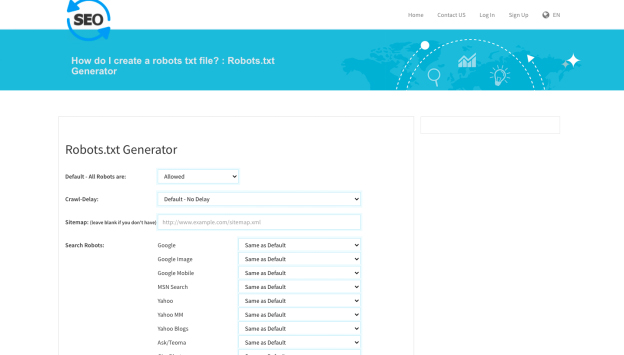

9. SEO для проверки

Еще одним полезным инструментом для создания файла robots.txt является генератор robot.txt SEO To Checker. Вы можете настроить все параметры поисковых роботов и добавить свою карту сайта.

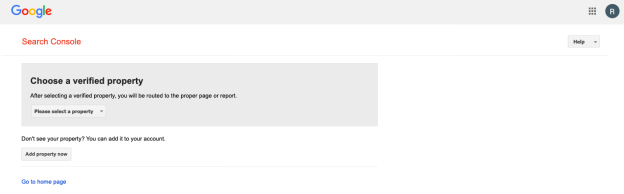

10. Тестер Robots.txt Google Search Console

Вы можете использовать тестер robots.txt в Google Search Console после создания файла robots.txt. Чтобы определить, правильно ли составлен ваш URL-адрес, чтобы запретить роботу Googlebot доступ к определенным разделам, которые вы хотите скрыть, отправьте его в инструмент тестирования.

Подводя итог!

Перечисленные выше инструменты упрощают и ускоряют создание файла robots.txt. С другой стороны, здоровый, хорошо работающий веб-сайт выходит за рамки файла robots.txt. Улучшение технического SEO имеет решающее значение для придания вашему веб-сайту необходимой видимости и успеха SEO, которого он заслуживает.