I migliori strumenti gratuiti per la generazione di Robots.txt

Pubblicato: 2022-04-28È fondamentale dare il meglio di sé (digitale) quando si tratta del tuo sito web. Ciò potrebbe implicare l'occultamento di alcune pagine da Googlebot durante la scansione del tuo sito. I file Robots.txt, fortunatamente, ti consentono di fare proprio questo. Esamineremo la pertinenza dei file robots.txt e come crearli con strumenti gratuiti per la generazione di file robots txt, nelle sezioni seguenti.

Che cos'è un file Robots.txt e perché ne ho bisogno?

Parliamo di cos'è un file robots.txt e perché è necessario prima di entrare negli strumenti di generazione robots.txt incredibilmente utili (e gratuiti!) che dovresti controllare.

Potrebbero esserci pagine sul tuo sito web di cui non desideri o di cui non hai bisogno per eseguire la scansione di Googlebot. Un file robots.txt indica a Google quali pagine e file del tuo sito web eseguire la scansione e quali ignorare. Considerala una guida pratica per Googlebot per aiutarti a risparmiare tempo.

Ecco come funziona

Un robot vuole eseguire la scansione dell'URL di un sito Web come http://www.coolwebsite.com/welcome.html. Innanzitutto, esegue la scansione di http://www.coolwebsite.com/robots.txt e trova:

La sezione non consentire informa i robot di ricerca di non eseguire la scansione di alcune pagine Web o elementi del sito Web.

Qual è il significato di un file Robots.txt?

Un file robots.txt è utile per una varietà di scopi SEO. Per cominciare, consente a Google di determinare in modo rapido e chiaro quali pagine del tuo sito sono più significative di altre.

I file Robots.txt possono essere utilizzati per impedire che aspetti di un sito Web, come i file audio, vengano visualizzati nei risultati di ricerca. Tieni presente che mentre un file robots.txt non deve essere utilizzato per nascondere pagine a Google, può essere utilizzato per controllare il traffico del crawler.

Secondo la guida al crawl budget di Google, non vuoi che il crawler di Google travolga il tuo server o sprechi denaro per eseguire la scansione di pagine non importanti o simili sul tuo sito.

Che cos'è un file Robots.txt e come faccio a crearne uno?

Per Google, i file robots.txt devono essere formattati in un modo specifico. Un singolo file robots.txt è consentito su ogni dato sito web. La prima cosa da ricordare è che il file robots.txt del tuo dominio deve essere posizionato nella directory principale.

Per istruzioni dettagliate sulla creazione manuale dei file robots.txt, vai a Google Search Central. Abbiamo compilato un elenco dei 10 migliori strumenti per la generazione di robots.txt che puoi utilizzare gratuitamente!

10 strumenti gratuiti per la generazione di Robots.txt :

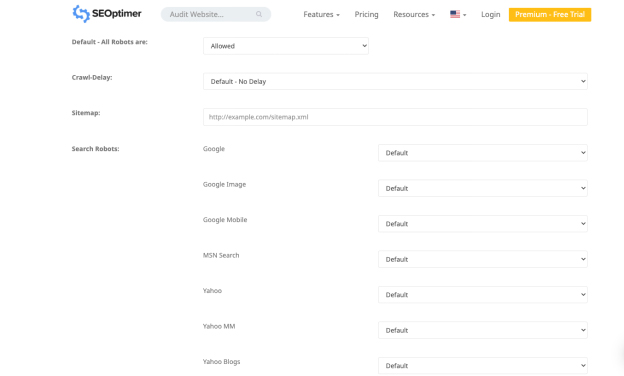

1. Ottimizzatore SEO

L'applicazione di Seo Optimer ti consente di creare gratuitamente un file robots.txt. Lo strumento offre un'interfaccia potente per creare gratuitamente un file robots.txt. Puoi scegliere un periodo di ritardo della scansione e quali bot sono autorizzati o vietati a eseguire la scansione del tuo sito.

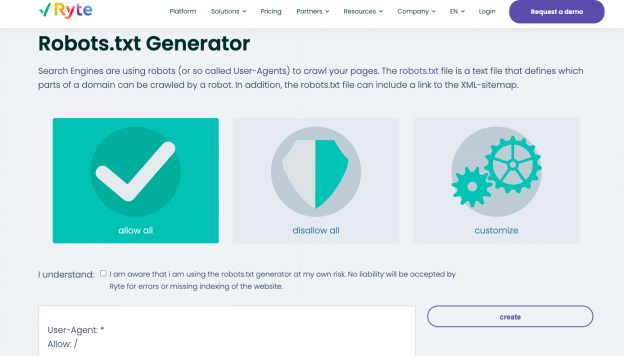

2. Rita

Consenti tutto, non consenti tutto e personalizza sono le tre opzioni per generare un file robots.txt nel generatore gratuito di Ryte. Puoi scegliere quali bot desideri influenzare con l'opzione di personalizzazione, contenente istruzioni dettagliate.

Ryte ti aiuta a condurre audit SEO per identificare il contenuto, gli errori tecnici e strutturali del tuo sito web. Inizia ad analizzare con un solo clic o pianifica scansioni frequenti per automatizzare i flussi di dati. Puoi personalizzare la scansione con più di 15 configurazioni o utilizzare una robusta API per integrare i dati direttamente nel tuo normale flusso di lavoro. Con lo strumento, ottieni tutte le informazioni necessarie per migliorare l'UX del tuo sito web.

Puoi facilmente creare contenuti intriganti con i consigli sulle parole chiave di Ryte che aiutano il tuo sito Web a essere visualizzato in cima alle SERP. Una volta compresi i consigli sulle parole chiave, puoi modificare i tuoi contenuti web con dati strutturati e tag schema.org. Puoi esportare il testo completato in HTML e quindi copiarlo e incollarlo nel tuo CMS.

3. Migliore Robots.txt (WordPress)

Il plugin Better Robots.txt WordPress migliora la SEO e la velocità di caricamento del tuo sito web. Può proteggere i tuoi dati e i tuoi contenuti da bot dannosi ed è disponibile in sette lingue. Il plug-in Better Robots.txt funziona con il plug-in Yoast SEO e altri generatori di mappe del sito. Il plug-in può rilevare se attualmente utilizzi Yoast SEO o se sono disponibili altre mappe del sito sul tuo sito web. Per aggiungere la tua mappa del sito, devi solo copiare e incollare l'URL della mappa del sito. Quindi, Better Robots.txt lo aggiungerà al tuo file Robots.txt.

Il plug-in Better Robots.txt ti aiuta a impedire ai robot dannosi di tendenza di eseguire la scansione e di influenzare i tuoi dati. Il plugin protegge il tuo sito Web WordPress da scraper e spider. Fornisce inoltre aggiornamenti e tempo con un elenco più completo di robot dannosi bloccati dallo strumento.

4. Virtual Robots.txt (WordPress)

Il plugin di WordPress Virtual Robots.txt è una soluzione semplice e automatizzata per creare e gestire un file robots.txt per il tuo sito web. Devi solo caricare e attivare il plugin prima di sfruttarlo al meglio.

Il plug-in Virtual Robots.txt consente di accedere per impostazione predefinita agli elementi di WordPress a cui devono accedere i buoni stivali, come Google. Mentre le altre parti di WordPress rimangono bloccate. Quando il plug-in rileva un file della mappa del sito XML precedente, un riferimento ad esso viene aggiunto automaticamente al file robots.txt.

5. Piccoli strumenti SEO

Un altro semplice strumento per creare un file robot.txt è il generatore gratuito del generatore gratuito di Small SEO Tools. Fa uso di menu a discesa per le preferenze di ciascun bot. Per ogni bot, puoi scegliere se è consentito o meno.

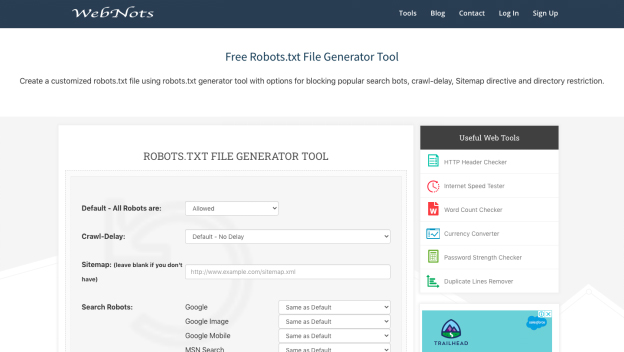

6. Web Not

A causa del suo aspetto minimalista, lo strumento di generazione robots.txt di Web Nots è simile al generatore di Small SEO Tools. Include anche menu a discesa e una sezione per le directory limitate. Al termine, puoi scaricare il file robots.txt.

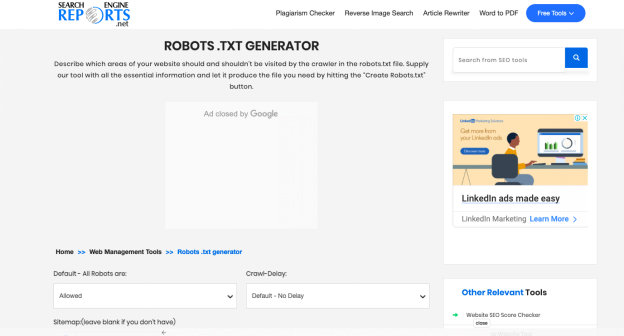

7. Rapporti sui motori di ricerca

Il generatore nei rapporti sui motori di ricerca fornisce parti per la mappa del tuo sito e tutte le directory limitate. Questa applicazione gratuita è un modo meraviglioso per creare rapidamente un file robots.txt.

Con i rapporti sui motori di ricerca, controlli un contenuto contenente 2000 parole alla volta. Puoi incollare il contenuto nella casella e fare clic sul pulsante di invio. La sua integrazione con Dropbox ti aiuta a caricare contenuti direttamente da questa piattaforma.

Puoi anche caricare i file archiviati nel tuo sistema facendo clic sull'opzione "Carica file" di Rapporti sui motori di ricerca. Puoi aggiungere un URL alla casella con il controllo del plagio online e il software esegue operazioni dettagliate.

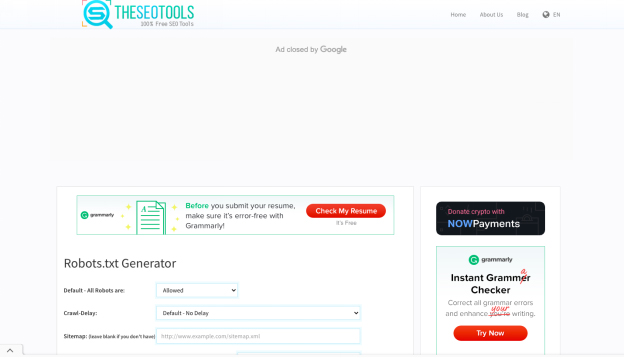

8. Gli strumenti SEO

Il generatore gratuito robots.txt di SEO Tools è un modo semplice e veloce per creare un file robots.txt per il tuo sito web. Se lo desideri, puoi definire un crawl-delay e inserire la mappa del tuo sito. Dopo aver completato la selezione delle opzioni desiderate, fai clic su "Crea e salva come Robots.txt".

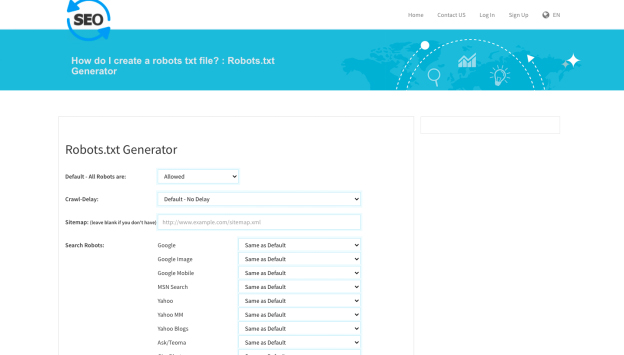

9. SEO per Checker

Un altro strumento utile per creare un file robots.txt è il generatore robot.txt di SEO To Checker. Puoi modificare tutte le opzioni dei robot di ricerca e aggiungere la mappa del tuo sito.

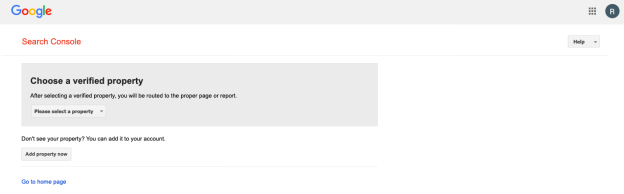

10. Tester Robots.txt di Google Search Console

Puoi utilizzare il tester robots.txt di Google Search Console dopo aver creato un file robots.txt. Per determinare se il tuo URL è stato costruito correttamente per impedire a Googlebot di accedere a determinate sezioni che desideri nascondere, invialo allo strumento tester.

Riassumendo!

Gli strumenti sopra elencati rendono la creazione di un file robots.txt semplice e veloce. Un sito web sano e con buone prestazioni, d'altra parte, va oltre robots.txt. Migliorare la SEO tecnica è fondamentale per dare al tuo sito web la visibilità di cui ha bisogno e il successo SEO che merita.