Meilleurs outils de générateur Robots.txt gratuits

Publié: 2022-04-28Il est essentiel de mettre en avant votre meilleur pied (numérique) lorsqu'il s'agit de votre site Web. Cela peut impliquer de cacher certaines pages à Googlebot pendant qu'il explore votre site. Heureusement, les fichiers Robots.txt vous permettent de faire exactement cela. Nous allons passer en revue la pertinence des fichiers robots.txt et comment les créer avec des outils de générateur de robots txt gratuits, dans les sections ci-dessous.

Qu'est-ce qu'un fichier Robots.txt et pourquoi en ai-je besoin ?

Parlons de ce qu'est un fichier robots.txt et pourquoi il est nécessaire avant d'entrer dans les outils générateurs de robots.txt incroyablement utiles (et gratuits !) que vous devriez consulter.

Il se peut que certaines pages de votre site Web ne soient pas explorées par Googlebot ou que vous n'en ayez pas besoin. Un fichier robots.txt indique à Google les pages et les fichiers de votre site Web à explorer et ceux à ignorer. Considérez-le comme un guide pratique pour Googlebot pour vous aider à gagner du temps.

Voici comment ça fonctionne

Un robot veut explorer une URL de site Web telle que http://www.coolwebsite.com/welcome.html. Tout d'abord, il recherche http://www.coolwebsite.com/robots.txt et trouve :

La section d'interdiction informe les robots de recherche de ne pas explorer certaines pages Web ou certains éléments du site Web.

Quelle est la signification d'un fichier Robots.txt ?

Un fichier robots.txt est utile à diverses fins de référencement. Pour commencer, cela permet à Google de déterminer rapidement et clairement quelles pages de votre site sont plus importantes que les autres.

Les fichiers robots.txt peuvent être utilisés pour empêcher certains aspects d'un site Web, tels que les fichiers audio, d'apparaître dans les résultats de recherche. Notez que même si un fichier robots.txt ne doit pas être utilisé pour dissimuler des pages à Google, il peut être utilisé pour contrôler le trafic des robots.

Selon les conseils de budget d'exploration de Google, vous ne voulez pas que le robot d'exploration de Google submerge votre serveur ou gaspille de l'argent d'exploration en explorant des pages sans importance ou similaires sur votre site.

Qu'est-ce qu'un fichier Robots.txt et comment en créer un ?

Pour Google, les fichiers robots.txt doivent être formatés d'une manière spécifique. Un seul fichier robots.txt est autorisé sur chaque site Web donné. La première chose à retenir est que le fichier robots.txt de votre domaine doit être placé dans le répertoire racine.

Pour obtenir des instructions détaillées sur la création manuelle de fichiers robots.txt, accédez à Google Search Central. Nous avons compilé une liste des 10 meilleurs outils générateurs de robots.txt que vous pouvez utiliser gratuitement !

10 outils générateurs de Robots.txt gratuits :

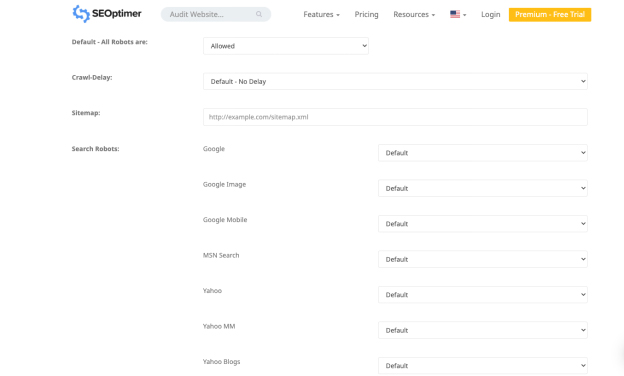

1. Optimiseur de référencement

L'application de Seo Optimer vous permet de créer gratuitement un fichier robots.txt. L'outil offre une interface puissante pour créer un fichier robots.txt gratuitement. Vous pouvez choisir une période de délai d'exploration et quels bots sont autorisés ou interdits d'explorer votre site.

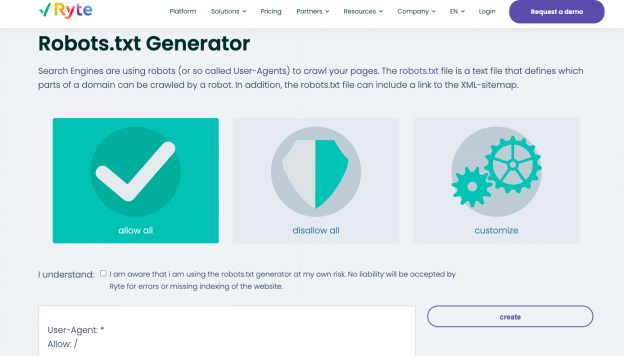

2. Ryte

Autoriser tout, interdire tout et personnaliser sont les trois options permettant de générer un fichier robots.txt dans le générateur gratuit de Ryte. Vous pouvez choisir les robots que vous souhaitez influencer avec l'option de personnalisation, contenant des instructions étape par étape.

Ryte vous aide à mener des audits SEO pour identifier le contenu, les erreurs techniques et structurelles de votre site Web. Commencez à analyser en un seul clic ou planifiez des analyses fréquentes pour automatiser les flux de données. Vous pouvez personnaliser l'exploration avec plus de 15 configurations ou utiliser une API robuste pour intégrer les données directement dans votre flux de travail habituel. Avec l'outil, vous obtenez toutes les informations nécessaires pour booster l'UX de votre site Web.

Vous pouvez facilement créer un contenu intrigant avec les recommandations de mots clés de Ryte qui aident votre site Web à s'afficher en haut des SERP. Une fois que vous avez compris les recommandations de mots clés, vous pouvez modifier votre contenu Web avec des données structurées et des balises schema.org. Vous pouvez exporter le texte complété au format HTML, puis copier et coller dans votre CMS.

3. Meilleur Robots.txt (WordPress)

Le plugin WordPress Better Robots.txt améliore le référencement et la vitesse de chargement de votre site Web. Il peut sécuriser vos données et votre contenu contre les robots nuisibles et est disponible en sept langues. Le plugin Better Robots.txt fonctionne avec le plugin Yoast SEO et d'autres générateurs de sitemap. Le plugin peut détecter si vous utilisez actuellement Yoast SEO ou si d'autres plans de site sont disponibles sur votre site Web. Pour ajouter votre sitemap, il vous suffit de copier-coller l'URL du sitemap. Ensuite, Better Robots.txt l'ajoutera à votre fichier Robots.txt.

Le plugin Better Robots.txt vous aide à empêcher les mauvais bots d'explorer et d'affecter vos données. Le plugin protège votre site Web WordPress contre les grattoirs et les araignées. Il fournit également des mises à niveau et du temps avec une liste plus complète des mauvais robots bloqués par l'outil.

4. Robots virtuels.txt (WordPress)

Le plugin WordPress Virtual Robots.txt est une solution simple et automatisée pour créer et gérer un fichier robots.txt pour votre site Web. Il vous suffit de télécharger et d'activer le plugin avant d'en tirer le meilleur parti.

Le plugin Virtual Robots.txt donne accès aux éléments WordPress par défaut auxquels les bonnes bottes, comme Google, doivent accéder. Alors que les autres parties de WordPress restent bloquées. Lorsque le plug-in détecte un fichier de plan de site XML précédent, une référence à celui-ci est automatiquement ajoutée au fichier robots.txt.

5. Petits outils de référencement

Un autre outil simple pour créer un fichier robot.txt est le générateur gratuit du générateur gratuit de Small SEO Tools. Il utilise des menus déroulants pour les préférences de chaque bot. Pour chaque bot, vous pouvez choisir s'il est autorisé ou non.

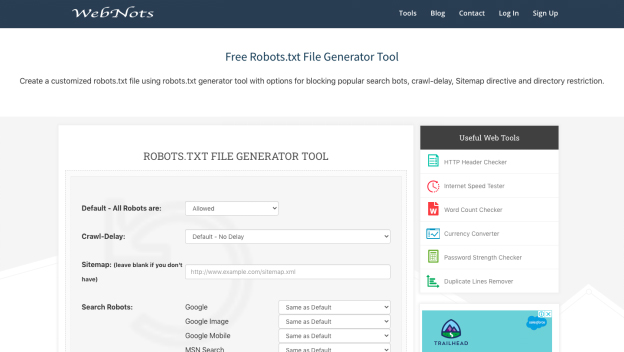

6. Notions Web

En raison de son apparence minimaliste, l'outil de génération de robots.txt de Web Nots est similaire au générateur de Small SEO Tools. Il comprend également des menus déroulants et une section pour les répertoires restreints. Lorsque vous avez terminé, vous pouvez télécharger le fichier robots.txt.

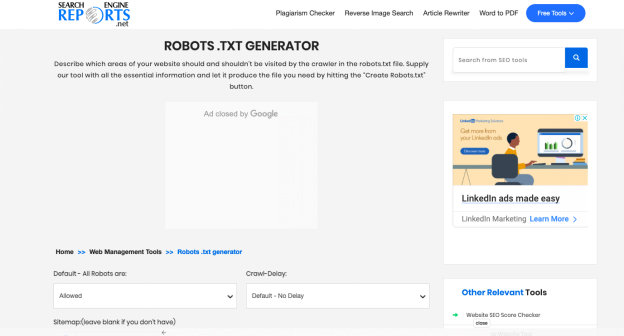

7. Rapports des moteurs de recherche

Le générateur de rapports de moteur de recherche fournit des parties pour votre plan de site et tous les répertoires restreints. Cette application gratuite est un excellent moyen de créer rapidement un fichier robots.txt.

Avec Search Engine Reports, vous vérifiez un contenu contenant 2000 mots à la fois. Vous pouvez coller le contenu dans la boîte et cliquer sur le bouton Soumettre. Son intégration avec Dropbox vous aide à télécharger directement du contenu depuis cette plateforme.

Vous pouvez également télécharger les fichiers stockés dans votre système en cliquant sur l'option "Télécharger le fichier" par Search Engine Reports. Vous pouvez ajouter une URL à la boîte avec le vérificateur de plagiat en ligne, et le logiciel exécute des opérations détaillées.

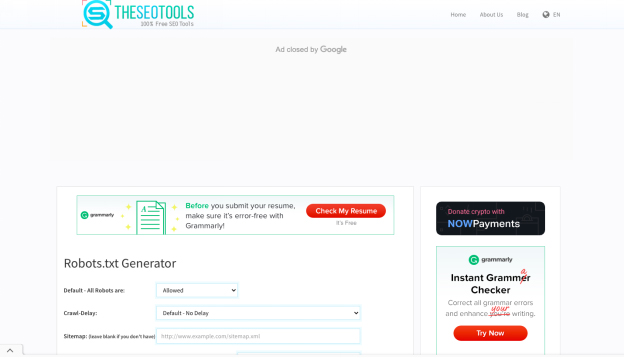

8. Les outils de référencement

Le générateur gratuit de robots.txt de SEO Tools est un moyen simple et rapide de créer un fichier robots.txt pour votre site Web. Si vous le souhaitez, vous pouvez définir un délai de crawl et saisir votre plan de site. Lorsque vous avez terminé de sélectionner les options souhaitées, cliquez sur "Créer et enregistrer sous Robots.txt".

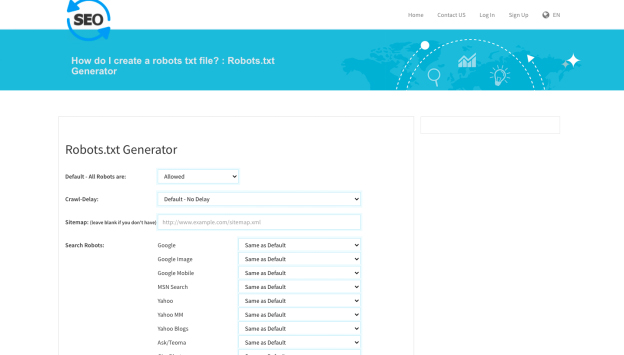

9. SEO vers vérificateur

Un autre outil utile pour créer un fichier robots.txt est le générateur robot.txt de SEO To Checker. Vous pouvez ajuster toutes les options des robots de recherche et ajouter votre plan de site.

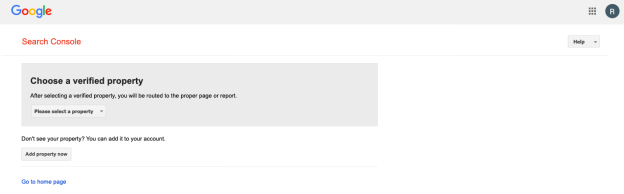

10. Testeur Robots.txt de la console de recherche Google

Vous pouvez utiliser le testeur robots.txt de Google Search Console une fois que vous avez créé un fichier robots.txt. Pour déterminer si votre URL est correctement construite pour interdire à Googlebot certaines sections que vous souhaitez masquer, soumettez-la à l'outil de test.

En résumé !

Les outils répertoriés ci-dessus rendent la création d'un fichier robots.txt simple et rapide. Un site Web sain et performant, en revanche, va au-delà de robots.txt. L'amélioration du référencement technique est essentielle pour donner à votre site Web la visibilité dont il a besoin et le succès SEO qu'il mérite.