Las mejores herramientas gratuitas de generación de Robots.txt

Publicado: 2022-04-28Es fundamental dar lo mejor de sí (digital) cuando se trata de su sitio web. Esto podría implicar ocultar algunas páginas del robot de Google mientras rastrea su sitio. Los archivos Robots.txt, afortunadamente, le permiten hacer precisamente eso. Veremos la relevancia de los archivos robots.txt y cómo crearlos con herramientas gratuitas de generación de robots txt, en las secciones a continuación.

¿Qué es un archivo Robots.txt y por qué necesito uno?

Hablemos de qué es un archivo robots.txt y por qué es necesario antes de entrar en las increíblemente útiles (¡y gratuitas!) herramientas generadoras de robots.txt que debe consultar.

Es posible que haya páginas en su sitio web que no desea o no necesita que Googlebot rastree. Un archivo robots.txt le dice a Google qué páginas y archivos de su sitio web rastrear y cuáles ignorar. Considéralo una guía práctica para que Googlebot te ayude a ahorrar tiempo.

Así es como funciona

Un robot quiere rastrear la URL de un sitio web como http://www.coolwebsite.com/welcome.html. Primero, busca http://www.coolwebsite.com/robots.txt y encuentra:

La sección de rechazo informa a los robots de búsqueda que no rastreen algunas páginas web o elementos del sitio web.

¿Cuál es el significado de un archivo Robots.txt?

Un archivo robots.txt es útil para una variedad de propósitos de SEO. Para empezar, le permite a Google determinar rápida y claramente qué páginas de su sitio son más importantes que otras.

Los archivos Robots.txt se pueden usar para evitar que aspectos de un sitio web, como archivos de audio, aparezcan en los resultados de búsqueda. Tenga en cuenta que si bien un archivo robots.txt no debe usarse para ocultar páginas de Google, puede usarse para controlar el tráfico del rastreador.

De acuerdo con la guía de presupuesto de rastreo de Google, no desea que el rastreador de Google abrume su servidor o malgaste el dinero de rastreo rastreando páginas sin importancia o similares en su sitio.

¿Qué es un archivo Robots.txt y cómo creo uno?

Para Google, los archivos robots.txt deben tener un formato específico. Se permite un solo archivo robots.txt en cada sitio web. Lo primero que debe recordar es que el archivo robots.txt de su dominio debe colocarse en el directorio raíz.

Para obtener instrucciones detalladas sobre la creación manual de archivos robots.txt, vaya a Google Search Central. ¡Hemos compilado una lista de las 10 mejores herramientas generadoras de robots.txt que puede usar de forma gratuita!

10 herramientas gratuitas de generación de Robots.txt :

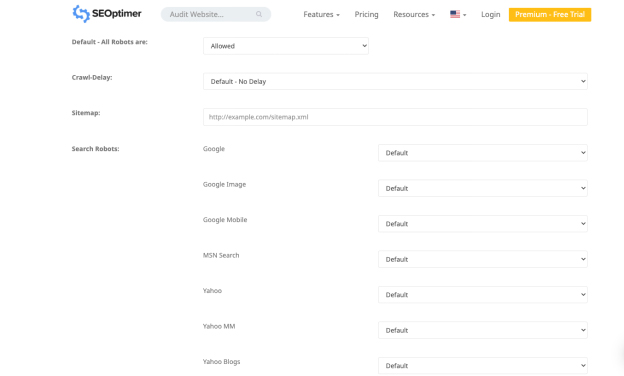

1. Optimizador SEO

La aplicación de Seo Optimer le permite crear un archivo robots.txt de forma gratuita. La herramienta ofrece una interfaz sólida para crear un archivo robots.txt de forma gratuita. Puede elegir un período de demora de rastreo y qué bots tienen permitido o prohibido rastrear su sitio.

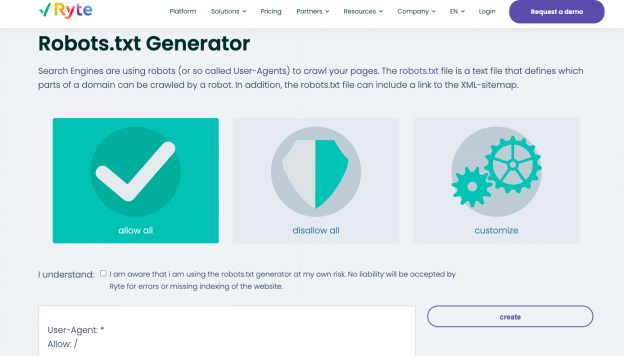

2. Ryte

Permitir todo, rechazar todo y personalizar son las tres opciones para generar un archivo robots.txt en el generador gratuito de Ryte. Puede elegir en qué bots desea influir con la opción de personalización, que contiene instrucciones paso a paso.

Ryte lo ayuda a realizar auditorías de SEO para identificar el contenido, los errores técnicos y estructurales de su sitio web. Comience a analizar con un solo clic o programe rastreos frecuentes para automatizar flujos de datos. Puede personalizar el rastreo con más de 15 configuraciones o usar una API robusta para integrar datos directamente en su flujo de trabajo habitual. Con la herramienta, obtienes toda la información necesaria para impulsar la experiencia de usuario de tu sitio web.

Puede crear fácilmente contenido intrigante con las recomendaciones de palabras clave de Ryte que ayudan a que su sitio web se muestre en la parte superior de las SERP. Una vez que comprenda las recomendaciones de palabras clave, puede modificar su contenido web con datos estructurados y etiquetas schema.org. Puede exportar el texto completo a HTML y luego copiarlo y pegarlo en su CMS.

3. Mejor Robots.txt (WordPress)

El complemento de WordPress Better Robots.txt mejora el SEO y la velocidad de carga de su sitio web. Puede proteger sus datos y contenido contra bots dañinos y está disponible en siete idiomas. El complemento Better Robots.txt funciona con el complemento Yoast SEO y otros generadores de mapas de sitio. El complemento puede detectar si actualmente usa Yoast SEO o si hay otros mapas de sitio disponibles en su sitio web. Para agregar su mapa del sitio, solo necesita copiar y pegar la URL del mapa del sitio. Luego, Better Robots.txt lo agregará a su archivo Robots.txt.

El complemento Better Robots.txt lo ayuda a bloquear los bots malos de tendencia para que no rastreen y afecten sus datos. El complemento protege su sitio web de WordPress contra raspadores y arañas. También proporciona actualizaciones y tiempo con una lista más completa de bots malos bloqueados por la herramienta.

4. Robots virtuales.txt (WordPress)

El complemento de WordPress Virtual Robots.txt es una solución fácil y automatizada para crear y administrar un archivo robots.txt para su sitio web. Solo necesita cargar y activar el complemento antes de aprovecharlo al máximo.

El complemento Virtual Robots.txt da acceso a los elementos de WordPress por defecto a los que las buenas botas, como Google, necesitan acceder. Mientras que las otras partes de WordPress permanecen bloqueadas. Cuando el complemento detecta un archivo de mapa de sitio XML anterior, se agrega automáticamente una referencia al archivo robots.txt.

5. Pequeñas herramientas de SEO

Otra herramienta sencilla para crear un archivo robot.txt es el generador gratuito de Small SEO Tools. Hace uso de menús desplegables para las preferencias de cada bot. Para cada bot, puede elegir si está permitido o no.

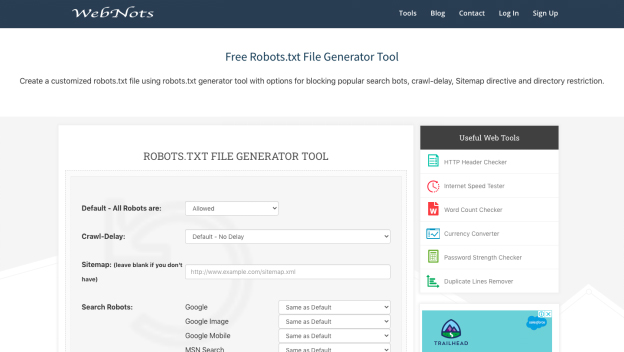

6. Notas web

Debido a su apariencia minimalista, la herramienta de generación de robots.txt de Web Nots es similar al generador de Small SEO Tools. También incluye menús desplegables y una sección para directorios restringidos. Cuando haya terminado, puede descargar el archivo robots.txt.

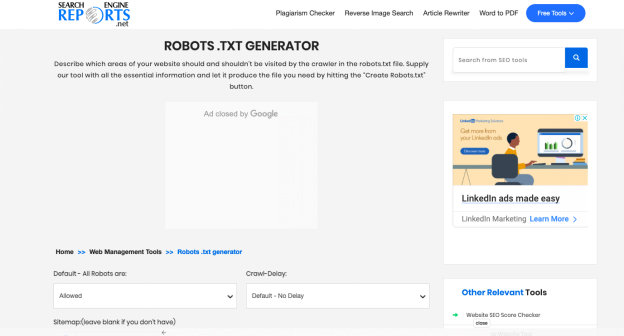

7. Informes de motores de búsqueda

El generador en Search Engine Reports proporciona partes para el mapa de su sitio y cualquier directorio restringido. Esta aplicación gratuita es una manera maravillosa de crear un archivo robots.txt rápidamente.

Con los informes del motor de búsqueda, revisa un contenido que contiene 2000 palabras a la vez. Puede pegar el contenido en el cuadro y hacer clic en el botón Enviar. Su integración con Dropbox te ayuda a subir contenido directamente desde esta plataforma.

También puede cargar los archivos almacenados en su sistema haciendo clic en la opción "Cargar archivo" de Search Engine Reports. Puede agregar una URL al cuadro con el verificador de plagio en línea y el software ejecuta operaciones detalladas.

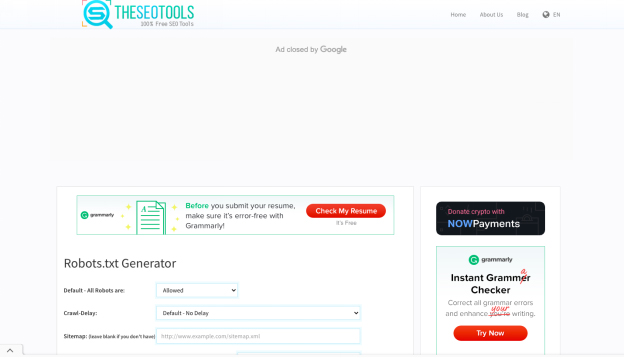

8. Las herramientas SEO

El generador gratuito de robots.txt de SEO Tools es una forma simple y rápida de crear un archivo robots.txt para su sitio web. Si lo desea, puede definir un retraso de rastreo e ingresar el mapa de su sitio. Cuando haya terminado de seleccionar las opciones que desea, haga clic en "Crear y guardar como Robots.txt".

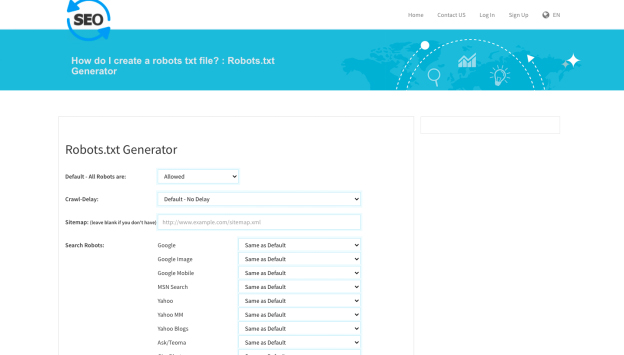

9. SEO al verificador

Otra herramienta útil para crear un archivo robots.txt es el generador robot.txt de SEO To Checker. Puede ajustar todas las opciones de los robots de búsqueda y agregar su mapa del sitio.

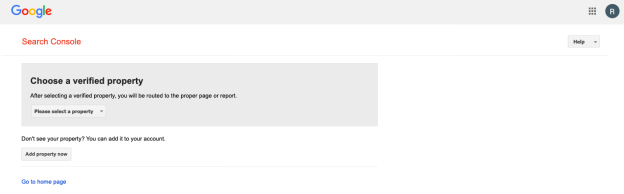

10. Probador de Robots.txt de la consola de búsqueda de Google

Puede utilizar el probador de robots.txt de Google Search Console una vez que haya creado un archivo robots.txt. Para determinar si su URL está construida correctamente para prohibir que Googlebot acceda a ciertas secciones que desea ocultar, envíela a la herramienta de prueba.

¡Resumiendo!

Las herramientas enumeradas anteriormente hacen que la creación de un archivo robots.txt sea simple y rápida. Un sitio web saludable y con buen rendimiento, por otro lado, va más allá de robots.txt. Mejorar el SEO técnico es fundamental para darle a su sitio web la visibilidad que necesita y el éxito de SEO que se merece.