最高の無料Robots.txtジェネレータツール

公開: 2022-04-28あなたのウェブサイトに関しては、最善の(デジタル)足を前に出すことが重要です。 これは、サイトをクロールするときにGooglebotから一部のページを非表示にすることを意味する場合があります。 Robots.txtファイルを使用すると、幸いなことに、それを実行できます。 以下のセクションでは、robots.txtファイルの関連性と、無料のrobotstxtジェネレータツールを使用してファイルを作成する方法について説明します。

Robots.txtファイルとは何ですか?なぜ必要なのですか?

robots.txtファイルとは何か、そしてなぜそれが必要なのかを話してから、非常に便利な(そして無料の!)robots.txtジェネレーターツールをチェックしてください。

ウェブサイトに、Googlebotがクロールしたくないページや必要のないページがある可能性があります。 robots.txtファイルは、ウェブサイト上のどのページとファイルをクロールし、どれを無視するかをGoogleに指示します。 時間を節約するためのGooglebotのハウツーガイドと考えてください。

仕組みは次のとおりです

ロボットがhttp://www.coolwebsite.com/welcome.htmlなどのWebサイトのURLをクロールしようとしています。 まず、http://www.coolwebsite.com/robots.txtをスキャンして、次のものを見つけます。

禁止セクションは、検索ボットに一部のWebページまたはWebサイトの要素をクロールしないように通知します。

Robots.txtファイルの重要性は何ですか?

robots.txtファイルは、さまざまなSEOの目的に役立ちます。 手始めに、それはグーグルがあなたのサイトのどのページが他より重要であるかを素早くそして明確に決定することを可能にします。

Robots.txtファイルを使用すると、オーディオファイルなどのWebサイトの一部が検索結果に表示されないようにすることができます。 robots.txtファイルを使用してGoogleからページを隠すことはできませんが、クローラーのトラフィックを制御するために使用できることに注意してください。

Googleのクロール予算ガイダンスによると、Googleのクローラーがサーバーを圧倒したり、サイト上の重要でないページや同様のページをクロールするお金を浪費したりすることは望ましくありません。

Robots.txtファイルとは何ですか?どのように作成しますか?

Googleの場合、robots.txtファイルは指定された方法でフォーマットする必要があります。 特定のすべてのWebサイトで単一のrobots.txtファイルを使用できます。 最初に覚えておくべきことは、ドメインのrobots.txtファイルをルートディレクトリに配置する必要があるということです。

robots.txtファイルを手動で作成する方法の詳細については、GoogleSearchCentralにアクセスしてください。 無料で使用できるrobots.txtジェネレーターツールのトップ10のリストをまとめました。

10無料のRobots.txtジェネレータツール:

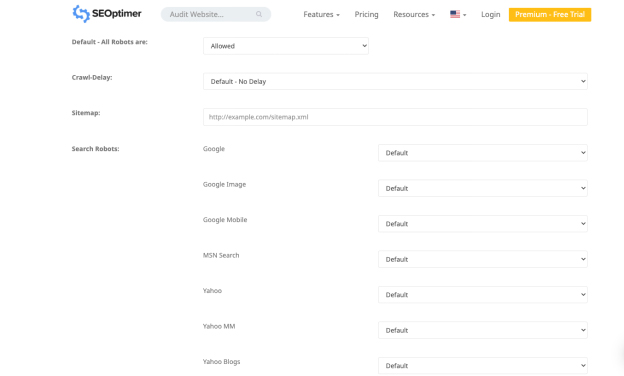

1.SEOオプティマー

Seo Optimerのアプリケーションを使用すると、robots.txtファイルを無料で作成できます。 このツールは、robots.txtファイルを無料で作成するための強力なインターフェイスを提供します。 クロール遅延期間と、サイトのクロールを許可または禁止するボットを選択できます。

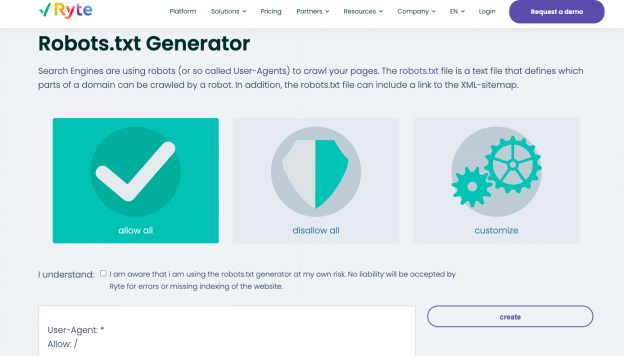

2.ライト

Ryteの無料ジェネレーターでrobots.txtファイルを生成するための3つのオプションは、すべて許可、すべて禁止、およびカスタマイズです。 ステップバイステップの説明を含むカスタマイズオプションを使用して、影響を与えるボットを選択できます。

Ryteは、SEO監査を実施して、Webサイトのコンテンツ、技術的および構造的なエラーを特定するのに役立ちます。 シングルクリックで分析を開始するか、頻繁なクロールをスケジュールして日付ストリームを自動化します。 15を超える構成でクロールをカスタマイズしたり、堅牢なAPIを使用してデータを通常のワークフローに直接統合したりできます。 このツールを使用すると、WebサイトのUXを向上させるために必要なすべての情報を取得できます。

Ryteのキーワードの推奨事項を使用して、魅力的なコンテンツを簡単に作成できます。これは、WebサイトをSERPの上部に表示するのに役立ちます。 キーワードの推奨事項を理解したら、構造化データとschema.orgタグを使用してWebコンテンツを変更できます。 完成したテキストをHTMLにエクスポートしてから、コピーしてCMSに貼り付けることができます。

3. Better Robots.txt(WordPress)

Better Robots.txt WordPressプラグインは、WebサイトのSEOと読み込み速度を向上させます。 有害なボットからデータとコンテンツを保護することができ、7つの言語で利用できます。 Better Robots.txtプラグインは、YoastSEOプラグインやその他のサイトマップジェネレーターと連携します。 プラグインは、現在Yoast SEOを使用しているかどうか、または他のサイトマップがWebサイトで利用可能かどうかを検出できます。 サイトマップを追加するには、サイトマップのURLをコピーして貼り付けるだけです。 次に、BetterRobots.txtがそれをRobots.txtファイルに追加します。

Better Robots.txtプラグインは、トレンドの悪いボットがクロールしてデータに影響を与えるのをブロックするのに役立ちます。 プラグインは、WordPressWebサイトをスクレーパーやスパイダーから保護します。 また、ツールによってブロックされた不良ボットのより包括的なリストを使用して、アップグレードと時間を提供します。

4. Virtual Robots.txt(WordPress)

WordPressプラグインVirtualRobots.txtは、ウェブサイトのrobots.txtファイルを作成および管理するための簡単で自動化されたソリューションです。 プラグインを最大限に活用する前に、プラグインをアップロードしてアクティブ化するだけです。

Virtual Robots.txtプラグインは、デフォルトでWordPress要素へのアクセスを提供します。これは、Googleなどの優れたブーツがアクセスする必要があります。 他のWordPressパーツはブロックされたままです。 プラグインが以前のXMLサイトマップファイルを検出すると、そのファイルへの参照がrobots.txtファイルに自動的に追加されます。

5.小さなSEOツール

robot.txtファイルを作成するためのもう1つの簡単なツールは、SmallSEOToolsの無料ジェネレーターです。 各ボットの設定に応じてドロップダウンメニューを利用します。 ボットごとに、許可するかどうかを選択できます。

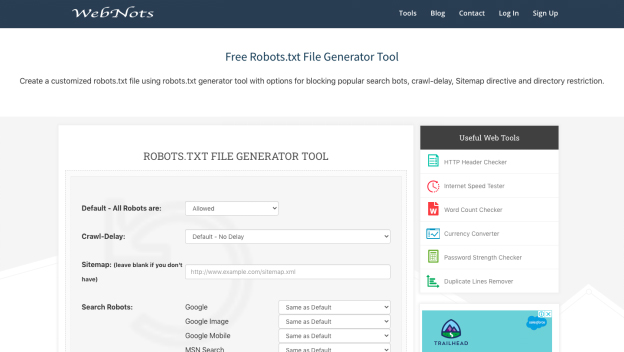

6.Webノート

外観が最小限であるため、Web Notsのrobots.txt生成ツールは、SmallSEOToolsのジェネレーターに似ています。 ドロップダウンメニューと制限されたディレクトリのセクションも含まれています。 終了したら、robots.txtファイルをダウンロードできます。

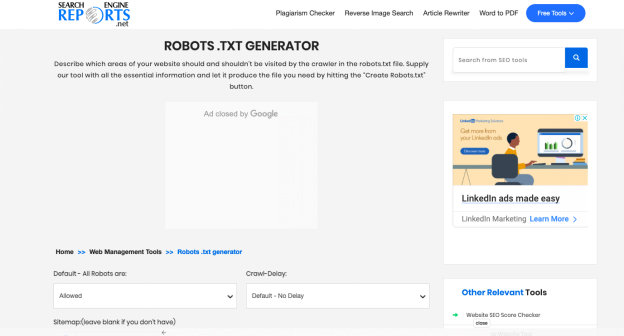

7.検索エンジンレポート

検索エンジンレポートのジェネレーターは、サイトマップと制限されたディレクトリのパーツを提供します。 この無料のアプリケーションは、robots.txtファイルをすばやく作成するための素晴らしい方法です。

検索エンジンレポートでは、一度に2000語を含むコンテンツをチェックします。 ボックスにコンテンツを貼り付けて、送信ボタンをクリックできます。 Dropboxとの統合により、このプラットフォームからコンテンツを直接アップロードできます。

検索エンジンレポートの[ファイルのアップロード]オプションをクリックして、システムに保存されているファイルをアップロードすることもできます。 オンライン盗用チェッカーを使用してボックスにURLを追加すると、ソフトウェアが詳細な操作を実行します。

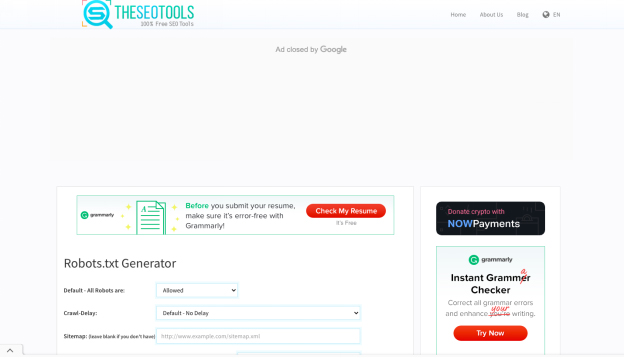

8.SEOツール

SEO Toolsの無料のrobots.txtジェネレーターは、Webサイト用のrobots.txtファイルを作成するための簡単で迅速な方法です。 必要に応じて、クロール遅延を定義し、サイトマップを入力できます。 必要なオプションの選択が完了したら、[作成してRobots.txtとして保存]をクリックします。

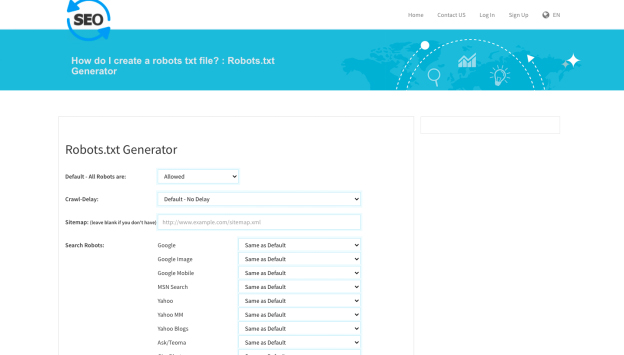

9.チェッカーへのSEO

robots.txtファイルを作成するためのもう1つの便利なツールは、SEOToCheckerのrobot.txtジェネレーターです。 すべての検索ロボットのオプションを調整して、サイトマップを追加できます。

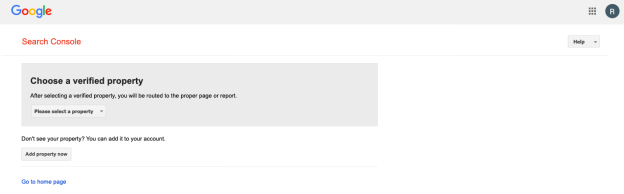

10. Google SearchConsoleRobots.txtテスター

robots.txtファイルを作成すると、Google検索コンソールのrobots.txtテスターを利用できます。 非表示にする特定のセクションからGooglebotを禁止するようにURLが適切に構成されているかどうかを判断するには、URLをテスターツールに送信します。

まとめて!

上記のツールを使用すると、robots.txtファイルを簡単かつ迅速に作成できます。 一方、健全でパフォーマンスの高いWebサイトは、robots.txtを超えています。 技術的なSEOを改善することは、Webサイトに必要な可視性と、それに値するSEOの成功をもたらすために重要です。