Die besten kostenlosen Robots.txt-Generator-Tools

Veröffentlicht: 2022-04-28Es ist entscheidend, dass Sie sich bei Ihrer Website von Ihrer besten (digitalen) Seite zeigen. Dies könnte bedeuten, dass einige Seiten vor dem Googlebot ausgeblendet werden, während er Ihre Website durchsucht. Robots.txt-Dateien ermöglichen Ihnen glücklicherweise genau das. In den folgenden Abschnitten gehen wir auf die Relevanz von robots.txt-Dateien ein und erläutern, wie sie mit kostenlosen robots.txt-Generator-Tools erstellt werden.

Was ist eine Robots.txt-Datei und warum brauche ich eine?

Lassen Sie uns darüber sprechen, was eine robots.txt-Datei ist und warum sie notwendig ist, bevor wir uns mit den unglaublich nützlichen (und kostenlosen!) robots.txt-Generator-Tools befassen, die Sie ausprobieren sollten.

Möglicherweise gibt es Seiten auf Ihrer Website, die der Googlebot nicht crawlen soll oder soll. Eine robots.txt-Datei teilt Google mit, welche Seiten und Dateien auf Ihrer Website gecrawlt und welche ignoriert werden sollen. Betrachten Sie es als eine Anleitung für den Googlebot, mit der Sie Zeit sparen können.

So funktioniert das

Ein Roboter möchte eine Website-URL wie http://www.coolwebsite.com/welcome.html crawlen. Zuerst scannt es nach http://www.coolwebsite.com/robots.txt und findet:

Der Disallow-Abschnitt informiert Such-Bots, einige Webseiten oder Elemente der Website nicht zu crawlen.

Welche Bedeutung hat eine Robots.txt-Datei?

Eine robots.txt-Datei ist für eine Vielzahl von SEO-Zwecken nützlich. Zunächst einmal ermöglicht es Google, schnell und eindeutig zu bestimmen, welche Seiten Ihrer Website wichtiger sind als andere.

Robots.txt-Dateien können verwendet werden, um zu verhindern, dass Aspekte einer Website, wie z. B. Audiodateien, in den Suchergebnissen angezeigt werden. Beachten Sie, dass eine robots.txt-Datei zwar nicht zum Verbergen von Seiten vor Google verwendet werden sollte, sie jedoch zur Kontrolle des Crawler-Verkehrs verwendet werden kann.

Gemäß der Anleitung zum Crawl-Budget von Google möchten Sie nicht, dass der Crawler von Google Ihren Server überlastet oder Crawl-Geld verschwendet, um unwichtige oder ähnliche Seiten auf Ihrer Website zu crawlen.

Was ist eine Robots.txt-Datei und wie erstelle ich eine?

Für Google müssen robots.txt-Dateien auf eine bestimmte Weise formatiert sein. Auf jeder Website ist eine einzige robots.txt-Datei zulässig. Das erste, woran Sie denken sollten, ist, dass die robots.txt-Datei Ihrer Domain im Stammverzeichnis abgelegt werden muss.

Ausführliche Anweisungen zum manuellen Erstellen von robots.txt-Dateien finden Sie in der Google-Suche-Zentrale. Wir haben eine Liste der 10 besten robots.txt-Generator-Tools zusammengestellt, die Sie kostenlos verwenden können!

10 kostenlose Robots.txt-Generator-Tools :

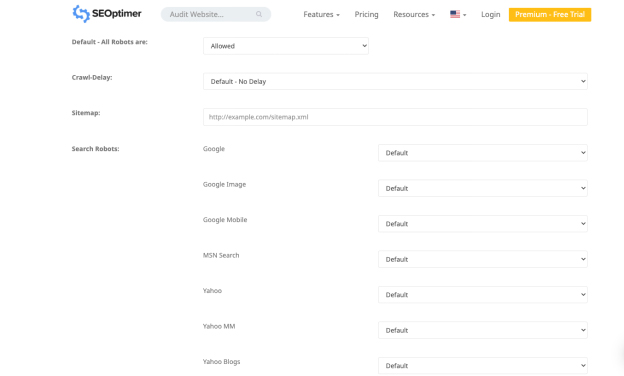

1. SEO-Optimierer

Mit der Anwendung von Seo Optimer können Sie kostenlos eine robots.txt-Datei erstellen. Das Tool bietet eine starke Schnittstelle, um kostenlos eine robots.txt-Datei zu erstellen. Sie können einen Zeitraum für die Crawling-Verzögerung auswählen und festlegen, welche Bots Ihre Website crawlen dürfen oder dürfen.

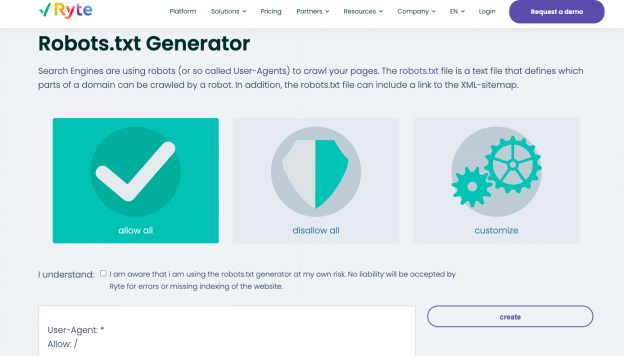

2. Ryte

Alle zulassen, alle verbieten und anpassen sind die drei Optionen zum Generieren einer robots.txt-Datei im kostenlosen Generator von Ryte. Sie können auswählen, welche Bots Sie mit der Anpassungsoption beeinflussen möchten, die Schritt-für-Schritt-Anleitungen enthält.

Ryte hilft Ihnen bei der Durchführung von SEO-Audits, um inhaltliche, technische und strukturelle Fehler Ihrer Website zu identifizieren. Starten Sie die Analyse mit einem einzigen Klick oder planen Sie häufige Crawls, um Datenströme zu automatisieren. Sie können das Crawling mit mehr als 15 Konfigurationen anpassen oder eine robuste API verwenden, um Daten direkt in Ihren regulären Workflow zu integrieren. Mit dem Tool erhalten Sie alle erforderlichen Informationen, um die UX Ihrer Website zu verbessern.

Mit den Keyword-Empfehlungen von Ryte können Sie ganz einfach faszinierende Inhalte erstellen, die Ihrer Website helfen, ganz oben in den SERPs angezeigt zu werden. Sobald Sie die Keyword-Empfehlungen verstanden haben, können Sie Ihre Webinhalte mit strukturierten Daten und schema.org-Tags ändern. Sie können den fertigen Text in HTML exportieren und dann kopieren und in Ihr CMS einfügen.

3. Bessere Robots.txt (WordPress)

Das Better Robots.txt WordPress-Plugin verbessert die SEO und Ladegeschwindigkeit Ihrer Website. Es kann Ihre Daten und Inhalte vor schädlichen Bots schützen und ist in sieben Sprachen verfügbar. Das bessere Robots.txt-Plugin funktioniert mit dem Yoast SEO-Plugin und anderen Sitemap-Generatoren. Das Plugin kann erkennen, ob Sie derzeit Yoast SEO verwenden oder ob andere Sitemaps auf Ihrer Website verfügbar sind. Um Ihre Sitemap hinzuzufügen, müssen Sie nur die Sitemap-URL kopieren und einfügen. Dann fügt Better Robots.txt es Ihrer Robots.txt-Datei hinzu.

Das Better Robots.txt-Plugin hilft Ihnen dabei, die trendigen bösartigen Bots daran zu hindern, zu crawlen und Ihre Daten zu beeinträchtigen. Das Plugin schützt Ihre WordPress-Website vor Scrapern und Spidern. Es bietet auch Upgrades und Zeit mit einer umfassenderen Liste von Bad Bots, die vom Tool blockiert werden.

4. Virtuelle Roboter.txt (WordPress)

Das WordPress-Plugin Virtual Robots.txt ist eine einfache und automatisierte Lösung zum Erstellen und Verwalten einer robots.txt-Datei für Ihre Website. Sie müssen das Plugin nur hochladen und aktivieren, bevor Sie es optimal nutzen können.

Das Virtual Robots.txt-Plugin bietet standardmäßig Zugriff auf die WordPress-Elemente, auf die gute Boots wie Google zugreifen müssen. Während die anderen WordPress-Teile blockiert bleiben. Wenn das Plugin eine frühere XML-Sitemap-Datei erkennt, wird der robots.txt-Datei automatisch ein Verweis darauf hinzugefügt.

5. Kleine SEO-Tools

Ein weiteres einfaches Tool zum Erstellen einer robot.txt-Datei ist der kostenlose Generator des kostenlosen Generators von Small SEO Tools. Es verwendet Dropdown-Menüs für die Einstellungen jedes Bots. Sie können für jeden Bot auswählen, ob er erlaubt ist oder nicht.

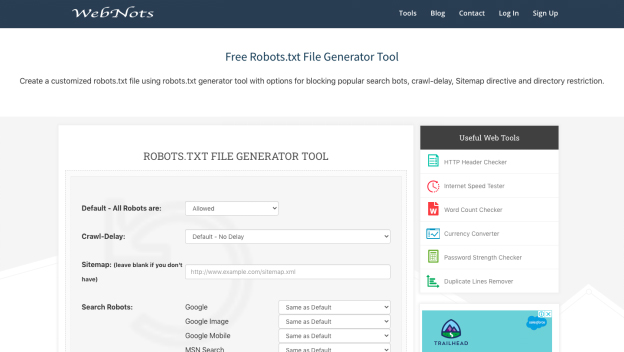

6. Webnotizen

Aufgrund seines minimalistischen Erscheinungsbilds ähnelt das robots.txt-Generierungstool von Web Nots dem Generator von Small SEO Tools. Es enthält auch Dropdown-Menüs und einen Abschnitt für eingeschränkte Verzeichnisse. Wenn Sie fertig sind, können Sie die robots.txt-Datei herunterladen.

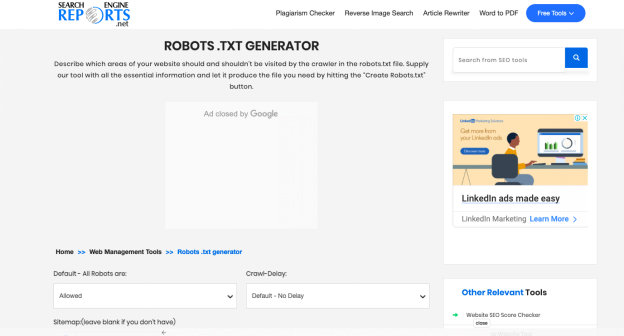

7. Suchmaschinenberichte

Der Generator in Search Engine Reports bietet Teile für Ihre Sitemap und alle eingeschränkten Verzeichnisse. Diese kostenlose Anwendung ist eine wunderbare Möglichkeit, schnell eine robots.txt-Datei zu erstellen.

Mit Suchmaschinenberichten überprüfen Sie einen Inhalt, der jeweils 2000 Wörter enthält. Sie können den Inhalt in das Feld einfügen und auf die Schaltfläche „Senden“ klicken. Die Integration mit Dropbox hilft Ihnen, Inhalte direkt von dieser Plattform hochzuladen.

Sie können die in Ihrem System gespeicherten Dateien auch hochladen, indem Sie bei den Suchmaschinenberichten auf die Option „Datei hochladen“ klicken. Sie können dem Feld mit der Online-Plagiatsprüfung eine URL hinzufügen, und die Software führt detaillierte Operationen aus.

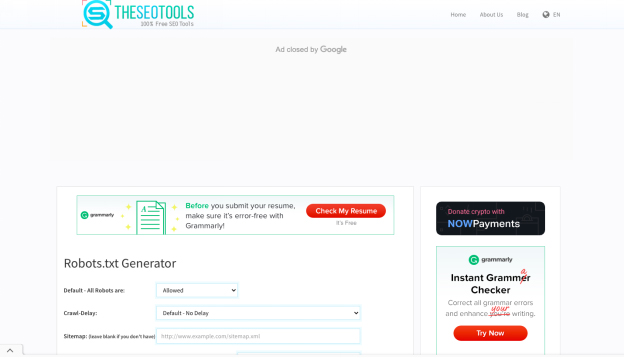

8. Die SEO-Tools

Der kostenlose robots.txt-Generator von SEO Tools ist eine einfache und schnelle Möglichkeit, eine robots.txt-Datei für Ihre Website zu erstellen. Wenn Sie möchten, können Sie eine Crawl-Verzögerung definieren und Ihre Sitemap eingeben. Wenn Sie mit der Auswahl der gewünschten Optionen fertig sind, klicken Sie auf „Create and Save as Robots.txt“.

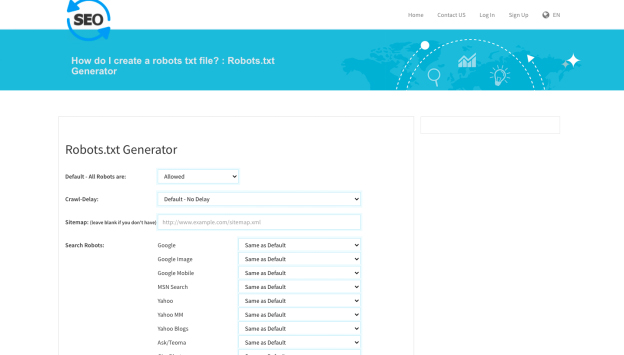

9. SEO zum Prüfer

Ein weiteres nützliches Tool zum Erstellen einer robots.txt-Datei ist der robot.txt-Generator von SEO To Checker. Sie können alle Optionen der Suchroboter anpassen und Ihre Sitemap hinzufügen.

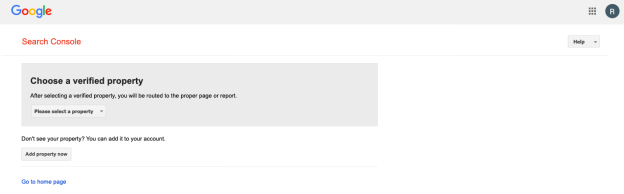

10. Google Search Console Robots.txt-Tester

Sie können den robots.txt-Tester der Google Search Console verwenden, sobald Sie eine robots.txt-Datei erstellt haben. Um festzustellen, ob Ihre URL richtig aufgebaut ist, um den Googlebot bestimmte Bereiche zu verbieten, die Sie ausblenden möchten, senden Sie sie an das Tester-Tool.

Zusammenfassend!

Die oben aufgeführten Tools machen das Erstellen einer robots.txt-Datei einfach und schnell. Eine gesunde, gut funktionierende Website hingegen geht über robots.txt hinaus. Die Verbesserung der technischen SEO ist entscheidend, um Ihrer Website die Sichtbarkeit zu verleihen, die sie benötigt, und den SEO-Erfolg, den sie verdient.