Rastreamento e indexação: tudo o que você precisa saber

Publicados: 2022-09-11O método de aumentar a qualidade e a quantidade de tráfego para o seu site é conhecido como SEO (Search Engine Optimization). É o processo de otimização de páginas da web para atingir classificações mais altas de pesquisa naturalmente. Você já se perguntou o que alimenta um mecanismo de pesquisa? É notável como alguns mecanismos podem varrer a World Wide Web de maneira sistemática para indexação da Web ou rastreamento da Web.

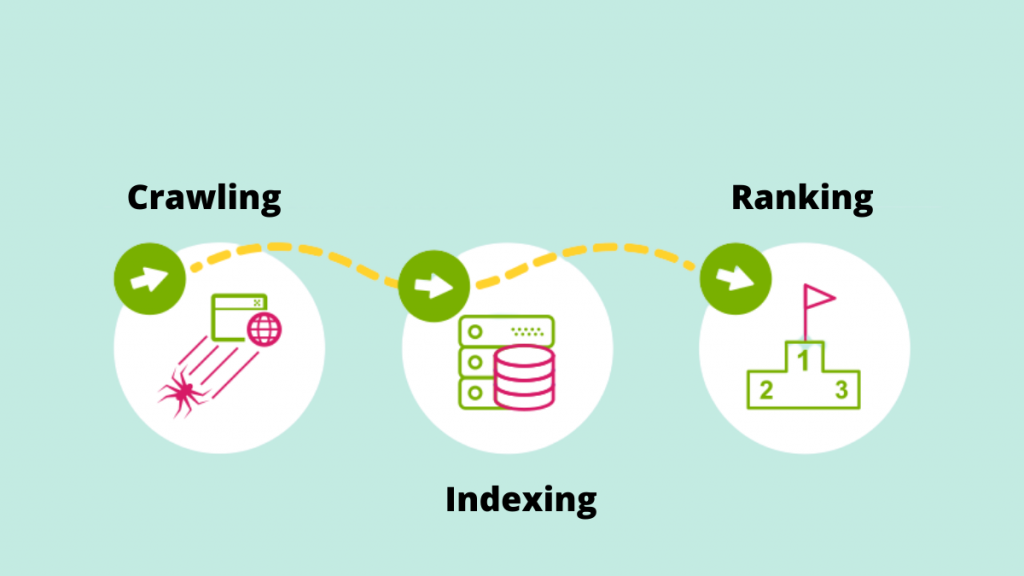

Vamos examinar mais de perto o papel fundamental do rastreamento e indexação na entrega de resultados de pesquisa à luz das crescentes tendências de SEO.

Rastejando

O rastreamento é o processo pelo qual os mecanismos de pesquisa empregam seus rastreadores da Web para detectar novos links, novos sites ou páginas de destino, atualizações para apresentar dados, links quebrados e outras coisas. Os rastreadores da Web também são chamados de “spiders”, “bots” ou “spiders”. Quando os bots visitam um site, eles usam os links internos para rastrear outras páginas do site.

Como resultado, um dos motivos mais importantes para facilitar o rastreamento do site pelo Google Bot é criar um mapa do site. Uma lista crucial de URLs pode ser encontrada no mapa do site.

Ex: https://iquelab.in/sitemap_index.xml

O Modelo DOM é usado pelo bot sempre que ele explora o site ou páginas da Web (Document Object Model). Este DOM reflete a estrutura de árvore lógica do site.

O código HTML e Javascript renderizado da página é chamado de DOM. Seria praticamente impossível rastrear todo o site de uma só vez e levaria muito tempo. Como resultado, o Google Bot rastreia apenas as áreas mais importantes do site, que são comparativamente importantes para medir estatísticas específicas que podem ajudar a classificar esses sites.

Otimize o site para o rastreador do Google

Às vezes nos deparamos com situações em que o Google Crawler não está indexando determinadas páginas importantes em um site. Como resultado, devemos instruir o mecanismo de pesquisa sobre como rastrear o site. Para isso, gere um arquivo robots.txt e armazene-o no diretório raiz do domínio.

O arquivo Robots.txt ajuda o rastreador a rastrear sistematicamente a página da web. O arquivo robots.txt instrui os rastreadores sobre quais URLs devem ser rastreados. Se o bot não conseguir localizar o arquivo robots.txt, ele continuará seu trabalho de rastreamento. Ele também ajuda no gerenciamento do orçamento de rastreamento do site.

Elementos que afetam o rastreamento

Como as páginas de login são páginas seguras, um bot não rastreia o material por trás dos formulários de login ou se algum site exigir que os usuários façam login.

As informações da caixa de pesquisa no site não são rastreadas pelo Googlebot. Muitas pessoas acreditam que quando um cliente digita o produto desejado na caixa de pesquisa, o rastreador do Google rastreia o site. Isso é especialmente verdadeiro para sites de comércio eletrônico.

Não há garantia de que o bot rastreará tipos de mídia, como fotografias, áudios, vídeos, texto e assim por diante. O método recomendado é incluir o texto (como um nome de imagem) no código HTML>.

Camuflagem para os robôs do mecanismo de pesquisa  é a manifestação de sites para determinados visitantes (por exemplo, Páginas vistas para o bot são distintas de Usuários).

é a manifestação de sites para determinados visitantes (por exemplo, Páginas vistas para o bot são distintas de Usuários).

Os rastreadores de mecanismos de pesquisa podem ocasionalmente notar um link para seu site de outros sites na Internet. Da mesma forma, o rastreador depende dos links do seu site para navegar para diferentes sites de destino.

Páginas órfãs são aquelas que não possuem links internos atribuídos a elas, pois os rastreadores não conseguem encontrar uma maneira de acessá-las. Eles também são quase invisíveis para o bot enquanto ele rastreia o site.

Quando os rastreadores encontram 'erros de rastreamento' em um site, como 404, 500 e outros, ficam frustrados e abandonam a página. A recomendação é usar um '302 – redirecionamento' ou um '301 – redirecionamento permanente' para redirecionar temporariamente as páginas da web. É fundamental colocar a ponte para os rastreadores do mecanismo de pesquisa.

Poucos dos rastreadores da Web são –

Googlebot

O Googlebot é um rastreador da Web (às vezes conhecido como aranha ou robô) que rastreia e indexa sites para o Google. Ele apenas recupera o texto pesquisável nos sites sem fazer nenhum julgamento. O nome refere-se a dois tipos de rastreadores da Web: um para desktop e outro para dispositivos móveis.

Bingbot

A Microsoft lançou o Bingbot, uma espécie de bot de internet, em outubro de 2010. Ele funciona da mesma forma que o Googlebot, coletando documentos de sites para fornecer informações pesquisáveis para os SERPs.

Slurp Bot

As descobertas do rastreador da web do Yahoo são geradas pelo bot Slurp. Ele reúne informações do site do parceiro e adapta o material para o mecanismo de busca do Yahoo. Essas páginas de rastreamento verificam a autenticação do usuário em várias páginas da web.

Baiduspider

A aranha do Baidu é o robô do mecanismo de busca chinês. O bot é um software que, como todos os rastreadores, coleta informações relevantes para a consulta do usuário. Ele rastreia e indexa as páginas da web da Internet gradualmente.

Bot Yandex

Yandex é um mecanismo de pesquisa russo e o rastreador de um mecanismo de pesquisa com o mesmo nome. Da mesma forma, o bot Yandex rastreia a página regularmente e registra os dados pertinentes no banco de dados. Ele ajuda na geração de resultados de pesquisa amigáveis. O Yandex é o quinto maior mecanismo de busca do mundo, com 60% de participação de mercado na Rússia.

Agora vamos avançar para entender como o Google indexa as páginas.

Indexação

O índice é uma coleção de todos os dados ou páginas indexadas pelo rastreador do mecanismo de pesquisa. O processo de indexação é o processo de armazenamento do material obtido em um banco de dados de índice de busca. Os dados salvos anteriormente são avaliados para métricas de algoritmo de SEO em comparação com páginas semelhantes usando dados indexados. A importância da indexação não pode ser exagerada porque ajuda na classificação de um site.

Como você pode saber o que o Google indexou?

Para ver quantas páginas estão indexadas na SERP, digite “site:seudominio” na caixa de pesquisa. Isso exibirá todas as páginas que o Google indexou, incluindo páginas, artigos e fotos, entre outras coisas.

A maneira mais fácil de garantir que os URLs sejam indexados é enviar um mapa do site ao Google Search Console, que contém uma lista de todas as páginas importantes.

Quando se trata de apresentar todas as páginas importantes da SERP, a indexação do site é crucial. Se o Googlebot não conseguir ver o material, ele não será indexado. O Googlebot analisa todo o site em vários formatos, como HTML, CSS e Javascript. A indexação não será executada em componentes que não estão acessíveis.

Como o Google decide o que indexar?

Quando um usuário digita uma consulta no Google, ele tenta encontrar a resposta mais relevante nos sites indexados do banco de dados. O Google indexa informações usando seu próprio conjunto de algoritmos. Normalmente, ele indexa novo conteúdo em um site que o Google acredita que melhoraria a experiência do usuário. Quanto maior a qualidade do conteúdo e quanto maior a qualidade dos links no site, melhor para o SEO.

Identificar como nossos sites chegam aos processos de indexação.

Versão em cache

O Google rastreia as páginas do site regularmente. Clique no sinal 'drop-down' ao lado do URL para ver a versão em cache da página da web (conforme mostrado na captura de tela abaixo).

URLs eliminados

SIM! Depois de serem indexadas no SERP, as páginas da web podem ser removidas. É possível que sites removidos estejam retornando erros 404, redirecionando URLs ou com links quebrados, entre outras coisas. Uma tag 'noindex' também seria adicionada aos URLs.

Metatags

Localizado no código HTML da seção <head> do site.

- Índice, sem índice

Esta função indica ao rastreador do motor de busca se as páginas devem ou não ser indexadas. O bot o trata como uma função de 'índice' por padrão. Ao selecionar 'noindex', você está instruindo os rastreadores a remover as páginas da SERP.

- Seguir/não seguir

Permite que o rastreador do mecanismo de pesquisa determine quais páginas devem ser monitoradas e quanto valor do link deve ser passado.

Aqui está o código de exemplo

< head >< meta name =”robots” content=”noindex, nofollow” /></ head >

Depois de reunir todas as informações necessárias, use os serviços avançados de SEO fornecidos pela agência líder de SEO de Kerala para otimizar seu site. Participe da conversa na seção de comentários abaixo.