Rastreo e indexación: todo lo que necesita saber

Publicado: 2022-09-11El método para aumentar la calidad y la cantidad de tráfico a su sitio web se conoce como SEO (Search Engine Optimization). Es el proceso de optimización de páginas web para alcanzar rangos de búsqueda más altos de forma natural. ¿Alguna vez te has preguntado qué impulsa un motor de búsqueda? Es notable cómo algunos mecanismos pueden escanear la World Wide Web de manera sistemática para la indexación web o el rastreo web.

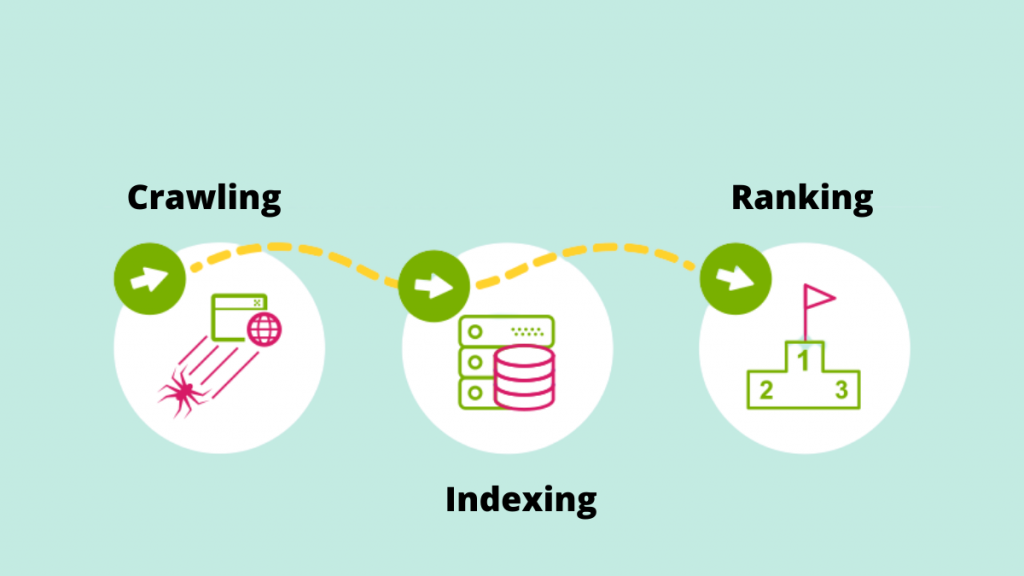

Echemos un vistazo más de cerca al papel fundamental del rastreo y la indexación en la entrega de resultados de búsqueda a la luz de las tendencias de SEO en constante aumento.

gateando

El rastreo es el proceso mediante el cual los motores de búsqueda emplean sus rastreadores web para detectar nuevos enlaces, nuevos sitios web o páginas de destino, actualizaciones de datos actuales, enlaces rotos y otras cosas. Los rastreadores web también se denominan "arañas", "bots" o "arañas". Cuando los bots visitan un sitio web, utilizan los enlaces internos para rastrear otras páginas del sitio.

Como resultado, una de las razones más importantes para facilitar que Google Bot rastree el sitio web es crear un mapa del sitio. Se puede encontrar una lista crucial de URL en el mapa del sitio.

Ej: https://iquelab.in/sitemap_index.xml

El modelo DOM es utilizado por el bot cada vez que explora el sitio web o las páginas web (modelo de objetos de documento). Este DOM refleja la estructura de árbol lógica del sitio web.

El código HTML y Javascript renderizado de la página se denomina DOM. Sería prácticamente imposible rastrear todo el sitio web a la vez y llevaría mucho tiempo. Como resultado, Google Bot solo rastrea las áreas más importantes del sitio, que son comparativamente importantes para medir estadísticas específicas que podrían ayudar a clasificar esos sitios web.

Optimizar sitio web para Google Crawler

A veces nos encontramos con situaciones en las que Google Crawler no está indexando ciertas páginas importantes en un sitio web. Como resultado, debemos indicarle al motor de búsqueda cómo rastrear el sitio. Para hacerlo, genere un archivo robots.txt y guárdelo en el directorio raíz del dominio.

El archivo Robots.txt ayuda al rastreador a rastrear sistemáticamente la página web. El archivo robots.txt indica a los rastreadores qué URL deben rastrearse. Si el bot no puede localizar el archivo robots.txt, continuará con su trabajo de rastreo. También ayuda en la gestión del presupuesto de rastreo del sitio web.

Elementos que afectan al Crawling

Debido a que las páginas de inicio de sesión son páginas seguras, un bot no rastrea el material detrás de los formularios de inicio de sesión o si algún sitio web requiere que los usuarios inicien sesión.

Googlebot no rastrea la información del cuadro de búsqueda del sitio. Mucha gente cree que cuando un cliente escribe su producto deseado en el cuadro de búsqueda, el rastreador de Google rastrea el sitio. Esto es especialmente cierto para los sitios web de comercio electrónico.

No hay garantía de que el bot rastree tipos de medios como fotografías, audios, videos, texto, etc. El método recomendado es incluir el texto (como nombre de una imagen) en el código HTML>.

Encubrimiento de los bots de los motores de búsqueda  es la manifestación de sitios web para ciertos visitantes (por ejemplo, las páginas vistas por el bot son distintas de los usuarios).

es la manifestación de sitios web para ciertos visitantes (por ejemplo, las páginas vistas por el bot son distintas de los usuarios).

Ocasionalmente, los rastreadores de motores de búsqueda pueden notar un enlace a su sitio web desde otros sitios web en Internet. De manera similar, el rastreador se basa en los enlaces de su sitio para navegar a diferentes sitios de destino.

Las páginas huérfanas son aquellas que no tienen ningún enlace interno asignado, ya que los rastreadores no pueden encontrar la manera de llegar a ellas. También son casi invisibles para el bot mientras rastrea el sitio.

Cuando los rastreadores encuentran "errores de rastreo" en un sitio web, como 404, 500 y otros, se sienten frustrados y abandonan la página. La recomendación es utilizar un '302 - redirección' o un '301 - redirección permanente' para redirigir temporalmente las páginas web. Es fundamental colocar el puente para los rastreadores de los motores de búsqueda.

Algunos de los rastreadores web son:

Robot de Google

Googlebot es un rastreador web (a veces conocido como araña o robot) que rastrea e indexa sitios web para Google. Simplemente recupera el texto de búsqueda en los sitios web sin hacer ningún juicio. El nombre se relaciona con dos tipos de rastreadores web: uno para escritorio y otro para dispositivos móviles.

Bingbot

Microsoft lanzó Bingbot, una especie de bot de Internet, en octubre de 2010. Funciona de la misma manera que Googlebot, recopilando documentos de sitios web para proporcionar información de búsqueda para los SERP.

Sorber robot

Los hallazgos del rastreador web de Yahoo son generados por el bot Slurp. Recopila información del sitio web del socio y adapta el material para el motor de búsqueda de Yahoo. Estas páginas de rastreo verifican la autenticación del usuario en varias páginas web.

Baiduspider

La araña de Baidu es el robot del motor de búsqueda chino. El bot es una pieza de software que, como todos los rastreadores, recopila información relevante para la consulta del usuario. Rastrea e indexa las páginas web de Internet gradualmente.

Robot Yandex

Yandex es un motor de búsqueda ruso y el rastreador de un motor de búsqueda con el mismo nombre. De manera similar, el bot de Yandex rastrea la página regularmente y registra los datos pertinentes en la base de datos. Ayuda en la generación de resultados de búsqueda fáciles de usar. Yandex es el quinto motor de búsqueda más grande del mundo, con una participación de mercado del 60 por ciento en Rusia.

Ahora avancemos para comprender cómo Google indexa las páginas.

Indexación

El índice es una colección de todos los datos o páginas indexadas por el rastreador del motor de búsqueda. El proceso de indexación es el proceso de almacenar el material obtenido en una base de datos de índice de búsqueda. Los datos guardados previamente se evalúan luego con las métricas del algoritmo SEO en comparación con páginas similares que utilizan datos indexados. La importancia de la indexación no se puede exagerar porque ayuda en la clasificación de un sitio web.

¿Cómo puedes saber lo que Google ha indexado?

Para ver cuántas páginas están indexadas en SERP, escriba "sitio: su dominio" en el cuadro de búsqueda. Esto mostrará todas las páginas que Google ha indexado, incluidas páginas, artículos y fotos, entre otras cosas.

La forma más fácil de asegurarse de que las URL estén indexadas es enviar un mapa del sitio a Google Search Console, que contiene una lista de todas las páginas importantes.

Cuando se trata de presentar todas las páginas importantes en SERP, la indexación del sitio web es crucial. Si Googlebot no puede ver el material, no se indexará. Googlebot analiza todo el sitio web en varios formatos, como HTML, CSS y Javascript. La indexación no se realizará en componentes que no sean accesibles.

¿Cómo decide Google qué indexar?

Cuando un usuario escribe una consulta en Google, intenta encontrar la respuesta más relevante de los sitios indexados de la base de datos. Google indexa la información utilizando su propio conjunto de algoritmos. Por lo general, indexa contenido nuevo en un sitio web que Google cree que mejoraría la experiencia del usuario. Cuanto mayor sea la calidad del contenido y la calidad de los enlaces en el sitio web, mejor para el SEO.

Identificar cómo nuestros sitios web llegan a los procesos de indexación.

Versión en caché

Google rastrea las páginas del sitio de forma regular. Haga clic en el signo 'desplegable' junto a la URL para ver la versión en caché de la página web (como se muestra en la captura de pantalla a continuación).

URL eliminadas

¡SÍ! Después de indexarse en SERP, las páginas web se pueden eliminar. Es posible que los sitios web eliminados devuelvan errores 404, tengan URL redirigidas o tengan enlaces rotos, entre otras cosas. También se agregaría una etiqueta 'noindex' a las URL.

Etiquetas meta

Ubicado en el código HTML de la sección <head> del sitio.

- índice, sin índice

Esta función indica al rastreador del motor de búsqueda si las páginas deben indexarse o no. El bot lo trata como una función de "índice" de forma predeterminada. Cuando selecciona 'noindex', está instruyendo a los rastreadores para que eliminen las páginas del SERP.

- Seguir/no seguir

Permite que el rastreador del motor de búsqueda determine qué páginas deben monitorearse y cuánto valor de enlace debe transmitirse.

Aquí está el código de muestra

< cabeza >< meta nombre =”robots” content=”noindex, nofollow” /></ cabeza >

Una vez que haya recopilado toda la información necesaria, utilice los servicios avanzados de SEO proporcionados por la agencia líder de SEO de Kerala para optimizar su sitio web. Únase a la conversación en la sección de comentarios a continuación.