Crawling & Indizierung: Alles, was Sie wissen müssen

Veröffentlicht: 2022-09-11Die Methode zur Steigerung der Qualität und Quantität des Traffics auf Ihrer Website wird als SEO (Search Engine Optimization) bezeichnet. Es ist der Prozess der Optimierung von Webseiten, um auf natürliche Weise höhere Suchränge zu erreichen. Haben Sie sich jemals gefragt, was eine Suchmaschine antreibt? Es ist bemerkenswert, wie einige Mechanismen das World Wide Web systematisch nach Web-Indexierung oder Web-Crawling durchsuchen können.

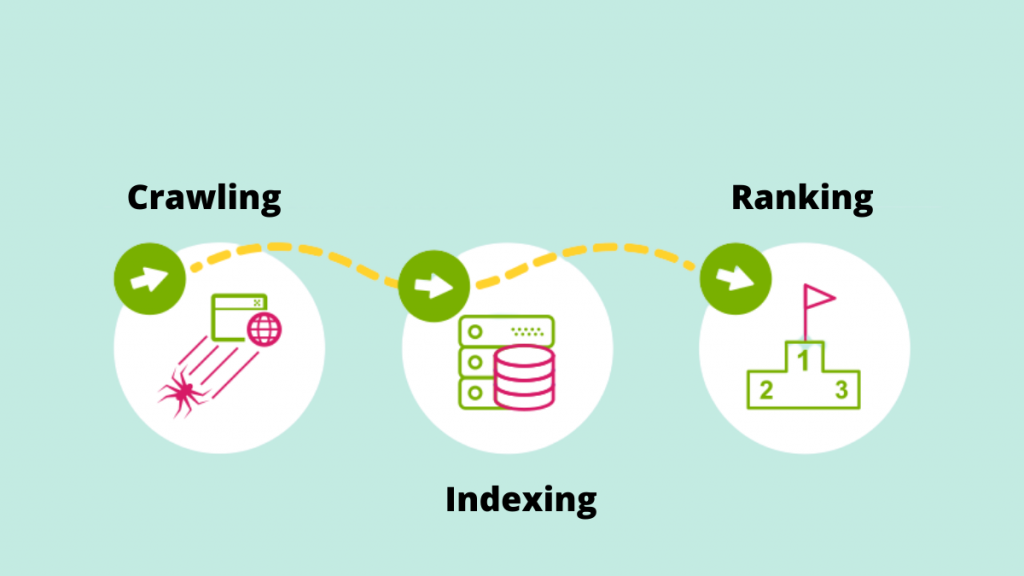

Lassen Sie uns einen genaueren Blick auf die grundlegende Rolle von Crawling & Indexing bei der Bereitstellung von Suchergebnissen angesichts der ständig zunehmenden SEO-Trends werfen.

Krabbeln

Crawling ist der Prozess, bei dem Suchmaschinen ihre Web-Crawler einsetzen, um neue Links, neue Websites oder Zielseiten, Aktualisierungen von aktuellen Daten, defekte Links und andere Dinge zu erkennen. Webcrawler werden auch als „Spider“, „Bots“ oder „Spider“ bezeichnet. Wenn Bots eine Website besuchen, verwenden sie die internen Links, um andere Seiten auf der Website zu crawlen.

Daher ist das Erstellen einer Sitemap einer der wichtigsten Gründe, um dem Google Bot das Crawlen der Website zu erleichtern. Eine wichtige Liste von URLs finden Sie in der Sitemap.

Beispiel: https://iquelab.in/sitemap_index.xml

Das DOM-Modell wird vom Bot immer dann verwendet, wenn er die Website oder Webseiten durchsucht (Document Object Model). Dieses DOM spiegelt die logische Baumstruktur der Website wider.

Der gerenderte HTML- und Javascript-Code der Seite wird als DOM bezeichnet. Es wäre praktisch unmöglich, die gesamte Website auf einmal zu crawlen, und es würde lange dauern. Infolgedessen crawlt der Google Bot nur die wichtigsten Bereiche der Website, die vergleichsweise wichtig sind, um spezifische Statistiken zu messen, die beim Ranking dieser Websites helfen könnten.

Website für Google Crawler optimieren

Manchmal stoßen wir auf Situationen, in denen Google Crawler bestimmte wichtige Seiten einer Website nicht indiziert. Infolgedessen müssen wir die Suchmaschine anweisen, wie die Website gecrawlt werden soll. Generieren Sie dazu eine robots.txt-Datei und speichern Sie diese im Root-Verzeichnis der Domain.

Die Robots.txt-Datei unterstützt den Crawler beim systematischen Crawlen der Webseite. Die robots.txt-Datei weist Crawler an, welche URLs gecrawlt werden sollen. Wenn der Bot die robots.txt-Datei nicht finden kann, setzt er seinen Crawling-Job fort. Es hilft auch bei der Verwaltung des Crawl-Budgets der Website.

Elemente, die das Krabbeln beeinflussen

Da Anmeldeseiten gesicherte Seiten sind, crawlt ein Bot nicht das Material hinter den Anmeldeformularen oder wenn sich eine Website von Benutzern anmelden muss.

Die Suchfeldinformationen auf der Website werden nicht vom Googlebot gecrawlt. Viele Leute glauben, dass der Google-Crawler die Website crawlt, wenn ein Kunde sein gewünschtes Produkt in das Suchfeld eingibt. Dies gilt insbesondere für E-Commerce-Websites.

Es gibt keine Garantie dafür, dass der Bot Medientypen wie Fotos, Audios, Videos, Text usw. crawlt. Die empfohlene Methode besteht darin, den Text (als Bildnamen) in den HTML>-Code aufzunehmen.

Tarnung vor den Suchmaschinen-Bots  ist die Manifestation von Websites für bestimmte Besucher (z. B. Seiten, die der Bot sieht, unterscheiden sich von Benutzern).

ist die Manifestation von Websites für bestimmte Besucher (z. B. Seiten, die der Bot sieht, unterscheiden sich von Benutzern).

Suchmaschinen-Crawler können gelegentlich einen Link zu Ihrer Website von anderen Websites im Internet bemerken. Ebenso verlässt sich der Crawler auf die Links Ihrer Website, um zu verschiedenen Zielseiten zu navigieren.

Verwaiste Seiten sind solche, denen keine internen Links zugewiesen sind, da Crawler keinen Weg finden, zu ihnen zu gelangen. Sie sind auch für den Bot fast unsichtbar, während er die Website durchsucht.

Wenn Crawler auf einer Website auf „Crawling-Fehler“ wie 404, 500 und andere stoßen, sind sie frustriert und verlassen die Seite. Es wird empfohlen, entweder eine „302 – Umleitung“ oder eine „301 – permanente Umleitung“ zu verwenden, um die Webseiten vorübergehend umzuleiten. Es ist wichtig, die Brücke für Suchmaschinen-Crawler zu platzieren.

Nur wenige der Web Crawler sind –

Googlebot

Googlebot ist ein Web-Crawler (manchmal auch als Spider oder Robot bezeichnet), der Websites für Google crawlt und indexiert. Es ruft nur den durchsuchbaren Text auf den Websites ab, ohne irgendwelche Urteile zu fällen. Der Name bezieht sich auf zwei Arten von Webcrawlern: einen für Desktop- und einen für mobile Geräte.

Binbot

Microsoft hat im Oktober 2010 Bingbot, eine Art Internet-Bot, auf den Markt gebracht. Er funktioniert auf die gleiche Weise wie der Googlebot und sammelt Dokumente von Websites, um durchsuchbare Informationen für die SERPs bereitzustellen.

Slurp-Bot

Die Ergebnisse des Yahoo-Webcrawlers werden vom Slurp-Bot generiert. Es sammelt Informationen von der Website des Partners und passt das Material für die Suchmaschine von Yahoo an. Diese Crawling-Seiten überprüfen die Benutzerauthentifizierung über mehrere Webseiten hinweg.

Baiduspinne

Baidus Spinne ist der Roboter der chinesischen Suchmaschine. Der Bot ist eine Software, die wie alle Crawler Informationen sammelt, die für die Anfrage des Benutzers relevant sind. Es durchsucht und indiziert die Webseiten des Internets nach und nach.

Yandex-Bot

Yandex ist eine russische Suchmaschine und der Crawler für eine gleichnamige Suchmaschine. Ebenso durchsucht der Yandex-Bot die Seite regelmäßig und zeichnet die relevanten Daten in der Datenbank auf. Es hilft bei der Generierung von benutzerfreundlichen Suchergebnissen. Yandex ist die fünftgrößte Suchmaschine der Welt mit einem Marktanteil von 60 Prozent in Russland.

Lassen Sie uns nun fortfahren, um zu verstehen, wie Google die Seiten indiziert.

Indizierung

Der Index ist eine Sammlung aller Daten oder Seiten, die vom Suchmaschinen-Crawler indexiert wurden. Der Prozess der Indexierung ist der Prozess der Speicherung des erhaltenen Materials in einer Suchindexdatenbank. Die zuvor gespeicherten Daten werden dann anhand von SEO-Algorithmus-Metriken mit ähnlichen Seiten unter Verwendung von indizierten Daten verglichen. Die Bedeutung der Indizierung kann nicht genug betont werden, da sie das Ranking einer Website unterstützt.

Wie können Sie wissen, was Google indiziert hat?

Um zu sehen, wie viele Seiten im SERP indexiert sind, geben Sie „site:yourdomain“ in das Suchfeld ein. Dadurch werden alle Seiten angezeigt, die Google indiziert hat, darunter unter anderem Seiten, Artikel und Fotos.

Der einfachste Weg, um sicherzustellen, dass URLs indexiert sind, besteht darin, eine Sitemap an die Google Search Console zu senden, die eine Liste aller wichtigen Seiten enthält.

Wenn es darum geht, alle wichtigen Seiten in den SERPs darzustellen, ist die Website-Indexierung von entscheidender Bedeutung. Wenn der Googlebot das Material nicht sehen kann, wird es nicht indexiert. Der Googlebot parst die gesamte Website in verschiedene Formate wie HTML, CSS und Javascript. Auf Komponenten, auf die nicht zugegriffen werden kann, wird keine Indizierung durchgeführt.

Wie entscheidet Google, was indexiert wird?

Wenn ein Benutzer eine Suchanfrage in Google eingibt, versucht es, die relevanteste Antwort von den indizierten Websites der Datenbank zu finden. Google indiziert Informationen mit eigenen Algorithmen. Es indiziert normalerweise neue Inhalte auf einer Website, von denen Google glaubt, dass sie die Benutzererfahrung verbessern würden. Je höher die Qualität der Inhalte und je höher die Qualität der Links auf der Website, desto besser für SEO.

Identifizieren, wie unsere Websites zu den Indexierungsprozessen gelangen.

Zwischengespeicherte Version

Google crawlt die Seiten der Website regelmäßig. Klicken Sie auf das „Dropdown“-Zeichen neben der URL, um die zwischengespeicherte Version der Webseite anzuzeigen (wie im Screenshot unten gezeigt).

URLs eliminiert

JAWOHL! Nachdem sie auf SERP indexiert wurden, können Webseiten entfernt werden. Es ist möglich, dass entfernte Websites unter anderem 404-Fehler zurückgeben, umgeleitete URLs oder fehlerhafte Links aufweisen. Den URLs würde außerdem ein „noindex“-Tag hinzugefügt.

Meta-Tags

Befindet sich im HTML-Code des Abschnitts <head> der Site.

- Index, kein Index

Diese Funktion zeigt dem Suchmaschinen-Crawler an, ob die Seiten indexiert werden sollen oder nicht. Der Bot behandelt sie standardmäßig als „Index“-Funktion. Wenn Sie „noindex“ auswählen, weisen Sie Crawler an, die Seiten aus den SERPs zu entfernen.

- Folgen/nicht folgen

Ermöglicht dem Suchmaschinen-Crawler zu bestimmen, welche Seiten überwacht werden sollen und wie viel Link-Equity weitergegeben werden soll.

Hier ist der Beispielcode

< Kopf >< Metaname = „Roboter“ Inhalt = „ noindex , nofollow“ /></ Kopf >

Nachdem Sie alle notwendigen Informationen gesammelt haben, nutzen Sie die fortschrittlichen SEO-Services von Keralas führender SEO-Agentur, um Ihre Website zu optimieren. Beteiligen Sie sich an der Unterhaltung im Kommentarbereich unten.