Exploration et indexation : tout ce que vous devez savoir

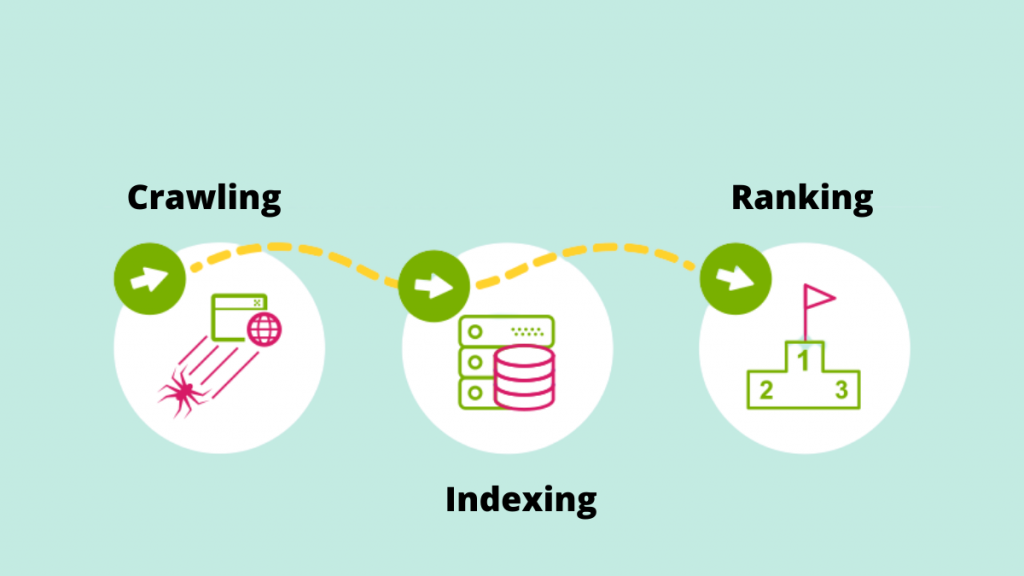

Publié: 2022-09-11La méthode pour augmenter la qualité et la quantité de trafic vers votre site Web est connue sous le nom de SEO (Search Engine Optimization). C'est le processus d'optimisation des pages Web pour atteindre naturellement des classements de recherche plus élevés. Vous êtes-vous déjà demandé ce qui alimente un moteur de recherche ? Il est remarquable de voir comment certains mécanismes peuvent analyser le World Wide Web de manière systématique pour l'indexation ou l'exploration du Web.

Examinons de plus près le rôle fondamental de l'exploration et de l'indexation dans la fourniture de résultats de recherche à la lumière des tendances SEO en constante augmentation.

Rampant

L'exploration est le processus par lequel les moteurs de recherche utilisent leurs robots d'exploration Web pour détecter de nouveaux liens, de nouveaux sites Web ou de nouvelles pages de destination, des mises à jour des données actuelles, des liens rompus et d'autres choses. Les robots d'exploration Web sont également appelés "araignées", "bots" ou "araignées". Lorsque les robots visitent un site Web, ils utilisent les liens internes pour explorer d'autres pages du site.

Par conséquent, l'une des raisons les plus importantes pour faciliter l'exploration du site Web par Google Bot est de créer un sitemap. Une liste cruciale d'URL peut être trouvée dans le plan du site.

Ex : https://iquelab.in/sitemap_index.xml

Le modèle DOM est utilisé par le bot chaque fois qu'il explore le site Web ou les pages Web (Document Object Model). Ce DOM reflète l'arborescence logique du site.

Le code HTML et Javascript rendu de la page est appelé DOM. Il serait pratiquement impossible d'explorer l'intégralité du site Web en une seule fois, et cela prendrait beaucoup de temps. En conséquence, Google Bot n'explore que les zones les plus importantes du site, qui sont relativement importantes pour mesurer des statistiques spécifiques qui pourraient aider à classer ces sites Web.

Optimiser le site Web pour Google Crawler

Parfois, nous rencontrons des situations où Google Crawler n'indexe pas certaines pages importantes sur un site Web. Par conséquent, nous devons indiquer au moteur de recherche comment explorer le site. Pour ce faire, générez un fichier robots.txt et stockez-le dans le répertoire racine du domaine.

Le fichier Robots.txt aide le robot à explorer systématiquement la page Web. Le fichier robots.txt indique aux robots d'exploration sur quelles URL doivent être explorées. Si le bot ne parvient pas à localiser le fichier robots.txt, il poursuivra son travail d'exploration. Il aide également à la gestion du budget de crawl du site Web.

Éléments affectant le Crawling

Étant donné que les pages de connexion sont des pages sécurisées, un bot n'explore pas le matériel derrière les formulaires de connexion ou si un site Web exige que les utilisateurs se connectent.

Les informations du champ de recherche sur le site ne sont pas explorées par Googlebot. De nombreuses personnes pensent que lorsqu'un client tape le produit souhaité dans le champ de recherche, le robot d'exploration Google explore le site. Cela est particulièrement vrai pour les sites de commerce électronique.

Il n'y a aucune garantie que le bot explorera des types de médias tels que des photographies, des audios, des vidéos, du texte, etc. La méthode recommandée consiste à inclure le texte (en tant que nom d'image) dans le code HTML>.

Masquer les robots des moteurs de recherche  est la manifestation de sites Web pour certains visiteurs (par exemple, les pages vues par le bot sont distinctes des utilisateurs).

est la manifestation de sites Web pour certains visiteurs (par exemple, les pages vues par le bot sont distinctes des utilisateurs).

Les robots des moteurs de recherche peuvent parfois remarquer un lien vers votre site Web à partir d'autres sites Web sur Internet. De même, le robot s'appuie sur les liens de votre site pour naviguer vers différents sites de destination.

Les pages orphelines sont celles qui n'ont pas de liens internes qui leur sont assignés puisque les crawlers ne peuvent pas trouver un moyen d'y accéder. Ils sont également presque invisibles pour le bot lorsqu'il parcourt le site.

Lorsque les robots d'exploration rencontrent des "erreurs d'exploration" sur un site Web, telles que 404, 500 et autres, ils deviennent frustrés et abandonnent la page. La recommandation est d'utiliser soit une '302 - redirection' ou une '301 - redirection permanente' pour rediriger temporairement les pages Web. Il est essentiel de placer le pont pour les robots des moteurs de recherche.

Peu de robots d'exploration Web sont -

Googlebot

Googlebot est un robot d'exploration Web (parfois appelé araignée ou robot) qui explore et indexe les sites Web pour Google. Il récupère simplement le texte consultable sur les sites Web sans porter de jugement. Le nom fait référence à deux types de robots d'exploration Web : un pour les ordinateurs de bureau et un pour les appareils mobiles.

Bingbot

Microsoft a lancé Bingbot, une sorte de bot Internet, en octobre 2010. Il fonctionne de la même manière que Googlebot, collectant des documents à partir de sites Web pour fournir des informations consultables pour les SERP.

Robot slurp

Les résultats du robot d'exploration Yahoo sont générés par le bot Slurp. Il recueille des informations sur le site Web du partenaire et adapte le matériel pour le moteur de recherche de Yahoo. Ces pages d'exploration vérifient l'authentification des utilisateurs sur plusieurs pages Web.

Baïduspider

L'araignée de Baidu est le robot du moteur de recherche chinois. Le bot est un logiciel qui, comme tous les crawlers, collecte des informations pertinentes à la requête de l'utilisateur. Il explore et indexe progressivement les pages Web d'Internet.

Robot Yandex

Yandex est un moteur de recherche russe et le crawler d'un moteur de recherche du même nom. De même, le bot Yandex parcourt régulièrement la page et enregistre les données pertinentes dans la base de données. Il aide à générer des résultats de recherche conviviaux. Yandex est le cinquième moteur de recherche au monde, avec une part de marché de 60 % en Russie.

Avançons maintenant pour comprendre comment Google indexe les pages.

Indexage

L'index est une collection de toutes les données ou pages indexées par le crawler du moteur de recherche. Le processus d'indexation est le processus de stockage du matériel obtenu dans une base de données d'index de recherche. Les données précédemment enregistrées sont ensuite évaluées selon les métriques de l'algorithme SEO par rapport à des pages similaires utilisant des données indexées. L'importance de l'indexation ne peut être surestimée car elle aide au classement d'un site Web.

Comment savoir ce que Google a indexé ?

Pour voir combien de pages sont indexées sur le SERP, tapez "site:votredomaine" dans le champ de recherche. Cela affichera toutes les pages indexées par Google, y compris les pages, les articles et les photos, entre autres.

Le moyen le plus simple de s'assurer que les URL sont indexées est de soumettre un sitemap à Google Search Console, qui contient une liste de toutes les pages importantes.

Lorsqu'il s'agit de présenter toutes les pages importantes du SERP, l'indexation du site Web est cruciale. Si le Googlebot ne peut pas voir le matériel, il ne sera pas indexé. Googlebot analyse l'intégralité du site Web dans plusieurs formats tels que HTML, CSS et Javascript. L'indexation ne sera pas effectuée sur les composants qui ne sont pas accessibles.

Comment Google décide-t-il quoi indexer ?

Lorsqu'un utilisateur tape une requête dans Google, il essaie de trouver la réponse la plus pertinente parmi les sites indexés de la base de données. Google indexe les informations à l'aide de son propre ensemble d'algorithmes. Il indexe généralement le nouveau contenu sur un site Web qui, selon Google, améliorerait l'expérience utilisateur. Plus la qualité du contenu est élevée et plus la qualité des liens sur le site Web est élevée, mieux c'est pour le référencement.

Identifier comment nos sites Web parviennent aux processus d'indexation.

Version en cache

Google parcourt régulièrement les pages du site. Cliquez sur le signe "déroulant" à côté de l'URL pour voir la version en cache de la page Web (comme illustré dans la capture d'écran ci-dessous).

URL supprimées

OUI! Après avoir été indexées sur SERP, les pages Web peuvent être supprimées. Il est possible que les sites Web supprimés renvoient des erreurs 404, aient des URL redirigées ou aient des liens rompus, entre autres. Une balise « noindex » serait également ajoutée aux URL.

Balises méta

Situé dans le code HTML de la section <head> du site.

- Index, pas d'index

Cette fonction indique au crawler du moteur de recherche si les pages doivent ou non être indexées. Le bot le traite comme une fonction 'index' par défaut. Lorsque vous sélectionnez "noindex", vous demandez aux robots d'exploration de supprimer les pages du SERP.

- Suivre/ne pas suivre

Permet au robot d'exploration du moteur de recherche de déterminer quelles pages doivent être surveillées et quelle équité de lien doit être transmise.

Voici l'exemple de code

< tête >< méta nom =”robots” content=”noindex, nofollow” /></ tête >

Après avoir rassemblé toutes les informations nécessaires, utilisez les services de référencement avancés fournis par la principale agence de référencement du Kerala pour optimiser votre site Web. Rejoignez la conversation dans la section des commentaires ci-dessous.