Crawling și indexare: tot ce trebuie să știți

Publicat: 2022-09-11Metoda de creștere a calității și cantității de trafic către site-ul dvs. este cunoscută sub numele de SEO (Search Engine Optimization). Este procesul de optimizare a paginilor web pentru a obține în mod natural poziții de căutare mai ridicate. Te-ai întrebat vreodată ce alimentează un motor de căutare? Este remarcabil cum unele mecanisme pot scana World Wide Web într-o manieră sistematică pentru indexarea web sau accesarea cu crawlere pe web.

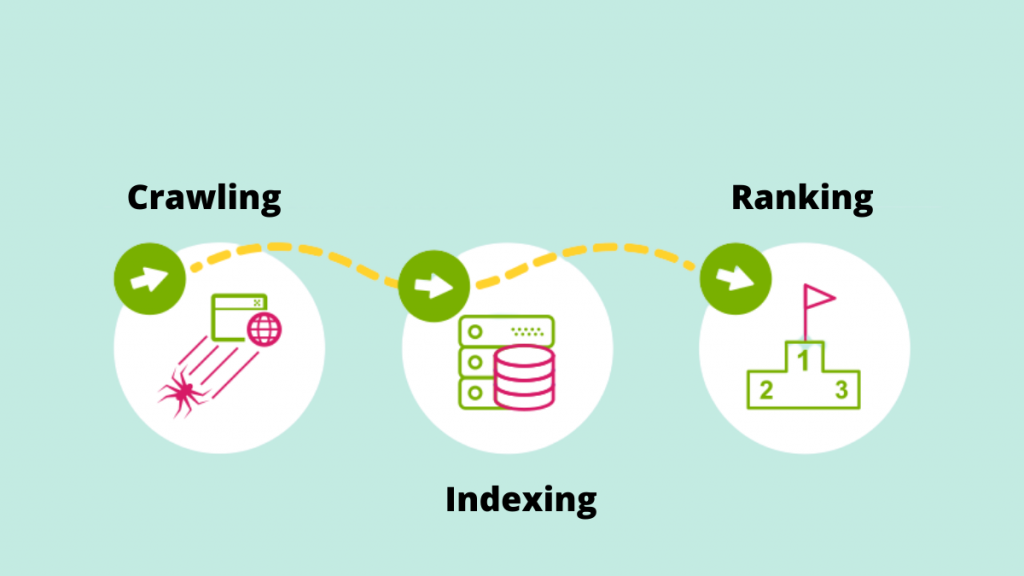

Să aruncăm o privire mai atentă asupra rolului fundamental al crawlingului și indexării în furnizarea rezultatelor căutării, în lumina tendințelor SEO în continuă creștere.

Crawling

Accesarea cu crawlere este procesul prin care motoarele de căutare își folosesc crawlerele web pentru a detecta link-uri noi, site-uri web sau pagini de destinație noi, actualizări pentru a prezenta date, link-uri întrerupte și alte lucruri. Crawlerele web sunt denumite și „păianjeni”, „roboți” sau „păianjeni”. Când roboții vizitează un site web, folosesc linkurile interne pentru a accesa cu crawlere alte pagini de pe site.

Drept urmare, unul dintre cele mai importante motive pentru a facilita accesarea cu crawlere a site-ului web pentru Google Bot este crearea unui sitemap. O listă crucială de adrese URL poate fi găsită în harta site-ului.

De exemplu: https://iquelab.in/sitemap_index.xml

Modelul DOM este folosit de bot ori de câte ori explorează site-ul web sau paginile web (modelul obiectului documentului). Acest DOM reflectă structura logică a arborelui site-ului.

Codul HTML și Javascript redat al paginii este denumit DOM. Ar fi practic imposibil să accesați cu crawlere întregul site deodată și ar dura mult timp. Drept urmare, Google Bot accesează cu crawlere doar cele mai importante zone ale site-ului, care sunt comparativ importante pentru a măsura statistici specifice care ar putea ajuta la clasarea site-urilor respective.

Optimizați site-ul web pentru Google Crawler

Uneori, ne confruntăm cu situații în care Google Crawler nu indexează anumite pagini importante de pe un site web. Ca rezultat, trebuie să instruim motorului de căutare cum să acceseze cu crawlere site-ul. Pentru a face acest lucru, generați un fișier robots.txt și stocați-l în directorul rădăcină al domeniului.

Fișierul Robots.txt ajută crawlerul să acceseze cu crawlere sistematic pagina web. Fișierul robots.txt indică crawlerilor ce adrese URL trebuie accesate cu crawlere. Dacă botul nu poate localiza fișierul robots.txt, își va continua sarcina de crawling. De asemenea, ajută la gestionarea bugetului de accesare cu crawlere a site-ului.

Elemente care afectează Crawling-ul

Deoarece paginile de conectare sunt pagini securizate, un bot nu accesează cu crawlere materialul din spatele formularelor de conectare sau dacă orice site web solicită utilizatorilor să se autentifice.

Informațiile din caseta de căutare de pe site nu sunt accesate cu crawlere de Googlebot. Mulți oameni cred că atunci când un client introduce produsul dorit în caseta de căutare, crawler-ul Google accesează cu crawlere site-ul. Acest lucru este valabil mai ales pentru site-urile de comerț electronic.

Nu există nicio garanție că botul va accesa cu crawlere tipuri de media, cum ar fi fotografii, audio, videoclipuri, text și așa mai departe. Metoda recomandată este includerea textului (ca nume de imagine) în codul HTML>.

Demascarea către roboții motoarelor de căutare  este manifestarea site-urilor web pentru anumiți vizitatori (de exemplu, Paginile văzute de bot sunt distincte de Utilizatori).

este manifestarea site-urilor web pentru anumiți vizitatori (de exemplu, Paginile văzute de bot sunt distincte de Utilizatori).

Crawlerele motoarelor de căutare pot observa ocazional un link către site-ul dvs. de pe alte site-uri de pe internet. În mod similar, crawlerul se bazează pe linkurile site-ului dvs. pentru a naviga la diferite site-uri de destinație.

Paginile orfane sunt acelea care nu au legături interne atribuite, deoarece crawlerele nu găsesc o modalitate de a ajunge la ele. De asemenea, sunt aproape invizibili pentru bot în timp ce accesează cu crawlere site-ul.

Când crawlerele întâlnesc „erori de accesare cu crawlere” pe un site web, cum ar fi 404, 500 și altele, devin frustrați și abandonează pagina. Recomandarea este să utilizați fie un „302 – redirecționare”, fie un „301 – redirecționare permanentă” pentru a redirecționa temporar paginile web. Este esențial să plasați puntea pentru crawlerele motoarelor de căutare.

Puțini dintre crawlerele web sunt -

Googlebot

Googlebot este un crawler web (uneori cunoscut sub numele de păianjen sau robot) care accesează cu crawlere și indexează site-uri web pentru Google. Doar preia textul care poate fi căutat de pe site-uri web fără a face nicio judecată. Numele se referă la două tipuri de crawler-uri web: unul pentru desktop și unul pentru dispozitive mobile.

Bingbot

Microsoft a lansat Bingbot, un fel de bot de internet, în octombrie 2010. Funcționează în același mod ca Googlebot, colectând documente de pe site-uri web pentru a oferi informații de căutare pentru SERP-uri.

Slurp Bot

Descoperirile crawlerului web Yahoo sunt generate de botul Slurp. Acesta adună informații de pe site-ul partenerului și adaptează materialul pentru motorul de căutare Yahoo. Aceste pagini de accesare cu crawlere verifică autentificarea utilizatorului pe mai multe pagini web.

Baiduspider

Păianjenul lui Baidu este robotul motorului de căutare chinez. Botul este un program care, la fel ca toate crawlerele, colectează informații relevante pentru interogarea utilizatorului. Se accesează cu crawlere și indexează treptat paginile web ale internetului.

Yandex Bot

Yandex este un motor de căutare rus și crawler-ul unui motor de căutare cu același nume. În mod similar, botul Yandex accesează cu crawlere pagina în mod regulat și înregistrează datele relevante în baza de date. Ajută la generarea de rezultate de căutare ușor de utilizat. Yandex este al cincilea motor de căutare din lume, cu o cotă de piață de 60% în Rusia.

Acum să mergem mai departe pentru a înțelege cum indexează Google paginile.

Indexarea

Indexul este o colecție a tuturor datelor sau paginilor indexate de crawler-ul motorului de căutare. Procesul de indexare este procesul de stocare a materialului obținut într-o bază de date cu index de căutare. Datele salvate anterior sunt apoi evaluate la valorile algoritmului SEO în comparație cu pagini similare folosind date indexate. Importanța indexării nu poate fi exagerată, deoarece ajută la clasarea unui site web.

Cum poți ști ce a indexat Google?

Pentru a vedea câte pagini sunt indexate pe SERP, tastați „site:yourdomain” în caseta de căutare. Aceasta va afișa toate paginile pe care Google le-a indexat, inclusiv pagini, articole și fotografii, printre altele.

Cel mai simplu mod de a vă asigura că adresele URL sunt indexate este să trimiteți un sitemap la Google Search Console, care conține o listă cu toate paginile importante.

Când vine vorba de prezentarea tuturor paginilor importante din SERP, indexarea site-ului este crucială. Dacă Googlebot nu poate vedea materialul, acesta nu va fi indexat. Googlebot analizează întregul site web în mai multe formate, cum ar fi HTML, CSS și Javascript. Indexarea nu va fi efectuată pe componente care nu sunt accesibile.

Cum decide Google ce să indexeze?

Când un utilizator introduce o interogare în Google, încearcă să găsească cel mai relevant răspuns de pe site-urile indexate ale bazei de date. Google indexează informații folosind propriul set de algoritmi. De obicei, indexează conținut nou pe un site web despre care Google consideră că ar îmbunătăți experiența utilizatorului. Cu cât este mai mare calitatea conținutului și cu cât este mai mare calitatea link-urilor de pe site, cu atât mai bine pentru SEO.

Identificarea modului în care site-urile noastre ajung la procesele de indexare.

Versiune în cache

Google accesează cu crawlere paginile site-ului în mod regulat. Faceți clic pe semnul „drop-down” de lângă adresa URL pentru a vedea versiunea stocată în cache a paginii web (după cum se arată în captura de ecran de mai jos).

URL-uri eliminate

DA! După ce au fost indexate pe SERP, paginile web pot fi eliminate. Este posibil ca site-urile web eliminate să returneze erori 404, să aibă adrese URL redirecționate sau să aibă link-uri întrerupte, printre altele. O etichetă „noindex” va fi adăugată și la adresele URL.

Meta etichete

Situat în codul HTML al secțiunii <head> a site-ului.

- Index, fără index

Această funcție indică crawler-ului motorului de căutare dacă paginile trebuie sau nu indexate. Botul o tratează implicit ca pe o funcție „index”. Când selectați „noindex”, le solicitați crawlerilor să elimine paginile din SERP.

- Urmăriți/nu urmăriți

Permite crawler-ului motorului de căutare să determine ce pagini ar trebui monitorizate și cât de mult ar trebui să se transmită link-uri.

Iată exemplul de cod

< head >< meta name =”roboți” content="noindex, nofollow” /></ head >

După ce ați adunat toate informațiile necesare, utilizați serviciile avansate de SEO oferite de agenția de SEO lider din Kerala pentru a vă optimiza site-ul. Alăturați-vă conversației în secțiunea de comentarii de mai jos.