Qu'est-ce que les données d'entraînement ? Comment il est utilisé dans l'apprentissage automatique

Publié: 2021-07-30Les modèles d'apprentissage automatique sont aussi bons que les données sur lesquelles ils sont formés.

Sans données d'entraînement de haute qualité, même les plus efficaces apprentissage automatique les algorithmes ne fonctionneront pas.

Le besoin de données de qualité, exactes, complètes et pertinentes commence tôt dans le processus de formation. Ce n'est que si l'algorithme est alimenté avec de bonnes données d'entraînement qu'il peut facilement capter les caractéristiques et trouver les relations dont il a besoin pour prédire sur toute la ligne.

Plus précisément, les données de formation de qualité sont l'aspect le plus important de l'apprentissage automatique (et de l'intelligence artificielle) que tout autre. Si vous introduisez les algorithmes d'apprentissage automatique (ML) dans les bonnes données, vous les configurez pour la précision et le succès.

Qu'est-ce que les données d'entraînement ?

Les données d'entraînement sont l'ensemble de données initial utilisé pour entraîner les algorithmes d'apprentissage automatique. Les modèles créent et affinent leurs règles à l'aide de ces données. Il s'agit d'un ensemble d'échantillons de données utilisés pour adapter les paramètres d'un modèle d'apprentissage automatique à sa formation par exemple.

Les données d'apprentissage sont également appelées ensemble de données d'apprentissage, ensemble d'apprentissage et ensemble d'apprentissage. C'est un composant essentiel de chaque modèle d'apprentissage automatique et les aide à faire des prédictions précises ou à effectuer une tâche souhaitée.

En termes simples, les données de formation créent le modèle d'apprentissage automatique. Il enseigne à quoi ressemble la sortie attendue. Le modèle analyse l'ensemble de données à plusieurs reprises pour comprendre en profondeur ses caractéristiques et s'ajuster pour de meilleures performances.

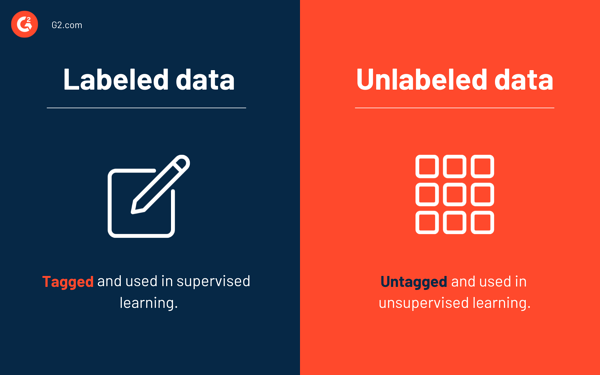

Dans un sens plus large, les données d'entraînement peuvent être classées en deux catégories : les données étiquetées et les données non étiquetées .

Qu'est-ce qu'une donnée étiquetée ?

Les données étiquetées sont un groupe d'échantillons de données étiquetés avec une ou plusieurs étiquettes significatives. Elles sont également appelées données annotées et leurs étiquettes identifient des caractéristiques, des propriétés, des classifications ou des objets contenus spécifiques.

Par exemple, les images de fruits peuvent être étiquetées comme des pommes, des bananes ou des raisins .

Les données d'entraînement étiquetées sont utilisées dans enseignement supervisé. Il permet aux modèles ML d'apprendre les caractéristiques associées à des étiquettes spécifiques, qui peuvent être utilisées pour classer des points de données plus récents. Dans l'exemple ci-dessus, cela signifie qu'un modèle peut utiliser des données d'image étiquetées pour comprendre les caractéristiques de fruits spécifiques et utiliser ces informations pour regrouper de nouvelles images.

L'étiquetage ou l'annotation des données est un processus qui prend du temps, car les humains doivent étiqueter ou étiqueter les points de données. La collecte de données étiquetées est difficile et coûteuse. Il n'est pas facile de stocker des données étiquetées par rapport aux données non étiquetées.

Qu'est-ce qu'une donnée non étiquetée ?

Comme prévu, les données non étiquetées sont à l'opposé des données étiquetées. Il s'agit de données brutes ou de données qui ne sont associées à aucune étiquette permettant d'identifier des classifications, des caractéristiques ou des propriétés. Il est utilisé dans l'apprentissage automatique non supervisé, et les modèles ML doivent trouver des modèles ou des similitudes dans les données pour tirer des conclusions.

Pour en revenir à l'exemple précédent de pommes , bananes et raisins , dans des données d'entraînement non étiquetées, les images de ces fruits ne seront pas étiquetées. Le modèle devra évaluer chaque image en examinant ses caractéristiques, telles que la couleur et la forme.

Après avoir analysé un nombre considérable d'images, le modèle sera en mesure de différencier de nouvelles images (nouvelles données) dans les types de fruits pommes , bananes ou raisins . Bien sûr, le modèle ne saurait pas que le fruit en question s'appelle une pomme. Au lieu de cela, il connaît les caractéristiques nécessaires pour l'identifier.

Il existe des modèles hybrides qui utilisent une combinaison d'apprentissage automatique supervisé et non supervisé.

Comment les données de formation sont utilisées dans l'apprentissage automatique

Contrairement aux algorithmes d'apprentissage automatique, les algorithmes de programmation traditionnels suivent un ensemble d'instructions pour accepter les données d'entrée et fournir une sortie. Ils ne s'appuient pas sur des données historiques et chaque action qu'ils effectuent est basée sur des règles. Cela signifie également qu'ils ne s'améliorent pas avec le temps, ce qui n'est pas le cas avec l'apprentissage automatique.

Pour les modèles d'apprentissage automatique, les données historiques sont fourragères. Tout comme les humains s'appuient sur leurs expériences passées pour prendre de meilleures décisions, les modèles ML examinent leur ensemble de données d'entraînement avec des observations passées pour faire des prédictions.

Les prédictions pourraient inclure la classification des images comme dans le cas de la reconnaissance d'images, ou la compréhension du contexte d'une phrase comme dans le traitement du langage naturel (TAL).

Considérez un scientifique des données comme un enseignant, l'algorithme d'apprentissage automatique comme l'étudiant et l'ensemble de données de formation comme la collection de tous les manuels.

L'aspiration de l'enseignant est que l'élève réussisse bien aux examens et aussi dans le monde réel. Dans le cas des algorithmes ML, les tests sont comme des examens. Les manuels (ensemble de données d'entraînement) contiennent plusieurs exemples du type de questions qui seront posées lors de l'examen.

Conseil : Découvrez l'analyse des données volumineuses savoir comment les mégadonnées sont collectées, structurées, nettoyées et analysées.

Bien sûr, il ne contiendra pas tous les exemples de questions qui seront posées à l'examen, et tous les exemples inclus dans le manuel ne seront pas non plus posés à l'examen. Les manuels peuvent aider à préparer l'élève en lui apprenant à quoi s'attendre et comment réagir.

Aucun manuel ne peut jamais être entièrement complet. Au fil du temps, le type de questions posées changera et, par conséquent, les informations contenues dans les manuels doivent être modifiées. Dans le cas des algorithmes ML, l'ensemble d'apprentissage doit être périodiquement mis à jour pour inclure de nouvelles informations.

En bref, les données de formation sont un manuel qui aide les scientifiques des données à donner aux algorithmes ML une idée de ce à quoi s'attendre. Bien que l'ensemble de données d'entraînement ne contienne pas tous les exemples possibles, il créera des algorithmes capables de faire des prédictions.

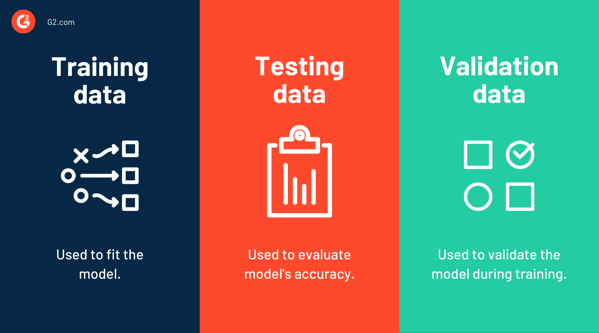

Données de formation vs données de test vs données de validation

Les données d'entraînement sont utilisées dans l'entraînement du modèle, ou en d'autres termes, ce sont les données utilisées pour ajuster le modèle. Au contraire, les données de test sont utilisées pour évaluer les performances ou la précision du modèle. Il s'agit d'un échantillon de données utilisé pour effectuer une évaluation impartiale de l'ajustement du modèle final sur les données d'apprentissage.

Un ensemble de données d'apprentissage est un ensemble de données initial qui apprend aux modèles ML à identifier les modèles souhaités ou à effectuer une tâche particulière. Un ensemble de données de test est utilisé pour évaluer l'efficacité de la formation ou la précision du modèle.

Une fois qu'un algorithme ML est formé sur un ensemble de données particulier et si vous le testez sur le même ensemble de données, il est plus susceptible d'avoir une grande précision car le modèle sait à quoi s'attendre. Si l'ensemble de données d'apprentissage contient toutes les valeurs possibles que le modèle pourrait rencontrer à l'avenir, tout va bien.

Mais ce n'est jamais le cas. Un ensemble de données de formation ne peut jamais être complet et ne peut pas enseigner tout ce qu'un modèle pourrait rencontrer dans le monde réel. Par conséquent, un ensemble de données de test, contenant des points de données invisibles , est utilisé pour évaluer la précision du modèle.

Ensuite, il y a les données de validation . Il s'agit d'un ensemble de données utilisé pour une évaluation fréquente pendant la phase de formation. Bien que le modèle voie occasionnellement cet ensemble de données, il n'en tire aucune leçon . L'ensemble de validation est également appelé ensemble de développement ou ensemble de développement. Il aide à protéger les modèles contre le surajustement et le sous-ajustement.

Bien que les données de validation soient distinctes des données de formation, les data scientists peuvent réserver une partie des données de formation à la validation. Mais bien sûr, cela signifie automatiquement que les données de validation ont été tenues à l'écart pendant la formation.

Conseil : Si vous disposez d'une quantité limitée de données, une technique appelée validation croisée peut être utilisée pour estimer les performances du modèle. Cette méthode consiste à partitionner de manière aléatoire les données d'apprentissage en plusieurs sous-ensembles et à en réserver un pour l'évaluation.

Beaucoup utilisent les termes « données de test » et « données de validation » de manière interchangeable. La principale différence entre les deux est que les données de validation sont utilisées pour valider le modèle pendant la formation, tandis que l'ensemble de test est utilisé pour tester le modèle une fois la formation terminée.

L'ensemble de données de validation donne au modèle un avant-goût de données inédites. Cependant, tous les scientifiques des données n'effectuent pas une vérification initiale à l'aide de données de validation. Ils peuvent ignorer cette partie et passer directement aux données de test.

Qu'y a-t-il d'humain dans la boucle ?

L'humain dans la boucle fait référence aux personnes impliquées dans la collecte et la préparation des données de formation.

Les données brutes sont recueillies à partir de plusieurs sources, y compris les appareils IoT, les plateformes de médias sociaux, les sites Web et les commentaires des clients. Une fois collectées, les personnes impliquées dans le processus détermineraient les attributs cruciaux des données qui sont de bons indicateurs du résultat que vous souhaitez que le modèle prédise.

Les données sont préparées en les nettoyant, en tenant compte des valeurs manquantes, en supprimant les valeurs aberrantes, en marquant les points de données et en les chargeant dans des emplacements appropriés pour la formation des algorithmes ML. Il y aura également plusieurs séries de contrôles de qualité ; comme vous le savez, des étiquettes incorrectes peuvent affecter considérablement la précision du modèle.

Qu'est-ce qui rend les données d'entraînement bonnes ?

Des données de haute qualité se traduisent par des modèles d'apprentissage automatique précis.

Des données de mauvaise qualité peuvent affecter considérablement la précision des modèles, ce qui peut entraîner de graves pertes financières. C'est presque comme donner à un élève un manuel contenant des informations erronées et s'attendre à ce qu'il excelle à l'examen.

Voici les quatre principales caractéristiques des données de formation de qualité.

Pertinent

Les données doivent être pertinentes pour la tâche à accomplir. Par exemple, si vous voulez former un vision par ordinateur algorithme pour les véhicules autonomes, vous n'aurez probablement pas besoin d'images de fruits et de légumes. Au lieu de cela, vous auriez besoin d'un ensemble de données d'entraînement contenant des photos de routes, de trottoirs, de piétons et de véhicules.

Représentant

Les données d'apprentissage de l'IA doivent avoir les points de données ou les caractéristiques que l'application est censée prédire ou classer. Bien sûr, l'ensemble de données ne peut jamais être absolu, mais il doit avoir au moins les attributs que l'application d'IA est censée reconnaître.

Par exemple, si le modèle est censé reconnaître des visages dans des images, il doit être alimenté par diverses données contenant des visages de personnes de diverses ethnies. Cela réduira le problème de biais de l'IA et le modèle ne sera pas préjudiciable à une race, un sexe ou un groupe d'âge particulier.

Uniforme

Toutes les données doivent avoir le même attribut et doivent provenir de la même source.

Supposons que votre projet d'apprentissage automatique vise à prédire le taux de désabonnement en examinant les informations sur les clients. Pour cela, vous disposerez d'une base de données d'informations sur les clients qui comprend le nom du client, son adresse, le nombre de commandes, la fréquence des commandes et d'autres informations pertinentes. Il s'agit de données historiques et peuvent être utilisées comme données d'entraînement.

Une partie des données ne peut pas contenir d'informations supplémentaires, telles que l'âge ou le sexe. Cela rendra les données de formation incomplètes et le modèle inexact. En bref, l'uniformité est un aspect essentiel des données de formation de qualité.

Complet

Encore une fois, les données d'entraînement ne peuvent jamais être absolues. Mais il doit s'agir d'un grand ensemble de données qui représente la majorité des cas d'utilisation du modèle. Les données d'entraînement doivent contenir suffisamment d'exemples pour permettre au modèle d'apprendre de manière appropriée. Il doit contenir des échantillons de données du monde réel car il aidera à former le modèle pour comprendre à quoi s'attendre.

Si vous pensez que les données d'apprentissage sont des valeurs placées dans un grand nombre de lignes et de colonnes, désolé, vous vous trompez. Il peut s'agir de n'importe quel type de données comme du texte, des images, de l'audio ou des vidéos.

Qu'est-ce qui affecte la qualité des données de formation ?

Les humains sont des créatures très sociales, mais il y a certains préjugés que nous aurions pu choisir dans notre enfance et dont nous devons constamment faire un effort conscient pour nous débarrasser. Bien que défavorables, de tels biais peuvent affecter nos créations, et les applications d'apprentissage automatique ne sont pas différentes.

Pour les modèles ML, les données d'entraînement sont le seul livre qu'ils lisent. Leur performance ou leur exactitude dépendra de l'exhaustivité, de la pertinence et de la représentativité du livre lui-même.

Cela étant dit, trois facteurs affectent la qualité des données d'entraînement :

Personnes : les personnes qui entraînent le modèle ont un impact significatif sur sa précision ou ses performances. S'ils sont biaisés, cela affectera naturellement la façon dont ils balisent les données et, en fin de compte, le fonctionnement du modèle ML.

Processus : le processus d'étiquetage des données doit être soumis à des contrôles de qualité rigoureux. Cela augmentera considérablement la qualité des données de formation.

Outils : des outils incompatibles ou obsolètes peuvent nuire à la qualité des données. L'utilisation d'un logiciel d'étiquetage de données robuste peut réduire le coût et le temps associés au processus.

Où obtenir des données d'entraînement

Il existe plusieurs façons d'obtenir des données d'entraînement. Votre choix de sources peut varier en fonction de l'ampleur de votre projet d'apprentissage automatique, du budget et du temps disponible. Voici les trois principales sources de collecte de données.

Données de formation open source

La plupart des développeurs ML amateurs et des petites entreprises qui n'ont pas les moyens de collecter ou d'étiqueter des données s'appuient sur des données de formation open source. C'est un choix facile car il est déjà collecté et gratuit. Cependant, vous devrez très probablement modifier ou ré-annoter ces ensembles de données pour répondre à vos besoins de formation. ImageNet, Kaggle et Google Dataset Search sont quelques exemples d'ensembles de données open source.

Internet et IdO

La plupart des entreprises de taille moyenne collectent des données à l'aide d'Internet et d'appareils IoT. Les caméras, capteurs et autres appareils intelligents aident à collecter des données brutes, qui seront nettoyées et annotées plus tard. Cette méthode de collecte de données sera spécifiquement adaptée aux exigences de votre projet d'apprentissage automatique, contrairement aux ensembles de données open source. Cependant, le nettoyage, la standardisation et l'étiquetage des données est un processus long et gourmand en ressources.

Données d'entraînement artificielles

Comme son nom l'indique, les données d'entraînement artificielles sont des données créées artificiellement à l'aide de modèles d'apprentissage automatique. On les appelle aussi données synthétiques, et c'est un excellent choix si vous avez besoin de données d'entraînement de bonne qualité avec des fonctionnalités spécifiques pour l'entraînement d'un algorithme. Bien sûr, cette méthode nécessitera de grandes quantités de ressources de calcul et beaucoup de temps.

Quelle quantité de données d'entraînement est suffisante ?

Il n'y a pas de réponse spécifique à la quantité de données d'entraînement suffisante pour les données d'entraînement. Cela dépend de l'algorithme que vous formez - de son résultat attendu, de son application, de sa complexité et de nombreux autres facteurs.

Supposons que vous souhaitiez former un classificateur de texte qui catégorise les phrases en fonction de l'occurrence des termes "chat" et "chien" et de leurs synonymes tels que "kitty", "kitten", "pussycat", "puppy" ou "doggy" . Cela peut ne pas nécessiter un ensemble de données volumineux car il n'y a que quelques termes à faire correspondre et à trier.

Mais s'il s'agissait d'un classificateur d'images qui catégorisait les images en "chats" et "chiens", le nombre de points de données nécessaires dans l'ensemble de données d'entraînement augmenterait considérablement. En bref, de nombreux facteurs entrent en jeu pour décider quelles données d'entraînement sont des données d'entraînement suffisantes.

La quantité de données requises changera en fonction de l'algorithme utilisé.

Pour le contexte, L'apprentissage en profondeur, un sous-ensemble de l'apprentissage automatique, nécessite des millions de points de données pour entraîner les réseaux de neurones artificiels (ANN). En revanche, les algorithmes d'apprentissage automatique ne nécessitent que des milliers de points de données. Mais bien sûr, il s'agit d'une généralisation farfelue car la quantité de données nécessaires varie en fonction de l'application.

Plus vous entraînez le modèle, plus il devient précis. Il est donc toujours préférable d'avoir une grande quantité de données comme données d'entraînement.

Déchets à l'intérieur, déchets à l'extérieur

L'expression "garbage in, garbage out" est l'une des expressions les plus anciennes et les plus utilisées en science des données. Même avec le taux de génération de données en croissance exponentielle, cela reste vrai.

La clé est de fournir des données représentatives de haute qualité aux algorithmes d'apprentissage automatique. Cela peut améliorer considérablement la précision des modèles. Des données de formation de bonne qualité sont également cruciales pour créer des applications d'apprentissage automatique impartiales.

Vous êtes-vous déjà demandé de quoi seraient capables les ordinateurs dotés d'une intelligence humaine ? L'équivalent informatique de l'intelligence humaine est connu sous le nom d'intelligence artificielle générale, et nous n'avons pas encore conclu si ce sera la plus grande ou la plus dangereuse invention de tous les temps.