Was ist Googlebot? Alles, was Sie über die Google-Indexierung wissen müssen

Veröffentlicht: 2022-04-22Eine optimierte Website ist entscheidend, um bei Google zu ranken und von Ihrer Zielgruppe gefunden zu werden. Suchmaschinenoptimierung (SEO) hilft dabei, Ihre Website sowohl für Suchmaschinen-Crawler als auch für Menschen lesbarer und zugänglicher zu machen.

Jede Suchmaschine hat ihre eigenen einzigartigen Webcrawler, aber die meisten Suchstrategen konzentrieren sich auf nur einen – Googlebot.

Also, was ist Googlebot und wie können Sie Ihre Website dafür optimieren?

Was ist Googlebot?

Googlebot ist der Name des Webcrawlers von Google. Es „liest“ Webseiten und indiziert sie, damit sie Suchenden als Antwort auf ihre Suchbegriffe angezeigt werden können.

Der Googlebot hat zwei wichtige Aufgaben:

- Es durchsucht Webseiten kontinuierlich nach neuen Links, damit es so viele Inhalte wie möglich indizieren kann, und

- Es sammelt neue Informationen über Seiten, um den Google-Index auf dem neuesten Stand zu halten.

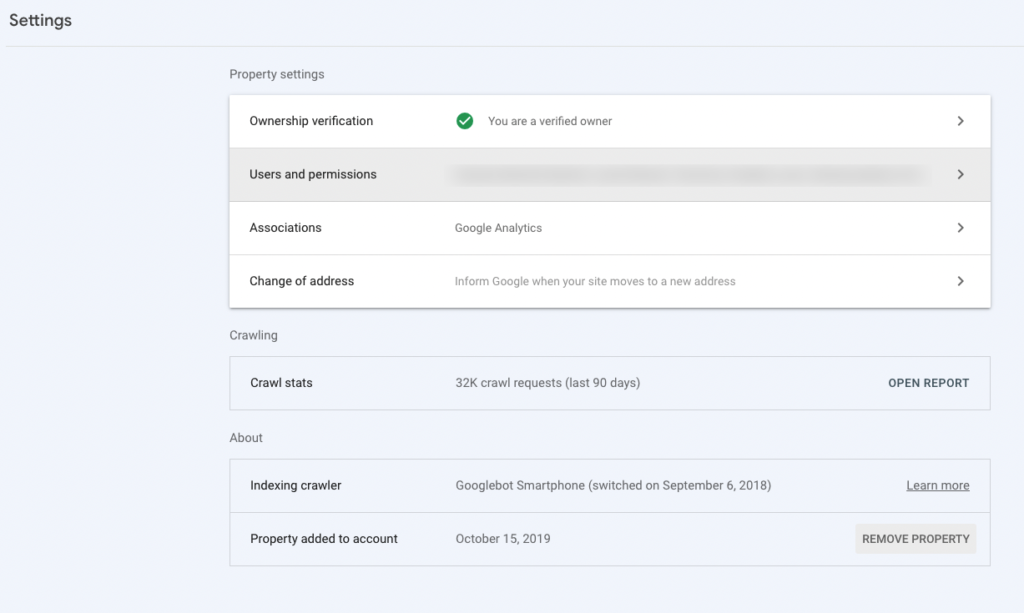

Obwohl es nur einen Namen gibt, gibt es tatsächlich zwei Arten von Googlebots: einen für Mobilgeräte (Googlebot Smartphone) und einen für den Desktop (Googlebot Desktop). Ersteres überprüft, wie gut Ihre Website auf Smartphones und Tablets gerendert wird, während letzteres sich auf die Desktop-Version Ihrer Website konzentriert.

Bei der Googlebot-Optimierung geht es darum, Google den Zugriff, das Crawlen und das „Lesen“ Ihrer Website zu erleichtern. Während sich viele SEO-Taktiken auf die Suchleistung auswirken, gibt es eine Handvoll unverzichtbarer Implementierungen, die die „Indexierbarkeit“ Ihrer Website verbessern und direkt beeinflussen können, ob Ihre Seiten für Google-Nutzer verfügbar sind oder nicht. Zusätzlich zu Onpage- und Offpage-SEO-Taktiken sollte Ihre SEO-Strategie technische SEO-Ziele beinhalten, die Ihnen dabei helfen, Ihre Chancen zu erhöhen, in den Suchmaschinenergebnissen aufzutauchen.

Warum sich nur auf den Googlebot konzentrieren? Was ist mit den Crawlern der anderen Suchmaschinen? Nun, da Google derzeit 92 % des Suchmarktes ausmacht, wird es wahrscheinlich von den meisten Ihrer Zielgruppe verwendet. Die folgenden Empfehlungen sollten es jedoch allen Crawlern erleichtern, Ihre Seiten zu lesen.

Wie funktioniert die Google-Indexierung?

Wenn Google eine Website indiziert, fügt es sie im Wesentlichen seiner Wissensdatenbank hinzu und notiert, worum es auf den Seiten geht, wie benutzerfreundlich sie sind und mehr. Aber woher weiß der Googlebot überhaupt, dass eine Website existiert und indexiert werden sollte?

Wenn Sie schon einmal eine Website erstellt haben, haben Sie wahrscheinlich bemerkt, dass Sie keinen organischen Traffic erhalten haben, sobald Sie sie veröffentlicht haben. Das liegt daran, dass Sie den Googlebot auf Ihre Website aufmerksam machen müssen, damit er Ihre Seiten crawlen kann. Sie können dies tun, indem Sie Ihre XML-Sitemap an die Google Search Console (ehemals Google Webmaster-Tools) senden.

Der Googlebot durchsucht Ihre Website mithilfe von Sitemaps und Linkdatenbanken aus früheren Crawls. Wenn es einen neuen Link auf Ihrer Website findet, fügt es ihn der Liste der zu besuchenden Seiten hinzu. Sowohl Googlebot Desktop als auch Googlebot Smartphone aktualisieren den Index, wenn sie auf fehlerhafte Links oder andere Probleme stoßen.

Dies ist der Index, den Google abruft, wenn es eine Anfrage erhält. Es verwendet dann kontextbezogene Hinweise aus der Suche, um zu bestimmen, wie relevante Ergebnisse eingestuft werden.

Wie oft crawlt Google meine Website?

Google crawlt URLs mit unterschiedlichen Raten. Während einige URLs möglicherweise jeden Tag gecrawlt werden, werden andere möglicherweise nur wöchentlich oder monatlich gecrawlt. Sofern Sie in Ihrer robots.txt-Datei oder in Ihren Meta-Robots-Tags nichts anderes angeben, versucht der Googlebot, zu jeder Seite Ihrer Website zu reisen und die Informationen auf dem Weg aufzuzeichnen, damit er Ihre Inhalte besser verstehen und seinen Index aktualisieren kann.

Obwohl ich mich bisher hauptsächlich auf den Googlebot-Crawler konzentriert habe, möchte ich darauf hinweisen, dass es tatsächlich mehrere Google-Webcrawler gibt. Die vollständige Liste der Google-Crawler finden Sie hier.

Wenn Sie wissen möchten, wie oft Google Ihre Website crawlt und indexiert, rufen Sie Ihre Google Search Console (GSC) auf. Sie finden Ihren Crawl-Statistikbericht unter Einstellungen.

5 Schritte zur Optimierung Ihrer Website für den Googlebot

Befolgen Sie diese fünf einfachen Schritte, um Ihre Website für Suchmaschinen-Spider zugänglich zu halten, damit Ihre Seiten in der Suche gefunden werden können.

1. Halten Sie Ihren Code einfach

Ein großer Teil der Verbesserung der Crawlbarkeit Ihrer Website besteht darin, die Dinge einfach zu halten. Google crawlt Flash, Ajax, Frames, Cookies, Session-IDs oder DHTML nicht und es dauert länger, JavaScript zu indizieren, weil es gerendert werden muss.

Beachten Sie beim Erstellen Ihrer Website unbedingt die allgemeinen und Qualitätsrichtlinien von Google, um Crawling-Probleme zu vermeiden und die Indexierung Ihrer Seiten zu vereinfachen.

2. Überprüfen Sie Ihre Robots.txt

Eine robots.txt-Datei teilt dem Googlebot mit, auf welche URLs er auf Ihrer Website zugreifen kann. Verwenden Sie robot.txt-Anweisungen, um eine Überlastung Ihrer Website mit Anfragen zu vermeiden und mehr Crawl-Budget für Seiten zu sparen, die von Suchmaschinen indexiert werden sollen. Ohne die robots.txt-Datei verbringt der Googlebot möglicherweise zu viel Zeit mit der Indizierung von Medien, Ressourcendateien oder anderen unwichtigen Seiten, die Sie nicht in die Suchergebnisse aufnehmen möchten. Robots.txt ist eine protokollweite Direktive. Sie sollten nur eine auf Ihrer Website haben, es sei denn, Sie haben mehrere Subdomains. Um Googlebot und Crawler Seite für Seite zu verwalten, verwenden Sie Meta-Roboter-Tags.

3. Verwenden Sie die interne Verlinkung

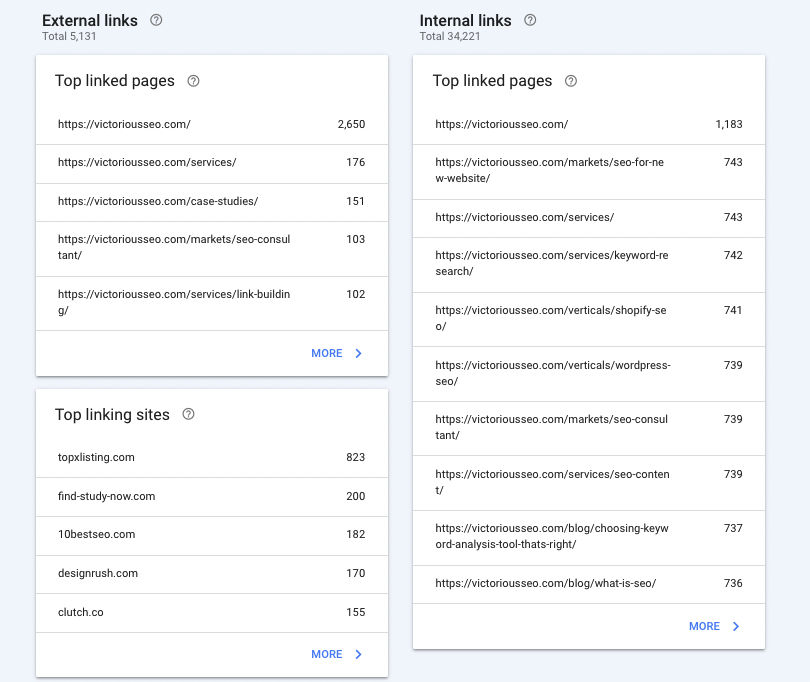

Interne Links sind Hyperlinks, die Sie von einer Seite zu einer anderen auf derselben Website führen. Sie können der Navigation dienen (denken Sie an Menüs, Seitenleisten, Kopf- und Fußzeilen) oder sie können kontextbezogen sein (im Hauptteil einer Seite platziert). Um es dem Googlebot zu erleichtern, Ihre Seiten zu finden und zu verstehen, wie sie zueinander in Beziehung stehen, verwenden Sie interne Links, um Ihre Website-Hierarchie hervorzuheben. Alle Ihre Seiten sollten auf irgendeine Weise miteinander verknüpft sein. Beispielsweise sollte Ihre Homepage mit Ihren Serviceseiten, Ihren Fallstudien und Ihrem Blog verlinken. Jede davon sollte dann auf relevante Seiten verlinken.

Erfahren Sie hier mehr über Best Practices für die interne Verlinkung.

Sehen Sie sich Ihren Linkbericht in GSC an, um sicherzustellen, dass Ihre wichtigsten Seiten – wie Ihre Homepage und Ihre Serviceseiten – die meisten Links erhalten. Dies zeigt Google an, dass es sich um die wichtigsten Seiten Ihrer Website handelt.

4. Erstellen Sie eine XML-Sitemap

Um dem Googlebot das Crawlen Ihrer Website zu erleichtern, stellen Sie eine XML-Sitemap bereit, die alle Ihre Seiten organisiert, damit der Web-Crawler die Hierarchie Ihrer Website schnell verstehen kann. (Nicht sicher, was eine XML-Sitemap ist, sehen Sie sich ein Sitemap-Beispiel an und erfahren Sie hier mehr.)

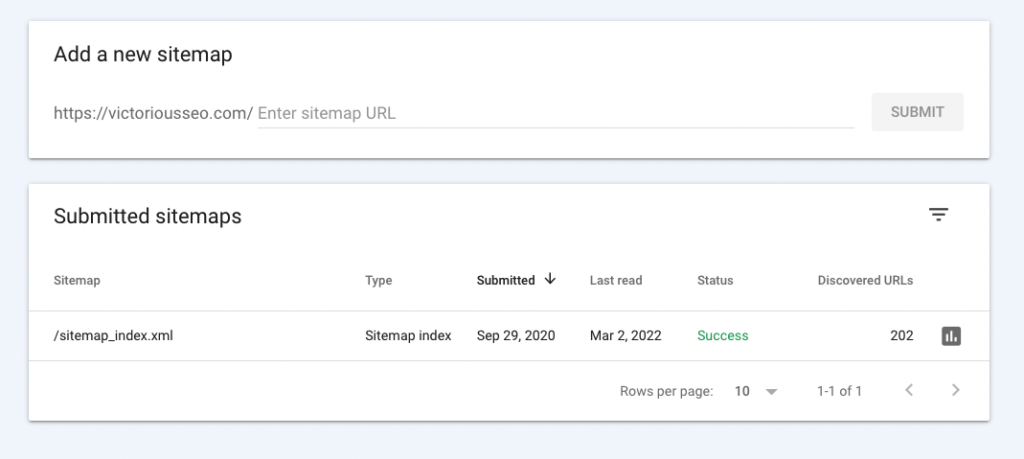

Senden Sie Ihre XML-Sitemap während des Überprüfungsprozesses über GSC an Google.

Wenn Sie kein Content-Management-System (CMS) verwenden, das Ihre Sitemap dynamisch für Sie aktualisiert, stellen Sie sicher, dass Sie Ihre XML-Sitemap manuell aktualisieren und erneut übermitteln, wenn Sie Änderungen an Ihrer Website-Hierarchie vornehmen. Klicken Sie einfach auf „Sitemaps“ in der linken Seitenleiste. Dadurch wird sichergestellt, dass Google die entsprechenden Seiten Ihrer Website indexiert.

5. Fordern Sie die Google-Indexierung an

Wenn Sie eine neue Seite veröffentlichen oder wesentliche Aktualisierungen an bestehenden Inhalten vornehmen, müssen Sie nicht warten, bis Google sie findet – teilen Sie Google mit, dass Sie eine neue oder aktualisierte Seite haben, die sie scannen können, indem Sie eine Indexierung anfordern.

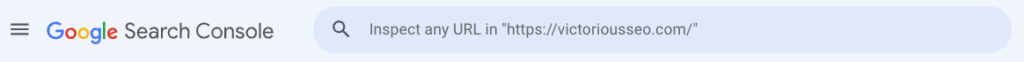

Melden Sie sich bei Ihrem GSC an und geben Sie die URL, die Sie indizieren möchten, links neben dem Lupensymbol oben auf der Seite ein und drücken Sie die Eingabetaste.

Google wird darauf hinweisen, dass Daten abgerufen werden.

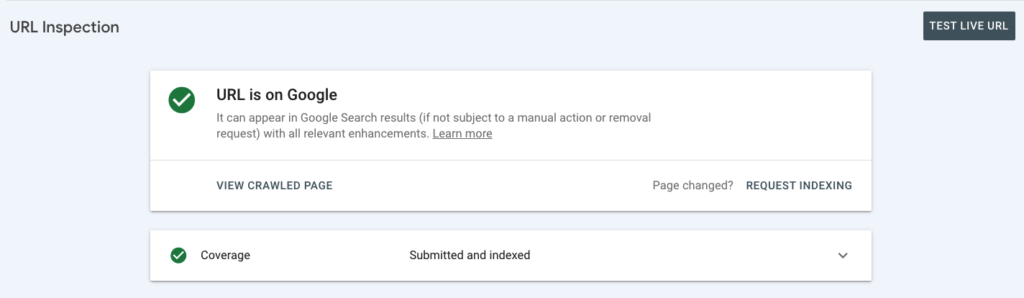

Und sagt Ihnen dann, ob Ihre Seite bereits indexiert ist.

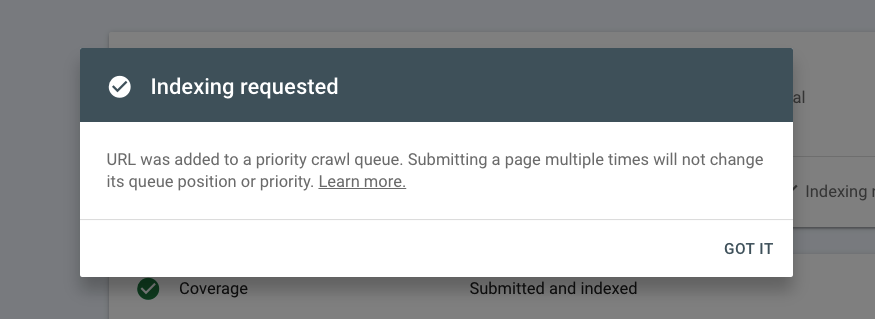

Ist dies nicht der Fall, können Sie die Indizierung anfordern. Wenn Ihre Seite indexiert ist und Sie wesentliche Änderungen daran vorgenommen haben, können Sie auch eine Indexierung anfordern.

Wenn Sie Ihrer Website häufig Seiten hinzufügen, z. B. einen neuen Blogbeitrag oder eine Produktseite, machen Sie diesen Prozess zu einem Teil Ihrer Best Practices, damit Sie sicherstellen können, dass alle Ihre Seiten ohne Verzögerung indexiert werden.

Literatur-Empfehlungen

- So verwenden Sie die Google Search Console

- So fügen Sie Benutzer zur Google Search Console hinzu

Vier Möglichkeiten, um zu analysieren, wie der Googlebot Ihre Website durchsucht

Nachdem Sie Ihre Website so optimiert haben, dass sie für einen Suchmaschinen-Crawler leichter lesbar ist, sollten Sie noch einmal überprüfen, ob sie ordnungsgemäß gecrawlt und indexiert wurde.

Crawling-Statistiken

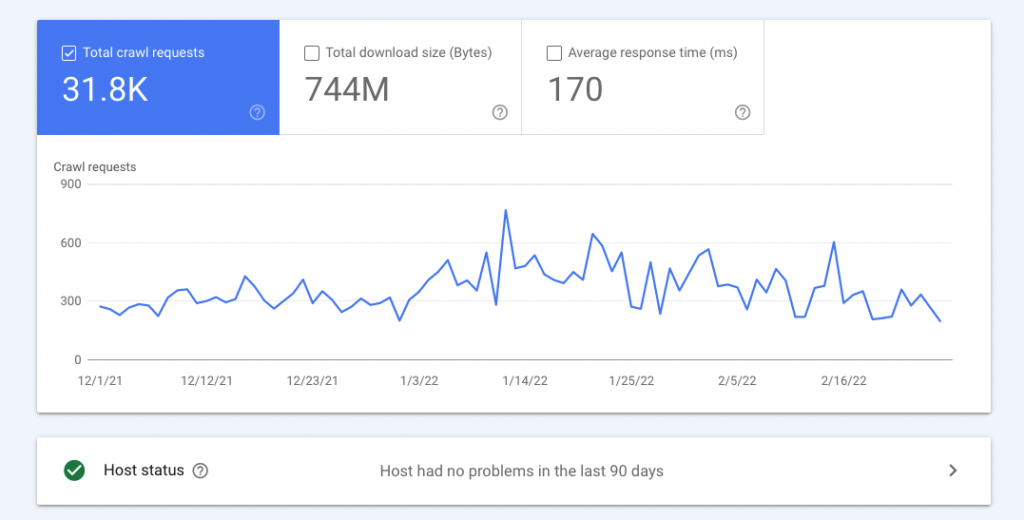

Ihre Crawling-Statistiken zeigen, wie viele Crawling-Anfragen der Googlebot insgesamt an Ihren Server gesendet hat und wann und ob er auf Probleme gestoßen ist.

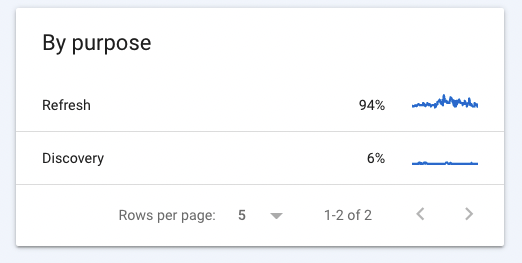

Ihr Crawl-Statistikbericht in der Google Search Console zeigt auch, was der Googlebot gefunden hat (Crawl-Antworten), Dateitypen, auf die er gestoßen ist, ob der Googlebot neue Seiten entdeckt oder alte neu indiziert hat und welche Googlebot-Typen zum Crawlen Ihrer Website verwendet wurden.

Wenn Sie in Ihrem Crawling-Statistikbericht auf eine Position klicken, erhalten Sie zusätzliche Informationen. Wenn Sie beispielsweise herausfinden möchten, welche Seiten einen 404-Fehler zurückgeben, klicken Sie auf diese Zeile im Feld Crawl-Antworten, um zu einer Liste mit URLs zu gelangen, die der Googlebot nicht finden konnte, und wann er zuletzt versucht hat, diese Seiten zu crawlen.

Durch Klicken auf die Zeilen „Aktualisieren“ oder „Erkennen“ unter „Crawling-Zweck“ können Sie sehen, welche URLs der Googlebot kürzlich indexiert hat. Wenn Sie feststellen, dass Ihre neuesten Seiten nicht indexiert wurden, können Sie sie ganz einfach über die Suchleiste oben im Bericht einreichen.

Crawling-Fehler

Crawling-Fehler treten auf, wenn Suchmaschinen nicht auf eine Ihrer Seiten zugreifen können. Sie können zwei Arten von Googlebot-Crawling-Fehlern in Ihrem Crawling-Bericht identifizieren, die sich negativ auf Ihre SEO auswirken können:

- Website-Fehler: Wenn Sie einen Website-Fehler haben, kann der Googlebot Ihre Website möglicherweise nicht crawlen. Websitefehler können durch fehlende oder unzugängliche robot.txt-Dateien, DNS-Auflösungsfehler oder Serververbindungsprobleme verursacht werden.

- URL-Fehler: Bei einem URL-Fehler kann der Googlebot eine bestimmte Seite nicht crawlen. Sie können mehrere URL-Fehler gleichzeitig haben.

Moz macht einen großartigen Job, wenn es darum geht, Crawling-Fehler zu beheben.

Blockierte URLs

Wenn es Bereiche Ihrer Website gibt, auf die der Google-Crawler nicht zugreifen soll, können Sie diese Verzeichnisse in robots.txt angeben, um Informationen darüber bereitzustellen, wie Robots Ihre Inhalte indexieren sollen.

Überprüfen Sie Ihre GSC, um die Anzahl der blockierten URLs anzuzeigen, die Google erkennt, um sicherzustellen, dass Ihre robots.txt-Datei funktioniert. Wenn die Anzahl der blockierten URLs geringer ist als sie sein sollte, müssen Sie Ihre robots.txt-Datei bearbeiten. Umgekehrt, wenn die Zahl höher ist als sie sein sollte, werden möglicherweise Seiten versehentlich für das Crawlen blockiert, die Sie in den Suchergebnissen anzeigen möchten.

URL-Parameter

Mit URL-Parametern, auch Abfragezeichenfolgen genannt, können Sie zusätzliche Informationen am Ende dynamischer URLs hinzufügen. Wenn Sie paginierten Inhalt besucht haben, z. B. Produktsuchergebnisse auf einer E-Commerce-Website, haben Sie wahrscheinlich „?page=2“ oder etwas Ähnliches am Ende der URL der Seite gesehen. Das ist ein URL-Parameter. Diese Parameter können auch verwendet werden für:

- Inhaltsfilter

- Übersetzungen

- Site-Suchen

- Verfolgung

Wenn Sie Parameter in Ihren URLs verwenden möchten, überlegen Sie, ob auf sie zugegriffen und sie indexiert werden sollen, da dies zu erheblichen Problemen wie doppelten Inhalten, verschwendetem Crawl-Budget und Tracking-Problemen führen kann.

Sie können diese Schritte ausführen, um das Crawlen von parametrisierten Inhalten zu blockieren.

Erfahren Sie mehr über Google Tools für SEO

Google bietet eine Vielzahl von Tools, mit denen Sie die Leistung Ihrer Website messen können. Nutzen Sie diese, um Ihre SEO-Strategie zu überwachen und zu verbessern.

Unser Leitfaden zu Google Tools führt Sie durch jedes der kostenlosen SEO-Tools von Google und unterteilt technische Konzepte in umsetzbare und leicht verständliche Kapitel voller zusätzlicher Ressourcen.

Ein Leitfaden für Google Tools für SEO

Laden Sie diesen Leitfaden herunter, um zu erfahren, wie Sie die kostenlosen, leistungsstarken Tools von Google optimal nutzen können, um Ihre SEO-Prozesse und -Leistung zu verbessern.