Ce este Googlebot? Tot ce trebuie să știți despre indexarea Google

Publicat: 2022-04-22Un site web optimizat este crucial pentru clasarea pe Google și pentru a fi găsit de publicul țintă. Optimizarea pentru motoarele de căutare (SEO) vă ajută să vă faceți site-ul mai lizibil și mai accesibil atât pentru crawlerii motoarelor de căutare, cât și pentru oameni.

Fiecare motor de căutare are propriile sale crawler-uri web unice, dar majoritatea strategilor de căutare se concentrează doar pe unul – Googlebot.

Deci, ce este Googlebot și cum vă puteți optimiza site-ul web pentru acesta?

Ce este Googlebot?

Googlebot este numele crawler-ului web al Google. Acesta „citește” pagini web și le indexează, astfel încât acestea să poată fi oferite celor care caută ca răspuns la termenii lor de căutare.

Googlebot are două locuri de muncă critice:

- Explorează continuu paginile web pentru noi link-uri, astfel încât să poată indexa cât mai mult conținut posibil și

- Acesta adună informații noi despre pagini pentru a menține actualizat indexul Google.

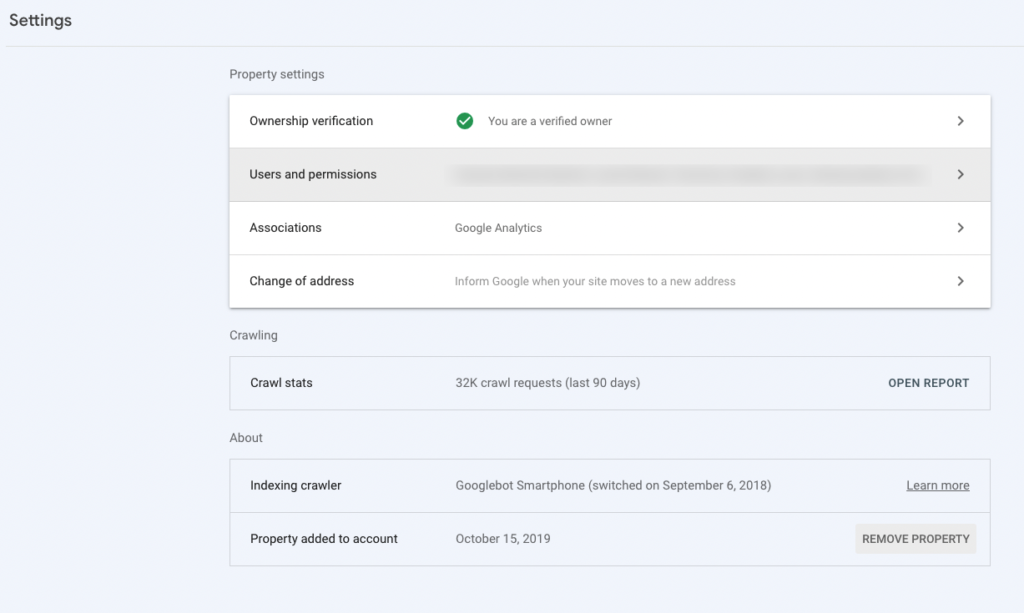

Deși există un singur nume, există de fapt două tipuri de Googlebot: unul pentru mobil (Googlebot Smartphone) și unul pentru desktop (Googlebot Desktop). Primul verifică cât de bine se redă site-ul tău pe smartphone-uri și tablete, în timp ce cel de-al doilea se concentrează pe versiunea desktop a site-ului tău.

Optimizarea Googlebot se referă la facilitarea accesului, accesarea cu crawlere și „citirea” de către Google a site-ului dvs. web. În timp ce multe tactici SEO influențează performanța căutării, există câteva implementări obligatorii care îmbunătățesc „indexabilitatea” site-ului tău și pot influența direct dacă paginile tale sunt sau nu disponibile pentru utilizatorii Google. Pe lângă tacticile SEO on-page și off-page, strategia dvs. SEO ar trebui să includă obiective tehnice SEO pentru a vă ajuta să vă creșteți șansele de a apărea în rezultatele motoarelor de căutare.

De ce să te concentrezi doar pe Googlebot? Dar crawlerele celorlalte motoare de căutare? Ei bine, deoarece Google deține în prezent 92% din piața de căutare, cea mai mare parte a publicului țintă îl folosește probabil. Cu toate acestea, recomandările care urmează ar trebui să faciliteze citirea paginilor pentru toți crawlerele.

Cum funcționează indexarea Google?

Când Google indexează un site, în esență îl adaugă la baza sa de cunoștințe și notează despre ce sunt paginile, cât de ușor de utilizat sunt acestea și multe altele. Dar de unde știe Googlebot că există un site web și că ar trebui să fie indexat?

Dacă ați mai creat un site web, probabil ați observat că nu ați primit trafic organic imediat ce l-ați publicat. Asta pentru că trebuie să faceți Googlebot conștient de site-ul dvs. web, astfel încât să vă poată accesa cu crawlere paginile. Puteți face acest lucru trimițând harta site-ului dvs. XML la Google Search Console (fostă Google Webmaster tools).

Googlebot accesează cu crawlere site-ul dvs. folosind hărți de site și conectează baze de date din accesările anterioare. Când găsește un link nou pe site-ul dvs. web, îl adaugă la lista de pagini de vizitat. Atât Googlebot Desktop, cât și Googlebot Smartphone vor actualiza indexul dacă întâlnesc linkuri întrerupte sau alte probleme.

Acesta este indexul de pe care Google îl extrage atunci când primește o interogare. Apoi utilizează indicii contextuale din căutare pentru a determina cum să ierarhească rezultatele relevante.

Cât de des accesează Google cu crawlere site-ul meu?

Google accesează cu crawlere adresele URL la rate diferite. În timp ce unele adrese URL pot fi accesate cu crawlere în fiecare zi, altele pot fi accesate cu crawlere doar săptămânal sau lunar. Dacă nu indicați altfel în fișierul robots.txt sau în etichetele meta robots, Googlebot va încerca să călătorească la fiecare pagină de pe site-ul dvs. web și să înregistreze informațiile pe parcurs, astfel încât să vă poată înțelege mai bine conținutul și să-și actualizeze indexul.

Deși până acum m-am concentrat în principal pe crawler-ul Googlebot, vreau să remarc că există de fapt mai multe crawler-uri Google. Puteți găsi lista completă a crawlerelor Google aici.

Dacă sunteți curios să aflați cât de des Google accesează cu crawlere și indexează site-ul dvs., accesați Google Search Console (GSC). Veți găsi raportul privind statisticile de accesare cu crawlere în setări.

5 pași pentru a vă optimiza site-ul pentru Googlebot

Urmați acești cinci pași simpli pentru a vă menține site-ul accesibil pentru motoarele de căutare, astfel încât paginile dvs. să poată fi găsite în căutare.

1. Păstrați codul simplu

O mare parte a creșterii posibilității de accesare cu crawlere a site-ului dvs. este de a menține lucrurile simple. Google nu va accesa cu crawlere Flash, Ajax, cadre, cookie-uri, ID-uri de sesiune sau DHTML și durează mai mult să indexeze JavaScript, deoarece trebuie să îl redeze.

Când vă construiți site-ul web, este esențial să urmați regulile generale și de calitate ale Google pentru a evita problemele de accesare cu crawlere și pentru a facilita indexarea paginilor.

2. Verificați-vă Robots.txt

Un fișier robots.txt îi spune lui Googlebot ce adrese URL poate accesa pe site-ul dvs. Utilizați directivele robot.txt pentru a evita supraîncărcarea site-ului cu solicitări și pentru a economisi mai mult buget de accesare cu crawlere pentru paginile pe care doriți să le indexeze de motoarele de căutare. Fără robots.txt, Googlebot ar putea petrece prea mult timp indexând media, fișierele de resurse sau alte pagini neimportante pe care nu doriți să le includă în rezultatele căutării. Robots.txt este o directivă la nivel de protocol. Ar trebui să aveți doar unul pe site-ul dvs. web, cu excepția cazului în care aveți mai multe subdomenii. Pentru a gestiona Googlebot și crawlerele pe o pagină cu pagină, utilizați etichete meta robot.

3. Utilizați legătura internă

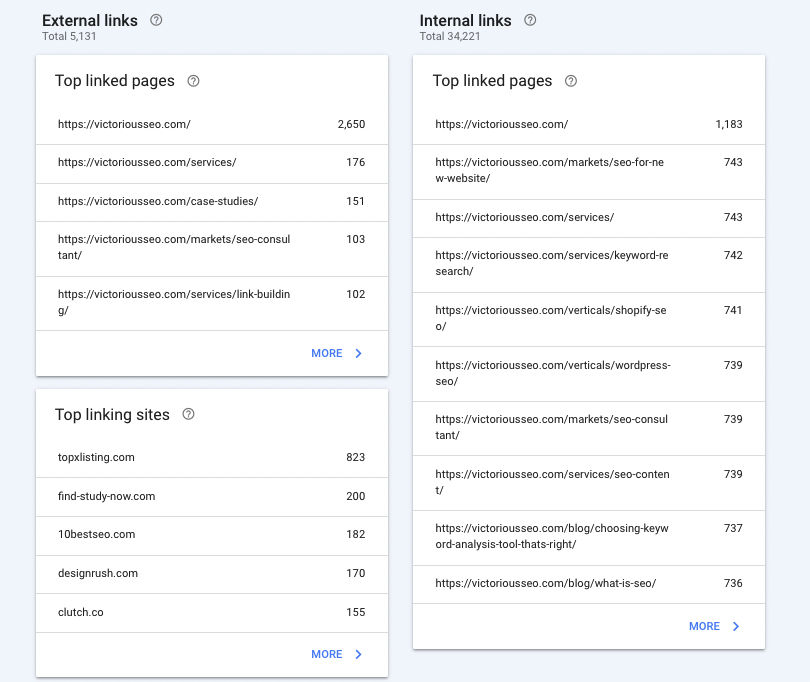

Link-urile interne sunt hyperlink-uri care vă duc de la o pagină la alta pe același site. Acestea pot fi de navigare (gândiți-vă la meniuri, bare laterale, antete, subsol) sau pot fi contextuale (plasate în corpul unei pagini). Pentru ca Googlebot să vă găsească mai ușor paginile și să înțeleagă modul în care acestea se relaționează între ele, utilizați linkurile interne pentru a vă accentua ierarhia site-ului. Toate paginile dvs. ar trebui să fie legate între ele într-un fel. De exemplu, pagina dvs. de pornire ar trebui să trimită către paginile dvs. de servicii, studiile de caz și blogul dvs. Fiecare dintre aceștia ar trebui apoi să trimită către paginile relevante.

Aflați mai multe despre cele mai bune practici de conectare internă aici.

Consultați Raportul Link-uri în GSC pentru a vă asigura că cele mai importante pagini, cum ar fi pagina de pornire și paginile de servicii, primesc cele mai multe link-uri. Acest lucru indică Google că acestea sunt cele mai importante pagini de pe site-ul dvs.

4. Creați un Sitemap XML

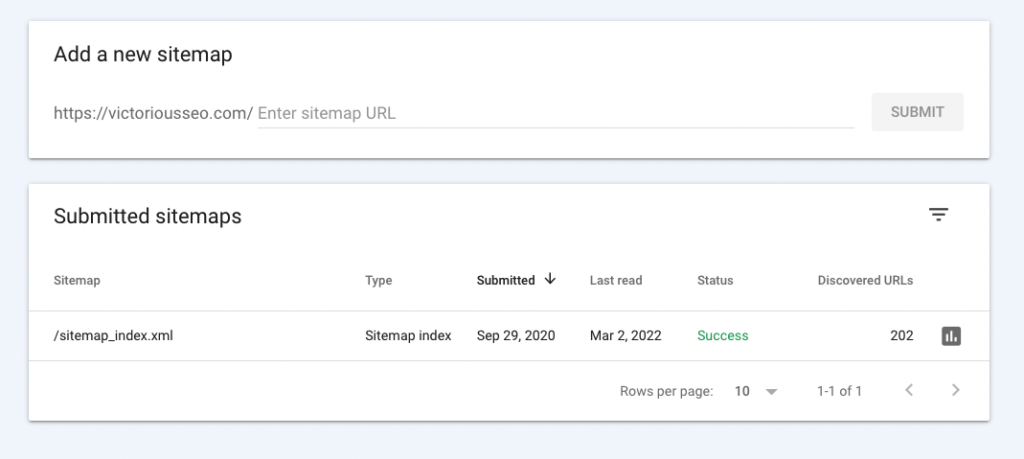

Pentru ca Googlebot să vă acceseze cu crawlere site-ul, furnizați un sitemap XML care vă organizează toate paginile pentru ca crawlerul web să înțeleagă rapid ierarhia site-ului dvs. (Nu sunt sigur ce este un sitemap XML, consultați un exemplu de sitemap și aflați mai multe aici.)

Trimiteți sitemap-ul dvs. XML la Google prin GSC în timpul procesului de verificare.

Dacă nu utilizați un sistem de gestionare a conținutului (CMS) care vă actualizează în mod dinamic harta site-ului, asigurați-vă că actualizați manual harta site-ului XML și retrimiteți-o când faceți modificări în ierarhia site-ului. Doar faceți clic pe „Sitemaps” din bara laterală din stânga. Acest lucru vă va ajuta să vă asigurați că Google indexează paginile adecvate de pe site-ul dvs.

5. Solicitați indexarea Google

Când publicați o pagină nouă sau faceți actualizări semnificative ale conținutului existent, nu trebuie să așteptați până când Google le găsește - spuneți Google că aveți o pagină nouă sau actualizată pe care să o scaneze solicitând indexarea.

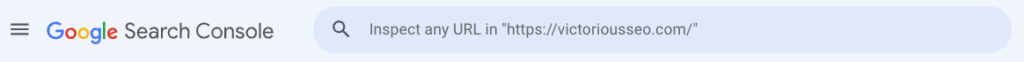

Conectați-vă la GSC și introduceți adresa URL pe care doriți să o indexați în stânga pictogramei lupă din partea de sus a paginii și apăsați Enter.

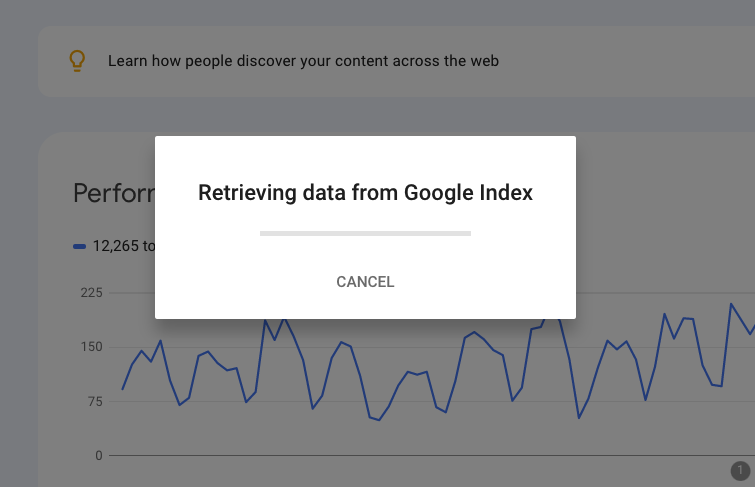

Google va observa că preia date.

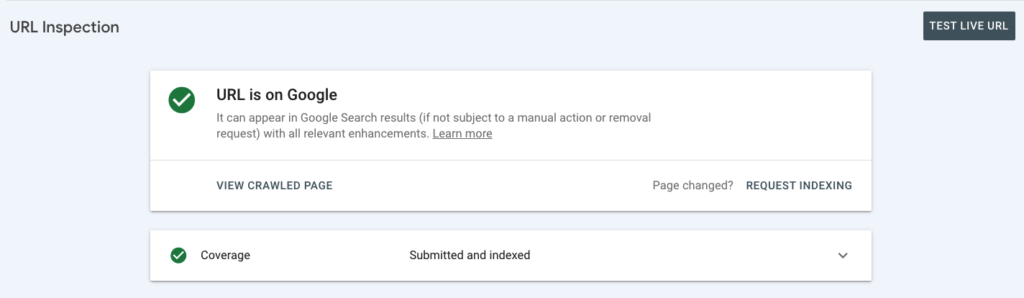

Și apoi vă va spune dacă pagina dvs. este deja indexată.

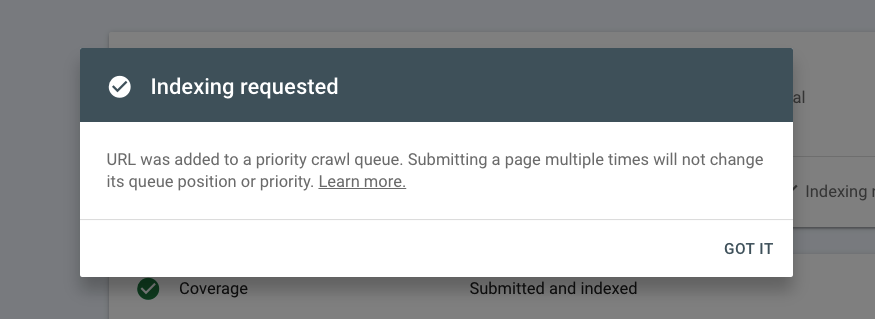

Dacă nu este, puteți solicita indexarea. Dacă pagina dvs. este indexată și i-ați făcut modificări semnificative, puteți solicita și indexarea.

Dacă adăugați frecvent pagini pe site, cum ar fi o nouă postare de blog sau o pagină de produs, faceți din acest proces parte din cele mai bune practici, astfel încât să vă asigurați că toate paginile sunt indexate fără întârziere.

Lectură recomandată

- Cum să utilizați Google Search Console

- Cum să adăugați utilizatori la Google Search Console

Patru moduri de a analiza modul în care Googlebot vă accesează cu crawlere site-ul

După ce v-ați optimizat site-ul pentru a facilita citirea unui crawler de motor de căutare, veți dori să verificați din nou dacă este accesat cu crawlere și indexat corect.

Statistici de accesare cu crawlere

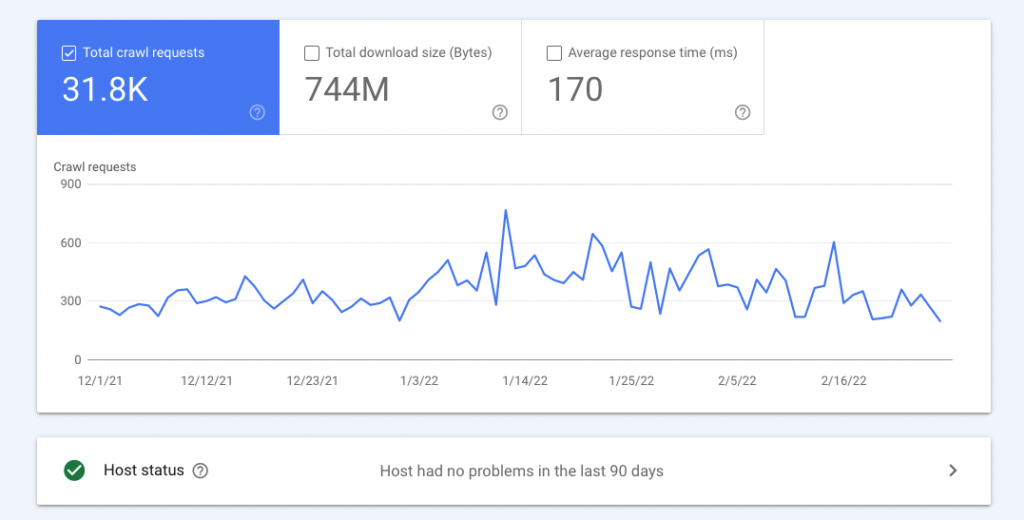

Statisticile dvs. de accesare cu crawlere arată câte solicitări de accesare cu crawlere a trimis Googlebot către serverul dvs. și când și dacă a întâmpinat probleme.

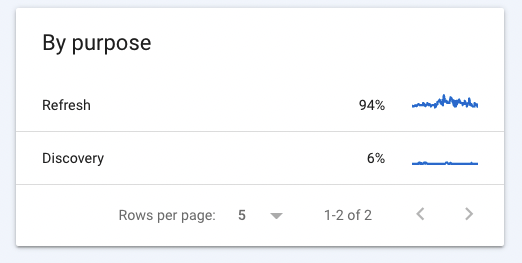

Raportul statistici privind accesarea cu crawlere din Google Search Console arată, de asemenea, ce a găsit Googlebot (răspunsuri la accesare cu crawlere), tipurile de fișiere pe care le-a întâlnit, dacă Googlebot descoperea pagini noi sau reindexa paginile vechi și ce tipuri Googlebot au fost folosite pentru a vă accesa cu crawlere site-ul.

Dacă dați clic pe un element rând din raportul dvs. de statistici de accesare cu crawlere, veți oferi informații suplimentare. De exemplu, dacă doriți să aflați ce pagini returnează o eroare 404, faceți clic pe acea linie din caseta de răspunsuri cu crawlere pentru a fi dus la o listă de adrese URL pe care Googlebot nu le-a găsit și când a încercat ultima dată să acceseze acele pagini.

Făcând clic pe elementele rând „reîmprospătare” sau „descoperire” din Scopul accesării cu crawlere, puteți vedea ce adrese URL a indexat recent Googlebot. Dacă observați că cele mai recente pagini ale dvs. nu au fost indexate, le puteți trimite cu ușurință folosind bara de căutare din partea de sus a raportului.

Erori de accesare cu crawlere

Erorile de accesare cu crawlere apar atunci când motoarele de căutare nu pot accesa una dintre paginile dvs. Puteți identifica două tipuri de erori de accesare cu crawlere Googlebot în Raportul de accesare cu crawlere care vă pot afecta negativ SEO:

- Erori de site: atunci când aveți o eroare de site, este posibil ca Googlebot să nu poată accesa cu crawlere site-ul dvs. Erorile site-ului pot fi cauzate de fișierele robot.txt lipsă sau inaccesibile, erori de rezoluție DNS sau probleme de conectivitate la server.

- Erori URL: cu o eroare URL, Googlebot nu poate accesa cu crawlere o anumită pagină. Puteți avea mai multe erori de adrese URL simultan.

Moz face o treabă grozavă de a împărtăși cum să remediați erorile de accesare cu crawlere.

Adrese URL blocate

Dacă există secțiuni ale site-ului dvs. pe care nu doriți să le acceseze crawlerul Google, puteți specifica acele directoare în robots.txt pentru a oferi informații despre cum ar trebui roboții să indexeze conținutul dvs.

Verificați GSC pentru a vedea numărul de adrese URL blocate pe care Google le recunoaște pentru a vă asigura că robots.txt funcționează. Dacă numărul de adrese URL blocate este mai mic decât ar trebui să fie, va trebui să editați fișierul robots.txt. În schimb, dacă numărul este mai mare decât ar trebui să fie, este posibil să existe pagini blocate din greșeală de la accesarea cu crawlere și pe care doriți să le apară în rezultatele căutării.

Parametri URL

Parametrii URL, cunoscuți și ca șiruri de interogare, vă permit să adăugați informații suplimentare la sfârșitul adreselor URL dinamice. Dacă ați vizitat conținut paginat, cum ar fi rezultatele căutării de produse pe un site de comerț electronic, probabil că ați văzut „?page=2” sau ceva similar la sfârșitul adresei URL a paginii. Acesta este un parametru URL. Acești parametri pot fi utilizați și pentru:

- Filtre de conținut

- Traduceri

- Căutări pe site

- Urmărire

Dacă doriți să utilizați parametri în adresele URL, luați în considerare dacă doriți ca aceștia să fie accesați și indexați, deoarece pot duce la probleme semnificative, cum ar fi conținut duplicat, buget irosit de accesare cu crawlere și probleme de urmărire.

Puteți urma acești pași pentru a bloca accesarea cu crawlere a conținutului parametrizat.

Aflați mai multe despre Instrumentele Google pentru SEO

Google oferă o varietate de instrumente pentru a vă ajuta să măsurați performanța site-ului dvs. Profitați de acestea pentru a vă monitoriza și îmbunătăți strategia SEO.

Ghidul nostru pentru instrumentele Google vă va ghida prin fiecare dintre instrumentele SEO gratuite de la Google și va descompune conceptele tehnice în capitole acționabile și ușor de înțeles, pline de resurse suplimentare.

Un ghid pentru instrumentele Google pentru SEO

Descărcați acest ghid pentru a afla cum să utilizați cât mai bine instrumentele gratuite și puternice oferite de Google pentru a vă îmbunătăți procesele și performanța SEO.