13 beste Data-Mining-Software für kleine bis große Unternehmen im Jahr 2022

Veröffentlicht: 2022-03-20Daten stehen im Mittelpunkt einiger der wichtigsten Entscheidungen, die moderne Unternehmen treffen, und Data Mining ist eine effektive Technik, um Ihnen dabei zu helfen.

Jedes Unternehmen hat mit einer überwältigenden Menge an Daten zu tun, die Ihrem Unternehmen bei richtiger Verwendung viele Vorteile bringen können.

Hier ist Data Mining sinnvoll.

Es kann Unternehmen dabei helfen, ihre betriebliche Effizienz zu optimieren, Kosten zu senken und fundierte Entscheidungen zu treffen.

Und mit Data-Mining-Software können Sie Data Mining effizient durchführen. Es wird dazu beitragen, den Prozess zu beschleunigen und Ihnen Zeit zu sparen, die Sie der Nutzung der gewonnenen Daten widmen können.

Lassen Sie uns mehr über Data Mining und die beste Data Mining-Software sprechen, die Sie ausprobieren können.

Was ist Data-Mining?

Data Mining bezieht sich auf einen Prozess des Suchens, Extrahierens und Auswertens von Daten. Daten können textuelle grafische Muster wie Kalligraphie, literarische und sprachliche Figuren, Statistiken usw. sein.

Data Mining entstand aus dem Bereich der Computerlinguistik in das Teilgebiet der Informatik, Linguistik, Kunstwissenschaften und mathematischen Statistik.

Ziel ist es, Daten mit Computerprogrammen, Analysen und intelligenten Methoden aus Datensätzen zu extrahieren, die Analyseergebnisse zu dokumentieren und diese Informationen neu zu strukturieren, um aussagekräftige Erkenntnisse gewinnen zu können.

Data Mining umfasst neben der Textanalyse auch Datenmanagement, Datenbankmanagement und Datenbankengineering. Das Datenmanagement beginnt mit der Datenvorverarbeitung, dem Erstellen von Datenmodellen und der Datenverarbeitung mit strengen und nicht strengen statistischen Schlussfolgerungen.

Wie funktioniert es?

Data Mining umfasst verschiedene Prozesse, beginnend mit dem Verständnis der Geschäftsanforderungen, warum Sie Daten extrahieren und verwenden müssen.

Der Prozess ist in drei Hauptphasen unterteilt – Datenvorverarbeitung, Data Mining und Ergebnisvalidierung.

Datenvorverarbeitung

Die Datenvorverarbeitung ist notwendig, um Variationen in Datensätzen zu verstehen, bevor das eigentliche Mining stattfinden kann.

Da Data Mining nützliche Muster in Datensätzen aufdecken kann, müssen Ihre Zieldaten umfangreich genug sein, um solche Muster zu enthalten. Darüber hinaus muss dieser Datensatz so prägnant sein, dass Sie die Daten innerhalb des erforderlichen Zeitrahmens abbauen können.

Bevor Sie also mit dem Mining von Daten beginnen, müssen Sie eine große Menge an Zieldatensätzen zusammenstellen, die Sie aus einem Data Warehouse beziehen können. Als nächstes müssen Sie diese Daten bereinigen, um unnötige Flusen und fehlende Informationen zu entfernen.

Data-Mining

Nachdem Sie die Zieldaten zusammengestellt haben, beginnt der eigentliche Prozess des Data Mining. Es umfasst sechs Hauptschritte – Anomalieerkennung, Abhängigkeitsmodellierung, Clustering, Klassifizierung, Regression und Zusammenfassung.

- Anomalieerkennung: Dies beinhaltet die Identifizierung unregelmäßiger Datensätze, die nützlich sein können oder einige Fehler enthalten.

- Abhängigkeitsmodellierung: In dieser Phase wird die Beziehung zwischen verschiedenen Variablen gefunden. Es wird auch als Assoziationsregellernen oder Warenkorbanalyse bezeichnet.

- Clustering: Es geht darum, Strukturen und Gruppen in Datensätzen zu entdecken, die ähnlich aussehen.

- Klassifizierung: Dies ist die Klassifizierung von Daten basierend auf bestimmten Parametern.

- Regression: Sie entdeckt Beziehungen zwischen Datensätzen oder Daten, um eine solche Funktion zu finden, die die Daten mit dem geringstmöglichen Fehler modellieren kann.

- Zusammenfassung: Hier visualisieren Sie Daten und erstellen Berichte, um eine kompakte, aussagekräftigere Darstellung der extrahierten Daten bereitzustellen.

Ergebnisvalidierung

Dies ist der letzte Schritt der Wissensentdeckung aus gesammelten Daten, um die im Data Mining generierten Muster zu überprüfen.

Nicht alle von Data-Mining-Algorithmen entdeckten Muster müssen gültig sein. Daher ist dieser Schritt entscheidend. Es wird auf einem Testdatensatz durchgeführt, wo die entdeckten Muster angewendet werden. Als nächstes wird die Ergebnisausgabe mit der gewünschten Ausgabe verglichen.

Erfüllen die Muster die gewünschten Standards, werden die erlernten Muster interpretiert und in sinnvolles Wissen umgewandelt. Wenn es jedoch nicht den Standards entspricht, müssen Sie die Ergebnisse neu bewerten, indem Sie die erforderlichen Änderungen in der Vorverarbeitungs- und Data-Mining-Phase vornehmen.

Warum brauchen Sie Data Mining?

Data Mining ist nützlich für Datenanalysen und Business Intelligence, um Unternehmen dabei zu helfen, tieferes Wissen über ihre Organisation, Kunden, Wettbewerber und Branche zu erlangen. Einige der Anwendungen von Data Mining sind:

- Vertrieb und Marketing: Unternehmen sammeln Informationen über ihre Zielkunden, um ihre Vertriebs- und Marketingbemühungen zusammen mit Produkten und Dienstleistungen zu optimieren.

- Bildung: Bildungseinrichtungen können mithilfe von Data Mining Schülerdaten extrahieren und diese zur Verbesserung der Bildungsqualität nutzen.

- Betrugserkennung: SaaS-Unternehmen, Banken und andere Organisationen können Data Mining verwenden, um Anomalien in ihrer Sicherheitslage zu erkennen und Cyberangriffe zu verhindern.

- Betrieb: Unternehmen können Data Mining nutzen, um ihren Betrieb zu optimieren, Kosten zu senken und fundierte Entscheidungen zu treffen.

Lassen Sie uns nun über einige der besten Data-Mining-Software sprechen.

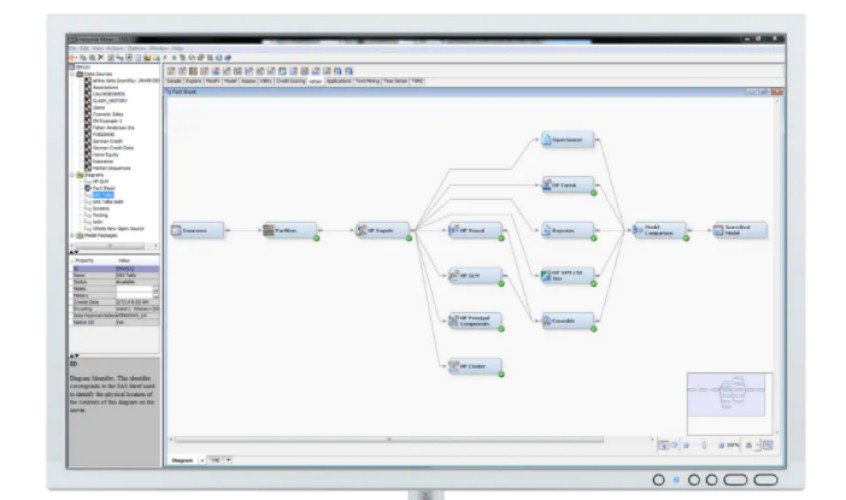

RapidMiner-Studio

Holen Sie sich eine umfassende Data-Mining-Plattform mit vollständiger Automatisierung und visuellem Workflow-Design von RapidMiner Studio. Mithilfe einer visuellen Drag-and-Drop-Oberfläche hilft es dabei, den Erstellungsprozess des Vorhersagemodells zu automatisieren und zu beschleunigen.

Sie erhalten mehr als 1500 Funktionen und Algorithmen, die in jedem Anwendungsfall das beste Modell gewährleisten. RapidMiner Studio bietet vorgefertigte Vorlagen für vorausschauende Wartung, Kundenabwanderung, Betrugserkennung und mehr.

Mit RapidMiner können Sie Point-and-Click-Verbindungen zu Enterprise Data Warehouses, Cloud-Speicher, Social Media, Geschäftsanwendungen, Data Lakes und Datenbanken erstellen. Anfänger finden in jedem Schritt auch proaktive Empfehlungen, um fortzufahren.

Führen Sie ETL und Datenvorbereitung in der Datenbank aus, um optimierte Daten für Analysen zu erhalten. Verstehen Sie Trends, Verteilungen und Muster mit Histogrammen, parallelen Koordinaten, Liniendiagrammen, Boxplots, Scatterplots usw., um Datenqualitätsprobleme, einschließlich fehlender Informationen und Ausreißer, schnell zu beheben.

Eliminieren Sie die harte Arbeit während der Datenvorbereitung mit RapidMiner Turbo Prep und erstellen Sie schnell wirkungsvolle und wertvolle Modelle für maschinelles Lernen, ohne eine einzige Codezeile zu schreiben. Es zeigt die tatsächliche Leistung des Modells, bevor es in die Produktion geht.

Erstellen Sie außerdem einfach zu erklärende und leicht verständliche visuelle Data-Mining-Workflows und implementieren Sie auch codehaltige und codebasierte Modelle in der Plattform.

Integrieren Sie RapidMiner in bestehende Anwendungen wie Python und R. Laden Sie die neuesten von der Community bereitgestellten Funktionen herunter und fügen Sie neue Funktionen über den Erweiterungsmechanismus hinzu.

Teradaten

Erleben Sie Daten, Einblicke und Ergebnisse mit Teradata Vantage. Es ist eine verbundene Multi-Cloud-Plattform, die alles für Unternehmensanalysen vereint.

Teradata hilft Ihnen dabei, Ihr Unternehmen voranzubringen, indem es ein Ökosystem für Unternehmensdatenanalyse, prädiktive Intelligenz und umsetzbare Antworten ermöglicht. Es bietet einen hybriden Ansatz, um den Anforderungen eines modernen Unternehmens gerecht zu werden.

Diese Multi-Cloud-Plattform bietet Ihnen die Portabilität und Flexibilität, um sie überall bereitzustellen, z. B. in lokalen und öffentlichen Clouds (Azure, AWS, Google Cloud). Die Expertenteams von Teradata können Ihnen dabei helfen, die Daten zu nutzen, um Ihre Geschäftsabläufe zu optimieren und einen beeindruckenden Wert zu erzielen.

Fragen Sie Ihr Inventar mit Teradata in Echtzeit ab und stellen Sie sicher, dass alles funktioniert und läuft, ohne sich Gedanken über die Betriebszeit machen zu müssen. Darüber hinaus liefert Teradata Vantage unzählige Informationen, die beim Aufbau eines Unternehmens der nächsten Generation helfen.

Darüber hinaus ermöglicht Ihnen die multidimensionale Skalierbarkeit auf Unternehmensniveau, die Dimensionen zu skalieren, um Ihre massiven Datenworkloads zu bewältigen. Erweitern Sie Ihre künstliche Intelligenz und Ihr maschinelles Lernen, um Ihre Modelle mit besseren Ergebnissen und besserer Qualität zu versorgen.

Stellen Sie Ihren Teams rollenbasierte und sichere No-Code-Software zur Verfügung, um 100 % Daten zu ziehen, die die wichtigsten Ziele Ihres Unternehmens unterstützen können. Es unterstützt auch alle Datenformate und -typen wie BSON, Avro, CSV, Parquet, XML und JSON.

Teradata Vantage wird Sie nicht mit zusätzlichen Kosten überraschen. Die intuitive Konsole ermöglicht es Ihnen, Ihre Ressourcennutzung einfach zu verfolgen, damit Sie wissen, wofür Sie bezahlen.

Oracle-Data-Miner

Oracle Data Miner ermöglicht es Unternehmen, Datenanalysten und Data Scientists, Daten anzuzeigen und direkt in der Datenbank zu arbeiten, indem ein einfacher Drag-and-Drop-Workflow-Editor verwendet wird.

Oracle Data Miner ist eine Erweiterung von Oracle SQL Developer, die die grafischen analytischen Workflow-Schritte dokumentiert und erfasst, die Benutzer unternehmen, um Daten zu untersuchen. Darüber hinaus ist der Arbeitsablauf einfach und nützlich für die Ausführung analytischer Methoden und den Austausch von Erkenntnissen.

Diese Plattform generiert PL/SQL- und SQL-Skripte und bietet schnell eine API zur Beschleunigung der Modellbereitstellung im gesamten Unternehmen. Sie erhalten außerdem ein interaktives Workflow-Tool zum Erstellen, Bewerten, Ändern, Freigeben und Bereitstellen von Methoden des maschinellen Lernens.

Darüber hinaus erhalten Sie Diagrammknoten zum Anzeigen von Daten, z. B. zusammenfassende Statistiken, Boxplots, Scatterplots und Histogramme. Verschiedene Knoten wie Transformations-, Spaltenfilter- und Modellerstellungsknoten helfen Ihnen, Ihr Geschäft voranzutreiben.

Oracle Data Miner kann die Zeit zwischen Modellentwicklung und Bereitstellung minimieren, indem Datenbewegungen eliminiert und die Sicherheit aufrechterhalten werden. Es wird auch Ihre Teams stärken, indem es ihnen hilft, mithilfe von Algorithmen für maschinelles Lernen vielfältige Fähigkeiten zu entwickeln.

MESSER

Erstellen und produzieren Sie Data Mining mit KNIME, das Ihrem Unternehmen End-to-End-Data-Science-Unterstützung bietet und die Produktivität steigert.

Sie erhalten zwei sich ergänzende Tools mit einer Plattform der Enterprise-Klasse. Sie erhalten auch KNIME Analytics, eine Open-Source-Plattform zum Erstellen und Bereitstellen kommerzieller KNIME-Server- und Data-Science-Modelle.

Darüber hinaus ist KNIME offen, intuitiv und kann kontinuierlich neue Entwicklungen integrieren, um Data-Science-Workflows zu verstehen und zu gestalten, die für alle zugänglich sind. Der KNIME-Server ist nützlich für die Teamzusammenarbeit, Verwaltung, Bereitstellung und Automatisierung.

Wenn Sie kein Experte sind, bietet KNIME Zugang zum KNIME-Webportal. Viele Erweiterungen wurden von KNIME selbst entwickelt, damit Sie etwas mehr tun können. Die Community und Partner bieten auch Erweiterungen an. KNIME lässt sich in Open-Source-Projekte integrieren, sodass Ihnen nie etwas fehlen wird.

Die KNIME Analytics Platform ist auf Amazon AWS und Microsoft Azure verfügbar. KNIME kann Ihnen helfen, auf alle Daten zuzugreifen, sie zu transformieren und zusammenzuführen und sie mit Ihren bevorzugten Tools zu analysieren. Es wird Ihr Unternehmen mit umfassenden Data-Mining-Praktiken und nützlichen Erkenntnissen aus den Daten unterstützen.

Laden Sie KNIME jetzt herunter und beginnen Sie mit der Erstellung Ihres ersten Workflows.

Orange

Data Mining macht jetzt Spaß mit Orange, das Open-Source-Datenvisualisierung und maschinelles Lernen bietet. Es bietet eine vielfältige Toolbox, um Datenanalyse-Workflows einfach und visuell zu erstellen.

Sie können einfache Datenvisualisierungen und -analysen durchführen und Boxplots, Scatterplots, statistische Verteilungen usw. untersuchen. Mit Orange können Sie mit hierarchischem Clustering, Heatmaps, Entscheidungsbaum, linearen Projektionen und MDS tiefer gehen.

Orange kann multidimensionale Daten in 2D-Visualisierungen mit besserer Attributauswahl und Rangfolge umwandeln. Sie finden auch eine grafische Benutzeroberfläche, um sich mehr auf die Datenanalyse zu konzentrieren, anstatt Zeit mit dem Codieren zu verschwenden.

Universitäten, Schulen und Schulungskurse auf der ganzen Welt nutzen Orange für seine großartigen Angebote. Es unterstützt die visuelle Veranschaulichung und das praktische Training von Konzepten aus dem Data Mining. Sie erhalten auch Widgets, um Ihr Training noch besser zu machen.

Verwenden Sie außerdem verschiedene Add-Ons, um Daten aus externen Quellen zu extrahieren, natürliche Verarbeitung und Text-Mining durchzuführen, Netzwerkanalysen durchzuführen, Itemsets abzuleiten und vieles mehr. Darüber hinaus können Molekularbiologen und Bioinformatiker Orange verwenden, um verschiedene Gene durch Anreicherungsanalyse und differentielle Expression einzustufen.

SAS

Gewinnen Sie wertvolle Erkenntnisse mit SAS Enterprise Miner – einer robusten Data-Mining-Software für Ihr Unternehmen. Es hilft Ihnen, den gesamten Prozess zu rationalisieren, um schnelle Modelle zu entwickeln und die wichtigsten Beziehungen zu verstehen.

SAS bietet mehrere Tools zur Entwicklung besserer Modelle. Mithilfe eines selbstdokumentierenden und interaktiven Prozessflussdiagramms können Sie den gesamten Data-Mining-Prozess abbilden, um bessere Ergebnisse zu erzielen.

Fachexperten und Geschäftsanwender mit begrenzten Kenntnissen können mit SAS Rapid Predictive Modeler ganz einfach ihre eigenen Modelle generieren. Sie können Ihre Vorhersagegenauigkeit auch verbessern, indem Sie Bewertungen und Vorhersagestatistiken aus den Modellen vergleichen, die mit verschiedenen Ansätzen erstellt wurden.

SAS eliminiert das manuelle Umschreiben, indem es Ihnen ermöglicht, das Modell automatisch bereitzustellen und Scoring-Code für alle Phasen zu generieren. Es bietet auch eine einfach zu handhabende GUI, Stapelverarbeitung, erweiterte Vorhersagen, deskriptive Modellierung, hohe Leistung, Open-Source-Integration, Cloud-Bereitstellungsoption, skalierbare Verarbeitung und mehr.

Qlik

Qlik Intelligence-Plattformen können die Lücke zwischen Erkenntnissen, Daten und Maßnahmen schließen. Es bietet Ihnen KI-gesteuerte, kollaborative, umsetzbare Echtzeit-Daten- und Analysevisualisierung.

Qlik beschleunigt die Aufnahme, Datenreplikation und das Streaming über verschiedene heterogene Mainframe-, SAP-, SaaS- und Datenbankanwendungen hinweg. Sie können die ETL- und Designcode-Generierung zusammen mit laufenden Updates automatisieren.

Die Plattform trägt dazu bei, Kosten, Risiken und Zeit für die Bereitstellung eines agilen Cloud-Data-Warehouse zu reduzieren. Sie können Pushdown- und moderne ELT-Ansätze verwenden, um Daten aus heterogenen Strukturen zu konvertieren, anzureichern, zu standardisieren, zu konsolidieren und zusammenzuführen.

Darüber hinaus rationalisiert und automatisiert der Cloud-native No-Code-Service von Qlik Ihre Arbeitsabläufe zwischen Qlik Sense und SaaS-Anwendungen, um Maßnahmen aus den Erkenntnissen zu empfehlen. Sie erhalten außerdem benutzerfreundliche Dashboards mit Interaktivität und vollständiger Unterstützung für Freiform-Exploration und -Suche.

Qlik nutzt KI, um die gesamte Analyse zu unterstützen, sodass mehr Benutzer einen extremen Wert aus den Daten ziehen können. Mithilfe offener APIs haben Sie die Möglichkeit, Analysen in betriebliche Anwendungen einzubetten und externe Anwendungen zu erstellen.

Wenn Sie eine plötzliche Änderung in den Daten feststellen, wird sofort die entsprechende Aktion veranlasst. Qlik bietet außerdem flexible Bereitstellungsoptionen, um lokale Governance-Anforderungen und Datenstandorte mit den zahlreichen Cloud-Optionen zu schützen.

Togawares Rassel

Rattle ist eine grafische Benutzeroberfläche für Data Science mit R. Es verwendet ein GUI-Toolkit, dh RGtk2, das aus dem Microsoft CRAN-Repository installiert werden kann.

Machen Sie sich mit den Fähigkeiten der Rattle-Software vertraut, die auch eine robuste Befehlszeilennutzung bietet. Es

- Zeigt visuelle und statistische Zusammenfassungen von Daten

- Transformiert dieselben Daten für die Modellierung

- Erstellt Modelle für unbeaufsichtigtes und überwachtes maschinelles Lernen

- Präsentiert leistungsstarke Modelle grafisch

- Bewertet die neuesten Datasets für die Bereitstellung.

Alle Interaktionen werden als R-Skript erfasst, das wiederum in R unabhängig mit der Rattle-Schnittstelle ausgeführt wird. Sie können das Tool erlernen und es verwenden, um Ihre Fähigkeiten in R zu entwickeln. Es wird Ihnen weiter helfen, erste Modelle mit leistungsstarken Optionen zu erstellen.

Rattle ist eine kostenlose Open-Source-Plattform und ihr Code ist im Bitbucket-Git-Repository verfügbar. Sie haben die Freiheit, den Code zu überprüfen, ihn für den gewünschten Zweck zu verwenden und zu erweitern.

Weka

Weka bietet Tools, um verschiedene Algorithmen für maschinelles Lernen zu implementieren, Daten zu verarbeiten und zu visualisieren.

Sie können Techniken des maschinellen Lernens bei Data-Mining-Problemen in der realen Welt anwenden. Es folgt einfachen Schritten:

- Sie erhalten Rohdaten aus dem Feld, das verschiedene irrelevante Felder und Nullwerte enthalten kann.

- Nutzen Sie die Datenvorverarbeitungstools von Weka, um die Daten zu bereinigen.

- Speichern Sie die bereinigten Daten im lokalen Speicher, um maschinelle Lernalgorithmen anzuwenden.

- Je nach Typ oder Modell des maschinellen Lernens wählen Sie aus den verfügbaren Optionen aus, darunter Klassifizieren, Clustern oder Zuordnen.

- Automatisieren Sie den Arbeitsablauf

Sie haben die Freiheit, jeden von Weka bereitgestellten Algorithmus auszuwählen und Ihre gewünschten Parameter festzulegen, um den Datensatz auszuführen. Erhalten Sie statistische Ergebnisse von Weka und ein Visualisierungstool für die Datenprüfung.

Es wendet verschiedene Modelle auf denselben Datensatz an, um die Ergebnisse der Modelle zu vergleichen und das Beste auszuwählen, das Sie benötigen.

Sinn

Die API-First-Analyseplattform Sisense liefert vollständig anpassbare und White-Label-Analysen, wann immer Sie sie brauchen.

Verwandeln Sie Ihren altmodischen Arbeitsstil und bauen Sie Ihr Geschäft aus, indem Sie die Macht der Daten entfesseln. Schalten Sie Daten aus lokalen und Cloud-Umgebungen für die Datenanalyse frei und erzielen Sie bessere Ergebnisse.

Sie können die mehrstufigen Aktionen in Ihrem Workflow automatisieren und benutzerdefinierte Erfahrungen erstellen, um die Workflows zu beschleunigen. Sisense bietet eine offene Cloud-Plattform, die durch Technologiepartnerschaften erweitert wird, um die Skalierbarkeit zu verbessern.

Darüber hinaus können Sie Ihren Workflows, Anwendungen, Produkten und Prozessen KI-gestützte Analysen hinzufügen, um die Intelligenz zur richtigen Zeit am richtigen Ort zu erleben und langsame Abläufe zu beseitigen.

Was auch immer Ihre Fähigkeiten sind, Sisense kann jeden in die Lage versetzen, Analysen effektiv einfließen zu lassen, um bessere Geschäftsentscheidungen zu treffen. Sie können auch die Produkte differenzieren, Ihre Verbraucher stärken und neue Streams mit KI-gestützten Analysen erstellen.

InetSoft

Die Stilintelligenz von InetSoft macht die Analyse schnell und einfach. Es handelt sich um eine webbasierte Plattform, die unabhängig von der Datenbankgröße auf Daten aus beliebigen Quellen zugreift und kleine Datensätze zur einfacheren und schnelleren Analyse verarbeitet.

Dies ist eine der besten Data-Mining-Software für Ihr Unternehmen, um eine Vielzahl von Datencaches zu durchsuchen und neue Marktforschungstools zu erhalten.

Style Intelligence kann Big-Data-Projekte handhaben und wurde mit einer proprietären Data-Grid-Cache-Technologie entwickelt, die auf MapReduce-Prinzipien basiert, die Big Data erleichtern.

Apache Mahout

Apache Mahout ist ein mathematisch ausdrucksstarkes Scala-DSL- und verteiltes Framework für lineare Algebra, das speziell für Datenwissenschaftler, Statistiker und Mathematiker entwickelt wurde, um ihre Algorithmen zu implementieren.

Dies ist ein Open-Source-Data-Science-Projekt, das bei der Erstellung von Algorithmen für maschinelles Lernen hilft. Es passiert eine Menge Dinge auf verschiedenen Ebenen. Es implementiert beliebte Lerntechniken, einschließlich Empfehlung, Klassifizierung und Clustering.

Die Algorithmen von Apache Mahout sind auf Hadoop geschrieben. Daher funktioniert es gut und verwendet die Hadoop-Bibliothek, um in der Cloud zu skalieren. Sie erhalten ein gebrauchsfertiges und einfach zu bedienendes Framework für Ihre Data-Mining-Aufgaben. Es ermöglicht Anwendungen auch, Big Data schnell und effektiv zu analysieren.

H2O

Holen Sie sich die Genmutations-KI, die mit H2O intelligente Entscheidungen direkt zu den Klinikern bringt. Es hilft Ihnen, Krankenhauseinweisungen im Zusammenhang mit COVID-19 zu verfolgen, zu verwalten und vorherzusagen.

H2O löst viele komplexe Probleme in Ihrem Unternehmen und beschleunigt innovative Ideen mit umsetzbaren Ergebnissen. Es kann die Art und Weise verändern, wie KI erstellt und genutzt wird, und verfügt über eine integrierte KI, die die Arbeit schneller und einfacher macht.

Darüber hinaus behält H2O Geschwindigkeit, Transparenz und Genauigkeit bei, sodass Sie Modelle ohne Einschränkungen erstellen können. Optimieren Sie Ihre Arbeitsabläufe entsprechend der Leistung, indem Sie die Daten überwachen, um eine aktuelle Entscheidung zu treffen.

Mit einem intuitiven KI-AppStore können Sie den Endbenutzern auf einfache Weise innovative Lösungen bereitstellen. Über 20.000 Organisationen nutzen H2O für die Data-Mining-Technologie. Es kann Ihnen helfen, Ihre Abläufe zu optimieren, indem es umsetzbare Erkenntnisse, optimierte Abläufe, reduzierte Risiken und personalisierte Erfahrungen liefert.

Starten Sie noch heute eine kostenlose 90-Tage-Testversion und sammeln Sie praktische Erfahrungen mit der KI-Cloud, um erstklassige Anwendungen und Modelle lokal und in der Cloud zu erstellen.

Fazit

Data Mining ist eine effektive Möglichkeit, aussagekräftige Informationen zu sammeln und für Ihr Unternehmen zu nutzen. Es hilft Ihnen, Ihre Abläufe und Kosten zu optimieren und bessere Geschäftsentscheidungen zu treffen.

Verwenden Sie dazu die beste Data-Mining-Software und gewinnen Sie immer wieder wunderbare Erkenntnisse für Ihr Unternehmen.