Ce este Web Scraping și cum se face?

Publicat: 2022-06-04Cuprins

- Ce este web scraping?

- De ce aveți nevoie de web scraping?

- Cum funcționează web scraping?

- Care sunt cele mai bune practici de scraping web?

- 5 dintre cele mai bune instrumente de scraping web

- Bucurați-vă să răzuiți web... cu prudență!

Dacă nu utilizați în prezent web scraping ca parte din arsenalul dvs., cu siguranță omiteți o oportunitate uriașă de a câștiga un avantaj față de concurența dvs.

Dacă sunteți ca majoritatea agenților de vânzări, sunteți mereu în căutarea unui avantaj față de concurență. Doriți să găsiți noi clienți potențiali, să consolidați relațiile cu clienții actuali și să obțineți o mai bună înțelegere a industriei dvs. în ansamblu.

Web scraping vă poate ajuta să faceți toate aceste lucruri și multe altele. Gândiți-vă la toate momentele în care v-ați dorit să obțineți o listă cu toate companiile din industria dvs. care sunt situate într-un anumit oraș. Sau poate ai vrut să obții o listă cu toate contactele unei anumite companii.

Web scraping vă poate ajuta să obțineți aceste informații rapid și ușor. Dar ce este și cum funcționează? În această postare pe blog, vom răspunde la aceste întrebări și la multe altele. Așa că continuați să citiți pentru a afla tot ce trebuie să știți despre acest instrument puternic!

Ce este web scraping?

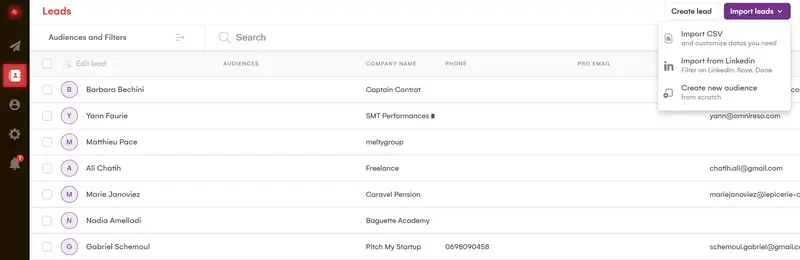

Imaginează-ți că a trebuit să te uiți la așa ceva toată ziua. Distracție, nu?

Acum imaginați-vă dacă există o modalitate de a sorta toate acele date în câteva secunde pentru a găsi un set organizat. Asta este practic ceea ce înseamnă scraping data.

Pe scurt, web scraping este o modalitate de a extrage date de pe site-uri web. De obicei, se face automat de către computere, dar se poate face și manual.

Există câteva moduri diferite de a face acest lucru, dar ideea de bază este să încărcați o pagină web și apoi să analizați codul HTML pentru a găsi datele dorite. Odată ce ați găsit datele dorite, le puteți salva într-un fișier sau bază de date pentru o utilizare ulterioară.

Web scraping poate fi util pentru o mare varietate de sarcini, cum ar fi obținerea unei liste cu toate numele și prețurile produselor dintr-un magazin online sau extragerea datelor de pe un forum web pentru a vedea ce spun oamenii despre un anumit subiect.

Web scraping este gratuit?

Majoritatea instrumentelor de scraping web sunt gratuite, deși există câteva opțiuni plătite. Opțiunile plătite oferă, de obicei, mai multe funcții și sunt mai ușor de utilizat, dar opțiunile gratuite vor face de obicei treaba bine.

Sfat rapid

Este legală web scraping?

Aceasta este cea mai frecventă întrebare adresată, iar răspunsul este... depinde. În general, este perfect să răzuiești date publice de pe site-uri web. Cu toate acestea, dacă eliminați date care sunt menite să fie private (cum ar fi informațiile de contact ale cuiva), atunci ați putea avea probleme legale.

Aceasta este o întrebare comună, iar răspunsul este... depinde. În general, este perfect să răzuiești date publice de pe site-uri web. Cu toate acestea, dacă eliminați date care sunt menite să fie private (cum ar fi informațiile de contact ale cuiva), atunci ați putea avea probleme legale.

Este întotdeauna o idee bună să verificați termenii și condițiile pentru site-ul web pe care îl eliminați pentru a vă asigura că nu încălcați nicio regulă.

Aici, la LaGrowthMachine, am dezvoltat propriile metode de scraping folosind mai multe surse de date și diferite tehnologii, ceea ce ne permite să avem una dintre cele mai bune caracteristici de îmbogățire a datelor de pe piață.

Recuperăm până la 28 de elemente de date diferite pe clienții noștri potențiali (urmând întotdeauna o abordare prietenoasă cu RGPD), ceea ce vă va permite să vă automatizați în funcție de variabile foarte precise și să fiți foarte natural în abordarea dvs.

Deși practica nu este recentă, ea tinde să devină mai răspândită și mai extinsă.

A devenit un atu esențial pentru marketerii în creștere și IMM-urile care doresc să combine eficiența și reactivitatea.

Bine, deci despre asta este tam-tam-ul, dar cu ce beneficii de fapt web scraping afacerea dvs.?

De ce aveți nevoie de web scraping?

Cel mai evident avantaj al web scraping este că vă poate economisi mult timp.

Imaginați-vă dacă ar trebui să copiați și să lipiți manual datele de pe site-uri web de fiecare dată când ați dori să faceți o cercetare de piață. Ar dura o veșnicie! Dar cu web scraping, puteți avea toate datele de care aveți nevoie în doar câteva minute.

Un alt mare avantaj este că vă poate ajuta să obțineți date care ar fi dificil sau imposibil de obținut în alt mod. De exemplu, dacă doriți să cercetați o nouă piață, web scraping vă poate ajuta să obțineți rapid și ușor o listă cu toate companiile din acea piață.

În plus, web scraping poate fi folosit pentru o varietate de sarcini, unele dintre cele mai comune utilizări includ:

- Generarea de clienți potențiali: eliminarea datelor de pe site-uri web poate fi o modalitate excelentă de a găsi clienți potențiali noi. De exemplu, puteți extrage date dintr-un director de afaceri pentru a găsi toate companiile din industria dvs. care sunt situate într-un anumit oraș.

- Cercetare de piață: Web scraping poate fi folosit pentru a colecta date despre o anumită industrie sau piață. Aceste date pot fi apoi analizate pentru a vă ajuta să înțelegeți mai bine piața în ansamblu.

- Analiza concurenței: monitorizarea concurenței este importantă în orice afacere. Prin eliminarea datelor de pe site-urile lor web, puteți înțelege mai bine produsele, prețurile și strategiile de marketing ale acestora.

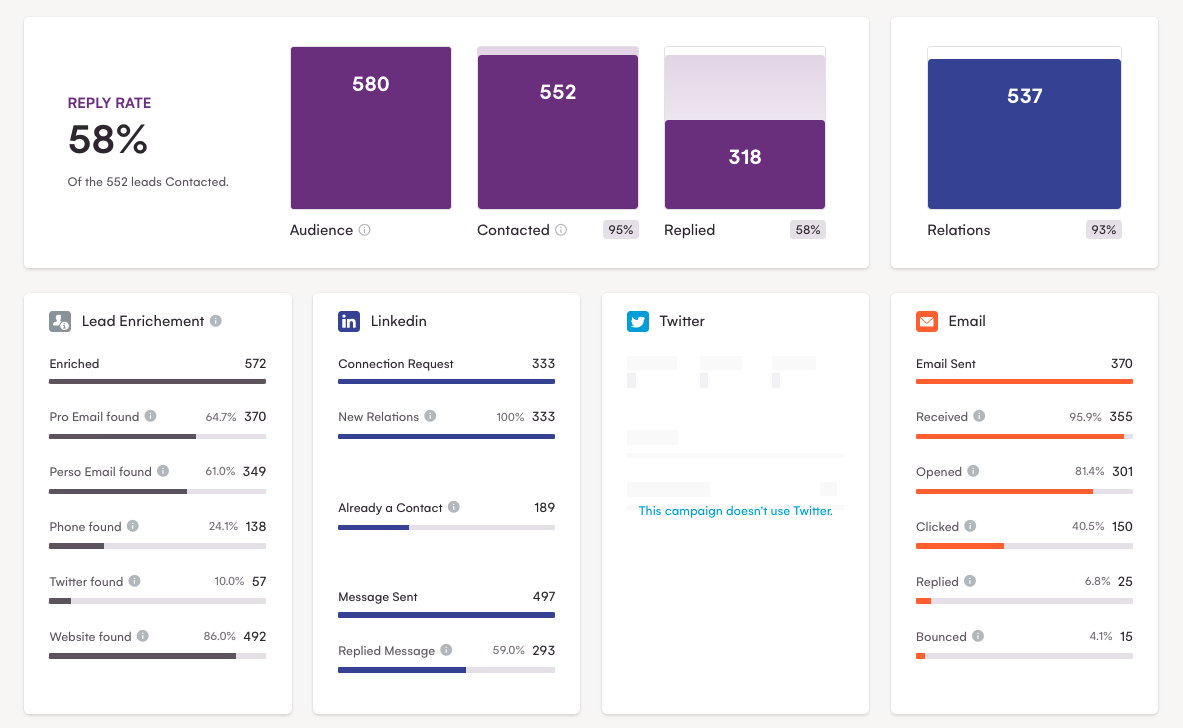

Mergând și mai departe, cu datele răzuite, puteți configura campanii multicanal în LaGrowthMachine.

După cum puteți vedea, această metodă este foarte reușită, cu o rată de răspuns de aproape 60%!

Acum că v-am făcut cunoștință cu web scraping și v-am arătat câteva dintre beneficiile sale, să aruncăm o privire la elementele de bază ale modului în care funcționează.

Cum funcționează web scraping?

Web scraping se face de obicei automat de către computere, dar poate fi făcută și manual.

Există câteva moduri diferite de a face acest lucru, dar ideea de bază este să încărcați o pagină web și apoi să analizați codul HTML pentru a găsi datele dorite. După ce ați găsit datele dorite, le puteți extrage într-un fișier sau bază de date pentru utilizare ulterioară.

De exemplu, să presupunem că doriți să extrageți datele dintr-un magazin online pentru a obține o listă cu toate numele și prețurile produselor.

În primul rând, ar trebui să găsiți și să încărcați pagina web pe care doriți să o răzuiți.

Apoi, ar trebui să scrieți un cod care să analizeze codul HTML al paginii web și să extragă datele de care sunteți interesat.

În cele din urmă, ar trebui să salvați datele într-un fișier sau bază de date.

Web scraping poate fi realizat într-o varietate de limbaje de programare, dar cele mai populare sunt Python, Java și PHP.

Dacă abia începi cu web scraping, îți recomandăm să folosești un instrument precum ParseHub sau Scrapy. Aceste instrumente facilitează extragerea datelor de pe site-uri web fără a fi nevoie să scrieți niciun cod.

Care sunt cele mai bune practici de scraping web?

Acum că cunoașteți elementele de bază ale scraping-ului web, să aruncăm o privire la câteva dintre cele mai bune practici de reținut.

Verificați termenii și condițiile

După cum am menționat anterior, trebuie să verificați termenii și condițiile pentru site-ul web pe care îl răzuiți. Acest lucru vă va asigura că nu încălcați nicio regulă și veți evita eventualele probleme - legale sau de altă natură - pe drum. De asemenea, este o idee bună să obțineți permisiunea de la proprietarul site-ului înainte de a-și elimina site-ul, deoarece este posibil ca unii webmasteri să nu fie prea încântați de asta.

Utilizați instrumentele potrivite

Există o varietate de instrumente diferite de scraping web disponibile, așa că este important să-l alegeți pe cel potrivit pentru nevoile dvs.

Apropo de asta, LaGrowthMachine este unul dintre ele!

Vom trece peste o listă cu cele mai bune instrumente de scraping web mai târziu în acest ghid, dar de dragul acestui punct, vom menționa doar câteva dintre cele mai populare:

- Scrapy: Scrapy este un cadru de scraping web scris în Python. Este unul dintre cele mai populare instrumente disponibile și este folosit de nume mari precum Google, Yahoo și Facebook.

- ParseHub: ParseHub este un web scraper care acceptă o mare varietate de limbi și platforme web.

- Octoparse: Octoparse este un alt web scraper care acceptă atât pagini web statice, cât și dinamice.

Nu supraîncărcați serverele

Când răzuiți date de pe site-uri web, este important să nu supraîncărcați serverele acestora cu prea multe solicitări. Acest lucru poate duce la interzicerea adresei dvs. IP de pe site. Pentru a evita acest lucru, asigurați-vă că vă distanțați solicitările și nu faceți prea multe simultan.

Gestionați erorile cu grație

Este inevitabil să te confrunți cu erori la un moment dat. Fie că este vorba despre un site web nefuncțional sau despre date care nu sunt în formatul pe care îl așteptați, este important să aveți răbdare și o atingere blândă atunci când faceți față acestor erori. Nu vrei să riști să spargi ceva pentru că ești prea grăbit.

Examinați-vă datele în mod regulat

Este important să vă revizuiți datele în mod regulat. Uneori, paginile web se schimbă și este posibil ca datele pe care le extrageți să nu mai fie exacte. Examinarea periodică a datelor vă va ajuta să vă asigurați că obțineți întotdeauna informații exacte.

Răzuiți în mod responsabil

Este important să fii respectuos față de site-urile web pe care le răzuiești. Aceasta înseamnă să nu răzuiți prea multe date, să nu răzuiți prea des și să nu curățați datele sensibile. De asemenea, asigurați-vă că vă păstrați racleta la zi, astfel încât să nu rupă din neatenție niciun site web pe care îl răzuiți.

Aflați când să vă opriți

Vor fi momente când nu veți putea obține datele dorite de la un site web. Când se întâmplă acest lucru, este important să știi când să te oprești și să mergi mai departe. Nu vă pierdeți timpul încercând să vă forțați scraperul web să funcționeze - există și alte site-uri web cu datele de care aveți nevoie.

Acestea sunt doar câteva dintre cele mai bune practici de care trebuie să țineți cont atunci când efectuați extragerea datelor. Respectarea acestor instrucțiuni vă va ajuta să vă asigurați că aveți o experiență pozitivă și să evitați eventualele probleme.

5 dintre cele mai bune instrumente de scraping web

După cum am menționat anterior, există o varietate de web scrapers disponibile, de la cadre complexe la instrumente simple. În această secțiune, vom trece peste câteva dintre cele mai populare instrumente de răzuit.

Acum... am menționat deja instrumentele de bază precum Scrapy și ParseHub, așa că vom trece rapid peste câteva dintre celelalte.

Piton

Python este una dintre cele mai evidente alegeri pentru nevoile dvs. de web scraping. Este un limbaj de scripting versatil care poate fi folosit pentru... răzuire a datelor, precum și pentru o gamă largă de alte sarcini.

Principalul avantaj al utilizării software-ului web scraping de la Python este că este relativ ușor de învățat și utilizat.

În plus, Python are o gamă largă de biblioteci și module care pot fi utilizate pentru extragerea datelor web, ceea ce îl face un instrument remarcabil de puternic.

Un dezavantaj este că scraperele web Python pot fi lente, mai ales dacă încearcă să curețe cantități mari de date.

În plus, unele site-uri web îi pot bloca accesul, ceea ce înseamnă că, de multe ori, web scraping cu Python poate fi mai consumatoare de timp și mai dificilă decât utilizarea altor instrumente de web scraping.

În general, extragerea datelor de pe web folosind Python are atât avantaje, cât și dezavantaje, dar rămâne o alegere populară pentru mulți oameni care doresc să scoată date de pe web.

Import.io

Acesta este un instrument de extragere a datelor web care vă permite să răzuiți date de pe site-uri web fără a fi nevoie să scrieți niciun cod. Este unul dintre cele mai ușor de utilizat instrumente de web scraping disponibile și bonus: este grozav pentru începători!

Include caracteristici minunate precum:

- O interfață ușor de utilizat de tip point-and-click

- Capacitatea de a răzui date din spatele unei autentificări

- Rotație automată a IP pentru a evita interzicerea

Ceea ce face import.io atât de grozav este că poate răzui date din mai multe pagini de pe un site web. Acest lucru este util dacă doriți să răzuiți date de pe un site web mare, cu multe pagini. Cu toate acestea, acest lucru înseamnă, de asemenea, că poate fi lent atunci când răzuiți datele de pe site-uri web care conțin o mulțime de pagini.

Un alt avantaj al import.io este că poate răzui date de pe site-uri web care sunt „dificil” de răzuit: ceea ce înseamnă că poate ocoli unele dintre mecanismele de protecție pe care site-urile le folosesc pentru a preveni răzuirea. Acestea fiind spuse, riscați ca instrumentul să se rupă atunci când site-urile web își schimbă mecanismele de protecție.

În general, import.io este un instrument excelent pentru a culege rapid date de pe web, dar este important să fii conștient de limitările sale.

Mozenda

Mozenda este un alt instrument de scraping web care nu necesită nicio codificare. Include funcții precum redarea paginilor web, accesarea cu crawlere a paginilor web și extragerea datelor.

Este o soluție grozavă, deoarece este ușor de utilizat și poate fi configurată pentru a răzui date de pe aproape orice site web.

Unul dintre principalele avantaje ale utilizării Mozenda este că este foarte rapid și eficient. Poate gestiona cantități mari de date foarte rapid și ușor.

În plus, este foarte ușor de utilizat. Interfața cu utilizatorul este intuitivă și ușor de utilizat. Există, de asemenea, o gamă largă de resurse online disponibile pentru a vă ajuta să începeți cu web scraping folosind acest instrument.

Cu toate acestea, unul dintre principalele dezavantaje este că este destul de scump. Dacă intenționați doar să utilizați web scraping pentru uz personal, atunci Mozenda poate să nu fie cea mai bună opțiune pentru dvs.

De asemenea, nu funcționează întotdeauna perfect. Uneori, site-urile web își pot schimba structura sau designul, ceea ce poate cauza probleme cu răzuirea web.

Apify

Ca platformă de scraping web, Apify vă permite să transformați site-urile web în date structurate. Oferă o gamă largă de funcții, inclusiv capacitatea de a răzui pagini web dinamice, de a crea API-uri și de a accesa cu crawlere site-uri web întregi.

Deși Apify este un instrument puternic, are câteva limitări:

În primul rând, nu este gratuit de utilizat, așa că, dacă nu dispuneți de numerar, s-ar putea să nu fie cea mai bună opțiune pentru dvs. De asemenea, poate fi dificil de configurat și utilizat, în special pentru utilizatorii care nu sunt familiarizați cu web scraping.

Oricum ar fi, acesta este unul dintre cele mai scalabile web scrapers pe care le puteți folosi. Platforma poate gestiona zgârieturi la scară largă, ceea ce o face ideală pentru companiile care trebuie să adune date la scară.

Cu toate acestea, această scalabilitate vine cu un dezavantaj; deoarece Apify poate gestiona astfel de scrape la scară mare, poate fi mai predispus la erori și unele date se pot pierde în timpul procesului de scraping.

În total, Apify rămâne o platformă populară de web scraping datorită flexibilității și gamei de caracteristici. Dacă sunteți în căutarea unei platforme de web scraping ușor de utilizat, cu o gamă largă de funcții, Apify poate fi o opțiune bună pentru dvs.

DiffBot

Diffbot este un software de scraping web care folosește inteligența artificială pentru a extrage date din paginile web. Oferă o gamă largă de funcții, inclusiv abilitatea de a răzui web pe scară largă, de a accesa cu crawlere site-uri web și de a extrage date din paginile web JavaScript.

Principalul avantaj al folosirii Diffbot este că este foarte precis. Instrumentul este capabil să extragă date specifice cu un grad ridicat de acuratețe, ceea ce înseamnă că este mai puțin probabil să întâmpinați erori atunci când utilizați instrumentul. De asemenea, are capacitatea de a răzui date din mai multe pagini și capacitatea de a gestiona solicitările AJAX, ceea ce este întotdeauna un plus.

În plus, este foarte ușor de utilizat. Interfața cu utilizatorul este intuitivă și ușor de utilizat și există o gamă largă de resurse online disponibile pentru a vă ajuta să începeți cu web scraping folosind Diffbot.

Cu toate acestea, unul dintre cele mai mari dezavantaje ale Diffbot este că este destul de scump, împreună cu incapacitatea sa de a răzui date de pe site-urile care folosesc JavaScript pentru a încărca conținut.

În plus, trebuie să aibă un site web bine structurat pentru ca acesta să funcționeze la maximum. Dacă nu, procesul de eliminare a datelor poate fi destul de lent.

Bucurați-vă să răzuiți web... cu prudență!

Web scraping poate fi o modalitate excelentă de a aduna date de pe web. Este rapid, eficient și relativ ușor de făcut. Cu toate acestea, există câteva lucruri de care trebuie să fii conștient înainte de a începe să faci scraping web.

În primul rând, web scraping poate fi ilegală în unele cazuri. Dacă intenționați să utilizați web scraping în scopuri comerciale, trebuie să vă asigurați că aveți dreptul legal de a face acest lucru.

În al doilea rând, web scraping poate fi o provocare. Deși există multe instrumente de scraping web disponibile care sunt destul de ușor de utilizat și nu necesită codare, unele site-uri web pot fi mai dificil de răzuit decât altele.

În sfârșit, web scraping poate consuma mult timp. Dacă intenționați să analizați un site web mare, poate dura ceva timp pentru a obține toate datele de care aveți nevoie.

Cu toate acestea, web scraping poate fi o modalitate excelentă de a culege date rapid și eficient. Doar asigurați-vă că sunteți conștient de riscurile implicate înainte de a începe web scraping.

Razuire fericita!