Mengapa Anda dapat (atau tidak dapat) memercayai laporan Anda?

Diterbitkan: 2022-04-12Menurut Harvard Business Review, 90% pemimpin bisnis percaya bahwa literasi data sangat penting untuk kesuksesan perusahaan. Namun, 84% pemasar mengalami kesulitan mengakses data dan wawasan. Dasbor dan laporan tidak menampilkan gambaran nyata dan tidak dapat dipercaya secara membabi buta.

Mengapa demikian? Kualitas data yang buruk dan kesalahan data adalah salah satu alasan utama mengapa Anda tidak dapat mempercayai laporan pemasaran Anda. Menurut survei Gartner, “dampak keuangan rata-rata dari kualitas data yang buruk pada organisasi diperkirakan mencapai $15 juta per tahun.”

Jika Anda tidak memercayai dasbor Anda dan data yang menjadi dasar pembuatannya, maka keputusan manajemen tidak akan dibuat berdasarkan angka sebenarnya. Dan untuk bisnis, itu mengerikan.

Dalam artikel ini, kami membahas semua kemungkinan kesalahan data dan tahapan di mana kesalahan tersebut dapat terjadi. Kemudian kami memberi Anda saran khusus tentang cara menghindarinya. Inilah daftar periksa Anda untuk mengatakan tidak pada kualitas data yang buruk!

Daftar Isi

- Mengapa masalah kepercayaan muncul

- Masalah kualitas data umum

- Perencanaan pengukuran

- Pengumpulan dan persiapan data

- Pembuatan laporan: menghubungkan analitik dengan nilai bisnis

- takeaways kunci

Mengapa masalah kepercayaan muncul

Jika Anda ingin perusahaan Anda berhasil, Anda harus memberdayakan pengguna bisnis dengan wawasan data berkualitas tinggi. Dengan semua informasi yang tersedia, pemasar dapat dengan mudah menjelaskan mengapa suatu keputusan berhasil, apa yang memengaruhi keberhasilan atau kegagalan kampanye iklan, apa yang dapat dilakukan dengan lebih baik, dll.

Selain itu, dengan lanskap media digital yang berkembang pesat, pelanggan menggunakan lebih banyak saluran media dan mengharapkan pendekatan yang dipersonalisasi yang didukung oleh data sehingga mereka dapat memperoleh rekomendasi yang tepat. Tidak masuk akal untuk mengabaikan kemampuan marketing analytics, terutama mengingat lebih dari 80% anggaran pemasaran mengandalkan saluran digital untuk menarik pelanggan. Seolah-olah Anda memiliki Ferrari yang kuat di garasi Anda dan takut mengendarainya!

Namun, menerapkan pendekatan logis dan lugas ini rumit: bagi para eksekutif dan pakar pemasaran untuk menerapkan data yang dikumpulkan, mereka harus memercayainya . Dan di situlah letak akar dari semua masalah.

Apa yang dapat dilakukan untuk meningkatkan kualitas data yang dikumpulkan dari semua saluran yang bekerja sama dengan pemasar dan meningkatkan kepercayaan pada temuan data? Mencegah kesalahan muncul!

Ada tiga tahap di mana kesalahan data biasanya muncul:

- Perencanaan pengukuran

- Pengumpulan dan persiapan data (normalisasi)

- Pembuatan laporan

Catatan! Pada setiap tahap ini, data dapat salah ditangani karena faktor manusia.

Mari kita lihat apa yang dapat dilakukan untuk menghentikan munculnya kesalahan. Lagi pula, lebih mudah untuk mencegah kesalahan daripada mencari kesalahan dan perbedaan data di seluruh sistem pelaporan.

Masalah kualitas data umum

Perencanaan pengukuran

Langkah pertama dalam bekerja dengan data tampaknya cukup mudah — Anda harus merencanakan pengumpulan semua data pemasaran yang Anda butuhkan. Namun, pengumpulan data sering direncanakan hanya untuk tugas tertentu, jadi Anda mungkin tidak memiliki cukup data untuk tugas baru yang Anda lakukan atau proyek baru yang Anda mulai. Oleh karena itu, melewatkan langkah perencanaan tidak masuk akal. Tim OWOX selalu melakukan analisis ekspres sebelum mereka mulai mengerjakan sebuah proyek. Mengapa? Untuk mengidentifikasi kemungkinan hambatan dalam pengumpulan data. Terkadang tim bahkan mengembangkan seluruh sistem metrik dan menghitung semua parameter yang mungkin.

Tantangannya adalah mengumpulkan semua data yang terfragmentasi dari semua sumber data (platform dan layanan periklanan yang berbeda yang Anda gunakan) dan membuat data ini berfungsi untuk Anda.

Tidak adanya tahap perencanaan ini, atau pendekatan tidak terstruktur, mengarah pada konfigurasi ulang transfer pengidentifikasi sementara data historis tidak tersedia. Jika Anda tidak memiliki semua data, keputusan dan tindakan Anda akan didasarkan pada informasi yang salah atau tidak lengkap. Untuk menghindari hal ini, Anda perlu mempertimbangkan semua poin kontak pelanggan dengan mengumpulkan:

- Data perilaku pengguna dari situs web dan/atau aplikasi Anda

- Data biaya dari platform periklanan

- Pelacakan panggilan, chatbot, dan data email

- Data penjualan aktual dari sistem CRM/ERP Anda, dll.

Klien kami

tumbuh 22% lebih cepat

Tumbuh lebih cepat dengan mengukur apa yang paling berhasil dalam pemasaran Anda

Analisis efisiensi pemasaran Anda, temukan area pertumbuhan, tingkatkan ROI

Dapatkan demoPengumpulan dan persiapan data

Mengumpulkan data pemasaran

Kesalahan utama yang dapat muncul pada tahap ini adalah hasil dari:

- Mendapatkan agregat, data sampel . Data sampel adalah data umum yang terjadi ketika hanya sebagian data yang dianalisis dan digunakan untuk pelaporan. Mari kita bayangkan Anda memiliki satu kilo apel dan tugas Anda adalah memutuskan apakah apel ini baik atau busuk. Jika Anda menggunakan data sampel (dua atau tiga apel dari seluruh tandan), Anda dapat memutuskan bahwa kilo ini memiliki kualitas yang sangat baik padahal sebenarnya semua apel lain yang tidak Anda sampel busuk.

Mengapa ini terjadi? Karena memproses susunan data yang sangat besar dalam waktu sesingkat mungkin adalah tugas yang rumit dan intensif sumber daya, sistem memproses data dengan cepat dengan menggunakan pengambilan sampel data, agregasi, dan pemfilteran untuk menghasilkan laporan secepat mungkin.

Bagaimana pengaruhnya terhadap kualitas data dan laporan? Jelas, buruk. Keputusan cerdas tidak dapat dibuat hanya berdasarkan sampel data yang kecil. Misalnya, Anda mungkin tidak melihat kampanye iklan yang menguntungkan dan mungkin menonaktifkannya karena data yang terdistorsi dalam laporan.

Bagaimana Anda bisa mengidentifikasi masalah ini? Di antarmuka Google Analytics, Anda akan melihat pesan di bagian atas laporan yang menyatakan Laporan ini didasarkan pada N% sesi .

Jika Anda ingin memiliki laporan yang dapat dipercaya, Anda harus mendapatkan data mentah tanpa sampel. Jadi setelah memutuskan semua sumber data, sebaiknya Anda menggunakan konektor yang secara otomatis mengumpulkan data mentah dan memeriksa kelengkapan data secara teratur.

- Mendapatkan data yang tidak lengkap dan salah dari API layanan iklan . Mengapa ini terjadi? Layanan periklanan mengumpulkan banyak data tentang pengguna dan perilaku mereka; namun, saat mentransmisikan data, kesalahan seperti penggandaan data, kehilangan data, atau perbedaan selama pembaruan retrospektif mungkin muncul. Bagaimana pengaruhnya terhadap kualitas data dan laporan Anda? Kesalahan ini ditransfer ke dalam laporan, dan akibatnya, tidak mungkin membuat keputusan yang tepat karena pelaporan yang tidak akurat.

Bagaimana cara memperbaiki masalah ini? Karena tidak mungkin untuk mengontrol kode secara langsung saat bekerja dengan API, mungkin sulit untuk berinteraksi dengan layanan. Kami sangat menyarankan untuk menggunakan alat impor data yang mendukung perubahan API. Jika data tidak tersedia, alat ini dapat menunjukkan kesenjangan data yang ada dan mengunduh data setelahnya.

Di mana saya menyimpan semua informasi ini?

Jika Anda ingin menyimpan setiap byte data di server Anda sendiri, Anda harus membayar mahal. Sebaiknya gunakan solusi cloud, karena solusi tersebut akan menghemat sumber daya Anda dan menyediakan akses ke data secara global. Tanpa pertanyaan, opsi terbaik di pasar yang mempertimbangkan kebutuhan pemasar adalah Google BigQuery. Anda dapat menggunakan layanan cloud ini untuk menyimpan data mentah dari situs web, sistem CRM, platform periklanan, dll.

Pada dasarnya, pilihan terbaik untuk menghindari kesalahan dalam pengumpulan data adalah dengan tidak pernah mengumpulkan data secara manual. Saat ini, ada banyak sekali solusi perangkat lunak pemasaran seperti OWOX BI yang secara otomatis mengumpulkan data ke dalam gudang data (atau danau data) dari berbagai layanan dan situs web.

Batasan data pemasaran

Selama bertahun-tahun, pemasaran bergantung pada data pihak ketiga. Tapi sekarang perusahaan besar berpengaruh seperti Google dan Apple mengubah cara mereka menggunakan data pribadi. Segera, dunia akan meninggalkan cookie pihak ketiga. Bagi pemasar, ini berarti pengumpulan data yang rumit dan kehilangan banyak data berharga tentang aktivitas pengguna di berbagai titik kontak. Apa yang dapat dilakukan untuk mempertahankan kinerja Anda? Pertama dan terpenting, Anda harus fokus mengumpulkan data pihak pertama dan pihak kedua. Kedua, Anda harus siap untuk menggunakan data lake, karena hanya data yang disimpan di lake tersebut yang dimiliki dan dikendalikan oleh Anda (dan bukan oleh platform iklan). Karena pembaruan dalam produk Google (Google Analytics 4, inisiatif Kotak Pasir Privasi), sebaiknya gunakan Google BigQuery, karena versi baru Google Analytics memiliki integrasi asli dengan GBQ dan menyediakan ekspor data lengkap.

Normalisasi data

Langkah kedua setelah mengumpulkan semua data adalah memanfaatkannya. Namun, Anda tidak bisa langsung melakukannya. Data tidak mungkin digunakan sampai data disiapkan (dinormalisasi). Mengapa begitu? Data dari platform/layanan periklanan yang berbeda memiliki struktur yang berbeda dan dalam format dan mata uang yang berbeda. Untuk dapat membuat laporan, Anda memerlukan data yang terstruktur, diperbarui, dan lengkap.

Saat mencoba menormalkan data, Anda dapat menghadapi tantangan terkait dengan:

- Format, struktur, dan tingkat detail data yang berbeda. Mengapa demikian? Layanan yang berbeda menggunakan skema yang berbeda untuk mengunggah data. Misalnya, satu layanan periklanan mungkin memiliki kolom bernama Product name , sedangkan yang lain memiliki kolom bernama Product category .

Bagaimana hal ini memengaruhi kualitas data dan laporan? Tidak mungkin membuat laporan jika data berada dalam struktur yang berbeda.

Bagaimana cara memperbaiki masalah ini? Sebelum menganalisis data, itu harus dikonversi ke format tunggal; jika tidak, tidak ada hal baik yang akan keluar dari analisis Anda. Misalnya, Anda harus menggabungkan data sesi pengguna dengan data biaya iklan untuk mengukur dampak dari setiap sumber lalu lintas atau saluran pemasaran tertentu dan untuk melihat kampanye iklan mana yang memberi Anda lebih banyak pendapatan.

- Mata uang yang berbeda. Layanan periklanan yang berbeda menggunakan mata uang yang berbeda, dan untuk mendapatkan angka yang benar dalam laporan Anda, Anda harus selalu memeriksa mata uang mana yang digunakan dan mengonversi semua mata uang menjadi satu mata uang dasar.

- Ketergantungan penyisipan, pembaruan, dan penghapusan. Sementara menghilangkan data tidak terstruktur agar seragam sempurna di semua catatan dan bidang, berbagai efek samping yang tidak diinginkan mungkin muncul.

Bagaimana ketergantungan ini mempengaruhi kualitas data dan laporan? Hasil paling umum dari kesalahan tersebut adalah bahwa data dibuang oleh sistem dan tidak diperhitungkan saat membuat laporan, sehingga membuat laporan itu sendiri menjadi salah. Misalnya, kita memiliki objek sesi dan objek iklan . Dalam sesi , kami memiliki data untuk hari 10 hingga 20, dan dalam iklan ada data dari hari 10 hingga 15 (untuk beberapa alasan tidak ada data biaya untuk hari 16 hingga 20). Oleh karena itu, kami kehilangan data dari iklan selama hari ke 16 hingga 20 atau data dari sesi hanya akan tersedia untuk hari ke 10 hingga 15.

Bagaimana cara memperbaiki masalah ini? Jika pengguna tidak mengetahui kekhasan penggabungan data dan tidak memverifikasi data yang mereka gunakan, kemungkinan membuat kesalahan sangat tinggi. Oleh karena itu, solusinya adalah memeriksa data Anda sebelum menggunakannya.

Catatan! Normalisasi data adalah "pekerjaan monyet" manual dan rutin yang tidak terlalu menginspirasi dan mencegah analis mengekstraksi wawasan. Kesulitan normalisasi biasanya memakan waktu hingga 50% dari waktu kerja seorang analis. Dan jujur saja: ini cukup membuat frustrasi. Untuk mencegah hal ini terjadi, gunakan alat otomatisasi!

Bagaimana mengatasi masalah ini?

Jalan keluar yang sempurna adalah dengan menerapkan solusi otomatis yang dapat mengumpulkan, membersihkan, menormalkan, dan memantau kualitas data Anda sehingga siap untuk bisnis. Varian yang lebih baik lagi adalah jika konektor data pilihan Anda dapat melakukan semuanya untuk Anda, seperti yang dilakukan oleh platform OWOX BI all-in-one. Dengan bantuan OWOX BI, Anda dapat dengan mudah menghadapi semua tantangan yang menunggu pemasar dan analis dan mendapatkan data siap bisnis yang dapat Anda percayai.

Pengumpulan data dan kesalahan normalisasi tidak akan pernah mengganggu Anda dengan OWOX BI. Layanan ini membebaskan waktu Anda yang berharga dan menangani:

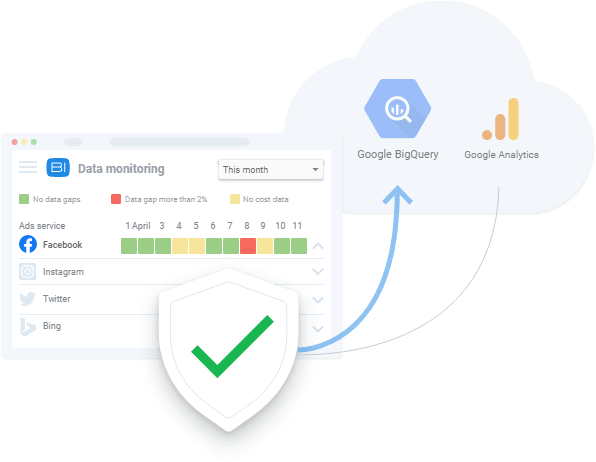

- Pengumpulan data. Dapatkan semua data yang Anda butuhkan dari Google Analytics, layanan periklanan, situs web Anda, toko offline Anda, layanan pelacakan panggilan, dan sistem CRM ke Google BigQuery. OWOX BI memungkinkan Anda memperoleh laporan tanpa mengambil sampel pada parameter apa pun yang tersedia. Layanan ini mengumpulkan data mentah dan memperingatkan Anda jika terjadi kesalahan dalam transfer data API. Yang harus Anda lakukan adalah memberikan akses ke sumber data dan memilih data apa yang ingin Anda kumpulkan.

- Pemantauan data. Anda selalu dapat melihat di mana Anda memiliki perbedaan data, selama periode apa, dan seberapa kritisnya dengan bantuan OWOX BI. Ini membandingkan jumlah data dalam proyek BigQuery Anda setiap hari menurut klik, sesi, pengguna, dan transaksi dengan Google Analytics dan menandakan perbedaan yang signifikan.

- normalisasi data. OWOX BI membantu Anda membersihkan, menghapus duplikasi, dan memperbarui data serta mengubah biaya menjadi satu mata uang dasar dan memantau relevansi data. Selain itu, OWOX BI dapat menentukan kesalahan dalam tag UTM seperti parameter dinamis yang tidak didukung, kesalahan sintaksis, atau kekurangan tag UTM wajib.

Dengan OWOX BI, Anda dapat mengumpulkan data pemasaran untuk laporan kompleksitas apa pun di penyimpanan cloud BigQuery Google yang aman, yang merupakan pilihan terbaik untuk kebutuhan pemasaran.

Pembuatan laporan: menghubungkan analitik dengan nilai bisnis

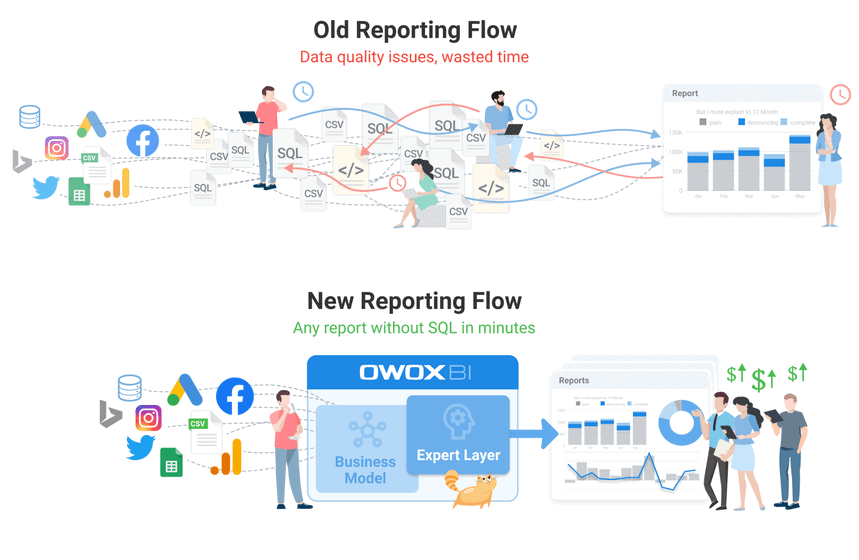

Menurut survei, 84% pemasar mengalami kesulitan mengakses data dan wawasan, sedangkan 86% berpikir mereka membutuhkan alat yang lebih baik untuk mendapatkannya. Sederhananya, pemasar ingin memiliki laporan segera setelah mereka memikirkannya. Keuntungan bisnis ketika tim pemasaran menerapkan wawasan sedangkan tim analitik mengekstraksinya. Dan dengan semakin banyak data perilaku pengguna yang dikumpulkan oleh pemasar, seharusnya mudah untuk mendapatkan wawasan yang bermanfaat. Namun, dalam praktiknya, hal-hal sering bekerja dengan cara yang sangat berlawanan.

Setelah mengatasi kendala di tingkat pengumpulan data dan persiapan data, masih ada beberapa kesulitan lain dalam pembuatan laporan seperti:

- Memutuskanmodel atribusi mana yang akan digunakan. Tidak ada jawaban yang benar, karena model yang berbeda diperlukan untuk tugas yang berbeda. Juga, Anda harus mengingat kekhasan bisnis Anda. Ikhtisar mendetail dari semua model atribusi di pasar dapat membantu Anda memilih yang terbaik untuk Anda.

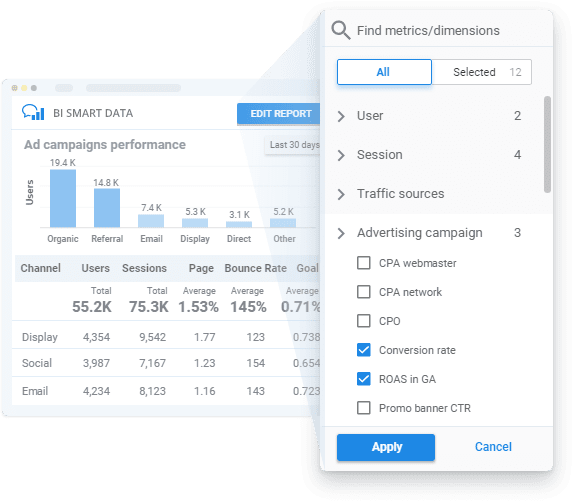

- Memutuskanyang melaporkan layanan bangunan untuk digunakan. Pilih layanan yang dapat dengan mudah memberikan visualisasi data yang dapat dipahami dan dapat memperbarui laporan secara otomatis. Harap perhatikan bahwa meskipun layanan visualisasi data seperti Google Data Studio dapat bekerja dengan lebih dari dua sumber data, namun tetap tidak mungkin menggunakannya untuk menggabungkan dan mengubah data. Jika Anda ingin membuat laporan berdasarkan banyak sumber data, Anda harus terlebih dahulu mengumpulkan semua data yang diperlukan ke dalam data lake (mis. Google BigQuery).

Semakin rumit keseluruhan ekosistem pelaporan (terutama untuk bisnis perusahaan) dan semakin banyak laporan dan kueri SQL yang dibuat, semakin mudah sistem rusak. Terlepas dari kesalahan data faktual, mungkin juga muncul berbagai kesulitan yang dapat menyebabkan lebih banyak kesalahan, kueri SQL yang rusak, atau kesalahpahaman dan penyalahgunaan data yang dikumpulkan .

- Terlalu banyak pengeditan pada laporan (dan/atau kueri SQL) dalam waktu singkat. Mengapa ini terjadi? Dalam arsitektur pelaporan klasik, ada kumpulan data di bawah setiap laporan yang dibuat menggunakan kueri SQL dan tidak ada yang berubah. Tapi hari ini, kueri SQL ini diubah dan diedit sesekali. Bagaimana hal ini memengaruhi kualitas data dan laporan? Ada begitu banyak perubahan sehingga mudah untuk melupakan perubahan apa yang dilakukan dan kapan. Ini berarti bahwa pengeditan pada tingkat satu set data tidak diterapkan ke set data lain.

- Persyaratan terus berubah (dan transisi ke versi baru Google Analytics 4 dan batasan penggunaan data tidak membuatnya lebih mudah). Mengapa ini terjadi? Sementara kebutuhan akan laporan yang berbeda semakin meningkat, analis perlu membuat kumpulan data, menormalkan data, dan menulis kueri SQL untuk setiap laporan. Bagaimana pengaruhnya terhadap kualitas data dan laporan? Saat makna suatu objek diubah — misalnya, apa yang dipahami sebagai konversi berubah menjadi kunjungan situs web alih-alih membuat pesanan — merupakan tantangan untuk mengingat apa yang perlu diubah agar data tetap akurat dan benar di setiap laporan.

- Proses pelaporan yang lama. Mengapa ini terjadi? Analis selalu kelebihan beban dan pemasar harus menunggu laporan. Selain itu, menurut penelitian, membuat bahkan satu dasbor membutuhkan rata-rata 4,5 hari, minimal tiga iterasi, dan yang paling penting, sekitar $ 18.000. Bagaimana hal ini memengaruhi kualitas data dan laporan? Pemasar tidak memiliki kesempatan untuk menemukan jawaban langsung atas semua jenis pertanyaan apa , mengapa , kapan , dan di mana pertanyaan itu muncul. Akibatnya, keputusan dibuat berdasarkan intuisi atau data yang tidak lengkap dan tidak benar.

- Kesulitan dalam memahami data. Mengapa ini terjadi? Orang yang berbeda bekerja dengan laporan yang sama, dan tidak selalu ada arti yang sama di balik metrik dan parameter tertentu. Misalnya, dalam berbagai laporan, metrik pengguna dapat berarti pengguna terdaftar tanpa pembelian atau pelanggan yang kembali. Bagaimana hal ini memengaruhi kualitas data dan laporan? Saat membuat keputusan, Anda mendefinisikan pengguna dengan satu cara, tetapi tidak ada jaminan bahwa laporan yang Anda rujuk mendefinisikan pengguna dengan cara yang sama.

Semua faktor ini dapat diilustrasikan dengan satu contoh: memainkan permainan bisikan di jalan . Data masukan Anda tampaknya benar dan relevan, tetapi hasilnya masih belum sepenuhnya seperti yang seharusnya.

Bagaimana mengatasi masalah ini?

Membuat data dan laporan dapat dipercaya dan dapat diterapkan merupakan tugas yang cukup berat. Di antara kesulitan dan hambatan utama dalam mencapai tujuan ini adalah sebagai berikut:

- Memiliki akses ke data siap-bisnis terbaru, lengkap, berkualitas tinggi untuk membebaskan waktu analis untuk mencari zona risiko dan pertumbuhan serta menemukan pendekatan baru untuk bekerja dengan data.

- Mampu menghasilkan laporan pemasaran dalam hitungan menit sehingga pemasar dapat menguji hipotesis dengan cepat dan mencari wawasan.

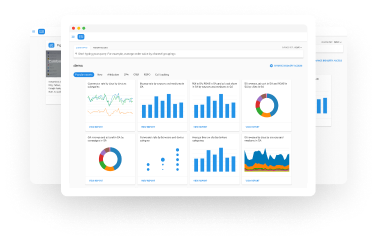

Untungnya, solusi analitik cloud modern memberi pemasar dan analis laporan dan data yang dapat mereka percayai. Jika Anda ingin membuat laporan yang dapat Anda percayai — laporan yang tidak rusak dan tidak memerlukan waktu berhari-hari untuk disiapkan — Anda harus mencoba menggunakan OWOX BI. Ini adalah layanan yang dirancang khusus untuk kebutuhan pelaporan pemasaran berdasarkan data yang lengkap dan berkualitas tinggi. Dengan pendekatan yang bijaksana, analis dapat menguji hipotesis dan menemukan wawasan lima kali lebih cepat.

OWOX BI mendemokratisasikan akses ke data untuk semua pengguna, terlepas dari latar belakang teknis mereka. Layanan ini memberi Anda proses otomatis untuk mengumpulkan dan menyiapkan data bisnis, memungkinkan Anda membuat dan mengedit laporan dalam hitungan menit. Selain itu, Anda dapat berhenti mengkhawatirkan kesalahan dalam laporan saat Anda melakukan perubahan, karena dengan OWOX BI, laporan Anda tidak akan pernah rusak!

OWOX BI membuatnya lebih mudah dari sebelumnya untuk membuka wawasan yang terperangkap dalam data Anda dan membuat laporan yang dapat Anda percayai. Pesan demo gratis untuk melihat bagaimana lagi OWOX BI menjamin kualitas data dan bagaimana Anda bisa mendapatkan keuntungan dari manajemen data otomatis sepenuhnya hari ini!

takeaways kunci

Sebuah perusahaan mendapatkan nilai maksimal dari datanya ketika data tersebut berkualitas tinggi dan ketika pembuat keputusan dapat dengan cepat bertindak berdasarkan temuan data.

Seorang analis paling berharga ketika mereka bekerja dengan data yang siap untuk bisnis, dapat dengan cepat menjawab pertanyaan bisnis dengan bantuan data, dan dapat memberikan wawasan yang dapat ditindaklanjuti. Pekerjaan seorang analis bukan lagi tentang menghabiskan waktu mengumpulkan, menyiapkan, dan menyelaraskan data dan menulis kueri SQL.

Perusahaan perlu menggunakan alat otomatisasi dengan model data siap-bisnis untuk tumbuh lebih cepat daripada pesaing yang menggunakan wawasan pemasaran. Data berkualitas tinggi adalah dasar di mana setiap laporan dan keputusan manajemen harus dibuat. Meskipun ada banyak kendala untuk mendapatkan data berkualitas tinggi yang dapat dipercaya, mulai dari tahap pengumpulan data dan terus berlanjut hingga tahap pembuatan laporan, hal itu masih mungkin dilakukan.

Apa yang dapat dilakukan untuk mengatasi masalah-masalah tersebut?

- Cegah kesalahan saat mengumpulkan data, karena lebih mudah dan lebih murah untuk menghentikan kesalahan agar tidak terjadi daripada mengurangi konsekuensinya.

- Hindari kemungkinan kesalahan dengan menggunakan otomatisasi sebanyak mungkin dalam alur kerja. Belum lagi bahwa mengotomatisasi tugas manual dan berulang memungkinkan spesialis untuk fokus pada aktivitas yang lebih bernilai tambah seperti mengembangkan wawasan data yang dapat ditindaklanjuti.