Que noindexer sur votre boutique Shopify et comment ? Le guide de robots.txt et de la balise meta robots

Publié: 2022-07-01Le fichier robots.txt est l'une des bases du référencement technique dont vous devez toujours prendre soin. Il vous aide à contrôler la façon dont les moteurs de recherche explorent votre site, de sorte que tout ce qui est important apparaisse dans les résultats de recherche et que tout ce que vous ne voulez pas y voir soit bloqué.

Pourquoi est-il si important de contrôler l'exploration et l'indexation de vos pages ?

- Économiser le budget de crawl. Il y a une limite au nombre de pages qu'un robot de recherche peut traiter en un temps donné. Pour vous assurer que vos pages les plus importantes sont explorées et réexplorées régulièrement, vous devez exclure les pages qui n'ont pas besoin d'être affichées dans les résultats de recherche.

- Empêcher l'affichage des pages techniques dans la recherche. Votre boutique génère de nombreuses pages pour le confort des utilisateurs : pages avec connexion, paiement, recherche interne, etc. Elles sont cruciales pour l'UX mais n'ont pas besoin d'être classées dans la recherche.

- Éviter les problèmes de contenu dupliqué. En parlant des pages techniques que nous avons mentionnées, elles peuvent créer des doublons : par exemple, différentes options de tri viendront à différentes URL mais afficheront les mêmes produits, mais dans un ordre différent. Vous ne voulez pas que ces pages soient impliquées dans les classements, car les moteurs de recherche n'apprécient pas le contenu dupliqué.

Comment pouvez-vous contrôler l'indexation des pages de votre boutique ?

Pour donner de la valeur à vos pages importantes et faciliter leur indexation par les robots de recherche, vous devez toujours avoir un sitemap à jour et correct. De plus, veillez à créer des liens internes et à faire en sorte que des sources externes soient liées à votre contenu afin que vos pages aient plus d'autorité aux yeux des moteurs de recherche.

Ces mesures garantissent à peu près que vos pages seront classées dans la recherche, bien qu'il n'existe aucun moyen sûr d'assurer une indexation à 100 %.

Ce que vous pouvez garantir à 100 %, c'est l'exclusion de certaines pages que vous ne souhaitez pas voir apparaître dans la recherche. Pour cela, vous pouvez utiliser la directive noindex dans le fichier robots.txt ou la balise meta robots . Cela semble très technique à première vue, mais c'est en fait très facile. Surtout pour les marchands Shopify, car la plateforme s'occupe automatiquement de la majeure partie de l'indexation correcte.

Alors, que devriez-vous noindexer sur une boutique Shopify ?

Pour les boutiques en ligne, il est logique de bloquer l'indexation des types de pages suivants :

- Tout ce qui est associé aux comptes d'utilisateurs. Ces pages sont uniques à chaque client et ne sont pas nécessaires à la recherche.

- Tout ce qui est associé à la caisse des invités. Même si les utilisateurs ne se connectent pas à leur compte et sont autorisés à acheter en tant qu'invités, les pages avec des étapes de paiement générées pour eux ne sont pas destinées à la recherche.

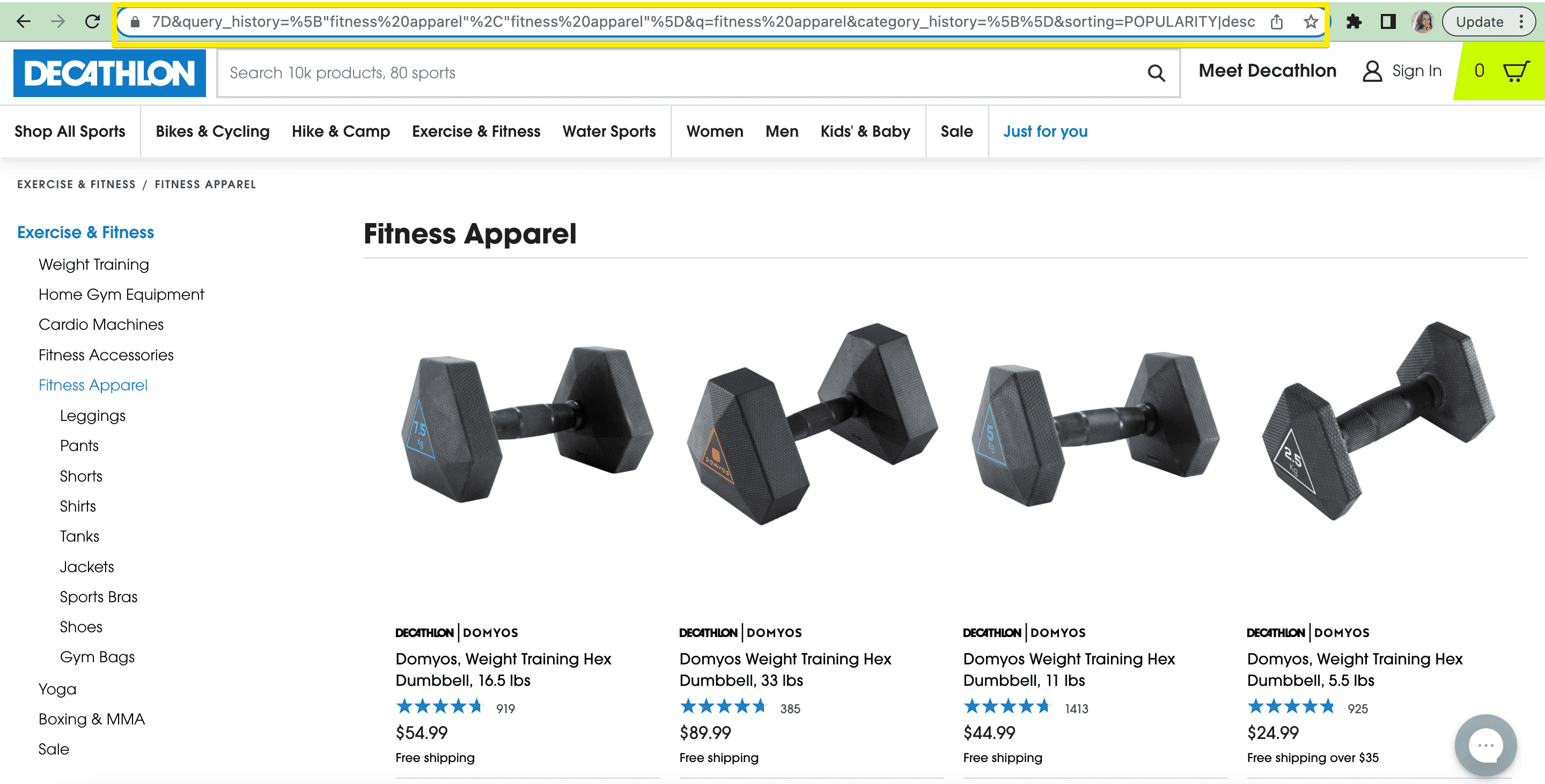

- Navigation à facettes et recherche interne. Comme nous l'avons déjà mentionné, proposer ces URL aux robots de recherche ne fera que les embrouiller, épuiser votre budget d'exploration et créer des problèmes de contenu en double.

- Produits que vous souhaitez masquer de la recherche. Si vous ne souhaitez pas que certains produits s'affichent dans les résultats de recherche, par exemple des articles en rupture de stock ou des articles urgents qui ne sont plus pertinents, vous pouvez masquer des produits de la recherche dans votre fichier Shopify robots.txt.

Robots.txt dans Shopify

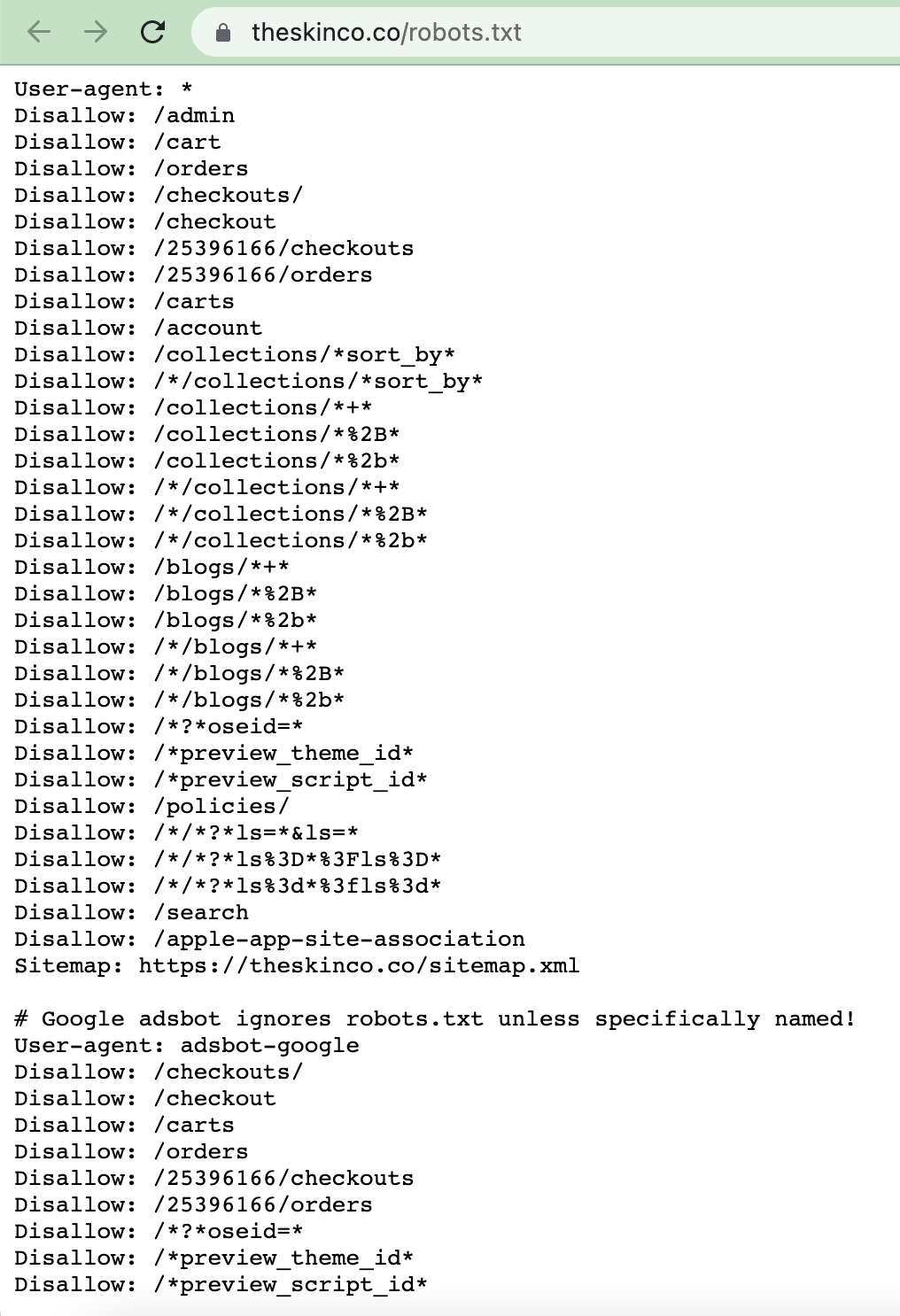

Pour vérifier votre fichier robots.txt qui est généré automatiquement pour vous, vous pouvez ajouter le /robots.txt au domaine de votre boutique :

Que contient généralement ce fichier ? Il indique un bot de recherche particulier (le champ User-agent ) et donne des directives d'exploration ( Disallow signifie bloquer l'accès). Dans l'exemple ci-dessus, le premier ensemble de règles est donné à tous les robots de recherche (l' agent utilisateur est défini sur *). À son tour, la directive Disallow interdit l'exploration des pages spécifiées. Dans l'exemple, nous pouvons voir que le fichier interdit l'exploration des pages techniques, telles que admin, cart, checkout, etc.

Robots.txt inclut également un lien vers votre sitemap, qui est également utile pour les robots de recherche afin de comprendre la structure de votre site et les priorités d'indexation.

Jusqu'à récemment, Shopify n'offrait aucune flexibilité avec ce fichier. Mais en juin 2021, les marchands Shopify ont eu la possibilité de modifier robots.txt. Les règles prédéfinies sont généralement suffisantes, mais peuvent ne pas prendre en compte tous les cas. Si vous utilisez une application pour la recherche interne, elle modifie souvent l'URL et les règles par défaut ne sont pas appliquées. Ou, si vous avez une navigation à facettes, l'URL change en fonction de chaque filtre choisi, et les règles par défaut peuvent ne pas tout prendre en compte. Vous pouvez ajouter plus de pages et de règles à votre fichier, spécifier plus d'agents utilisateurs, etc.

Pour en savoir plus sur les directives existantes que vous pouvez appliquer, consultez le guide de Google sur robots.txt.

Notez également que de nouvelles règles apparaissent tout le temps. Par exemple, début 2022, Google a introduit une nouvelle balise qui contrôle l'indexation des contenus embarqués : indexifembedded. Il peut être appliqué si vous avez des widgets sur votre boutique qui sont insérés via iframe ou une balise HTML similaire et que vous ne voulez pas qu'ils soient indexés.

Comment modifier votre robots.txt sur Shopify ?

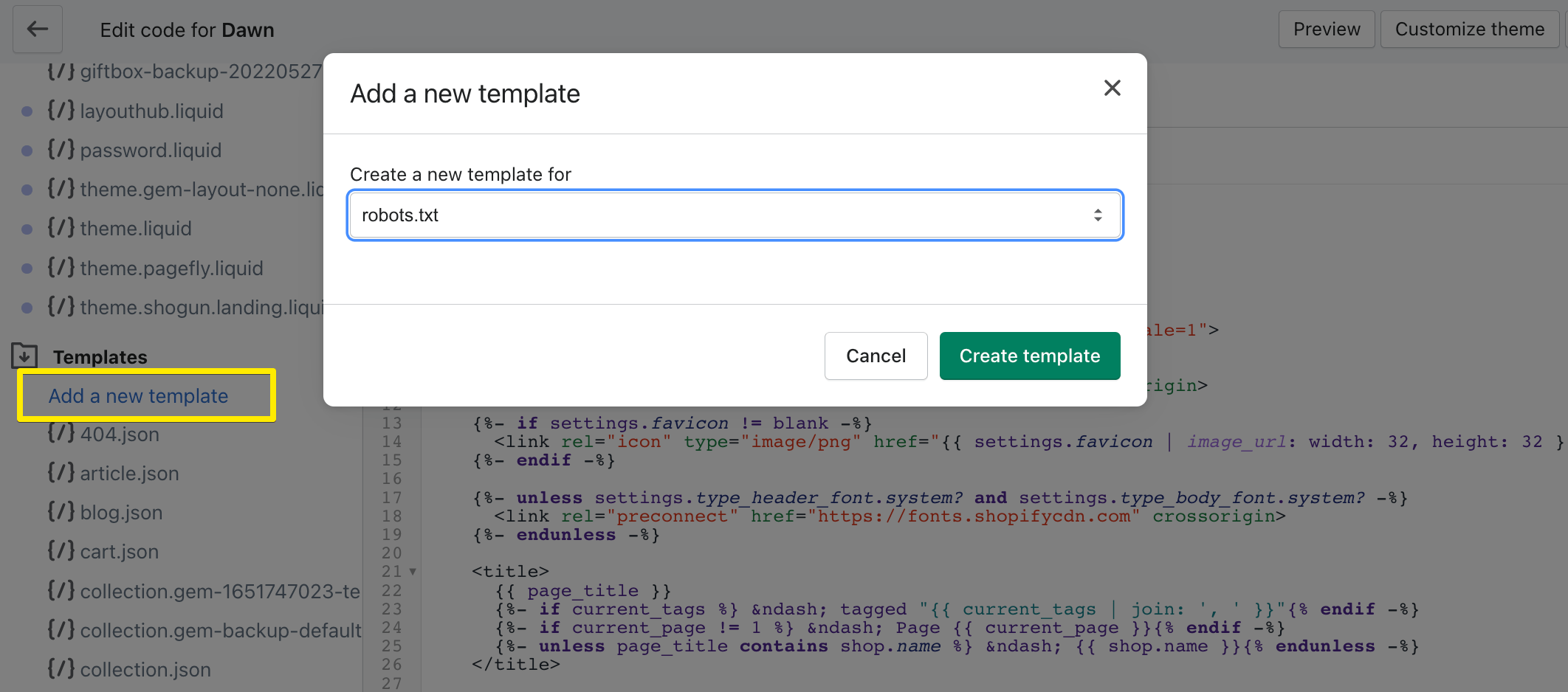

Dans le code de votre thème, vous verrez un tas de modèles (allez dans Boutique en ligne > Thèmes > cliquez sur Actions sur votre thème actuel > choisissez Modifier le code > allez dans Modèles ). La liste doit contenir le fichier robots.txt.liquid.

Si, pour une raison quelconque, vous n'avez pas le fichier, vous pouvez le créer en cliquant sur Ajouter un nouveau modèle et en choisissant robots.txt.

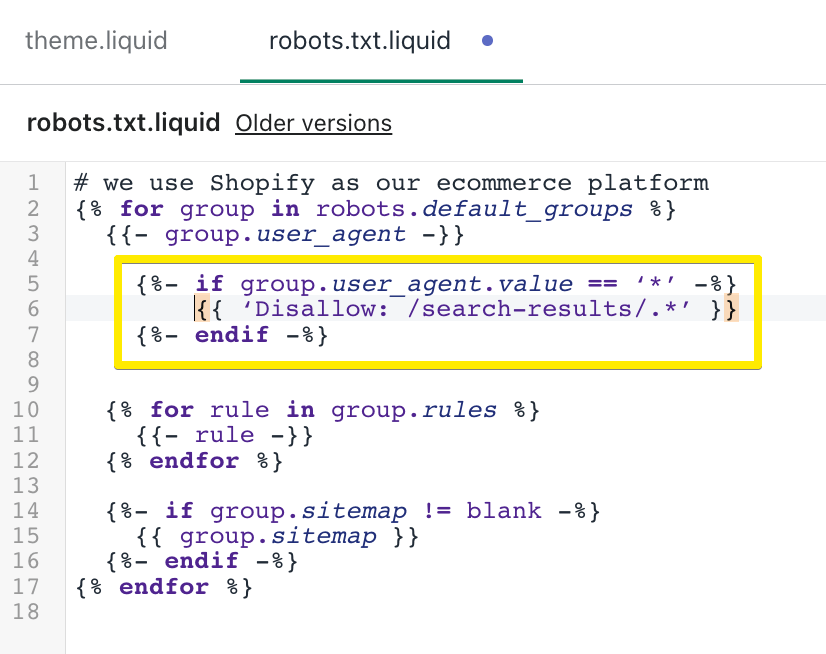

Par exemple, bloquons l'indexation de la recherche interne. Elle ressemblera à ceci dans le modèle :

Reportez-vous à la page d'aide de Shopify sur la modification du fichier robots.txt pour plus de détails.

Notez que même si une page est interdite dans robots.txt, elle peut toujours être indexée si elle contient des liens provenant de sources externes. Ainsi, par exemple, si vous avez une ancienne page qui a reçu une quantité décente de trafic dans le passé mais qui n'est plus pertinente pour votre boutique, il est préférable de la bloquer avec la balise méta robots ou de la supprimer complètement.

Pas d'indexation du contenu Shopify avec la balise meta robots

Outre robots.txt, la directive noindex peut être insérée dans la section <head> du code de votre thème à l'aide de la balise meta robots. La balise a la syntaxe suivante : <meta name=”robots” content=”noindex”>.

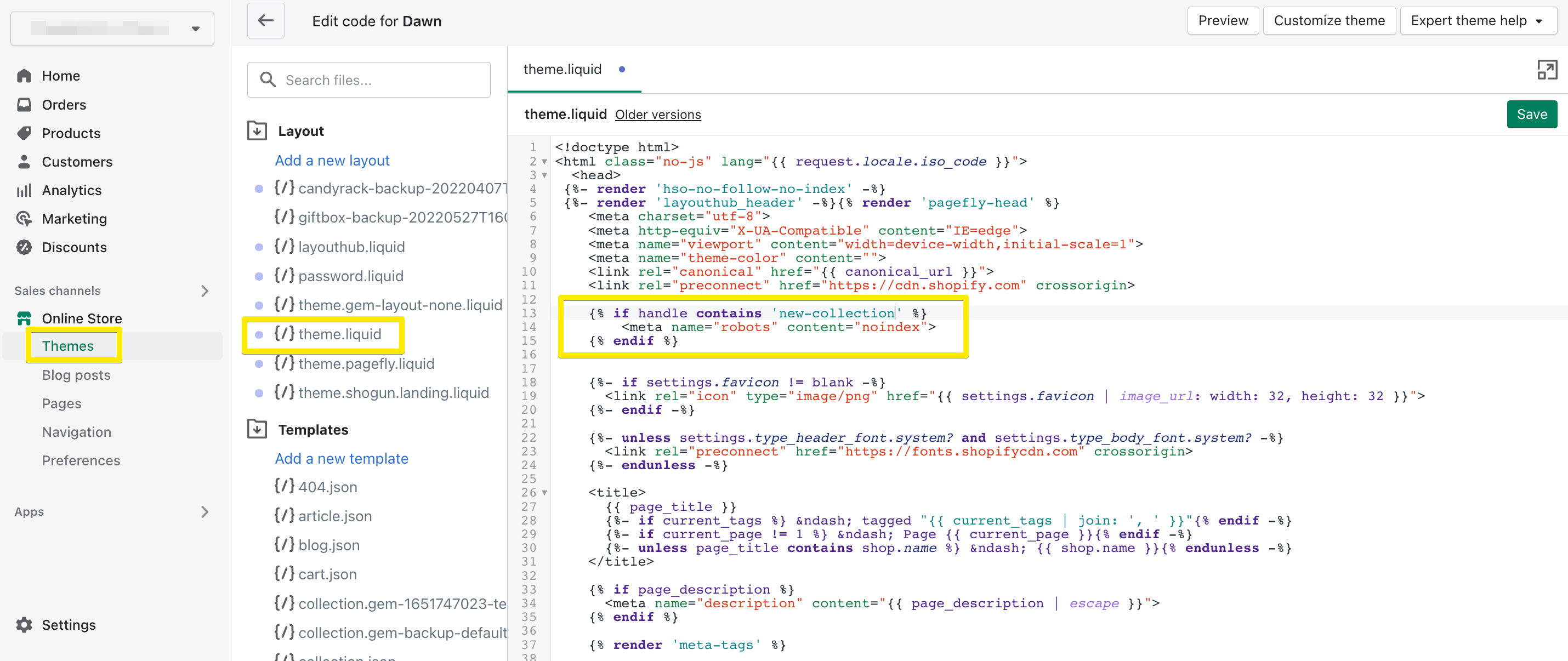

De la même manière que vous modifiez ou créez un code Shopify robots.txt, accédez à theme.liquid dans la section Mise en page . Par exemple, voici à quoi cela ressemblera si vous ajoutez une règle pour ne pas indexer votre page /new-collection :

De cette façon, vous cacherez une page de la recherche pour de bon.

Notez que vous pouvez utiliser noindex avec les directives nofollow ou follow ensemble. Avec follow , l'indexation de votre page sera bloquée mais permettra aux robots de recherche d'explorer d'autres liens placés sur cette page, tandis qu'avec nofollow , la page elle-même et tous les liens qu'elle contient ne seront pas accessibles aux robots de recherche.

Pas d'indexation du contenu Shopify à l'aide d'applications

Si tout cela vous semble trop compliqué, il existe des moyens de contrôler l'indexation de votre page encore plus facilement, sans avoir à écrire une seule ligne de code. Il existe plusieurs applications de référencement pour Shopify qui vous aideront à masquer les produits de la recherche dans votre boutique Shopify ou à bloquer toute autre page.

Jetez un oeil à ces deux:

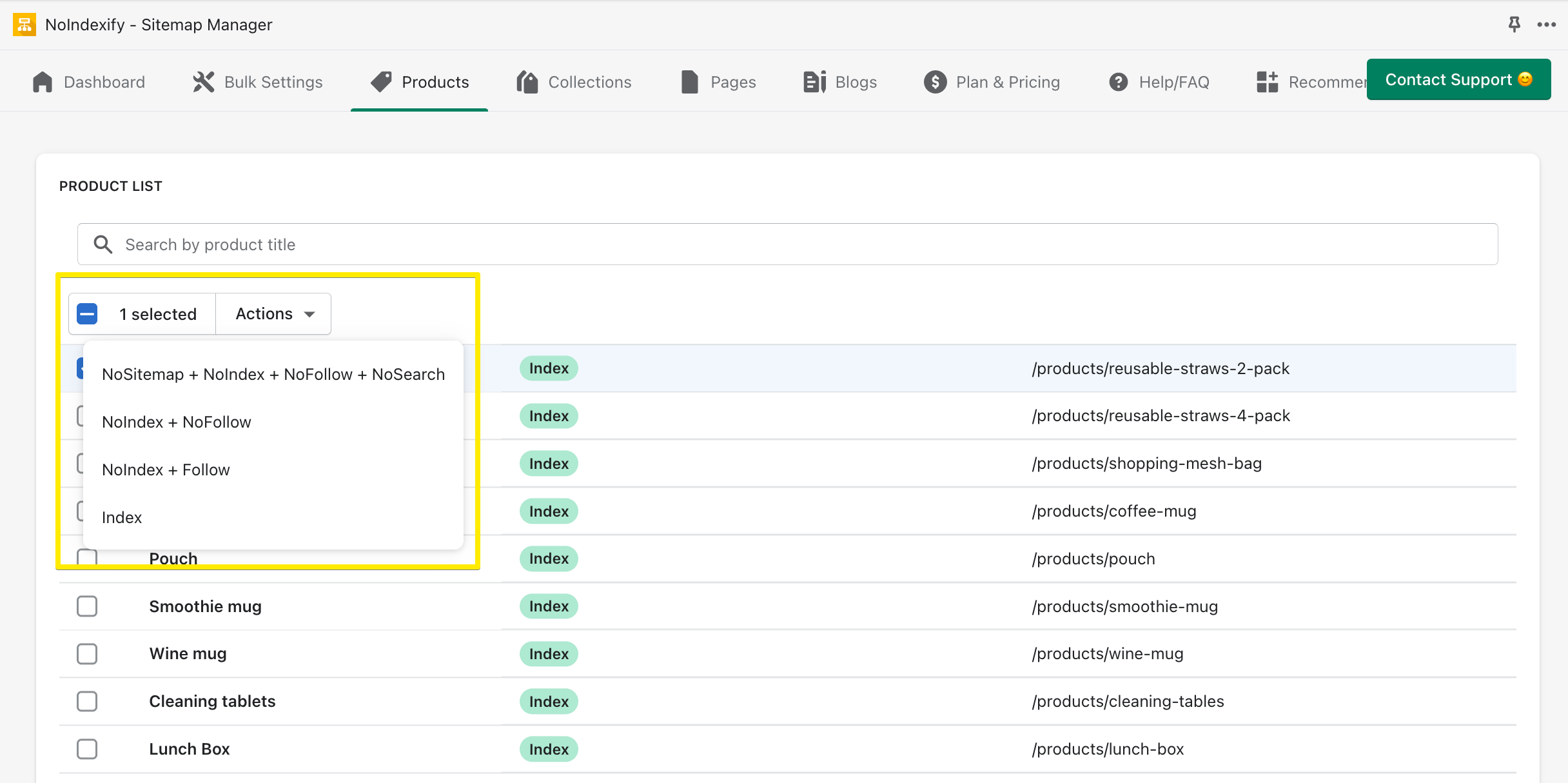

- Sitemap Noindex SEO Tools (3,49 $ par mois pour tous les types de pages)

- NoIndexify - Sitemap Manager (gratuit pour les pages produit, collection et blog ; 2,99 $ par mois pour les autres pages : recherche, pagination, connexion, etc.)

Voici à quoi ressemble l'interface de NoIndexify—pour chaque page, vous pouvez choisir un ensemble de directives :

Améliorez votre référencement en améliorant l'indexation des pages

Voilà : nous espérons que vous comprenez mieux le fonctionnement du fichier robots.txt de Shopify et comment l'utiliser à votre avantage. Avec l'aide de robots.txt et de la balise méta robots, vous pouvez améliorer votre contrôle sur l'indexation des pages, prévenir les problèmes de référencement et donner plus de valeur à vos pages les plus importantes afin qu'elles brillent dans la recherche et attirent plus de visiteurs.

Si vous recherchez plus de conseils SEO Shopify, consultez notre guide SEO.