在您的 Shopify 商店中沒有什麼索引以及如何操作? robots.txt 和 robots 元標記指南

已發表: 2022-07-01robots.txt 文件是您應該始終注意的技術 SEO 的基礎知識之一。 它可以幫助您控制搜索引擎對您網站的抓取方式——這樣所有重要的內容都會出現在搜索結果中,而您不想在那裡顯示的所有內容都會被屏蔽。

為什麼控制您的頁面抓取和索引如此重要?

- 節省爬行預算。 搜索機器人在給定時間內可以處理的頁面數量是有限制的。 為確保您最重要的頁面被抓取並定期重新抓取,您應該排除那些不需要在搜索結果中顯示的頁面。

- 防止技術頁面顯示在搜索中。 您的商店為方便用戶而生成了很多頁面:登錄、結帳、內部搜索等頁面。它們對用戶體驗至關重要,但不需要在搜索中排名。

- 避免重複內容問題。 說到我們提到的技術頁面,它們可能會造成重複:例如,不同的排序選項會出現在不同的 URL 上,但會顯示相同的產品,只是順序不同。 您不希望這些頁面參與排名,因為搜索引擎不喜歡重複的內容。

如何控製商店的頁面索引?

為了使您的重要頁面有價值並促進搜索機器人對其進行索引,您應該始終擁有更新且正確的站點地圖。 另外,請注意內部鏈接並讓外部資源鏈接到您的內容,以便您的頁面在搜索引擎眼中看起來更具權威性。

這些措施幾乎可以保證您的頁面將在搜索中排名,儘管沒有可靠的方法來確保 100% 索引。

您可以保證 100% 排除您不想出現在搜索中的某些頁面。 為此,您可以使用 robots.txt 文件或 robots 元標記中的noindex指令。 乍一看聽起來很技術性,但實際上很容易。 特別是對於 Shopify 商家,因為該平台會自動處理大部分正確索引。

那麼,你應該在 Shopify 商店中使用什麼?

對於在線商店,阻止索引以下類型的頁面是有意義的:

- 與用戶帳戶相關的所有內容。 這些頁面對每個客戶都是唯一的,在搜索中不需要。

- 與客人結賬相關的一切。 即使用戶沒有登錄他們的帳戶並被允許以訪客身份購買,為他們生成結帳步驟的頁面也不適合搜索。

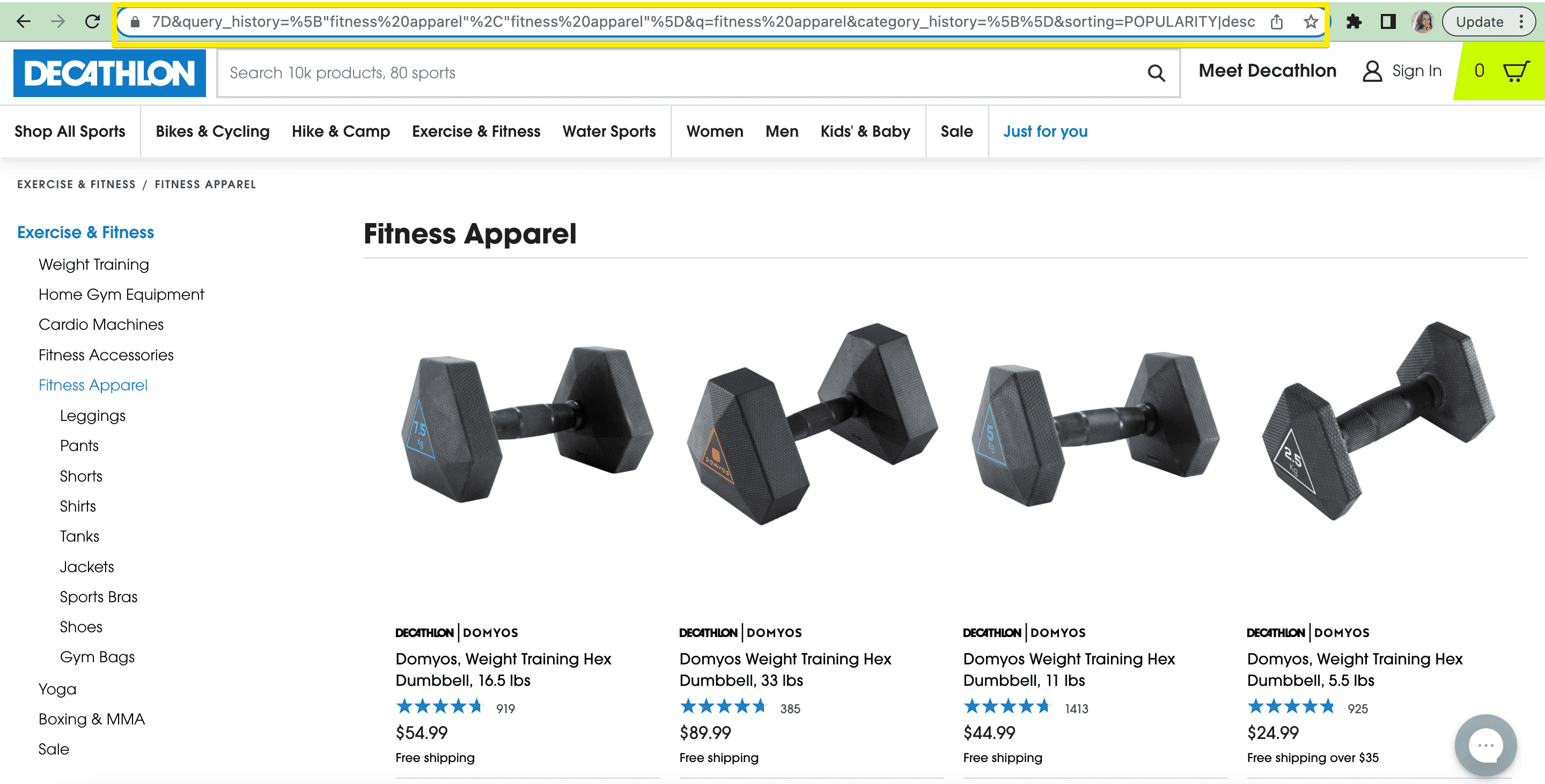

- 分面導航和內部搜索。 正如我們已經提到的,將這些 URL 提供給搜索機器人只會使它們感到困惑,耗盡您的抓取預算,並產生重複的內容問題。

- 您想在搜索中隱藏的產品。 如果您不希望某些產品顯示在搜索結果中(例如,缺貨商品或不再相關的對時間敏感的商品),您可以在 Shopify robots.txt 文件中隱藏商品以進行搜索。

Shopify 中的 Robots.txt

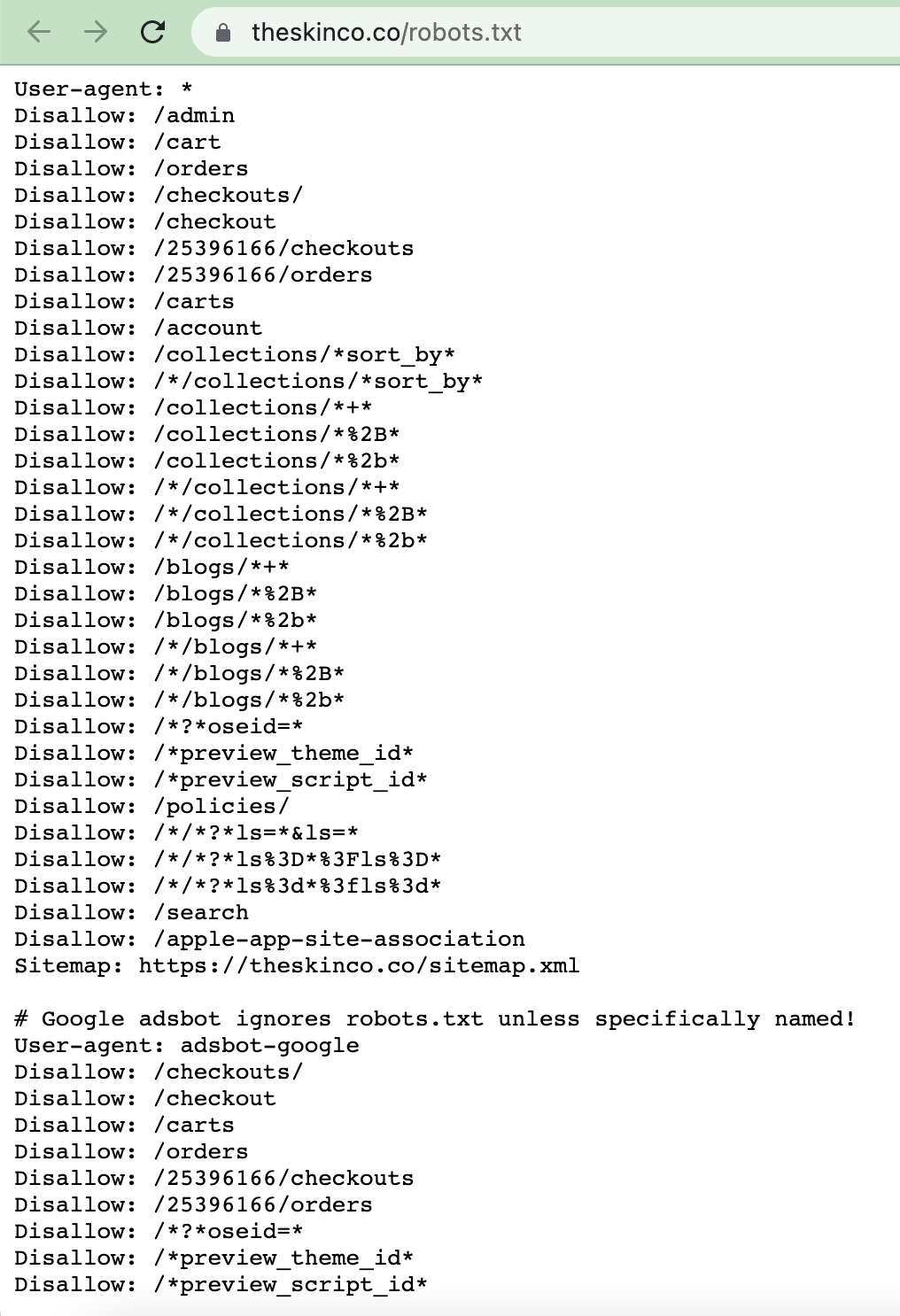

要檢查自動為您生成的 robots.txt 文件,您可以將 /robots.txt 添加到商店的域中:

這個文件通常包含什麼? 它指示一個特定的搜索機器人(用戶代理字段)並給出抓取指令(禁止意味著阻止被訪問)。 在上面的示例中,第一組規則提供給所有搜索機器人(用戶代理設置為 *)。 反過來, Disallow指令禁止爬取指定頁面。 在示例中,我們可以看到該文件禁止抓取技術頁面,例如 admin、cart、checkout 等。

Robots.txt 還包含指向您的站點地圖的鏈接,這也有助於搜索爬蟲了解您的站點結構和索引優先級。

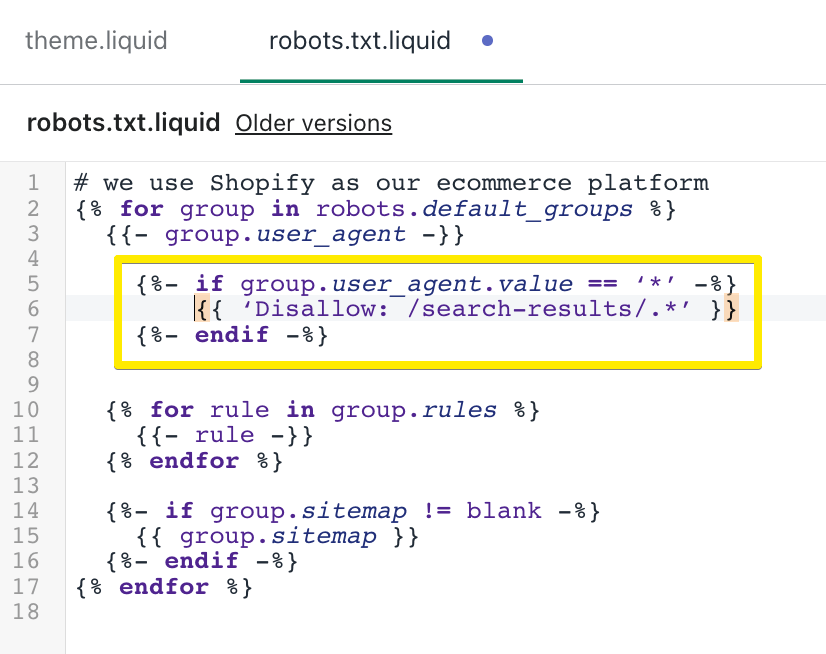

直到最近,Shopify 才對該文件提供任何靈活性。 但在 2021 年 6 月,Shopify 商家獲得了編輯 robots.txt 的可能性。 預定義的規則就足夠了,但可能不會考慮所有情況。 如果您使用應用程序進行內部搜索,它通常會更改 URL,並且不會應用默認規則。 或者,如果您有分面導航,則 URL 會根據每個選擇的過濾器而變化,並且默認規則可能不會考慮所有內容。 您可以向文件中添加更多頁面和規則,指定更多用戶代理等。

要了解您可以應用的現有指令,請查看 Google 的 robots.txt 指南。

另外,請注意新規則會一直出現。 例如,在 2022 年初,谷歌引入了一個控制嵌入內容索引的新標籤:indexifembedded。 如果您的商店中有一些通過iframe或類似 HTML 標記插入的小部件並且您不希望它們被索引,則可以應用它。

如何在 Shopify 上編輯您的 robots.txt?

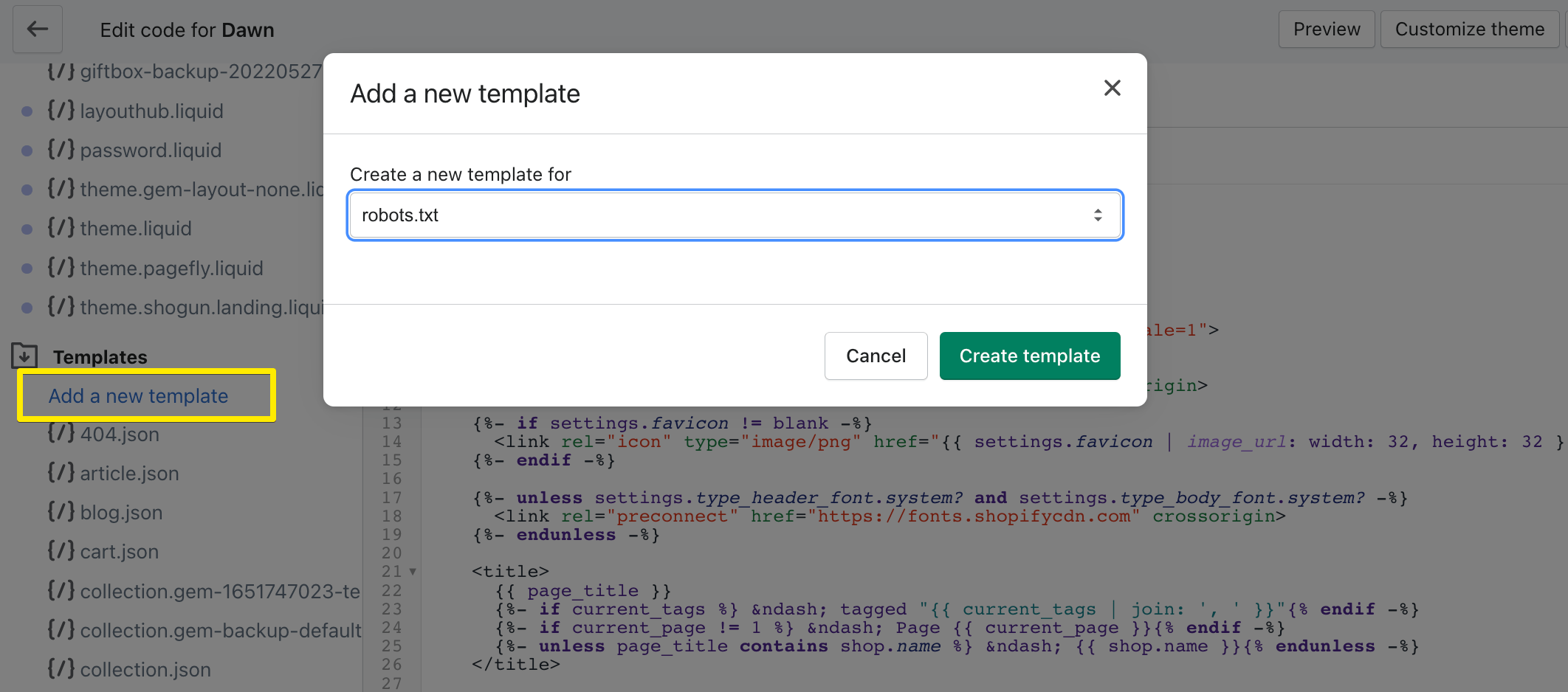

在您的主題代碼中,您會看到一堆模板(轉到在線商店>主題> 單擊當前主題上的操作> 選擇編輯代碼> 轉到模板)。 該列表應包含 robots.txt.liquid 文件。

如果由於某種原因您沒有該文件,您可以通過單擊添加新模板並選擇 robots.txt 來創建它。

例如,讓我們從索引中阻止內部搜索——它在模板中看起來像這樣:

有關更多詳細信息,請參閱 Shopify 關於編輯 robots.txt 的幫助頁面。

請注意,即使某個頁面在 robots.txt 中被禁止,如果它具有來自外部來源的鏈接,它仍然可以被編入索引。 因此,例如,如果您有一個舊頁面過去獲得了相當多的流量但不再與您的商店相關,那麼最好使用機器人元標記阻止它或將其完全刪除。

Noindexing Shopify 內容與機器人元標記

除了 robots.txt,在 robots 元標記的幫助下,可以將noindex指令插入主題代碼的 <head> 部分。 該標籤的語法如下:<meta name=”robots” content=”noindex”>。

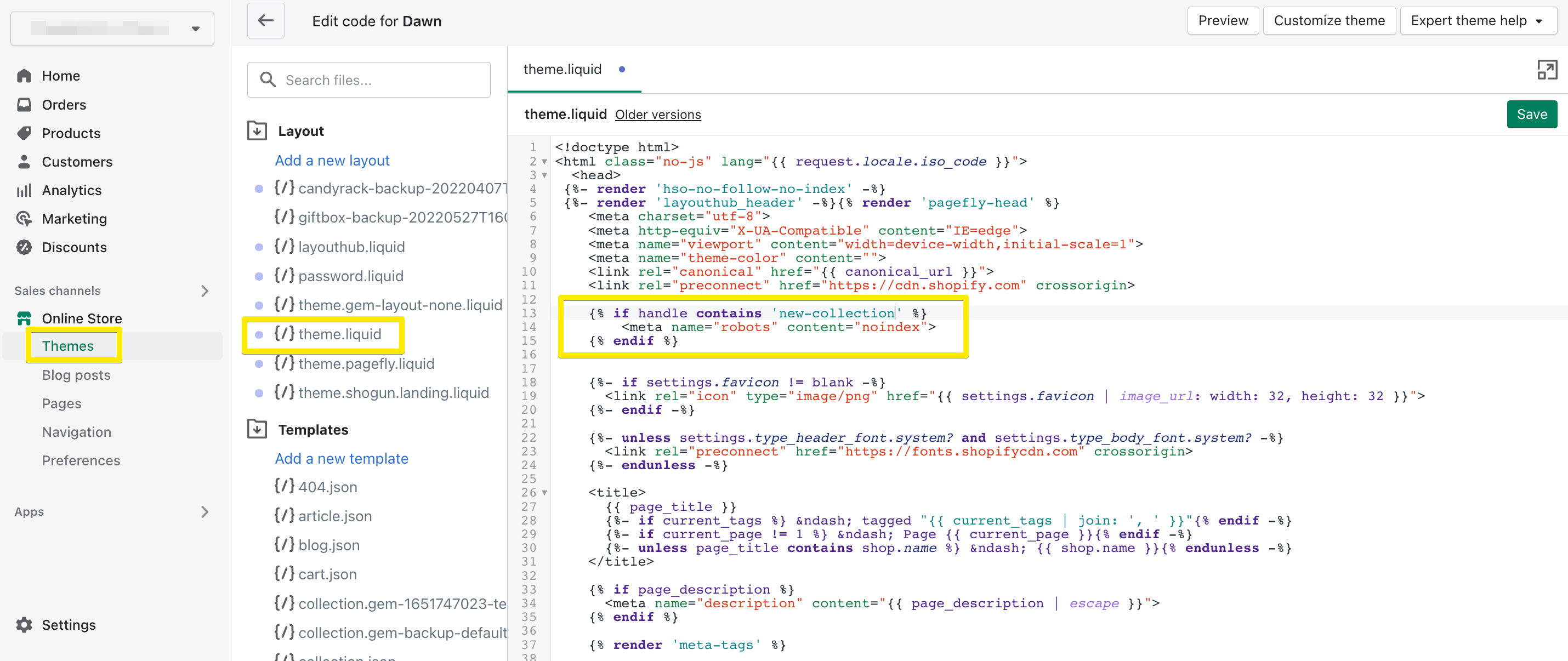

與編輯或創建 Shopify robots.txt 代碼的方式類似,請轉到佈局部分中的 theme.liquid。 例如,如果您添加一條規則以不為您的 /new-collection 頁面編制索引,這就是它的外觀:

這樣,您將永遠隱藏頁面以防止搜索。

請注意,您可以將noindex與nofollow或follow指令一起使用。 使用follow ,您的頁面將被阻止編制索引,但允許搜索機器人抓取放置在該頁面上的其他鏈接,而使用nofollow ,搜索機器人將無法訪問頁面本身及其上的所有鏈接。

在應用程序的幫助下不為 Shopify 內容編制索引

如果所有這些聽起來對您來說太麻煩了,有一些方法可以更輕鬆地控制您的頁面索引,而無需編寫任何代碼。 Shopify 有幾個 SEO 應用程序可以幫助您在 Shopify 商店中隱藏產品搜索或阻止任何其他頁面。

看看這兩個:

- 網站地圖 Noindex SEO 工具(所有類型的頁面每月 3.49 美元)

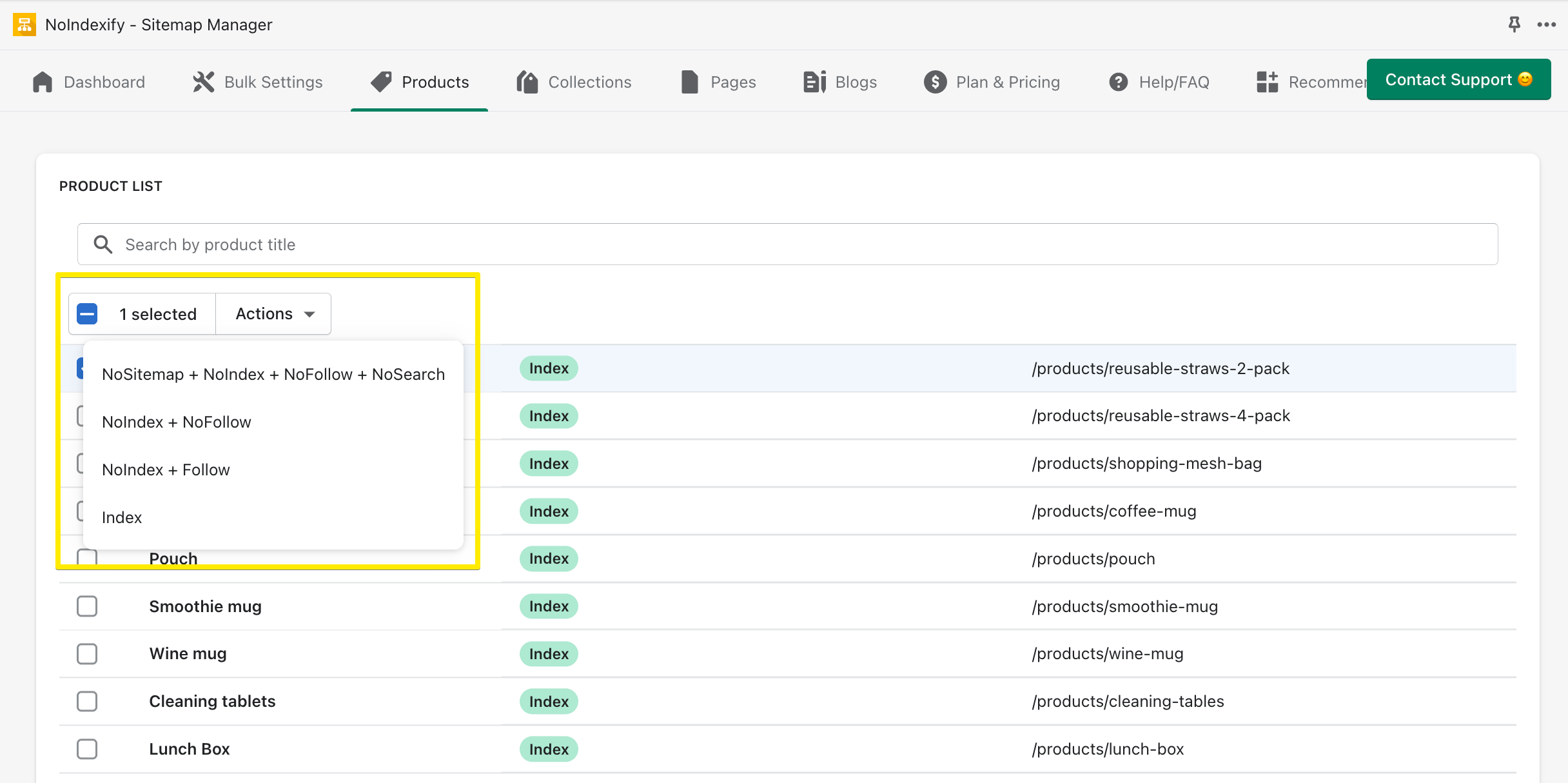

- NoIndexify - 站點地圖管理器(產品、收藏和博客頁面免費;其他頁面每月 2.99 美元:搜索、分頁、登錄等)

這就是 NoIndexify 的界面的樣子——對於每個頁面,您可以選擇一組指令:

通過改進頁面索引來改進您的 SEO

就是這樣:我們希望您更好地了解 Shopify 的 robots.txt 的工作原理以及如何利用它來發揮自己的優勢。 在 robots.txt 和 robots 元標記的幫助下,您可以改進對頁面索引的控制,防止 SEO 問題,並為您最重要的頁面賦予更多價值,以便它們在搜索中大放異彩並吸引更多訪問者。

如果您正在尋找更多 Shopify SEO 提示,請查看我們的 SEO 指南。