ログファイル分析とは何ですか?SEOにとってなぜそれが重要なのですか?

公開: 2022-03-16SEOログファイル分析は、Webサイトでのクローラーの動作を理解し、潜在的な技術的なSEO最適化の機会を特定するのに役立ちます。

クローラーの動作を分析しないSEOは、ブラインドで飛ぶようなものです。 Google検索コンソールでウェブサイトを送信してインデックスに登録した可能性がありますが、ログファイルを調べないと、ウェブサイトが検索エンジンボットによってクロールまたは読み取られているかどうかがわかりません。

そのため、SEOログファイルを分析し、それらから問題とSEOの機会を特定するために知っておく必要のあるすべてのものを集めました。

ログファイル分析とは何ですか?

SEOログファイル分析は、検索エンジンボットとWebサイトとの相互作用のパターンを認識するプロセスです。 ログファイル分析は技術的なSEOの一部です。

ログファイルの監査は、SEOがクロール、インデックス作成、ステータスコードに関連する問題を認識して解決するために重要です。

ログファイルとは何ですか?

ログファイルは、誰がWebサイトにアクセスし、どのコンテンツを表示したかを追跡します。 これらには、誰がWebサイト(「クライアント」とも呼ばれます)へのアクセスを要求したかに関する情報が含まれています。

認識される情報は、GoogleやBingなどの検索エンジンボットやWebサイトの訪問者に関連している可能性があります。 通常、ログファイルレコードはサイトのWebサーバーによって収集および維持され、通常は一定期間保持されます。

ログファイルには何が含まれていますか?

SEOのログファイルの重要性を知る前に、このファイルの中に何があるかを知ることが不可欠です。 ログファイルeには、次のデータポイントが含まれています。

- Webサイトの訪問者が要求しているページのURL

- ページのHTTPステータスコード

- 要求されたサーバーのIPアドレス

- ヒットの日時

- リクエストを行うユーザーエージェント(検索エンジンボット)のデータ

- リクエストメソッド(GET / POST)

ログファイルを最初に見ると、複雑に見える場合があります。 それでも、SEOのログファイルの目的と重要性を理解したら、それらを効果的に使用して、貴重なSEOの洞察を生成します。

SEOのためのログファイル分析の目的

ログファイル分析は、重要な技術的なSEOの問題のいくつかを解決するのに役立ちます。これにより、Webサイトを最適化するための効果的なSEO戦略を作成できます。

ログファイルを使用して分析できるいくつかのSEOの問題は次のとおりです。

#1。 Googlebotがウェブサイトをクロールする頻度

検索エンジンのボットまたはクローラーは、重要なページを頻繁にクロールして、検索エンジンがWebサイトの更新や新しいコンテンツを認識できるようにする必要があります。

重要な製品または情報ページはすべてGoogleのログに表示されます。 販売しなくなった製品の製品ページ、および最も重要なカテゴリページがないことは、ログファイルを使用して認識できる問題の指標です。

検索エンジンボットはクロールバジェットをどのように利用しますか?

検索エンジンのクローラーがサイトにアクセスするたびに、「クロールの予算」が制限されます。 Googleは、クロール予算をサイトのクロールレートとクロール需要の合計として定義しています。

価値の低いURLやサイトマップに正しく送信されていないURLが多数含まれている場合、サイトのクロールとインデックス作成が妨げられる可能性があります。 クロール予算が最適化されていると、キーページのクロールとインデックス作成が簡単になります。

ログファイル分析は、SEOの取り組みを加速するクロールバジェットを最適化するのに役立ちます。

#2。 モバイルファーストのインデックス作成の問題とステータス

モバイルファーストのインデックス作成は現在すべてのウェブサイトにとって重要であり、Googleはそれを好みます。 ログファイル分析により、スマートフォンのGooglebotがサイトをクロールする頻度がわかります。

この分析は、ページがスマートフォンのGooglebotによって正しくクロールされていない場合に、ウェブマスターがモバイルバージョン用にウェブページを最適化するのに役立ちます。

#3。 要求されたときにWebページから返されるHTTPステータスコード

ウェブページが返す最近の応答コードは、ログファイル、またはGoogle検索コンソールのフェッチとレンダリングのリクエストオプションを使用して取得できます。

ログファイルアナライザーは、3xx、4xx、および5xxコードのページを見つけることができます。 これらの問題を解決するには、適切なアクションを実行します。たとえば、URLを正しい宛先にリダイレクトしたり、301にコード化された302stausを変更したりします。

#4。 クロール深度や内部リンクなどのクロールアクティビティの分析

Googleは、クロールの深さと内部リンクに基づいてサイト構造を評価します。 Webサイトの不適切なクロールの背後にある理由は、リンク間の構造とクロールの深さが悪いことです。

Webサイトの階層やサイト構造、またはインターリンク構造に問題がある場合は、ログファイル分析を使用してそれらを見つけることができます。

ログファイル分析は、Webサイトのアーキテクチャとインターリンク構造を最適化するのに役立ちます。

#4。 孤立したページを見つける

孤立したページとは、他のページからリンクされていないWebサイト上のWebページです。 このようなページは、ボットによって簡単に検出されないため、インデックスに登録したり、検索エンジンに表示したりすることは困難です。

孤立したページは、Screaming Frogなどのクローラーによって簡単に発見できます。この問題は、これらのページをWebサイト上の他のページに相互リンクすることで解決できます。

#5。 ページの速度とエクスペリエンスについてページを監査する

現在、ページエクスペリエンスとコアWebバイタルは公式にランキング要素であり、WebページがGoogleページ速度ガイドラインに準拠していることが重要です。

遅いページや大きなページは、ログファイルアナライザーを使用して検出できます。これらのページは、SERPでの全体的なランキングに役立つページ速度に最適化できます。

ログファイル分析は、Webサイトのクロール方法と、検索エンジンによるWebサイトの処理方法を制御するのに役立ちます。

ここで、ログファイルの基本とその分析が明確になったので、SEOのログファイルを監査するプロセスを見てみましょう。

ログファイル分析を行う方法

ログファイルのさまざまな側面とSEOの重要性についてはすでに見てきました。 次に、ファイルを分析するプロセスと、ログファイルを分析するための最適なツールについて学習します。

ログファイルにアクセスするには、Webサイトのサーバーログファイルにアクセスする必要があります。 ファイルは次の方法で分析できます。

- Excelまたはその他のデータ視覚化ツールを手動で使用する

- ログファイル分析ツールの使用

ログファイルに手動でアクセスするには、さまざまな手順が必要です。

- ウェブサーバーからログデータを収集またはエクスポートします。データは、検索エンジンのボットまたはクローラー用にフィルタリングする必要があります。

- データ分析ツールを使用して、ダウンロードしたファイルを読み取り可能な形式に変換します。

- Excelまたはその他の視覚化ツールを使用してデータを手動で分析し、SEOのギャップと機会を見つけます。

- フィルタリングプログラムとコマンドラインを使用して、作業を簡単にすることもできます

ファイルのデータを手動で操作することは、Excelの知識が必要であり、開発チームが関与するため、簡単ではありません。 それでも、ログファイル分析用のツールを使用すると、SEOの作業が簡単になります。

ログファイルを監査するための主要なツールを見て、これらのツールがログファイルの分析にどのように役立つかを理解しましょう。

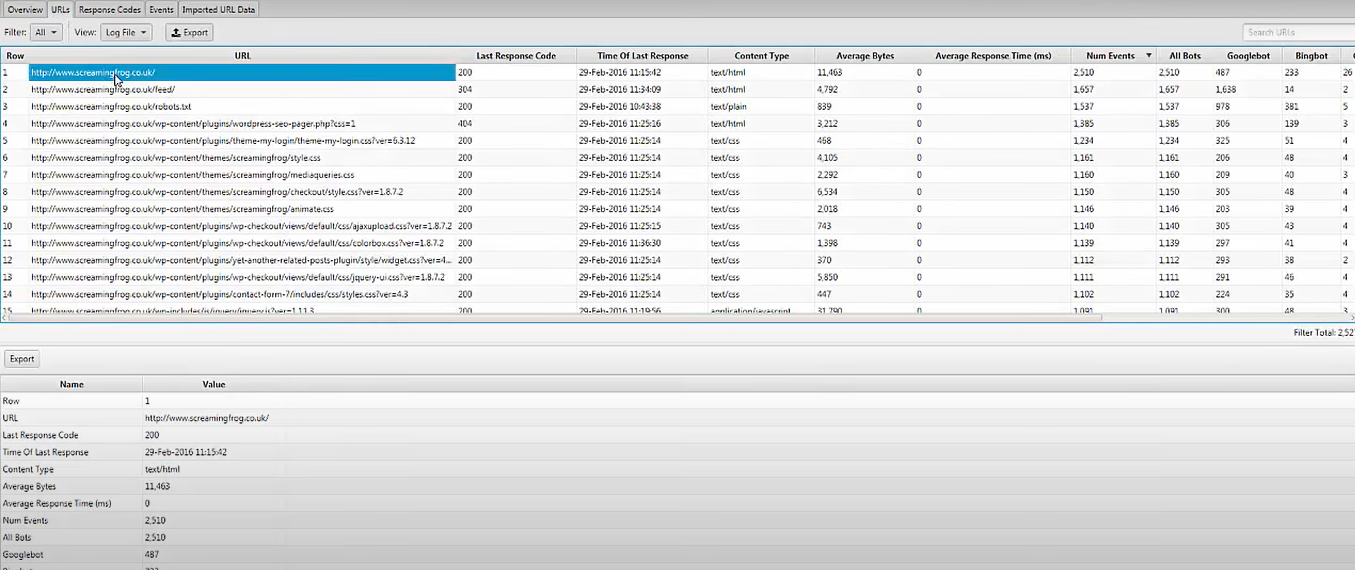

スクリーミングフロッグログファイルアナライザー

技術的なSEOの問題は、アップロードされたログファイルデータと、Screaming Frog LogFileAnalyzerを使用して検証された検索エンジンボットを使用して特定できます。 次のようにすることもできます。

- 検索エンジンボットのアクティビティと検索エンジン最適化のためのデータ。

- 検索エンジンボットによるウェブサイトのクロール頻度を発見する

- 技術的なSEOの問題と外部および内部の壊れたリンクのすべてについて調べてください

- クロールが最も少なく、最も多く行われたURLを分析して、損失を減らし、効率を高めます。

- 検索エンジンによってクロールされていないページを発見します。

- 外部リンクデータ、ディレクティブ、およびその他の情報を含む、任意のデータを比較および結合できます。

- リファラーURLに関するデータを表示する

Screaming Frogログファイルアナライザツールは、1000行のログイベントの制限がある単一のプロジェクトで完全に無料で使用できます。 無制限のアクセスと技術支援が必要な場合は、有料バージョンにアップグレードする必要があります。

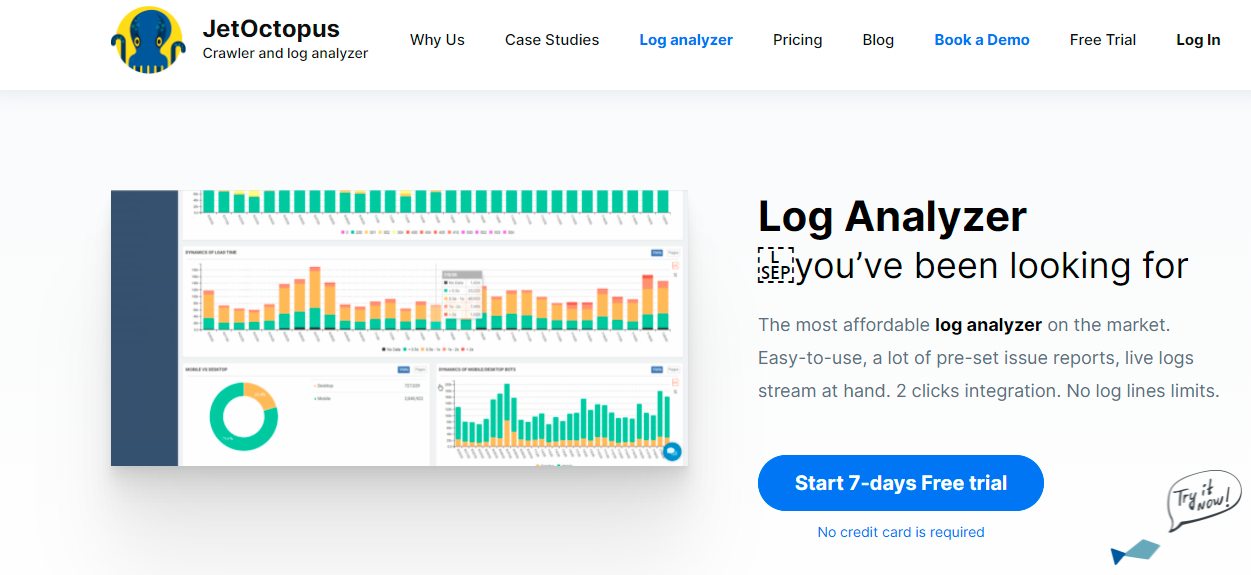

JetOctopus

手頃なログアナライザツールに関しては、JetOctopusが最適です。 7日間の無料トライアル、クレジットカード不要、2クリック接続が可能です。 クロールの頻度、クロールの予算、最も人気のあるページなどはすべて、リストにある他のツールと同様に、JetOctopusログアナライザーを使用して識別できます。

このツールを使用すると、ログファイルデータをGoogle Search Consoleデータと統合できるため、競合他社に対して明確な利点が得られます。 このコンボを使用すると、Googlebotがサイトとどのように相互作用し、どこを改善できるかを確認できます。

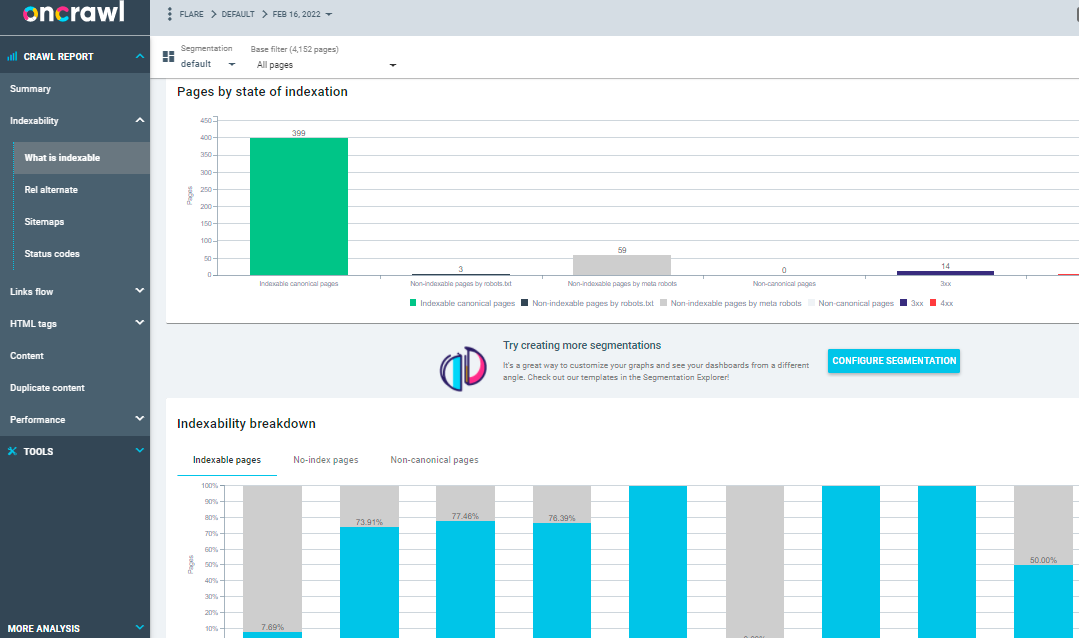

クロールログアナライザーについて

1日に5億を超えるログ行が、中規模から大規模のWebサイト向けに設計されたツールであるOncrawlLogAnalyzerによって処理されます。 Webサーバーのログをリアルタイムで監視し、ページが適切にインデックスに登録され、クロールされていることを確認します。

Oncrawl Log Analyzerは、GDPRに準拠しており、安全性が高くなっています。 プログラムは、IPアドレスの代わりに、すべてのログファイルを安全で分離されたFTPクラウドに保存します。

JetOctopusとScreamingFrogLog File Analyzerに加えて、Oncrawlには次のようないくつかの機能があります。

- IIS、Apache、Nginxなどの多くのログ形式をサポートします。

- ツールは、変更時に処理とストレージの要件に簡単に適応します

- 動的セグメンテーションは、さまざまな基準に基づいてURLと内部リンクをグループ化することにより、データのパターンと接続を明らかにするための強力なツールです。

- 生のログファイルのデータポイントを使用して、実用的なSEOレポートを作成します。

- FTPスペースに転送されるログファイルは、技術スタッフの助けを借りて自動化できます。

- Google、Bing、Yandex、Baiduのクローラーなど、人気のあるすべてのブラウザーを監視できます。

OnCrawl Log Analyzerには、さらに2つの重要なツールがあります。

Oncrawl SEO Crawler: Oncrawl SEO Crawlerを使用すると、最小限のリソースで高速にWebサイトをクロールできます。 ランキング基準が検索エンジン最適化(SEO)にどのように影響するかについてのユーザーの理解を向上させます。

オンクロールデータ:オンクロールデータは、クロールと分析からのデータを組み合わせることにより、すべてのSEO要因を分析します。 クロールファイルとログファイルからデータをフェッチしてクロールの動作を理解し、コンテンツまたはランキングページに優先順位を付けるためにクロール予算を推奨します。

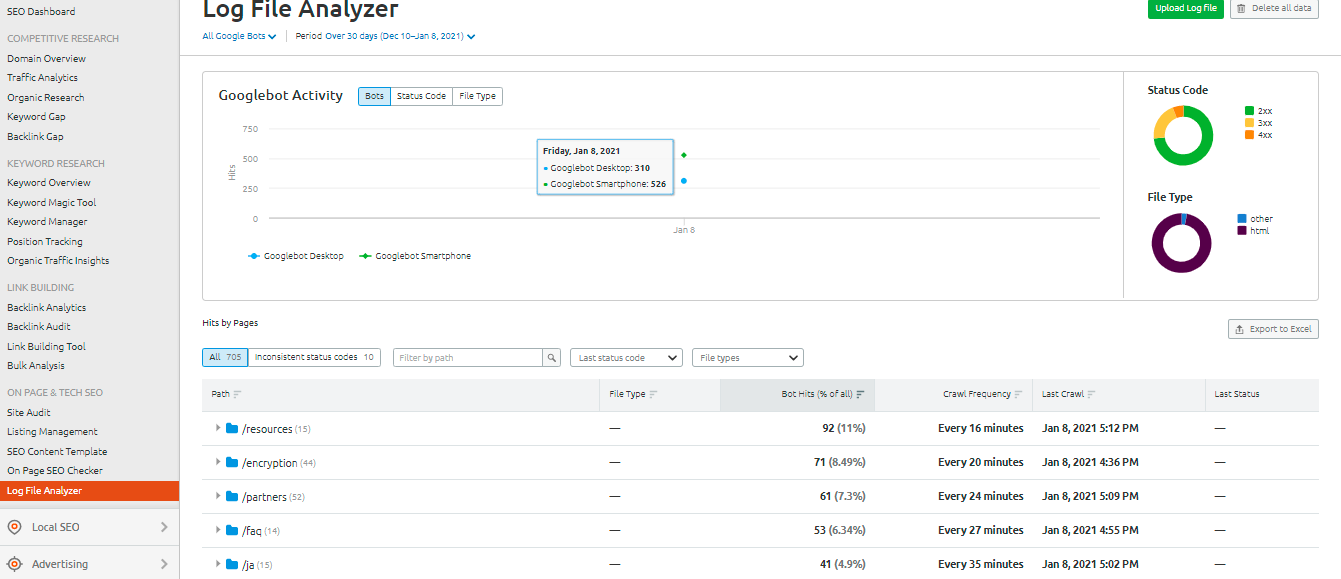

SEMrushログファイルアナライザー

SEMrush Log File Analyzerは、ブラウザーベースの簡単なログ分析ツールとして最適です。 このアナライザーはダウンロードを必要とせず、オンラインバージョンで使用できます。

SEMrushは、次の2つのレポートを表示します。

Pages'Hits :Pages' Hitsは、WebクローラーとWebサイトのコンテンツとの相互作用を報告します。 ボットとのやり取りが最大および最小のページ、フォルダー、およびURLのデータを提供します。

Googlebotのアクティビティ:Googlebotアクティビティレポートは、次のようなサイト関連の洞察を毎日提供します。

- クロールされたファイルの種類

- 全体的なHTTPステータスコード

- さまざまなボットによってサイトに対して行われたリクエストの数

SolarWindsからのLoggly

SolarWindsのLogglyは、Webサーバーのアクセスログとエラーログ、およびサイトの毎週のメトリックを調べます。 ログデータはいつでも見ることができ、ログの検索を簡単にする機能があります。

クライアントからのリソース要求の成功または失敗に関する情報を得るためにWebサーバー上のログファイルを効率的にマイニングするには、SolarWindsLogglyのような堅牢なログファイル分析ツールが必要です。

Logglyは、最も頻繁に表示されないページを表示するチャートを提供し、平均、最小、および最大のページ読み込み速度を計算して、Webサイトの検索エンジン最適化の最適化を支援します。

Google検索コンソールのクロール統計

Google Search Consoleは、その実践の有用な概要を提供することにより、ユーザーにとって物事を容易にしました。 コンソールの操作は簡単です。 クロール統計は、次の3つのカテゴリに分類されます。

- 1日あたりのダウンロードキロバイト数:ウェブサイトにアクセスしているときにGooglebotがダウンロードしたキロバイト数を示します。 これは基本的に2つの重要なポイントを示しています。グラフに高い平均が表示されている場合は、サイトがより頻繁にクロールされていることを意味します。または、ボットがWebサイトをクロールするのに時間がかかり、軽量ではないことを示している可能性もあります。

- 日ごとにクロールされたページ: Googlebotが1日にクロールしたページ数を示します。 また、クロールアクティビティのステータスが低、高、平均のいずれであるかを記録します。 クロール率が低い場合は、ウェブサイトがGooglebotによって適切にクロールされていないことを示しています

- ページのダウンロードに費やされた時間(ミリ秒単位):これは、ウェブサイトのクロール中にGooglebotがHTTPリクエストを行うのにかかった時間を示します。 Googlebotがリクエストを行うために費やす時間が少なくなり、インデックス作成が高速になるため、ページのダウンロードが向上します。

結論

ログファイルの分析とSEOのログファイルの監査に使用されるツールについて、このガイドから多くのことを理解していただければ幸いです。 ログファイルの監査は、Webサイトの技術的なSEOの側面を改善するために非常に効果的です。

GoogleSearchConsoleとSEMrushLogFile Analyzerは、無料の基本的な分析ツールの2つのオプションです。 別の方法として、Screaming Frog Log File Analyzer、JetOctopus、またはOncrawl Log Analyzerをチェックして、検索エンジンボットがWebサイトとどのように相互作用するかを理解してください。 SEOにはプレミアムと無料のログファイル分析ツールを組み合わせて使用できます。

また、SEOを改善するためにいくつかの高度なWebサイトクローラーを見ることができます。