Optimizarea bugetului cu crawlere: 8 sfaturi pentru a opri irosirea bugetului cu crawlere

Publicat: 2022-07-26Concluzie: dacă Google nu poate accesa cu crawlere paginile dvs. importante, acestea nu vor apărea în rezultatele căutării. Acest lucru ar putea duce la un trafic organic mai scăzut decât se aștepta și la clasamente deprimate.

Optimizarea bugetului de accesare cu crawlere facilitează accesul, accesarea și indexarea fiecărei pagini importante pentru Google, astfel încât să puteți ajunge la mai mulți clienți prin căutare. Iată ce trebuie să știți despre bugetul de accesare cu crawlere, cum să identificați risipa de buget de accesare cu crawlere și ce puteți face pentru a vă optimiza site-ul pentru a evita eventualele probleme legate de bugetul de accesare cu crawlere SEO.

Ce este Bugetul Crawl?

Bugetul dvs. de accesare cu crawlere se referă la numărul de pagini ale site-ului dvs. pe care Google le accesează cu crawlere într-o anumită zi. Se bazează pe limita ratei de accesare cu crawlere și pe cererea de accesare cu crawlere.

Limita ratei de accesare cu crawlere este numărul de pagini pe care Google le poate accesa cu crawlere fără a afecta experiența utilizatorului site-ului dvs. În esență, Google nu dorește să-ți supraîncarce serverul cu solicitări, așa că găsește un mediu fericit între ceea ce poate gestiona serverul tău (resurse serverului tău) și cât de mult „dorește” să acceseze cu crawlere site-ul tău.

Cererea dvs. de accesare cu crawlere este determinată de cât de populară este o adresă URL și de prospețimea acesteia. Dacă o adresă URL este învechită și puțini oameni o caută, Google o va accesa cu crawlere mai rar.

Deși nu vă puteți afecta rata de accesare cu crawlere, puteți influența cererea de accesare cu crawlere creând conținut nou, optimizând site-ul cu cele mai bune practici SEO și abordând probleme SEO precum 404s și redirecționări inutile.

Ce este optimizarea bugetului cu crawlere?

Optimizarea bugetului de accesare cu crawlere este procesul prin care Googlebot poate accesa, accesa cu crawlere și indexează mai ușor site-ul dvs., îmbunătățind navigabilitatea crawlerului de căutare și reducând risipa de buget de accesare cu crawlere. Aceasta include reducerea erorilor și a linkurilor întrerupte, îmbunătățirea legăturilor interne, neindexarea conținutului duplicat și multe altele.

Bugetul de accesare cu crawlere poate deveni o problemă atunci când Google nu accesează cu crawlere suficient paginile de pe site-ul dvs. sau nu le accesează cu crawlere suficient de frecvent.

Deoarece are doar un anumit număr de resurse cu care să lucreze, Google poate aloca doar atâtea accesări cu crawlere oricărui site în orice zi. Dacă aveți un site mare, aceasta înseamnă că Google poate avea resursele necesare pentru a accesa cu crawlere zilnic o mică parte din paginile site-ului dvs. Acest lucru poate afecta timpul necesar pentru ca paginile dvs. să fie indexate sau pentru ca actualizările de conținut să fie reflectate în clasamentele Google.

Din fericire, dacă credeți că site-ul dvs. poate avea probleme legate de bugetul de accesare cu crawlere Google, există anumite lucruri pe care le puteți face pentru a vă optimiza site-ul și a profita la maximum de bugetul pentru accesare cu crawlere.

Cum să verificați raportul privind statisticile de accesare cu crawlere

Puteți identifica problemele legate de bugetul de accesare cu crawlere verificând statisticile de accesare cu crawlere în Google Search Console sau analizând jurnalele fișierelor de pe server.

Vizualizarea raportului privind statisticile de accesare cu crawlere în Google Search Console vă poate ajuta să înțelegeți mai bine cum interacționează Googlebot cu site-ul dvs. web. Iată cum îl puteți folosi pentru a vedea ce a făcut crawlerul Google.

Deschideți Google Search Console, conectați-vă și alegeți site-ul dvs. Apoi selectați opțiunea „Setări” din meniul Search Console.

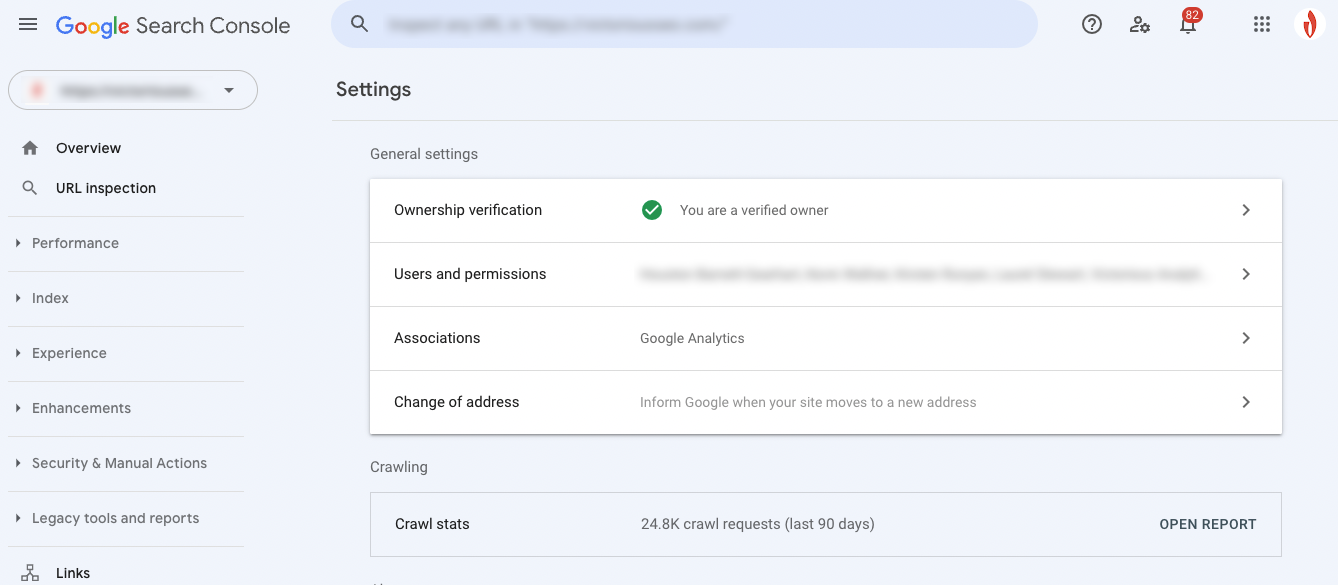

Puteți vedea raportul de accesare cu crawlere pentru ultimele 90 de zile în secțiunea statistici de accesare cu crawlere. Deschideți-l făcând clic pe „Deschide raport”.

Ce înseamnă raportul dvs. de statistică de accesare cu crawlere

Acum că puteți vedea activitatea Googlebot, este timpul să decodați datele. Iată o detaliere rapidă a tipului de informații pe care le puteți obține din raportul de accesare cu crawlere.

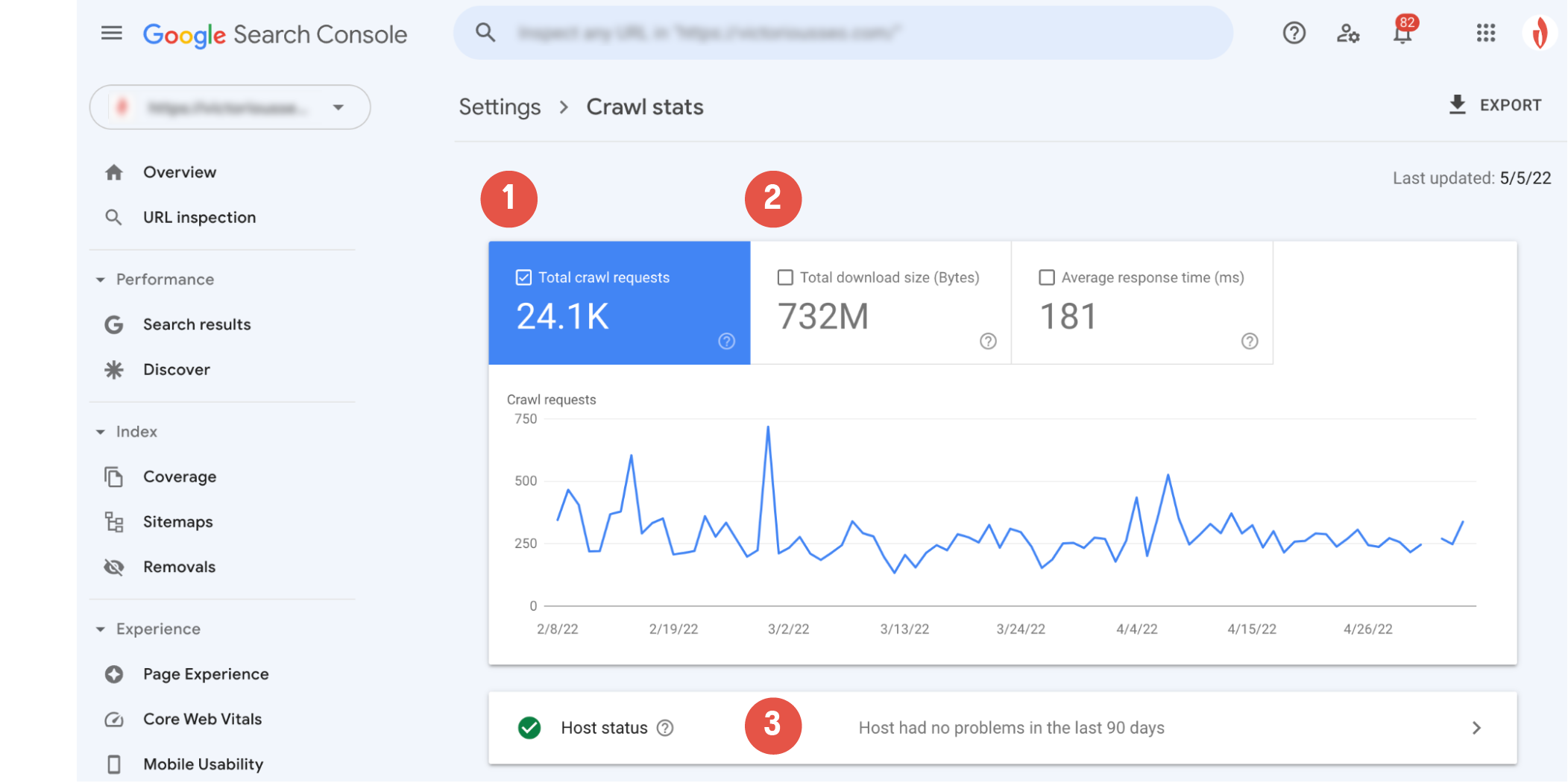

Graficul principal de accesare cu crawlere vă va arăta o reprezentare vizuală a activității de accesare cu crawlere a Googlebot. Aici puteți vedea (1) câte solicitări de accesare cu crawlere a trimis Google în ultimele 90 de zile și (2) timpul mediu de răspuns al serverului site-ului dvs. și cantitatea totală de octeți descărcați în timpul accesării cu crawlere.

Secțiunea „Starea gazdei” (3) vă va informa dacă crawler-ul a întâmpinat probleme de disponibilitate în timpul accesării site-ului dvs. web.

Un cerc verde cu o bifă albă înseamnă că Googlebot nu a întâmpinat probleme și indică faptul că gazda dvs. funcționează fără probleme.

Un cerc alb cu o bifă verde înseamnă că Googlebot a întâmpinat o problemă în urmă cu peste o săptămână, dar totul merge bine acum.

Un cerc roșu cu un semn de exclamare alb indică Googlebot a întâlnit cel puțin o problemă semnificativă în ultima săptămână.

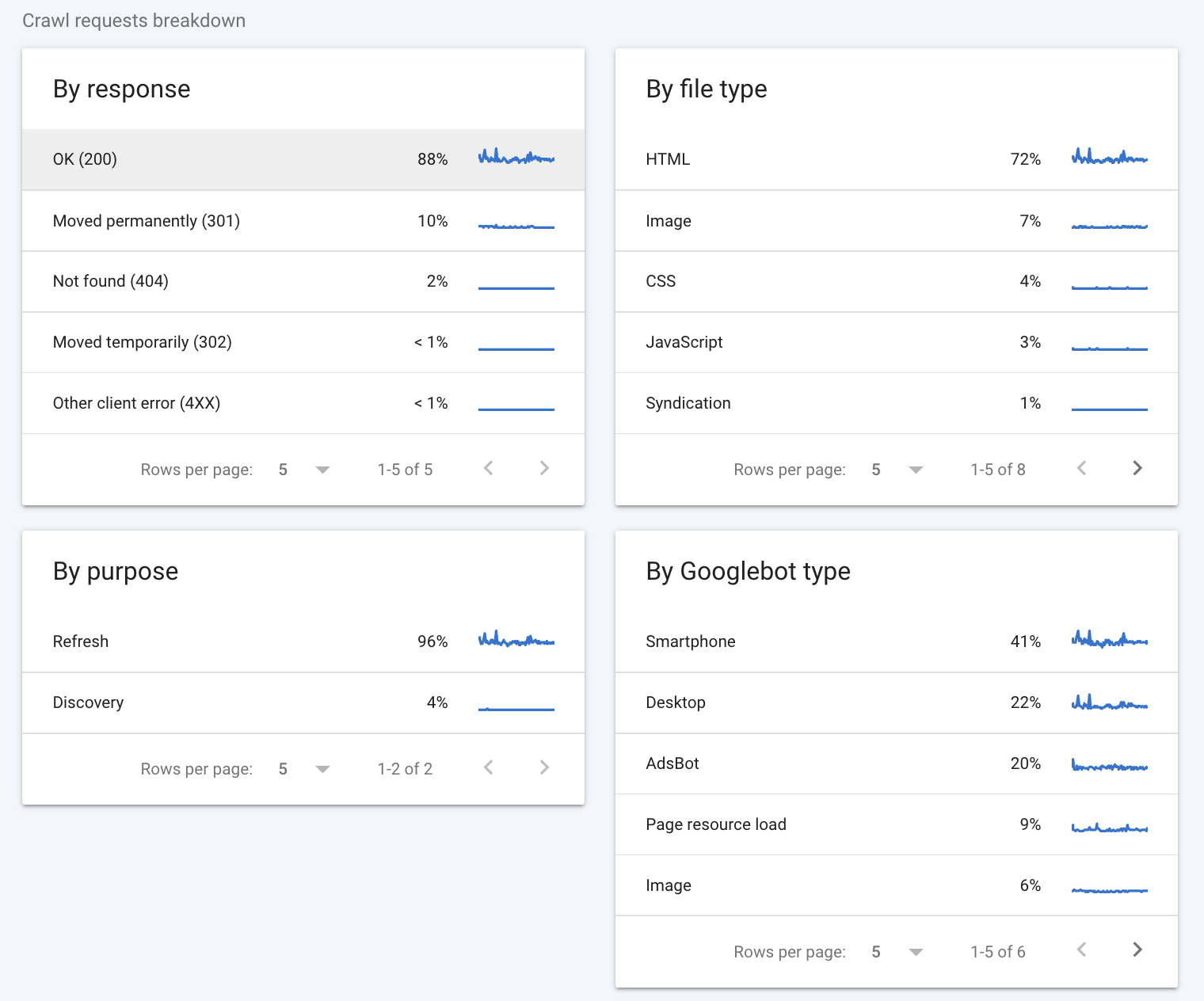

Defalcarea solicitărilor de accesare cu crawlere oferă câteva informații mai detaliate despre modul în care crawlerele Google au interacționat cu site-ul dvs.

Prin Răspuns

Prima secțiune pe care trebuie să o priviți este secțiunea „După răspuns”. Această secțiune vă spune ce fel de răspunsuri a primit Googlebot când a încercat să acceseze cu crawlere paginile de pe site-ul dvs. Google consideră următoarele răspunsuri bune:

- OK (200)

- Mutat definitiv (301)

- Mutat temporar (302)

- Mutat (altul)

- Nemodificat (304)

În mod ideal, majoritatea răspunsurilor ar trebui să fie 200 (unele 301 sunt și ele ok). Codurile precum „Nu s-au găsit (404)” sunt un avertisment că există probabil căi fără fund pe site-ul dvs. web care ar putea afecta bugetul de accesare cu crawlere.

Tip fișier

Secțiunea „După tip de fișier” vă arată ce tip de fișier a întâlnit Googlebot în timpul accesării cu crawlere. Valorile procentuale pe care le vedeți sunt reprezentative pentru procentul de răspunsuri de acel tip și nu pentru procentul de octeți ai fiecărui tip de fișier.

După Scop

Secțiunea „După scop” indică dacă pagina accesată cu crawler a fost una pe care crawler-ul a văzut-o înainte (o reîmprospătare) sau una nouă pentru crawler (o descoperire).

După tipul Googlebot

În cele din urmă, secțiunea „După tipul Googlebot” vă informează despre tipurile de agenți de accesare cu crawlere Googlebot utilizați pentru a face solicitări și a vă accesa cu crawlere site-ul. De exemplu, tipul „Smartphone” indică o vizită de către crawlerul smartphone-ului Google, în timp ce tipul „AdsBot” indică o accesare cu crawler de către unul dintre crawlerele Google AdsBot. Ca o notă secundară, puteți oricând să dezactivați anumite tipuri de roboti Google de la accesarea cu crawlere a site-ului dvs. prin editarea fișierului robots.txt.

Consultați ghidul Google pentru rapoartele de accesare cu crawlere din Search Console dacă doriți să aflați mai multe despre cum să interpretați datele din raportul de accesare cu crawlere.

Cum să-ți dai seama dacă îți irosești bugetul de crawl

O modalitate rapidă de a determina dacă optimizarea bugetului de accesare cu crawlere va ajuta Googlebot să acceseze cu crawlere mai multe dintre paginile dvs. este să vedeți ce procent din paginile site-ului dvs. sunt de fapt accesate cu crawlere pe zi.

Aflați exact câte pagini unice aveți pe site-ul dvs. și împărțiți-l la numărul „medie accesată cu crawlere pe zi”. Dacă aveți de zece sau mai multe ori numărul total de pagini decât paginile accesate cu crawlere pe zi, ar trebui să luați în considerare optimizarea bugetului de accesare cu crawlere.

Dacă credeți că aveți probleme legate de bugetul de accesare cu crawlere, începeți prin a consulta secțiunea „După răspuns” pentru a vedea ce tipuri de erori se poate confrunta cu crawlerul. Probabil că va trebui să efectuați o analiză mai profundă pentru a vedea exact ce vă mănâncă bugetul. O privire asupra jurnalelor de server vă poate oferi mai multe informații despre modul în care crawler-ul interacționează cu site-ul dvs.

Verificați jurnalele serverului dvs

O altă modalitate de a verifica dacă irosești bugetul de accesare cu crawlere este să te uiți la jurnalele de server ale site-ului tău. Aceste jurnale stochează fiecare solicitare făcută către site-ul dvs., inclusiv solicitările pe care Googlebot le face atunci când accesează cu crawlere site-ul dvs. Analizând jurnalele serverului dvs. vă puteți spune cât de des accesează Google site-ul dvs. cu crawlere, ce pagini accesează cel mai des crawler-ul și ce tipuri de erori le-a întâlnit robotul crawler.

Puteți verifica aceste jurnale manual, deși săparea pentru aceste date poate fi puțin plictisitoare. Din fericire, mai multe instrumente diferite de analiză a jurnalelor vă pot ajuta să sortați și să înțelegeți datele dvs. de jurnal, cum ar fi analizatorul de fișiere jurnal SEMRush sau analizatorul de fișiere jurnal Screaming Frog SEO.

Bugetul de accesare cu crawlere SEO: 8 moduri de a vă optimiza bugetul de accesare cu crawlere

Ați descoperit bugetul de accesare cu crawlere irosit? Strategiile de optimizare SEO pentru bugetul cu crawlere vă pot ajuta să reduceți risipa. Iată opt sfaturi pentru a vă ajuta să vă optimizați bugetul de accesare cu crawlere SEO pentru o performanță mai bună.

1. Finetune Robots.txt & Meta Robots Tags

O modalitate de a reduce bugetul de accesare cu crawlere irosit este, în primul rând, de a împiedica crawler-ul Google să acceseze cu crawlere anumite pagini. Ținând Googlebot departe de paginile pe care nu doriți să le indexați, îi puteți concentra atenția asupra paginilor dvs. mai importante.

Fișierul robots.txt stabilește limite pentru crawlerele de căutare, declarând ce pagini doriți să fie accesate cu crawlere și care sunt interzise. Adăugarea unei comenzi de respingere în fișierul dvs. robots.txt va împiedica crawlerele să acceseze, să acceseze cu crawlere și să indexeze subdirectoarele specificate, cu excepția cazului în care există legături care indică acele pagini.

La nivel de pagină, puteți utiliza etichete meta robots pentru a nu indexa anumite pagini. O etichetă noindex permite Googlebot să vă acceseze pagina și să urmeze linkurile de pe ea, dar îi spune lui Googlebot să se abțină de la indexarea paginii în sine. Această etichetă intră direct în elementul <head> al codului dvs. HTML și arată astfel:

<meta name=”robots” content=”noindex” />2. Tădea conținutul

Găzduirea adreselor URL cu valoare redusă sau a conținutului duplicat pe site-ul dvs. poate fi un obstacol pentru bugetul de accesare cu crawlere. O cercetare profundă a paginilor site-ului dvs. vă poate ajuta să identificați paginile inutile, care pot consuma bugetul de accesare cu crawlere și pot împiedica accesarea și indexarea conținutului mai valoros.

Ce se califică ca fiind o adresă URL cu valoare scăzută? Potrivit Google, adresele URL cu valoare redusă se încadrează de obicei într-una din mai multe categorii:

- Conținut duplicat

- Identificatori de sesiune

- Pagini de eroare soft

- Pagini piratate

- Calitate scăzută și conținut spam

Conținutul duplicat nu este întotdeauna ușor de identificat. Dacă majoritatea conținutului dintr-o pagină este același cu cel al altei pagini - chiar dacă ați adăugat mai mult conținut sau ați schimbat unele cuvinte - Google îl va vedea ca fiind semnificativ similar. Utilizați metaetichetele noindex și etichetele canonice pentru a indica ce pagină este originalul care ar trebui indexat.

Prin actualizarea, eliminarea sau neindexarea conținutului care se poate înregistra ca de valoare scăzută, oferiți Googlebotului mai multe oportunități de a accesa cu crawlere paginile de pe site-ul dvs. care sunt cu adevărat importante.

Lectură recomandată

- SEO pentru conținut duplicat: Cum să verificați conținutul duplicat

- De ce tăierea conținutului vă ajută SEO (și cum să o faceți)

3. Eliminați sau redați JavaScript

Googlebot nu are nicio problemă să citească HTML, totuși, trebuie să redea JavaScript înainte de a-l putea citi și indexa. Deci, în loc să acceseze cu crawlere și să indexeze un element JavaScript pe o pagină, Google accesează cu crawlere conținutul HTML din pagină și apoi plasează pagina într-o coadă de randare. Când are timpul și resursele de dedicat redării, va reda JavaScript și îl va „citi”, apoi îl va indexa în cele din urmă. Acest pas suplimentar nu necesită doar mai mult timp, ci necesită mai mult buget de accesare cu crawlere.

JavaScript poate afecta, de asemenea, timpii de încărcare a paginii dvs. și, deoarece viteza site-ului și încărcarea serverului vă influențează bugetul de accesare cu crawlere, Google poate accesa cu crawlere site-ul dvs. mai puțin decât v-ați dori dacă este blocat cu prea mult JavaScript.

Pentru a economisi bugetul de accesare cu crawlere, nu puteți indexa paginile cu JavaScript, puteți elimina elementele JavaScript sau utilizați un instrument precum Prerender care redă conținut JavaScript dinamic ca HTML static și facilitează înțelegerea și accesarea cu crawlere de către Google.

4. Eliminați 301 Redirect Chains

Redirecționările 301 sunt o modalitate utilă și prietenoasă cu SEO de a transfera traficul și echitatea linkurilor de la o adresă URL pe care doriți să o eliminați la o altă adresă URL relevantă.

Cu toate acestea, este ușor să creați accidental lanțuri de redirecționare dacă nu vă urmăriți redirecționările. Acest lucru nu numai că poate duce la creșterea timpilor de încărcare pentru vizitatorii site-ului dvs., dar poate determina și crawler-ii să acceseze cu crawlere mai multe adrese URL doar pentru a accesa o pagină de conținut real. Aceasta înseamnă că Google va trebui să acceseze cu crawlere fiecare adresă URL din lanțul de redirecționare pentru a ajunge la pagina de destinație, consumând bugetul de accesare cu crawlere în acest proces.

Pentru a preveni acest lucru, asigurați-vă că toate redirecționările vizează destinația lor finală. Este întotdeauna o practică bună să evitați utilizarea lanțurilor de redirecționare ori de câte ori este posibil. Totuși, se întâmplă greșeli, așa că faceți-vă ceva timp pentru a vă parcurge site-ul manual sau utilizați un instrument de verificare a redirecționării pentru a identifica și curăța orice lanțuri de redirecționare 301.

5. Urmați cele mai bune practici XML Sitemap

Harta site-ului dvs. partajează toate paginile dvs. importante cu crawlerele de căutare - sau cel puțin ar trebui. Motoarele de căutare accesează cu crawlere hărțile de site pentru a găsi cu ușurință pagini. Deși Google spune că nu are nevoie de unul pentru a vă găsi paginile, este totuși o idee bună să păstrați una.

Pentru a funcționa bine, harta dvs. de site ar trebui să includă numai paginile pe care doriți să le indexați. Ar trebui să eliminați orice adrese URL neindexate sau redirecționate din harta site-ului dvs. O modalitate ușoară de a face acest lucru este cu un sitemap XML generat dinamic. Sitemapurile generate dinamic se actualizează singure, astfel încât nu trebuie să vă faceți griji cu privire la editarea dvs. după fiecare 301 pe care o implementați.

Dacă aveți mai multe subdirectoare pe site-ul dvs., utilizați un index de hărți de site care găzduiește linkuri către fiecare dintre hărțile de site ale subdirectoarelor dvs. Acest lucru ajută la prezentarea arhitecturii site-ului dvs. și oferă o foaie de parcurs ușoară pe care să o urmărească crawlerele de căutare.

6. Creați o strategie de legătură internă

Link-urile interne nu ajută doar vizitatorii site-ului să se deplaseze; de asemenea, creează o cale de mișcare mai clară pentru roboții cu crawler.

O strategie de conectare internă bine dezvoltată poate direcționa crawlerele către paginile pe care doriți să le accesați cu crawlere. Deoarece crawlerele folosesc linkuri pentru a găsi alte pagini, interconectarea paginilor mai profunde cu conținut de nivel superior poate ajuta crawlerul să le acceseze mai rapid. În același timp, eliminarea linkurilor din paginile cu prioritate scăzută pe care nu doriți să le consumați în bugetul de accesare cu crawlere poate ajuta să le împingeți în spatele cozii și să vă asigurați că paginile dvs. importante sunt accesate cu crawlere mai întâi.

7. Remediați erorile site-ului

Erorile site-ului pot declanșa crawlerele de căutare și irosesc un buget valoros pentru accesare cu crawlere. În mod ideal, doriți ca crawler-ul fie să întâlnească o pagină reală, fie o singură redirecționare către pagina respectivă. Dacă se confruntă cu lanțuri de redirecționare sau o pagină de eroare 404, atunci irosești bugetul de accesare cu crawlere.

Utilizați raportul de accesare cu crawlere din Google Search Console pentru a identifica unde crawlerul întâlnește erori și ce tipuri de erori sunt acestea. Eliminarea oricăror erori identificabile va crea o experiență de accesare cu crawlere mai fluidă pentru Googlebot.

8. Verificați dacă există legături întrerupte

Un URL este practic o punte între două pagini. Oferă crawlerului motorului de căutare o cale pentru găsirea de pagini noi, dar unele adrese URL nu ajung nicăieri. O legătură întreruptă este un punct mort pentru crawlerele motoarelor de căutare și o risipă a bugetului limitat de accesare cu crawlere.

Acordați-vă timp pentru a verifica site-ul dvs. pentru link-uri rupte care ar putea trimite crawlerele de căutare către pagini moarte și pentru a le corecta sau elimina. Pe lângă reducerea risipei bugetului de accesare cu crawlere, veți îmbunătăți, de asemenea, experiența de navigare a vizitatorilor prin eliminarea link-urilor întrerupte, așa că efectuarea unei verificări periodice a link-urilor este întotdeauna o idee bună.

Opriți irosirea bugetului de crawl cu un audit SEO

Vă simțiți copleșit sau nu sunteți sigur de unde să începeți cu optimizarea bugetului de accesare cu crawlere al site-ului dvs. sau SEO general? Nu e nevoie să mergi singur. Rezervă astăzi o consultație cu Victorious și lasă-i experților noștri să te ajute prin procesul de realizare a unui audit SEO și de concepere a unei strategii pentru optimizarea SEO a site-ului tău.