Ottimizzazione del budget di scansione: 8 suggerimenti per fermare il budget di scansione sprecato

Pubblicato: 2022-07-26In conclusione: se Google non è in grado di eseguire la scansione delle tue pagine importanti, non verranno visualizzate nei risultati di ricerca. Ciò potrebbe portare a un traffico organico inferiore al previsto e a classifiche depresse.

L'ottimizzazione del budget di scansione rende più facile per Google l'accesso, la scansione e l'indicizzazione di ciascuna delle tue pagine importanti in modo da poter raggiungere più clienti tramite la ricerca. Ecco cosa devi sapere sul crawl budget, come identificare lo spreco di crawl budget e cosa puoi fare per ottimizzare il tuo sito per evitare possibili problemi di crawl budget SEO.

Che cos'è il budget di scansione?

Il budget di scansione si riferisce al numero di pagine del tuo sito che Google scansiona in un dato giorno. Si basa sul limite della velocità di scansione e sulla domanda di scansione.

Il tuo limite di velocità di scansione è il numero di pagine che Google può scansionare senza influire sull'esperienza utente del tuo sito web. In sostanza, Google non vuole sovraccaricare il tuo server di richieste, quindi trova una via di mezzo tra ciò che il tuo server può gestire (risorse del tuo server) e quanto "vuole" eseguire la scansione del tuo sito.

La tua richiesta di scansione è determinata dalla popolarità di un URL e dalla sua freschezza. Se un URL è obsoleto e poche persone lo cercano, Google lo eseguirà con minore frequenza.

Anche se non puoi influire sulla tua velocità di scansione, puoi influire sulla tua domanda di scansione creando nuovi contenuti, ottimizzando il tuo sito con le migliori pratiche SEO e affrontando problemi SEO come 404 e reindirizzamenti non necessari.

Che cos'è l'ottimizzazione del budget di scansione?

L'ottimizzazione del budget di scansione è il processo che semplifica l'accesso, la scansione e l'indicizzazione del tuo sito da parte di Googlebot, migliorando la navigabilità del crawler di ricerca e riducendo lo spreco di budget di scansione. Ciò include la riduzione degli errori e dei collegamenti interrotti, il miglioramento dei collegamenti interni, il non indicizzazione dei contenuti duplicati e altro ancora.

Il budget di scansione può diventare un problema quando Google non esegue la scansione a sufficienza delle pagine del tuo sito o non le esegue con una frequenza sufficiente.

Poiché ha solo un certo numero di risorse con cui lavorare, Google può assegnare solo così tante scansioni a un determinato sito in un dato giorno. Se disponi di un sito di grandi dimensioni, ciò significa che Google potrebbe disporre delle risorse per eseguire quotidianamente la scansione di una piccola parte delle pagine del tuo sito. Ciò può influire sul tempo necessario affinché le tue pagine vengano indicizzate o affinché gli aggiornamenti dei contenuti si riflettano nelle classifiche di Google.

Per fortuna, se ritieni che il tuo sito possa soffrire di problemi di budget di scansione di Google, ci sono alcune cose che puoi fare per ottimizzare il tuo sito e ottenere il massimo dal tuo budget di scansione.

Come controllare il rapporto sulle statistiche di scansione

Puoi identificare i problemi di budget di scansione controllando le statistiche di scansione in Google Search Console o analizzando i log dei file del server.

La visualizzazione del rapporto sulle statistiche di scansione in Google Search Console può aiutarti a capire meglio come Googlebot interagisce con il tuo sito web. Ecco come puoi usarlo per vedere cosa ha combinato il crawler di Google.

Apri Google Search Console, accedi e scegli il tuo sito web. Quindi seleziona l'opzione "Impostazioni" dal menu di Search Console.

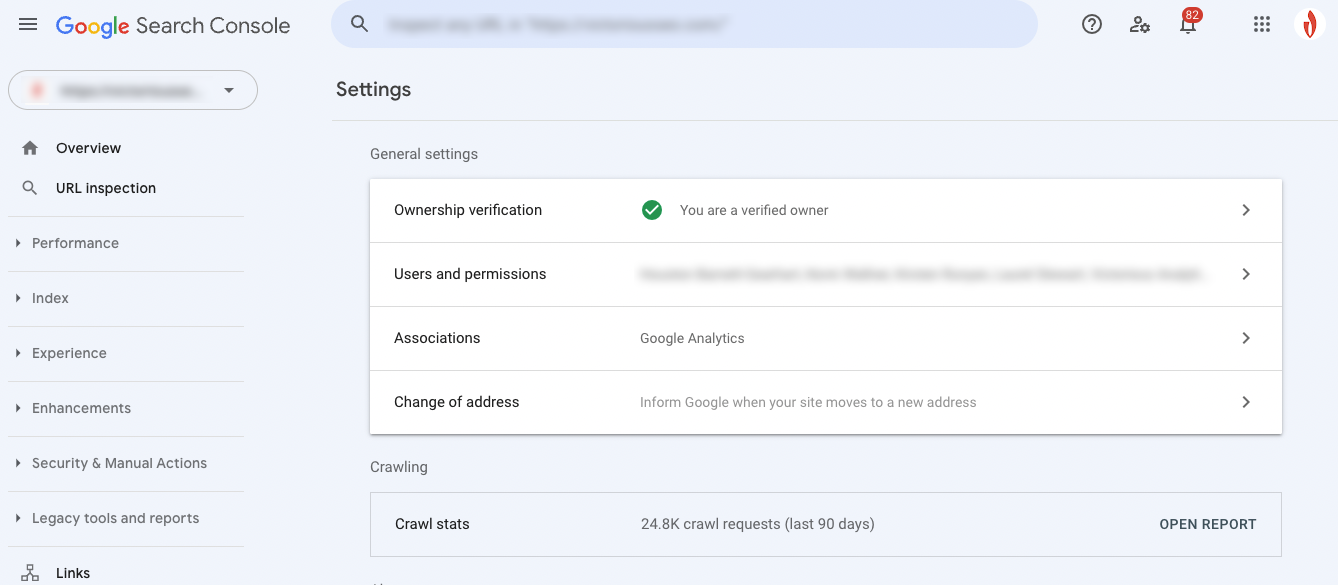

Puoi visualizzare il rapporto di scansione degli ultimi 90 giorni nella sezione delle statistiche di scansione. Aprilo facendo clic su "Apri rapporto".

Cosa significa il tuo rapporto sulle statistiche di scansione

Ora che puoi vedere l'attività di Googlebot, è il momento di decodificare i dati. Ecco una rapida ripartizione del tipo di informazioni che puoi ottenere dal rapporto di scansione.

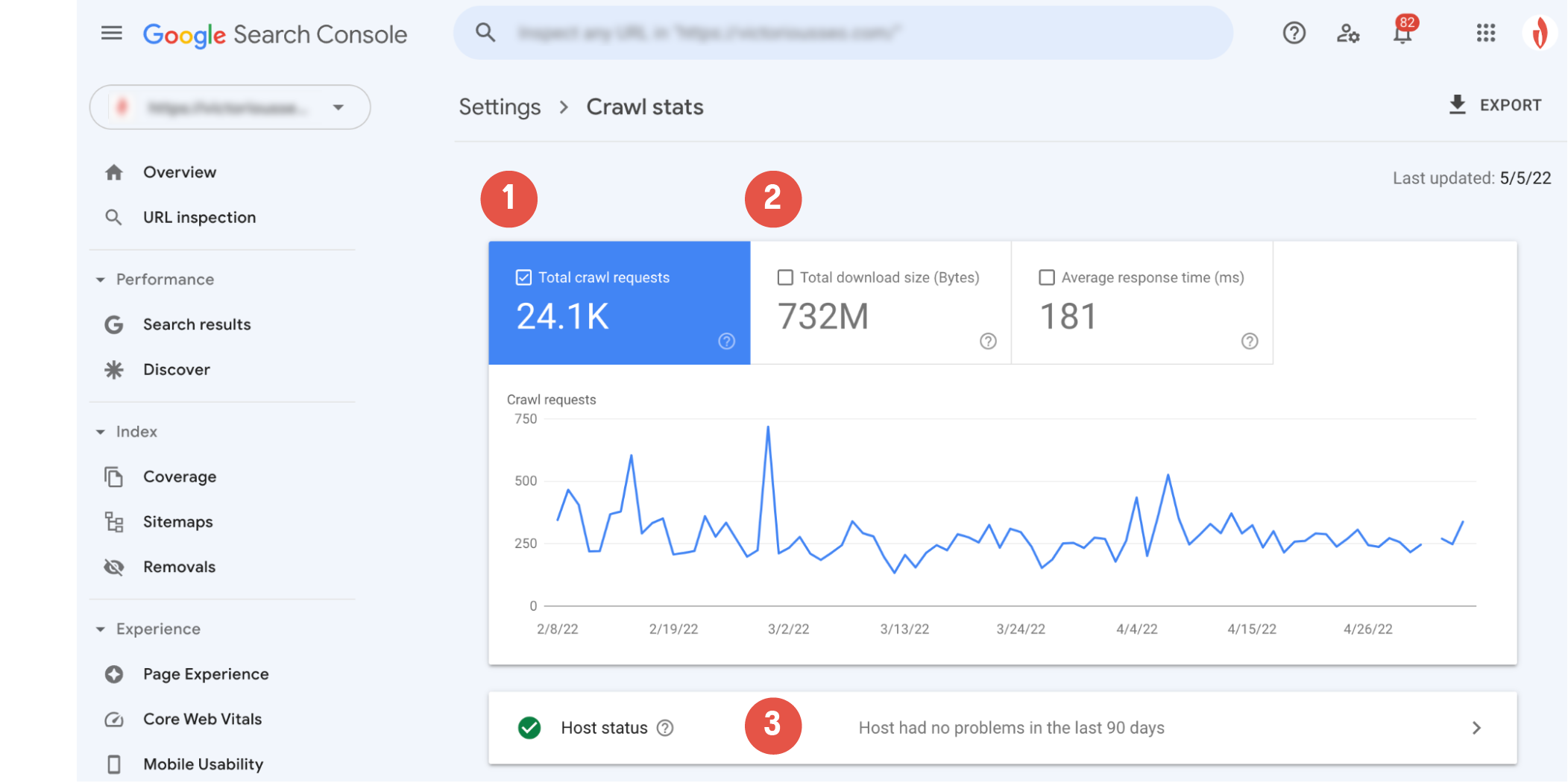

Il grafico di scansione principale ti mostrerà una rappresentazione visiva dell'attività di scansione di Googlebot. Qui puoi vedere (1) quante richieste di scansione ha inviato Google negli ultimi 90 giorni e (2) il tempo medio di risposta del server del tuo sito e la quantità totale di byte scaricati durante la scansione.

La sezione "Stato host" (3) ti informerà se il crawler ha riscontrato problemi di disponibilità durante l'accesso al tuo sito web.

Un cerchio verde con un segno di spunta bianco indica che Googlebot non ha riscontrato problemi e indica che il tuo host funziona correttamente.

Un cerchio bianco con un segno di spunta verde indica che Googlebot ha riscontrato un problema più di una settimana fa, ma ora tutto funziona correttamente.

Un cerchio rosso con un punto esclamativo bianco indica che Googlebot ha riscontrato almeno un problema significativo nell'ultima settimana.

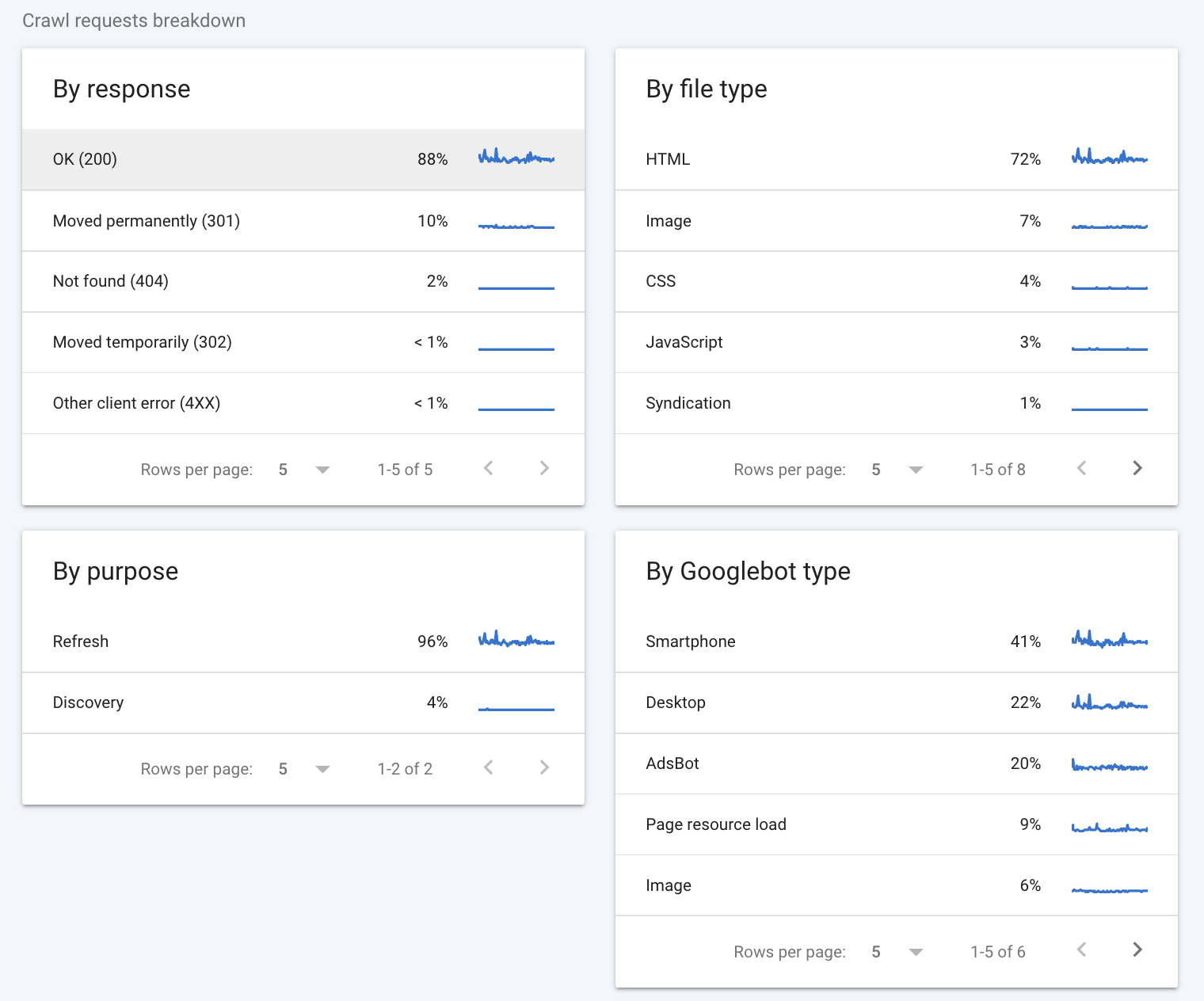

L'analisi delle richieste di scansione fornisce alcune informazioni più dettagliate su come i crawler di Google hanno interagito con il tuo sito.

Per risposta

La prima sezione da guardare è la sezione "Per risposta". Questa sezione ti dice che tipo di risposte ha ricevuto Googlebot quando ha tentato di eseguire la scansione delle pagine del tuo sito. Google considera le seguenti buone risposte:

- OK (200)

- Trasferito definitivamente (301)

- Trasferito temporaneamente (302)

- Spostato (altro)

- Non modificato (304)

Idealmente, la maggior parte delle risposte dovrebbe essere 200 (anche alcuni 301 vanno bene). Codici come "Non trovato (404)" segnalano che ci sono probabilmente vicoli ciechi sul tuo sito web che potrebbero incidere sul tuo budget di scansione.

Tipo di file

La sezione "Per tipo di file" indica il tipo di file rilevato da Googlebot durante la scansione. I valori percentuali visualizzati sono rappresentativi della percentuale di risposte di quel tipo e non della percentuale di byte di ciascun tipo di file.

Intenzionalmente

La sezione "Per scopo" indica se la pagina sottoposta a scansione è stata vista in precedenza dal crawler (un aggiornamento) o una nuova per il crawler (una scoperta).

Per tipo di Googlebot

Infine, la sezione "Per tipo di Googlebot" ti fornisce informazioni sui tipi di agenti di scansione di Googlebot utilizzati per effettuare richieste ed eseguire la scansione del tuo sito. Ad esempio, il tipo "Smartphone" indica una visita da parte del crawler di smartphone di Google, mentre il tipo "AdsBot" indica una scansione da parte di uno dei crawler AdsBot di Google. Come nota a margine, puoi sempre disabilitare determinati tipi di Googlebot dalla scansione del tuo sito web modificando il file robots.txt.

Consulta la guida di Google ai rapporti di scansione di Search Console se vuoi saperne di più su come interpretare i dati nel rapporto di scansione.

Come capire se stai sprecando il tuo budget di scansione

Un modo rapido per determinare se l'ottimizzazione del budget di scansione aiuterà Googlebot a eseguire la scansione di più pagine è vedere quale percentuale delle pagine del tuo sito viene effettivamente scansionata ogni giorno.

Scopri esattamente quante pagine uniche hai sul tuo sito web e dividilo per il numero "media scansionata al giorno". Se hai dieci o più pagine totali rispetto alle pagine scansionate al giorno, dovresti prendere in considerazione l'ottimizzazione del budget di scansione.

Se ritieni di avere problemi con il budget di scansione, inizia esaminando la sezione "Per risposta" per vedere in quali tipi di errori potrebbe essere incappato il crawler. Probabilmente dovrai eseguire un'analisi più approfondita per vedere esattamente cosa sta consumando il tuo budget. Uno sguardo ai log del tuo server può darti maggiori informazioni su come il crawler sta interagendo con il tuo sito.

Controlla i registri del tuo server

Un altro modo per verificare se stai sprecando il budget di scansione è guardare i log del server del tuo sito. Questi log memorizzano ogni singola richiesta effettuata al tuo sito web, comprese le richieste che Googlebot effettua quando esegue la scansione del tuo sito. L'analisi dei log del tuo server può dirti con quale frequenza Google esegue la scansione del tuo sito Web, a quali pagine il crawler accede più spesso e che tipo di errori ha riscontrato il bot del crawler.

Puoi controllare questi registri manualmente, anche se scavare per questi dati può essere un po' noioso. Per fortuna, diversi strumenti di analisi dei registri possono aiutarti a ordinare e dare un senso ai tuoi dati di registro, come l'analizzatore di file di registro SEMRush o l'analizzatore di file di registro SEO Screaming Frog.

Crawl Budget SEO: 8 modi per ottimizzare il tuo budget di scansione

Hai scoperto il crawl budget sprecato? Le strategie di ottimizzazione SEO del crawl budget possono aiutarti a ridurre gli sprechi. Ecco otto suggerimenti per aiutarti a ottimizzare il tuo budget di scansione SEO per prestazioni migliori.

1. Ottimizza Robots.txt e tag Meta Robot

Un modo per frenare il crawl budget sprecato è innanzitutto impedire al crawler di Google di eseguire la scansione di determinate pagine. Tenendo Googlebot lontano dalle pagine che non vuoi indicizzare, puoi concentrare la sua attenzione sulle tue pagine più importanti.

Il file robots.txt imposta i limiti per i crawler di ricerca dichiarando quali pagine desideri scansionare e quali sono off-limits. L'aggiunta di un comando disallow al file robots.txt impedirà ai crawler di accedere, scansionare e indicizzare le sottodirectory specificate, a meno che non siano presenti collegamenti che puntano a tali pagine.

A livello di pagina, puoi utilizzare meta tag robots per pagine particolari noindex. Un tag noindex consente a Googlebot di accedere alla tua pagina e di seguirne i collegamenti, ma dice a Googlebot di astenersi dall'indicizzare la pagina stessa. Questo tag va direttamente nell'elemento <head> del tuo codice HTML e si presenta così:

<meta name=”robots” content=”noindex” />2. Potare il contenuto

L'hosting di URL di basso valore o contenuti duplicati sul tuo sito può essere un freno al tuo budget di scansione. Un'analisi approfondita delle pagine del tuo sito Web può aiutarti a identificare le pagine non necessarie che potrebbero consumare il budget di scansione e impedire la scansione e l'indicizzazione di contenuti più preziosi.

Cosa si qualifica come URL di basso valore? Secondo Google, gli URL di basso valore rientrano in genere in una di diverse categorie:

- Contenuto duplicato

- Identificatori di sessione

- Pagine di errore morbide

- Pagine hackerate

- Contenuti di bassa qualità e spam

I contenuti duplicati non sono sempre facili da identificare. Se la maggior parte dei contenuti di una pagina è uguale a quella di un'altra pagina, anche se hai aggiunto più contenuti o hai modificato alcune parole, Google lo vedrà come notevolmente simile. Utilizza i meta tag noindex e i tag canonici per indicare quale pagina è l'originale da indicizzare.

Aggiornando, rimuovendo o non indicizzando i contenuti che potrebbero essere registrati come di basso valore, offri a Googlebot maggiori opportunità di eseguire la scansione delle pagine del tuo sito che sono veramente importanti.

Lettura consigliata

- SEO per contenuti duplicati: come verificare la presenza di contenuti duplicati

- Perché lo sfoltimento dei contenuti aiuta il tuo SEO (e come farlo)

3. Rimuovere o eseguire il rendering di JavaScript

Googlebot non ha problemi a leggere l'HTML, tuttavia, deve eseguire il rendering di JavaScript prima di poterlo leggere e indicizzarlo. Quindi, anziché eseguire la scansione e l'indicizzazione di un elemento JavaScript su una pagina, Google esegue la scansione del contenuto HTML della pagina e quindi inserisce la pagina in una coda di rendering. Quando ha il tempo e le risorse da dedicare al rendering, eseguirà il rendering di JavaScript e lo "leggerà", quindi infine lo indicizzerà. Questo passaggio aggiuntivo non richiede solo più tempo, ma richiede più budget di scansione.

JavaScript può anche influire sui tempi di caricamento della tua pagina e, poiché la velocità del sito e il carico del server influiscono sul tuo budget di scansione, Google potrebbe eseguire la scansione del tuo sito meno frequentemente di quanto vorresti se fosse impantanato con troppo JavaScript.

Per risparmiare il budget di scansione, puoi noindex pagine con JavaScript, rimuovere i tuoi elementi JavaScript o utilizzare uno strumento come Prerender che esegue il rendering di contenuti JavaScript dinamici come HTML statico e semplifica la comprensione e la scansione di Google.

4. Rimuovere 301 catene di reindirizzamento

I reindirizzamenti 301 sono un modo utile e SEO friendly per trasferire traffico e link equity da un URL che desideri rimuovere a un altro URL pertinente.

Tuttavia, è facile creare accidentalmente catene di reindirizzamento se non stai tracciando i tuoi reindirizzamenti. Questo non solo può portare a tempi di caricamento più lunghi per i visitatori del tuo sito, ma può anche indurre i crawler a eseguire la scansione di più URL solo per accedere a una pagina di contenuto effettivo. Ciò significa che Google dovrà eseguire la scansione di tutti gli URL nella catena di reindirizzamento per raggiungere la pagina di destinazione, consumando nel frattempo il budget di scansione.

Per evitare ciò, assicurati che tutti i tuoi reindirizzamenti puntino alla loro destinazione finale. È sempre buona norma evitare di utilizzare le catene di reindirizzamento quando possibile. Tuttavia, si verificano errori, quindi prenditi del tempo per esaminare manualmente il tuo sito o utilizza uno strumento di controllo del reindirizzamento per individuare e ripulire eventuali catene di reindirizzamento 301.

5. Segui le best practice della Sitemap XML

La tua mappa del sito condivide tutte le tue pagine importanti con i crawler di ricerca, o almeno dovrebbe. I motori di ricerca scansionano le mappe dei siti per trovare facilmente le pagine. Anche se Google afferma che non ne ha bisogno per trovare le tue pagine, è comunque una buona idea mantenerne una.

Per funzionare correttamente, la tua mappa del sito dovrebbe includere solo le pagine che desideri indicizzare. Dovresti rimuovere tutti gli URL non indicizzati o reindirizzati dalla tua mappa del sito. Un modo semplice per farlo è con una mappa del sito XML generata dinamicamente. Le mappe del sito generate dinamicamente si aggiornano da sole, quindi non devi preoccuparti di modificare le tue dopo ogni 301 implementazioni.

Se disponi di più sottodirectory sul tuo sito, utilizza un indice della mappa del sito che ospita i collegamenti alle mappe del sito di ciascuna delle tue sottodirectory. Ciò consente di mostrare l'architettura del tuo sito Web e fornisce una tabella di marcia facile da seguire per i crawler di ricerca.

6. Creare una strategia di collegamento interno

I collegamenti interni non solo aiutano i visitatori del sito a spostarsi; creano anche un percorso di movimento più chiaro per i robot crawler.

Una strategia di collegamento interno ben sviluppata può indirizzare i crawler verso le pagine che desideri sottoporre a scansione. Poiché i crawler utilizzano i collegamenti per trovare altre pagine, l'interconnessione di pagine più profonde con contenuti di livello superiore può aiutare il crawler ad accedervi più rapidamente. Allo stesso tempo, rimuovere i link dalle pagine a bassa priorità che non vuoi intaccare nel tuo budget di scansione può aiutare a spingerli in fondo alla coda e garantire che le tue pagine importanti vengano scansionate per prime.

7. Correggi gli errori del sito

Gli errori del sito possono inciampare nei crawler di ricerca e sprecare prezioso budget di scansione. Idealmente, vuoi che il crawler incontri una pagina reale o un singolo reindirizzamento a quella pagina. Se si verificano catene di reindirizzamento o una pagina di errore 404, stai sprecando il budget di scansione.

Utilizza il rapporto sulla scansione di Google Search Console per identificare dove il crawler sta riscontrando errori e di che tipo si tratta. L'eliminazione di eventuali errori identificabili creerà un'esperienza di scansione più fluida per Googlebot.

8. Verifica la presenza di collegamenti interrotti

Un URL è fondamentalmente un ponte tra due pagine. Fornisce al crawler dei motori di ricerca un percorso per trovare nuove pagine, ma alcuni URL non vanno da nessuna parte. Un collegamento interrotto è un vicolo cieco per i crawler dei motori di ricerca e uno spreco del tuo budget di scansione limitato.

Prenditi del tempo per controllare il tuo sito alla ricerca di collegamenti interrotti che potrebbero inviare i crawler di ricerca a pagine morte e correggerli o rimuoverli. Oltre a ridurre lo spreco di crawl budget, migliorerai anche l'esperienza di navigazione dei visitatori rimuovendo i collegamenti interrotti, quindi eseguire un controllo periodico dei collegamenti è sempre una buona idea.

Ferma il budget di scansione sprecato con un audit SEO

Ti senti sopraffatto o non sai da dove iniziare con l'ottimizzazione del crawl budget del tuo sito o della SEO generale? Non c'è bisogno di andare da soli. Prenota oggi stesso una consulenza con Victorious e lascia che i nostri esperti ti aiutino nel processo di esecuzione di un audit SEO e nell'elaborazione di una strategia per ottimizzare il SEO del tuo sito.