技術的なSEOの問題:あなたのウェブサイトがSERPでランク付けされない一般的な理由

公開: 2022-06-03世界中でビジネスの数が増えるにつれ、最大のターゲット顧客の注意を引くために、WebサイトはSERPで上位にランク付けされる必要があります。 したがって、技術的なSEOに一生懸命取り組む必要があります。 そうしないと、Webサイトのランク付けに失敗し、潜在的な顧客にリーチできなくなります。 プロフェッショナルなSEOサービスは、一般的な技術的なSEOの問題や間違いを特定して修正するための大きな投資になる可能性があります。

それでも、あなたのウェブサイトが望ましい検索エンジンのランクを取得していない最も一般的な理由を知っておく必要があります。 ここでは、技術的なSEOとは何か、その重要性、および検索エンジンの結果でWebサイトのパフォーマンスを損なう可能性のある主要なSEOの間違いについて学習します。

読み続けます。

テクニカルSEOとは何ですか?

テクニカルSEOは、ウェブサイトとサーバーを最適化するプロセスであり、検索エンジンスパイダーがウェブサイトをより迅速にクロールしてインデックスに登録し、オーガニックランキングを上げるのに役立ちます。 これは、Webサイトの一部の要素を構成してWeb用にインデックスを作成する方法です。

このプロセスには、Webサイトのフレームワーク、インデックス作成、サイトマップの生成、クロール、ページ速度、移行、コアバイタルなどのすべての基本概念と高度な概念が含まれます。 あなたのウェブサイトをSERPで上位にランク付けしたい場合は、技術的なSEOに取り組み、望ましい結果を得る必要があります。

テクニカルSEOの重要性は何ですか?

あなたのウェブサイトは最高のコンテンツを持っているかもしれませんが、技術的なSEOが基準に達していない場合、あなたはSERPにランク付けされません。 一流のWebコンテンツは、誰もそれを見つけて見ることができないのかどうか疑問に思うことは決してありません。

検索エンジンは、Webサイトのコンテンツのクロール、インデックス作成、および理解を向上させています。 しかし、それらはまだ完璧ではありません。 したがって、しっかりした技術的なSEOベースでWebサイトのコンテンツを充実させる必要があります。 最も効果的なSEO戦略を実装すると、リードが生成され、コンバージョンと売上が増加します。

あなたのウェブサイトはそれなしでは不完全に索引付けされるので、技術的なSEOは非常に重要です。 不適切なインデックス作成により、Google、Yahoo、Bing、およびその他の検索エンジンは、SERPにWebサイトを表示するタイミングを理解できません。

あなたがあなたのウェブサイトで技術的なSEO監査を行うとき、それはあなたがあなたのウェブサイトでのあなたのすべての努力が索引付けされてランク付けされるようにあなたが完璧なフレームワークを持っていることを保証します。

それでは、Webサイトで発生する可能性のある最も一般的な技術的なSEOの間違いと、それらのエラーを修正する方法について説明しましょう。

最も一般的なSEOの間違いは何ですか?これらのSEOの問題を修正する方法は?

これがあなたのウェブサイトが持っている傾向がある技術的なSEOの間違いの種類です:

重複コンテンツ

グーグルは永遠にユニークなウェブサイトのコンテンツを愛しています。 したがって、Google検索結果の最初のページのトップにランク付けしたい場合、重複コンテンツは重大な間違いになる可能性があります。

コンテンツをユニークで新鮮に保ち、一貫してWebサイトを更新し、ブログを頻繁に投稿します。 大きな変更は小さな変更よりもGoogleへのより良いシグナルであるため、Webサイトのコンテンツをアップグレードするときは、大きな変更を加えるようにしてください。 ブログやWebページを追加するだけでなく、検索者やターゲット顧客に付加価値を与える補足コンテンツも作成する必要があります。

Webサイトに追加できるさまざまな種類のコンテンツは次のとおりです。

- インフォグラフィック

- 白い紙

- 電子ブック

- ダウンロード可能なテンプレート

- インタラクティブなツールまたはマップ

- ビデオ

Webサイトのコンテンツをドラフトした後、SEMRushとDeepCrawlを使用して重複するコンテンツを見つけます。 重複は、他の誰かがあなたのコンテンツを他のURLに再投稿した場合、または同様のコンテンツがWebページやブログまたは他の投稿に投稿された場合に発生する可能性があります。 このようなツールは、インターネット上の自分や他のWebサイトをクロールして、そのコンテンツが以前に投稿されたコンテンツと類似しているかどうかを確認するのに役立ちます。

コンテンツの重複を防ぐために、すべてのWebページが一意であることを確認してください。 すべてのWebページには、メタの説明、タイトル、URL、およびH1 / H2/H3の見出しが必要です。 H1の見出しは目立ち、主要なキーワードが含まれている必要があります。 キーワードの可能性に応じてSEOを改善するために、ウェブページのすべてのセクションに直接キーワードを追加するようにしてください。

これらの画像に関連するALTタグを再利用する場合は注意が必要です。 このようなタグにはキーワードが含まれている必要がありますが、同じにすることはできません。 キーワードを追加するときは革新的であり、タグをコピーされたコンテンツとしてインデックス付けしないように十分に異なっている必要があります。

完璧なキーワードの配置は、Googleがあなたのウェブページのトピックを理解するのを助けるために重要です。 したがって、ページコンテンツの先頭と、Webサイトの残りの部分全体で、ターゲットとするキーワード/フレーズをタイトルタグに追加します。これは、SEOに非常に適しています。 あなたは常に人間のためにあなたのコンテンツを書くべきですが、検索エンジンではありません。 すべてのページのコンテンツは、Google Webクローラーを引き付けるためだけにキーワードを詰め込むのではなく、自然に見える必要があります。

キーワードの乱用には常に注意する必要があります。そうしないと、コンテンツがスパムのように見え、Googleがその理由でウェブサイトにペナルティを科す可能性があります。 したがって、常にGoogleの関連性の兆候を構築することを目指す必要がありますが、それをやり過ぎないでください。

訪問者がウェブサイトをすぐに離れる場合(バウンスとも呼ばれます)、Googleは、ウェブサイトのコンテンツがオンラインでウェブサイトを見つけるために使用される検索クエリとは無関係であると判断できます。 したがって、コンテンツは魅力的で、完璧なメッセージを配信する必要があります。 訪問者があなたのウェブサイトに時間を費やすなら、あなたはグーグルが新しい顧客と共有したい価値を提供しているに違いありません。

ドメインの履歴と登録

ドメインは、技術的なSEOパフォーマンスを向上させるために考慮すべきもう1つの重要なことです。 グーグルで繰り返しランクが低いウェブサイトは、ドメイン履歴が貧弱である可能性があります。 パンダやペンギンなどのペナルティは、ウェブサイトのランキングを上げるための不正な戦略を特定します。これは、SEOのパフォーマンスに悪影響を及ぼします。 スパマーのいるホストは、「ブラックハットSEO戦術」を慎重に実装します。 それ以外の場合、Googleは後でこれを認識し、Webサイトを破棄します。

ドメインを更新して、より長いドメイン登録を購入してみてください。 Googleは、長い登録は短い登録よりも合法であると考えています。 検索エンジンは常にウェブサイトにより多くのクレジットを与えます、そしてそれは彼らが将来何年もの間とどまり続けると彼らが考えます。 短期間の登録を持つドメインは、一貫して維持されていないか、同様のトピックに関する定評のあるWebサイトとは異なり、一時的なものである可能性があるため、権限が低いようです。

ドメインを選択するときは、キーワードを追加し、可能であれば、ドメインの最初の単語としてキーワードをリストします。 ドメインが以前に登録されている場合は、心配する必要はなく、サブドメインにキーワードを含めてみてください。 たとえば、「 wwwwebsite.com/seo 」ではなく「www.seo.website.com」のようなページドメインを設定してみてください。

優れたプラグイン(Yoast SEOなど)を使用して、Webページを正確かつ自然に最適化できます。 このプラグインは、Webコンテンツを読み、すべてのページでキーワード/フレーズを使用する回数を理解したり、画像が最適化されているかどうかを確認したりするための最も簡単な方法をガイドします。 必要に応じてWordPressSEOで作業するには、RankMathツールを使用できます。

さらに、構造化スキーマまたはデータで重複するコンテンツを探す必要があります。 多くの企業は、検索エンジンのランクが低下しているこのWebサイト要素を見落としがちです。

Googleは、スキーマに重複するコンテンツが表示されていないことを確認するのに役立つ高度なスキーママークアップツールを提供しています。

Webページにメタ記述がありません

Webページのメタディスクリプションは、Webページのコンテンツを要約した簡単なスニペット(下の画像の2つの灰色のテキスト行)です。

検索エンジンは通常、説明に含まれているフレーズを検索するときにそれらを表示します。 このため、SEOの目的でウェブサイトのメタディスクリプションを最適化する必要があります。

Webページには常に約150語のメタディスクリプションを追加してください。 WordPress Webサイトをお持ちの場合は、公開されたページの下部にメタディスクリプションが表示されます。 SERPのカットオフが表示される前に、5月の説明に重要なキーワードを含めてください。 ほとんどの場合、重複するメタ記述のないWebサイトは、SEOパフォーマンスを台無しにします。

弱い内部リンクフレームワーク

あなたのウェブサイトはSERPで上位にランク付けするために強力な内部リンクフレームワークを持っている必要があります。 あなたが理想的に戦略を立てないならば、それはいくつかの重大なSEO問題を引き起こす可能性があります。

内部リンク構造は、可能な限り効果的である必要があります。 実用的なナビゲーションリンクと最適化されたアンカーテキストを介して、Webページが相互にリンクしていることを確認します。

壊れたウェブサイトの内部リンク

Googleは、インデックス作成の目的でWebサイトをクロールするときに、Webページ内の内部リンクに依存しています。 内部リンクが壊れている場合、彼らは先に進むべき場所を知りません。

壊れた内部リンクもあなたのウェブサイトの信頼性を台無しにします。 404エラーメッセージでいっぱいの場合、誰もあなたのWebサイトにアクセスしたくありません。 GoogleSearchConsoleやBrokenLinkCheckerなどのツールを使用して、壊れたリンクを見つけることができます。 これらのツールを使用する場合、URLを入力すると、壊れたリンクと404エラーがすべて表示されます。 壊れたリンクがどこにあるかを知ったら、それらを削除または修正できます。

壊れたバックリンク、インバウンドおよび外部リンク

あなたはあなたがあなたのウェブサイトについてグーグルに正しい信号を送ることを確実にする必要があります。 品質の悪い、またはスパムのような内部リンクがある場合、Googleはこれを検索エンジンのランキングシステムを変更し、ウェブサイトにペナルティを科すと見なします。 読者に質の高いリソースを提供するため、通常はWebサイトのランクを上げるのに役立つ、信頼性の高い認定Webサイトとして、すべてのリンク構築は自然なものでなければなりません。

リンク構築戦略を改善するために、Screaming Frog SEO Spider、Ahrefs、Mozブラウザ拡張機能などのさまざまなツールを使用できます。 内部のウェブサイトへのリンクは、Googleへの高品質の内部リンクを構築することと同じくらい重要です。 Webサイトに、関連するWebページのコンテンツにトラフィックを誘導する十分な量のインバウンドリンクがあることを確認します。 たとえば、連絡先ページへのリンクを追加するか、ブログ/記事で提供するサービスを指定する場合は、そのサービスページへのリンクを追加します。

また、壊れたリンクをチェックして修正する必要があります。リンク切れは、Googleに低品質の信号を送信し、検索エンジンの結果でのWebサイトのプレゼンスを低下させる可能性があるためです。 Googleは、関連するトピックに関するブログからの1つのリンクと、あまり密接に関連していないWebサイトからの別のリンクがあるウェブサイトを見つけると、最初のウェブサイトが2番目のウェブサイトよりも信頼性が高く優れていると見なします。 権威の高いウェブサイトからリンクを取得することで、「リンクジュース」を簡単に作成できます。

内部リンクと同様に、意図したリンクがWebサイトにエラーメッセージを表示させないようにする必要があります。 Webサイトに外部リンクがない場合、検索エンジンに表示されるWebページの総数が減少します。

また、GoogleSearchConsoleやBrokenLinkCheckerなどのツールを使用して、Webサイトをスキャンし、外部の壊れたリンクを見つけることもできます。 これらは外部のウェブサイトでホストされているため、壊れたバックリンクを修正するのはそれほど簡単ではありません。 壊れたWebサイトの外部リンクの問題を解決するには、リンク元のWebサイトに直接連絡して、リンクの削除を依頼できます。

疑わしいリンク構築戦略

リンク構築キャンペーンは、効果的に実行された場合、検索エンジンのランクを向上させることができます。 疑わしいリンクを作成しようとすると、Googleはペナルティを請求します。

ブラックハットのリンク構築のような戦略を実装しないでください。 あなたはその技術を実装する多くのリンクを得るでしょう、しかしそれらは質が悪く、あなたの検索エンジンのランキングを上げることはありません。

その他の疑わしいリンクスキームの動作には、リンクや自動化されたプログラム/サービスの売買があります。

過剰なNofollow出口リンク

Nofollowリンクは、信頼できないコンテンツへのリンク、有料リンクの構築、およびクロールの優先順位付けに使用されます。 これらの目的に加えて、外部リンクのフォローを使いすぎないようにしてください。

特定のWebサイトは、nofollowを使用して内部スパイダークロールを優先します。 ただし、Googleはこの手法を好まないことに注意してください。

小文字と大文字のURL

さまざまなサイズ、形状、レベル、状況のSEOの問題に直面する可能性があります。 .NETを使用しているWebサイトは、多くのSEO問題に直面する傾向があります。

サーバーは通常、小文字から大文字のURLを使用してWebサイトをリダイレクトするとは限りません。 ウェブサイトがさまざまなタイプのSEOの問題に直面する傾向がある場合は、リライトモデルを使用してそれらを修正できます。

Webページの複雑なURL

Webページが自動的にURLを生成する場合、Webサイトの検索エンジンの使いやすさは技術的なSEOパフォーマンスには関係ありません。

したがって、「インデックス」のような乱雑でわかりにくいURLになってしまいます。 p hp?p=367595。」 このようなURLは、快適でもSEOフレンドリーでもありません。 したがって、それらをクリーンアップして、関連するキーワードをURLに追加する必要があります。

URL末尾のクエリパラメータ

過度に長いURLを見たことがありますか? 一部のフィルター(サイズや色など)がURLに含まれていると、余分な長さが発生し、eコマースWebサイトのパフォーマンスが低下します。 これは、多くのWebサイトで非常に一般的な問題です。 クエリパラメータにより、ほとんどの場合、コンテンツが重複します。

URLの最後にあるクエリパラメータは、クロールバジェットを利用します。 したがって、URLのクリーンアップに必要な時間を費やすことを確認してください。

新しいウェブサイトまたはURLフレームワークへの不完全なシフト

ウェブサイトの更新とシフトは、ビジネスの新しさと関連性を維持するための重要なステップです。 移行を適切に管理できない場合、多くの問題が発生する可能性があります。 最大の間違いは、Webサイトのトラフィックが大幅に減少することです。

すべてのWebサイトのURLの記録を維持し、レプリカがなく、301リダイレクトが適切に送信されていることを確認する必要があります。 いずれにせよ、Webサイトを移行し、トラフィックを維持するための適切な方法を常に実装する必要があります。

壊れた画像と最適化されていない画像

あなたは常にあなたのウェブサイトに画像をリンクするべきです。 ユーザーがウェブサイトに追加されたすべての画像をクリックしたときに、必ずどこかにユーザーを送信してください。 リンクは、他のWebサイトまたはWebサイト上の他のページにつながる可能性があります。

インターネット上のどこにも向けられていない画像は、ウェブサイトのバウンス率を高め、技術的なSEOを悪化させます。 すべての画像にリンクを追加する場合でも、ウェブサイトのエラーやドメインの変更がリンクに悪影響を与えていないことを確認するために、それらを頻繁にチェックする必要があります。

壊れた画像は一般的な問題であり、Webサイトやドメインの変更、またはWebに投稿した後のファイルの変更が原因で発生する傾向があります。 Webサイトでそのような問題を特定した場合は、すぐにトラブルシューティングを行う必要があります。

Googleのウェブクローラーは画像を表示できないため、ウェブサイトの画像が何であるかを理解する必要があります。 画像ファイル名、タイトルタグ、およびALTテキストがすべての画像を説明していることを確認してください。 簡単な説明を追加し、テキストのバリエーションを使用します。 ウェブサイト全体で同じ画像を使用して、ウェブサイトをもう少しクリエイティブにするようにしてください。

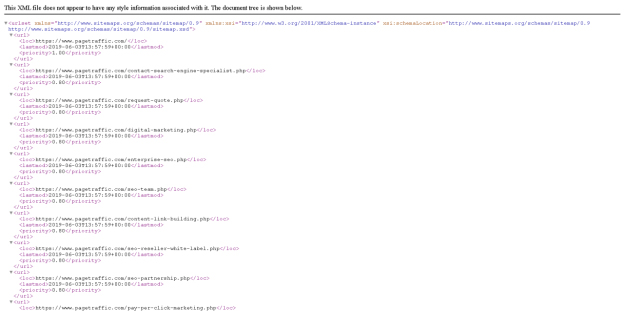

壊れた、欠落している、または古いサイトマップ

サイトマップは、GoogleとBingのWebマスターに配信され、Webサイトのインデックス作成に役立つため、重要なWeb要素です。 サイトマップを簡単にデザインできます。 多くのウェブデザインとホスティングウェブサイトはあなたのためにサイトマップをデザインすることができます。 サイトマップの設計は、技術的なSEOの取り組みが望ましい結果をもたらさない可能性がある領域です。

サイトインデックスクローラーは、サイトマップを使用して、内部リンクとほぼ同じように、次に進むページを見つけます。 サイトマップが壊れている、欠落している、または古くなっている場合、クローラーは次に進むべき場所を理解できません。

クローラーがWebサイトのコンテンツをクロールする方法を知らない場合、クローラーはコンテンツのインデックスを作成する方法を認識しません。 クローラーがWebサイトのインデックスを作成できない場合、SERPで上位にランク付けされることはありません。

サイトマップが更新され、Webページに加えたすべての変更が含まれていることを確認してください。 サイトマップを作成するのが難しい場合は、Yoastなどのプラグインを使用して作成できます。

XMLサイトマップは、Google検索ボットがWebページを詳細に理解するのに役立ち、Webサイトを効果的にクロールできます。 ドメイン名を入力し、「/sitemap.xml」をGoogleに追加します。 これは、サイトマップが存在する傾向がある場所です。 Webサイトにサイトマップがある場合は、次のようになります。

Webサイトにサイトマップがなく、最終的に404ページになる場合は、サイトマップを作成できます。 自分でサイトマップをデザインできない場合は、Web開発者を雇ってください。 最も簡単なオプションは、XMLサイトマップ生成ツールを使用することです。WordPressWebサイトがある場合、YoastSEOプラグインは自動的にXMLサイトマップを生成できます。

また、読んでください

すべてのウェブマスターが知っておくべき15の最高のテクニカルSEOツール!

ページの一部が検索エンジンによって索引付けされるのをブロックする方法は?

Rel=間違った場所での正規の使用法

rel = canonicalを使用して、あるWebページを別のWebページに関連付けることができます。 それらを利用することで、検索エンジンのランキングを損なうことなく、信頼性が向上し、コンテンツの重複が軽減されます。 それらは、rel=canonicalを持つWebページがインデックス付けされる必要があるものであることを検索エンジンに伝えます。

ただし、間違った場所でrel = canonicalを使用すると、特定の混乱を引き起こす可能性があります。そのため、上位の検索エンジンがWebサイトをまったくランク付けしない可能性があります。 すべてのWebページのコードをチェックしてrel=canonicalを見つけ、それが効果的に使用されていることを確認します。

タイトルタグの複雑さ

タイトルタグには、重複タグ、欠落したタイトルタグ、短すぎる/長すぎるタイトルタグなど、SEOに悪影響を与えるさまざまな問題が発生する可能性があります。

ページタイトルまたはタイトルタグは、検索エンジンとユーザーの両方がWebサイトの内容を判断するのに役立ちます。 この理由により、それらはSEOプロセスの重要な部分です。 テクニカルSEOで望ましい結果を得るには、基本から始める必要があります。

タイトルタグには50〜60文字が含まれ、2つのターゲットキーワードのうち少なくとも1つが含まれている必要があります。 技術的な問題を防ぐために、Webサイトに重複するコンテンツがないことを確認してください。

技術的な側面に加えて、クリック可能で完璧なタイトルには、数字、日付、大文字、感情を含める必要があります。

H1タグがないか重複しています

ヘッダー(H1)タグは、ページ上のSEOの重要な要素です。 タイトルタグとH1タグはかなり異なります。 前者は検索結果に表示されますが、後者はすべてのWebサイトユーザーに表示されます。 したがって、両方を異なるアプローチで作成する必要があります。

1ページに1つ以上のH1タグがないことを確認してください。 多くのH1タグは、タイトルタグで見落とされたり、コピーされたりする傾向があります。 ページ上のH1タグを見逃したりコピーしたりしないでください。 Webページごとに一意のH1を追加します。

テクニカルSEOでうまく機能するには、H1タグにウェブページでターゲットとするキーワードを含める必要があります。 長さは20〜70文字で、Webページのコンテンツを正確に反映している必要があります。

メタリフレッシュの利用

メタリフレッシュは、ユーザーを別のWebページにリダイレクトする古い手法です。 現在、ほとんどのWeb開発者は301リダイレクトを使用しています。 Googleはメタリフレッシュの使用を推奨しておらず、301と同様の利点がないことを保証します。

Mozによると、メタリフレッシュは遅くなる傾向があり、推奨されるSEO戦略ではありません。 これらは、最も一般的には、テキストによる5秒のカウントダウンに関連しています。「5秒以内にリダイレクトされない場合は、ここをクリックしてください。」

メタリフレッシュは一部のリンクジュースを通過しますが、機能が低下し、リンクジュースを通過できなくなるため、推奨されるSEO手法ではありません。

非常に長いWebページ

不必要な長いウェブページはあなたのウェブサイトの速度を遅くし、それはあなたのSEOに重大な害を及ぼします。 場所、利用規約、条件に関連する情報は、1つのページを対象とすることができますが、最終的にはすべてのWebサイトページに埋め込まれます。

Screaming Frogなどのツールを使用して、Webサイトをスキャンします。 予想される単語数があり、非表示のテキストがないかどうかを確認します。

間違った言語宣言

ビジネスオーナーは、あなたの言語でコミュニケーションを取り、理解している顧客を含む、適切なターゲット顧客にコンテンツを配信したいと思うでしょう。 多くのブランドは、技術的なSEOの側面としてWebサイトの言語宣言を見落としがちです。

Googleが常にウェブページを翻訳して場所を特定できるように、必ずデフォルトの言語を宣言してください。 あなたの場所はあなたの技術的なSEOと国際的なSEOの両方に影響を与える可能性があることを忘れないでください。

適切な宣言を行ったかどうかを理解するために、Webサイトのソースコード内で国と言語を確認してください。

ALTなし-テキストタグ

ALTテキストは2つの方法で技術的なSEOに利益をもたらすことができます。 まず、彼らはあなたのウェブサイトをよりアクセスしやすくします。 Webサイトにアクセスする視覚障害者は、ALTタグを使用して、画像がWebサイトにある理由とその理由を知ることができます。

次に、ALTタグを使用すると、テキストコンテンツにスペースが追加され、SERPで確実にランク付けするために使用できます。 したがって、技術的なSEOパフォーマンスを向上させたい場合は、適切なALTタグを使用してください。

301および302リダイレクトの不適切な使用

必要に応じて効果的に使用するには、301リダイレクトと302リダイレクトの違いを学ぶ必要があります。

301リダイレクトは永続的であるため、ページを別の場所に永続的にリダイレクトまたは置換する場合は、このリダイレクトを使用する必要があります。 この種のリダイレクトは、検索エンジンがインデックス作成を一時停止したり、このWebページをクロールしたりできることを知るのに役立ちます。

302リダイレクトは一時的なリダイレクトであるため、このコードは、このページが現在特定の変更を行っていることをインデクサーが知るのに役立ちますが、まもなくオンラインに戻ります。 302リダイレクトは、インデクサーがこのWebページのインデックス作成またはクロールを続行する必要があることを学習するのに役立ちます。

Webページを永続的にリダイレクトまたは置換する場合は、適切なタイプのリダイレクトを使用して、使用していないページのインデックス作成やクロールを検索エンジンが継続しないようにします。

カスタム404ページを使用しない

誰でも無効なURLであなたのウェブサイトにリンクする可能性があります。 これはほとんどのWebサイトで発生し、プロセス中に深刻なSEO問題を引き起こす傾向があります。

誰かが誤ったURLであなたのウェブサイトにリンクしているときはいつでも、訪問者に白い背景の一般的な404エラーメッセージを表示しないでください。 その代わりに、わかりやすい404エラーメッセージを表示します。

Webページが存在しない場合でも、デザインと配色を使用できます。 ホームページへのリンクを追加して、ユーザーがアクセスを期待していた記事やWebページを検索できるようにすることもできます。

ソフト404エラーの使用

検索エンジンは404リダイレクトを認識するとすぐに、クロールを停止し、その特定のWebページにインデックスを付けることを認識します。

ただし、ソフト404エラーを使用すると、Webサイトはコード200をインデクサーに返します。 このコードは、この特定のWebページが正常に機能することを検索エンジンに通知します。 検索エンジンは、ページが正しく機能していると判断すると、インデックスを作成し続けます。

間違ったコードのサーバーヘッダー

技術的なSEO監査を実施するときは、必ずサーバーヘッダーを確認してください。 サーバーヘッダーチェッカーとして機能する複数のツールをインターネット上で見つけることができます。 これらのツールは、Webサイトに返されるステータスコードを示します。

4xx / 5xxステータスコードのWebページは、問題のあるWebサイトとしてマークされます。 したがって、検索エンジンはそれらのインデックスを作成することを躊躇します。 サーバーヘッダーがプロメンコードを返していることに気付いた場合は、ウェブサイトのバックエンドにアクセスして修正し、URLステータスコードがポジティブになるようにする必要があります。

HTMLに対するテキストの比率が少ない

インデクサーは、すばやく簡単に読み込まれるコンテンツを好みます。 コピーとテキストにより、インデクサーはWebサイトの内容と、コンテンツに関連するキーワードを簡単に知ることができます。

Webコンテンツを混乱させて複雑にしすぎると、検索エンジンはそれを見つけようとしません。 検索エンジンは、それらを混乱させたWebページのインデックスを作成しません。 ウェブサイトに多くのバックエンドコードがある場合、読み込みが遅すぎます。 WebサイトのテキストがHTMLコーディングよりも優先されることを確認してください。

過度のコーディングは、技術的なSEOにとって非常に大きな問題になる傾向があります。 ただし、この問題には、余分なコードを削除したり、ページ上のテキストコンテンツを追加したりするなどの簡単な解決策があります。 不要なページや古いページをブロックまたは削除することもできます。

インデックス付けされていないWebページ

Webページのインデックスを適切に作成すると、多くの問題から身を守ることができます。 考えられるSEOの問題の評価を開始する前に、Webサイトの検索エンジンのランクを確認してください。 あなたがする必要があるのは簡単なグーグル検索を実行することです。

ウェブサイトのURLをGoogle検索パネルに入力して、上位のウェブページを見つけます。 あなたがSERPのトップ部分にランク付けするなら、それはあなたのSEOにとって良いことです。

ランク付けしたいWebページがSERPにない場合は、問題をさらに深く掘り下げる必要があります。 インデックス付きとインデックスなしのウェブページを確認するには、Googleの検索バーに「site:yoursitename.com」と入力すると、ウェブサイトのインデックス付きページの総数がすぐにわかります。

ウェブサイトがまったくインデックスに登録されていない場合は、URLをGoogleに追加することから始めることができます。 あなたのウェブサイトが索引付けされている場合、あなたはあなたの期待よりもはるかに多いまたは少ない結果を得る。 更新されたWebサイトに直接リダイレクトするための完全なリダイレクトではなく、インデックスが作成されたWebサイトの古いバージョンやハッキングスパムを詳しく調べます。 インデックスに登録されたコンテンツの監査を実施し、ランク付けするWebページと比較することができます。

コンテンツがランク付けされていない理由がわからない場合は、Googleウェブマスターのガイドラインに目を通し、ウェブサイトのコンテンツが準拠していることを確認してください。 結果がどの形式でも予想と異なる場合は、重要なWebページがrobots.txtファイルによってブロックされていないことを確認してください。 また、誤ってNOINDEXメタタグを実装していないことを確認する必要があります。

不適切なNoindexコード

誤って配置されたインデックスは、技術的なSEOを大幅に台無しにする可能性のある小さなコーディングです。 Noindexを使用すると、検索エンジンにWebサイトのインデックスを作成しないように指示します。 この間違いは、Webサイトが公開される前のWeb開発フェーズで発生する傾向があります。 ただし、不適切なインデックスなしコードを削除する必要があります。

時間通りに削除しないと、検索エンジンがWebサイトのインデックスを作成しない場合があります。 あなたのウェブサイトが索引付けされていない場合、それはSERPで上位にランク付けされません。

Robots.txtファイルエラー

robots.txtファイルエラーは、技術的なSEOに深刻な影響を与える可能性があります。 あなたがあなたの技術的なSEOチェックリストを使い果たすとき、あなたはそのようなエラーに注意を払う必要があります。 robots.txtファイルの文字の位置を間違えるほど重要ではないと思われるものは、ページに大きな損害を与え、誤ってインデックスを作成する可能性があります。

ファイルを注文するときは、Web開発者が注意を払う必要があります。 適切にリストされたコマンドを使用できますが、それらが適切に機能すると、意図しないURLがクロールされる可能性があります。

誤って配置された「禁止」を探す必要があります。これは、Googleや他の検索エンジンに、正しくインデックスに登録されない可能性のある禁止を含むページをクロールしないように通知するためです。 robots.txtファイルの強度を評価するには、Google検索コンソール内のテキストツールを使用できます。

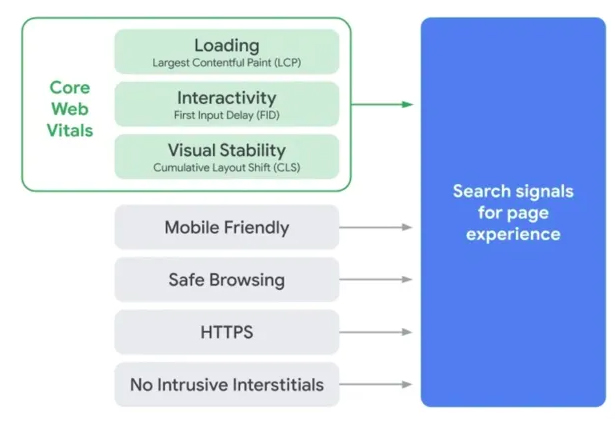

貧弱なコアWebバイタル

技術的なSEOに関しては、コアWebバイタルはまったく新しい考慮事項です。 ただし、このGoogleツールは、主にWebサイトの機能を示しているため、見落としてはなりません(下の画像を参照)。 それはあなたのウェブサイトが速くロードすることが安全でユーザーフレンドリーであるかどうかをチェックします。

あなたはグーグルがあなたのコアウェブバイタルを承認することを目指すべきです。そうすればあなたのウェブサイトはSERPで上位にランク付けされるのを助けます。 グーグルがあなたのウェブサイトを信頼できないと感じるとき、それはユーザーにそれを推薦しません。

読み込みが遅いウェブサイト

読み込みが遅いWebサイトは、低品質の信号を反映し、特定の大きなSEO問題を引き起こすSERPで上位にランク付けされる傾向はありません。 あなたの遅いウェブサイトのために、あなたはあなたの競争相手に遅れをとっています。

グーグルは彼らと彼らのユーザーがウェブサイトのスピードを大いに評価していると言った。 Webページの読み込みが遅い場合、顧客はすぐにWebサイトを離れ、バウンス率が高くなります。 それで、彼らは検索エンジンランキングのためにウェブサイトの速度を考慮することに決めました。 彼らは他のウェブサイトと比較してウェブサイトの速度を評価するためにさまざまな情報源を使用しています。

ウェブサイトの読み込み速度が遅いと、技術的なSEOに悪影響を与える可能性があります。 幸い、サイトの速度を監視し、問題をすぐに特定して修正できます。

あなたが目指すべきウェブサイトの速度を学ぶために、 SEMRushは以下の点で研究の結果を組み合わせました:

- ウェブサイトが5秒で読み込まれる場合、ウェブサイトの約25%よりも高速です。

- ウェブサイトが2.9秒で読み込まれる場合、ウェブサイトの約50%よりも高速です。

- ウェブサイトが1.7秒で読み込まれる場合、ウェブの約75%よりも高速です。

- ウェブサイトが0.8秒で読み込まれる場合、ウェブサイトの約94%よりも高速です。

ウェブサイトの速度を上げるためのヒントをいくつか紹介します。

圧縮を有効にする

圧縮については、Web開発チームに相談する必要があります。 アクティビティにはWebサーバー構成の更新が含まれる傾向があるため、自分で更新しようとしないでください。 ただし、Webサイトの速度を向上させるには、圧縮を有効にする必要があります。

画像を最適化する

多くのウェブサイトには、50万以上のサイズの画像があります。 これらの画像の一部を最適化できるため、画質を損なうことなくサイズを大幅に小さくすることができます。 Webサイトにロードするバイトが数バイトある場合、Webページをより速く提供します。

ブラウザキャッシュを使用する

WordPressを使用している場合は、ブラウザのキャッシュを使用するのに役立つプラグインにアクセスできます。 ユーザーは、ネットワーク経由ではなくハードドライブからリソース(画像など)をロードするため、Webサイトに再度アクセスしたいと思うでしょう。

CDNにアクセスする

コンテンツ配信ネットワーク(CDN)は、その場所の近くのノードからWebサイトをロードすることにより、ビスタにコンテンツを即座に配信します。 ただし、欠点が1つあります。つまり、コストがかかります。 CDNは非常に高価です。 ただし、UXが心配な場合は、CDNに投資する必要があります。

あなたのウェブサイトの貧弱なモバイル体験

最近ではほとんどの人がスマートフォンを使用しているため、顧客への働きかけを増やすには、モバイルデバイス向けにWebサイトを最適化する必要があります。

2016年、 Googleはモバイルファーストのインデックス作成を開始する動機を次のように宣言しました。 「結果をより有用なものにするために、インデックスをモバイルファーストにするための実験を開始しました。 検索インデックスは引き続きウェブサイトとアプリの単一のインデックスですが、アルゴリズムは最終的に主にモバイルバージョンのサイトのコンテンツを使用して、そのサイトのページをランク付けし、構造化データを理解し、それらのページのスニペットを表示します。結果。"

モバイルウェブブラウジングは、日々人気が高まっています。 スマートフォンやその他のモバイルデバイスと互換性があるようにWebサイトを最適化していない場合は、すぐに実行する必要があります。 人々がスマートフォンやその他のハンドヘルドデバイスを介してすべてのコンテンツにアクセスできる場合、それは自動的に顧客への働きかけを増やします。

モバイルデバイス用にWebサイトを最適化するには、Webサイトのデザイン、フレームワーク、フラッシュの使用、ページ速度、およびその他の重要な要素を考慮する必要があります。

貧弱なウェブサイトのナビゲーション

ユーザーがWebサイトを簡単にナビゲートできない場合、ユーザーは関与しない傾向があり、訪問者にとっての有用性が低下します。 ナビゲーションが不十分なため、検索エンジンはWebサイトの権限が低いと見なし、検索エンジンのランキングを大幅に低下させる可能性があります。

HTTPセキュリティなし

最近のWebセキュリティは常に人々の頭の中にあるため、インデックスに登録されたすべてのWebサイトは最近HTTPSを使用しています。 HTTPSを使用したWebサイトのセキュリティは、これまで以上に重要になっています。 Googleは、パスワードやクレジットカードが必要な場合、 HTTPS以外のウェブサイトを安全でないものとしてマークするようになりました。

ウェブサイトが安全でない場合、Google Chromeにドメイン名を入力すると、灰色の背景が表示されます。 また、灰色の背景よりも悪い「安全ではありません」という警告(下の画像を参照)が付いた赤い背景も表示されます。 このため、ユーザーはすぐにWebサイトからSERPに戻ることができます。

この問題をすばやく修正するには、WebサイトがHTTPSであるかどうかを確認する必要があります。 Simply type a domain name into Google Chrome. If you see the “secure” message, your website is secure. To convert your website to HTTPS, you require an SSL certificate from a Certificate Authority. Once you buy and install a certificate, your website is secure.

Search engines would never want to ruin their credibility by sending users to non-secure websites. If your website is unsecured, Google won't index it. When it comes to improving your local SEO, using an HTTP website can be a big mistake.

No Use of Local Searches and Structured Data Markup

Google recognizes that local searches drive numerous search engine queries. Thus, you need to build a presence on search data providers( such as Facebook and Yelp) and Google My Business page. Ensure your contact details are consistent on all web pages.

Structured data is an easy way to help Google search crawlers to understand your website content and data. For instance, if your web page comprises a recipe, an ingredient list will be the perfect type of content to feature in your website in a structured data format. These structured data then get displayed on the SERPs in the form of rich snippets which add a visual appeal to your SERP listing.

Before creating and posting new content, look for opportunities to add structured data to the web page and coordinate the processes between content developers and your SEO experts. When you use structured data in a better way, it boosts CTR and tends to improve your search engine rank. After you implement structured data, review your Google Search Console report every day to ensure Google is not reporting any problem related to your structured data markup.

You can use Schema Builder to create, text, and implement structured data with a user-friendly point-and-click interface.

Home Page Multiple Versions

Duplicate content creates a problem in performing well in technical SEO. But the problem gets more intense if you have a duplicated homepage. You will have to make sure that your homepage doesn't have multiple versions(such as “www”, ” non-www”, and “.index.html versions).

You can easily find if your Home page has multiple versions by only Googling your website. The results you get tell you if the web page versions are indexed or live.

When you discover your website's multiple versions, add a 301 redirect to the duplicate page for pointing search engines and users in the direction of the right home page.

No Use of Breadcrumb Menus

If you run an eCommerce website with multiple categories and subcategories, adding breadcrumb links to your web pages can be a smart decision. You must have seen breadcrumbs as you have browsed across cyberspace.

Breadcrumbs look like this below:

Categories > Electronics > Mobile Devices > Smartphones

As each of these words or phrases is a link, search bots can crawl them and those links. Furthermore, bread crumbs also simplify the website visitors. Sometimes, they will upgrade one or two levels and browse your website taking a different route.

Less Word Count

Brevity and simplicity hold a high value in digital marketing. But too little text can harm your technical SEO significantly. Google tends to rank web content with depth higher on SERPs and longer when pages tend to reflect that.

So, try to write and add more long-form articles(ranging from 1500 to 4000 words) across your website for better search engine results.

Google Penalty

No business wants Google to penalize them. Google said that they use more than 200 signals to rank websites. Sometimes, penalties affect those rankings. If Google has penalized your website, you should take an action before it displays anywhere on the search engine result pages again.

First, you should learn as much as you can regarding why this has happened and how you can fix it via resources like a blog post. Google Search Console generally has a disavow tool, which you can use to tell Google which links must no longer be related to your website.

Your website may be failing to consistently rank on Google SERPs because of several reasons. Even if you learn more about them, you will not always get immediate knowledge on how to fix those issues. But if you conduct a little research and put in some effort, you can walk on the right path.

Required Citations in Local Search Results

Citations are crucial for your business to build the credibility of the local listings. Google conducts an algorithm update that impacts citations on numerous websites, including those which have been optimized by brands selling citation services or even SEO agencies themselves.

So, why does this happen? Most of the time, these kinds of companies will not offer a link back from their website to you with consistent information regarding what is optimized. Google will penalize these kinds of listings as the search engine doesn't trust them as much as those listings, which have been properly optimized. Your website may not be ranking in Google as you are not cited correctly and thus, you should work on citations to improve your search engine rank.

Google New Algorithm Update Release

Have you ever checked websites, like Moz, which posts updates directly from Google? If you have checked such websites, then you must have seen a big update release at least once a year.

So, how does the release of a new Google algorithm update affect your technical SEO? The updates tend to target spammy links, backlinks, and social media profiles. If you have a website that is spammy in any form or shape, the next big Google update may impact it significantly.

結論

If your website consistently fails to rank high on SERPs, it's high time to work on your technical SEO. You may have the best website, but not just can't afford to stay behind your competitors only for poor SEO performance.

It's not that easy to spot technical SEO issues. Hopefully, this post will help you to learn the most common technical issues and how to fix them.

Once you notice any of the issues mentioned above on your website, you need to solve them at the earliest. Get in touch with a leading SEO service provider who can help you to fix these issues.

よくある質問

What are the common technical SEO issues?

Here are some issues you should look out for:

● Broken links

● Duplicate content

● Slow page load speed

● Poor mobile experience

● Poor site navigation

● Missing Robots .txt

● Canonical issues

What is a technical SEO checklist?

Technical SEO is integral to any website's SEO, and a technical audit checklist consists of all important technical parameters based on which a website should be analyzed and corrected.

How are on-page, off-page and technical SEO different?

Technical SEO is any work done outside of the content itself. While onpage refers to any work that is done on the website, and off-page tasks are accomplished beyond it.